El examen clínico objetivo y estructurado (ECOE) evalúa las competencias adquiridas por los estudiantes al terminar el grado de medicina. La competencia es el conjunto de conocimientos y habilidades para resolver un problema profesional, con una actitud adecuada. La Conferencia de decanos de las 40 facultades de medicina de España ha establecido que todos los estudiantes del grado de medicina que finalizasen sus estudios en el curso 2015/2016 deberían superar una prueba (ECOE) que evaluase 8 competencias clínicas: anamnesis; exploración física; comunicación; habilidades técnicas; juicio clínico, manejo diagnóstico y tratamiento; prevención y promoción de la salud; relaciones interprofesionales; y aspectos éticos y legales.

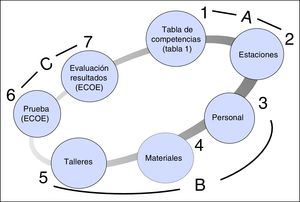

La Facultad de Medicina de la Universidad Autónoma de Madrid se ha incorporado a este proyecto y ha organizado su primer ECOE para los 197 alumnos de 6.° curso, con 25 estaciones o pruebas. Este trabajo describe las 7 etapas o procesos esenciales que se han seguido para la instauración del ECOE y que puede resultar de utilidad para la comprensión de este complejo examen y su implantación.

The Objective Structured Clinical Examination (OSCE) evaluates clinical skills of medical students at the end of medical school training. Professional competence is the set of knowledge and clinical skills that helps to solve professional problems with the correct attitude. The Conference of Deans from all 40 Schools of Medicine in Spain agreed that all students completing their medical training in the 2015/16 academic year should take an exam to assess 8 competency areas: medical history, physical examination, communication skills, clinical judgment, diagnosis, management and treatment, prevention and health promotion, inter-professional relationships, and ethical and legal aspects. The Madrid Autonomous University Medical School took part in this national project, and conducted its first OSCE, with 25 tests, for the 197 students that concluded their training in 2016. This paper describes the 7 stages, or essential processes followed in order to establish the OSCE. This experience may be useful for the understanding and implementation of this complex competence evaluation process.

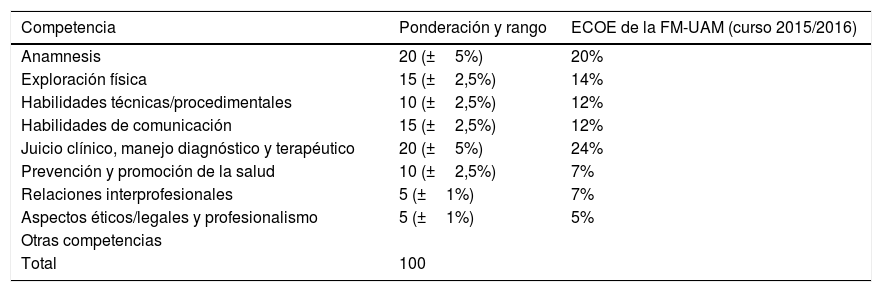

El Espacio Europeo de Enseñanza Superior (objetivo prioritario del plan Bolonia) reconoce y equipara todas las titulaciones universitarias de los estados miembros. Este proceso, iniciado en 1999 y con implantación completa en 2010, ha modificado sustancialmente la transmisión de los conocimientos en medicina: de un modelo basado en la enseñanza del profesor como elemento nuclear se pretende un modelo basado en el aprendizaje activo del alumno1. Este cambio cultural se instrumentaliza mediante la formación en competencias (conjunto de conocimientos y habilidades para abordar un problema de la profesión, con una actitud adecuada). Así, de una formación basada en la adquisición de conocimientos (saber), los tiempos actuales demandan, además, una adecuada formación en habilidades, actitudes y valores, es decir, en competencias. La consecuencia inexorable de esta evolución pedagógica es una modificación del proceso evaluativo de la enseñanza. Los exámenes escritos tradicionales no permiten evaluar la adquisición de competencias en toda su dimensión; de ahí la necesidad de establecer nuevos métodos para evaluar las competencias, que se han desarrollado en la segunda mitad del siglo xx2–6. Durante el curso 2011-2012 la Conferencia nacional de decanos de medicina (CND-medicina) aprobó por unanimidad que todas las facultades de medicina de España realizaran una «evaluación final de las competencias clínicas y de comunicación, de carácter eminentemente práctico»7. Este examen denominado evaluación clínica objetiva y estructurada (ECOE) se ha implantado en Cataluña en 19957,8. Según la CND-medicina, la prueba debe evaluar 8 competencias básicas que todo médico debe poseer al finalizar el grado de medicina (tabla 1).

Competencias clínicas que todo médico debe adquirir durante la carrera y su ponderación, según la Conferencia nacional de decanos de medicina2

| Competencia | Ponderación y rango | ECOE de la FM-UAM (curso 2015/2016) |

|---|---|---|

| Anamnesis | 20 (±5%) | 20% |

| Exploración física | 15 (±2,5%) | 14% |

| Habilidades técnicas/procedimentales | 10 (±2,5%) | 12% |

| Habilidades de comunicación | 15 (±2,5%) | 12% |

| Juicio clínico, manejo diagnóstico y terapéutico | 20 (±5%) | 24% |

| Prevención y promoción de la salud | 10 (±2,5%) | 7% |

| Relaciones interprofesionales | 5 (±1%) | 7% |

| Aspectos éticos/legales y profesionalismo | 5 (±1%) | 5% |

| Otras competencias | ||

| Total | 100 |

Se detalla la ponderación de cada competencia en el primer examen clínico objetivo y estructurado (ECOE) de la Facultad de Medicina de la Universidad Autónoma de Madrid (FM-UAM), curso 2015/2016, celebrado los días 7 y 8 mayo 2016.

Si bien la Asociación Europea de Educación Médica (AMEE) ha publicado unas guías del ECOE9,10, no se han encontrado publicaciones detalladas en castellano que recojan los procedimientos a seguir para la implantación del ECOE, examen ciertamente complejo en su organización, desarrollo y evaluación. La Facultad de Medicina de la Universidad Autónoma de Madrid (FM-UAM) se ha adherido a este proyecto y ha implantado el ECOE de grado en el curso 2015/2016. Se describe aquí el proceso seguido para su implantación y un plan de actuación para futuras ediciones.

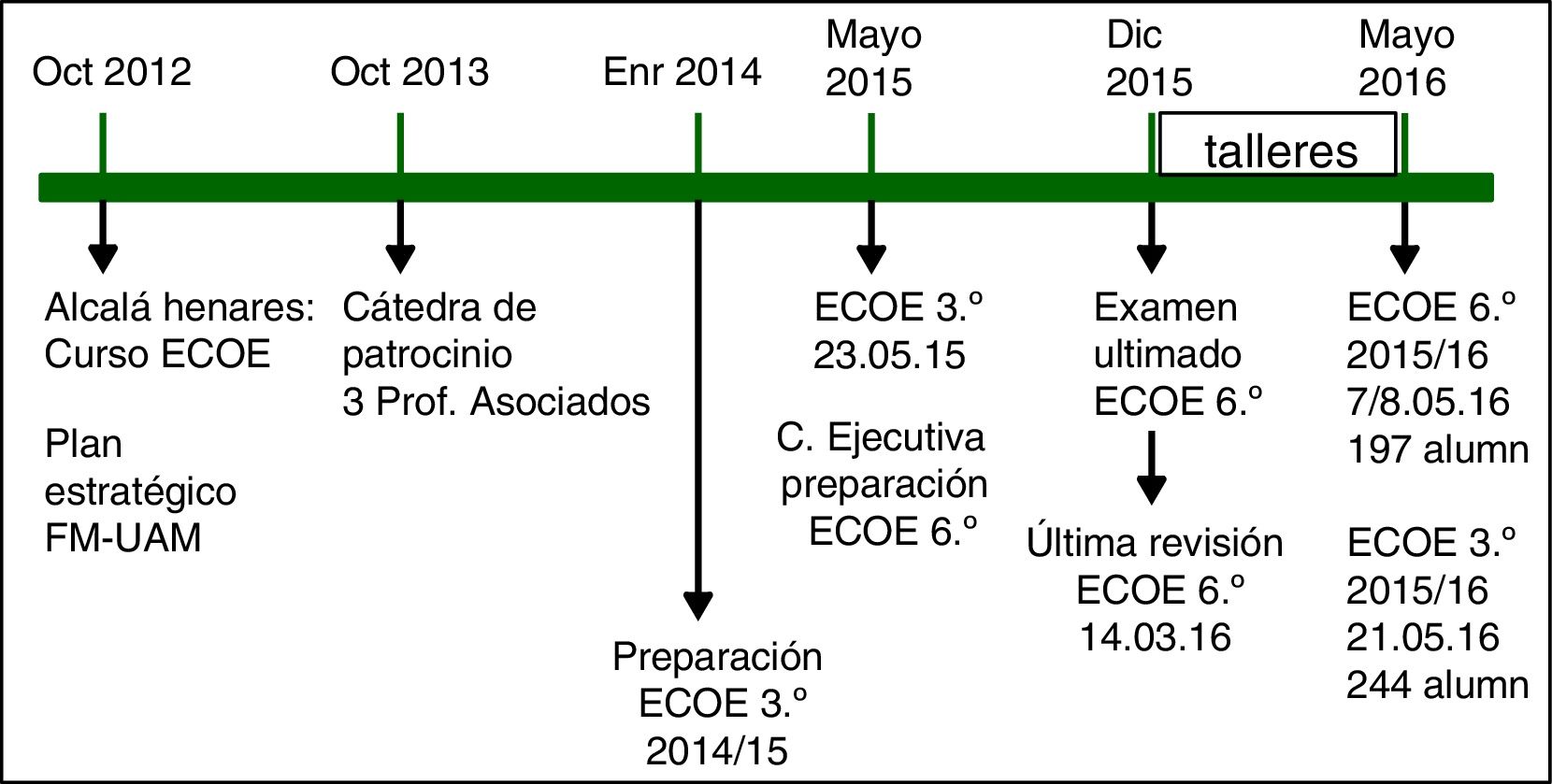

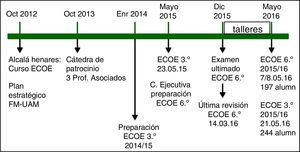

Plan estratégico para la implantación del examen clínico objetivo estructuradoFormaciónEl 18 de octubre de 2012 la Facultad de Medicina de la Universidad de Alcalá de Henares (Madrid) organizó una jornada de formación sobre el ECOE (fig. 1). Este fue el primer paso de un plan estratégico de 4 años que culminaría el 7 y 8 de mayo de 2016 con la celebración del ECOE de 6.° para la primera promoción de los alumnos del grado de medicina de la FM-UAM.

Cátedra de patrocinio (fig. 1)Durante el primer curso (octubre 2012 a septiembre 2013), además de procurar una formación adecuada en el ECOE, se recabaron fondos mediante una cátedra de patrocinio de «innovación docente» (colaboración de Laboratorios Alcalá Farma). En febrero de 2014 el departamento de medicina convocó 3 plazas de profesor asociado, de 3h/semana, vinculadas a la cátedra de patrocinio, para procurar los contenidos clínicos esenciales sobre los que se construiría el ECOE.

Examen clínico objetivo estructurado para los alumnos de 3.° (fig. 1)Para abordar con seguridad la organización y ejecución del ECOE del grado un año antes (mayo de 2016) se programó un «mini-ECOE» para los alumnos de 3.° en mayo de 2015, que serviría para iniciar esta actividad evaluadora. Durante 2014 se elaboraron las estaciones clínicas, vinculadas a las asignaturas de fisiopatología y semiología. El examen se celebró el 23 de mayo 2015 (fig. 1) en las consultas externas del Hospital Universitario La Paz, con 5 estaciones de 10minutos cada una y 8 «ruedas» o grupos de 5 alumnos, para examinar simultáneamente a 40 alumnos. Los alumnos rotaron sucesivamente por cada estación o prueba: un caso de dolor torácico, uno de dolor abdominal (2 estaciones con actor), una prueba de auscultación y 2 casos clínicos con imágenes o pruebas complementarias. La encuesta de satisfacción de los alumnos ofreció un valor medio de 3,9/5,0.

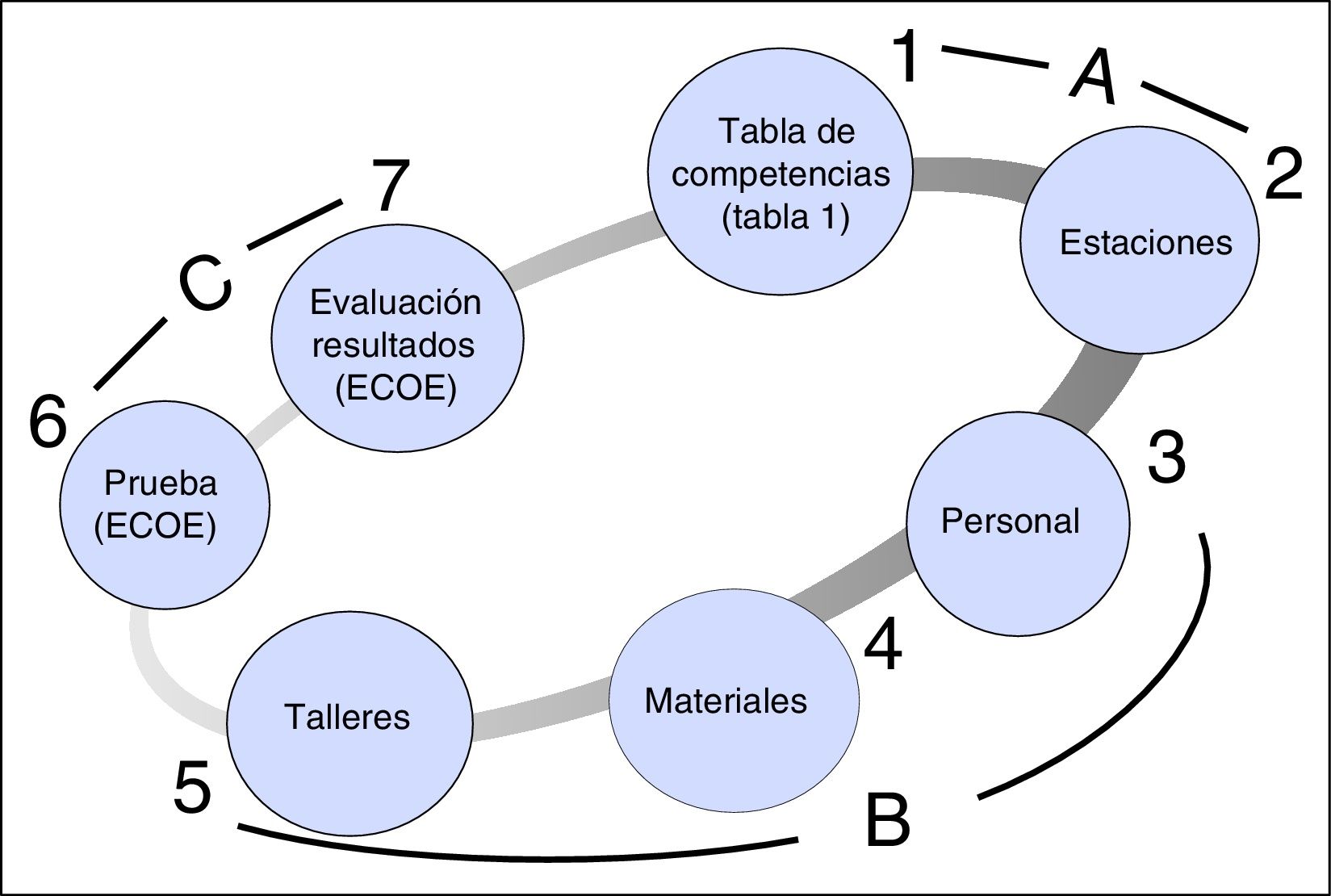

Comisión del examen clínico objetivo estructurado del grado de medicina (fig. 1)El ECOE se concibió como un proyecto global de toda la FM-UAM. El Decano de la FM-UAM convocó a los directores de departamento para explicarles el proyecto y que designaran a un representante en el «comité ejecutivo del ECOE» (primavera de 2015 [fig. 1]). La comisión ejecutiva del ECOE ha sido abierta y cualquier profesor de la FM-UAM ha podido participar. Durante el año 2015 y en reuniones quincenales se elaboraron las estaciones para que el examen estuviera ultimado el 31 de diciembre de 2015. Entre enero y abril de 2016 se revisaron las estaciones y se verificó la idoneidad de cada estación con residentes de los hospitales asociados a la FM-UAM. Además, en estos 4 meses se procuró el personal necesario para el ECOE, los materiales necesarios para las pruebas y se impartieron talleres a alumnos, actores y evaluadores (fig. 2; fases o etapas 3, 4 y 5). El 14 de marzo de 2016 se convocó una última reunión del «comité ejecutivo del ECOE» para que el responsable de cada estación revisase el listado evaluativo y corrigiese posibles deficiencias.

Planificación general del examen clínico objetivo y estructurado (ECOE) en la Facultad de Medicina de la Universidad Autónoma de Madrid (FM-UAM).

Cada número es un área de trabajo o actividad a desarrollar, con su plan de trabajo (ver explicación en el texto). El ECOE se puede estructurar en 3 áreas: A, actividades 1 y 2; B, áreas 3, 4 y 5; y C, actividades 6 y 7.

Un profesional competente es «aquel que usa de modo habitual y sensato los conocimientos, habilidades técnicas y de comunicación, el razonamiento clínico, las emociones, los valores y la reflexión de la práctica diaria para el beneficio del individuo y de la comunidad a la que se sirve»11. La CND-medicina ha establecido 8 competencias básicas o esenciales que debe adquirir cualquier graduado en Medicina en España (tabla 1). El peso de cada competencia es diferente y así, como es lógico, se concede mayor peso a la competencia «anamnesis» (20±5%) que a la de «relaciones interprofesionales» (5±1%). La FM-UAM ha asumido la tabla de competencias sugerida por la CND-medicina9.

Estaciones (fig. 2, área 2)La CND-medicina ha aconsejado que el ECOE se componga de 20 estaciones y que la preparación de cada estación tenga un dosier escrito estructurado9. El ECOE de la FM-UAM se diseñó con 21 estaciones y 4 descansos (25 estaciones). ¿Cómo se asignó la elaboración de las estaciones entre los departamentos de la FM-UAM? A partir del plan de estudios y de los European Credit Transfer System (ECTS) de cada asignatura, se calculó el número de estaciones que debía elaborar cada departamento, con un criterio de proporcionalidad. ¿Cómo se elaboraron las estaciones? La CND-medicina ha ofrecido algunos ejemplos. A partir de estos cada delegado del ECOE elaboró las estaciones que le correspondían con el siguiente esquema de trabajo: a) presentación de la estación al comité ejecutivo del ECOE en las reuniones periódicas programadas durante 2015; b) discusión de la estación y su listado evaluativo; y c) consenso final. Es importante destacar estos 5 principios o guías para la elaboración de cada estación:

- •

La estación debe plantear un problema clínico frecuente.

- •

Cada estación debe examinar entre 2 y 4 competencias (tabla 1).

- •

Cada listado evaluativo debe contener entre 10 y 20 preguntas.

- •

Cada pregunta debe ponderarse entre 1 y 5 puntos, dependiendo de su relevancia para la resolución del caso. Así, ante un paciente con dolor torácico, la pregunta «¿cuándo empezó el dolor?» puede parecer tan elemental que quizás deba valorarse poco (1 punto) mientras que otra pregunta («dolor de reposo o de esfuerzo») tal vez deba tener una mayor valoración (de 2 a 5 puntos).

- •

A la hora de determinar los puntos que debe tener cada estación, lo más trascendente es que el caso clínico sea ilustrativo de un síntoma o signo frecuente (dolor torácico, abdominal, articular, hematuria, disnea, fiebre, cefalea, pérdida de fuerza o sensibilidad, retraso estaturo-ponderal, etc.). Los aspectos o preguntas a evaluar deben ser los adecuados para resolver o enfocar el proceso patológico, con una ponderación razonable. La suma de los puntos del listado evaluativo de cada estación no tiene por qué ser la misma (por ejemplo, 100), sino contener las 10-20 preguntas clave para resolver el caso o problema clínico. Lo más importante es que cada competencia, en el conjunto del ECOE, tenga un peso adecuado y aproximado al establecido por la CND-medicina (tabla 1).

Cada estación requiere un evaluador. En las estaciones con actor se debe contar con 2 personas y en las de habilidades clínicas, por ejemplo, «suturas» o «vendaje», se requiere, además, un ayudante o responsable del material. Esto determina la necesidad de un gran número de personas. Para examinar a 197 alumnos se ha recabado la colaboración de 288 personas, casi todos médicos (cociente colaborador ECOE/alumno, 1,46) (https://medicina.fmed.uam.es/ecoe/ecoe16.php) (tabla 2). El comité ejecutivo designó a un responsable del ECOE en cada unidad docente hospitalaria de la FM-UAM (Hospitales Universitario La Paz, La Princesa, Puerta de Hierro y Fundación Jiménez Díaz) para que reclutara médicos, en su mayoría residentes, que se ofrecieron como evaluadores y ayudantes (fig. 3). Para colaborar se exigió haber asistido a un «seminario ECOE», donde se ofreció la información necesaria acerca de la naturaleza, organización y procedimiento evaluativo de este examen. Los actores y actrices convocados eran casi todos médicos, miembros del grupo de teatro «No damos crédito» de la FM-UAM y recibieron instrucciones para que sus actuaciones (cada jornada 25 escenas de 8min) fuesen lo más homogéneas posible y contestaran de forma muy escueta a las preguntas de cada alumno (por ejemplo, no era adecuado que el actor contestara «me duele aquí desde hace 2 días», ya que impide que el alumno formule 2 preguntas clave: «¿dónde le duele?» y «¿desde cuándo?»). Además, los actores y actrices debían evaluar las «habilidades de comunicación»; el que mejor percibe cómo se ha sentido durante el acto médico es el paciente (actor).

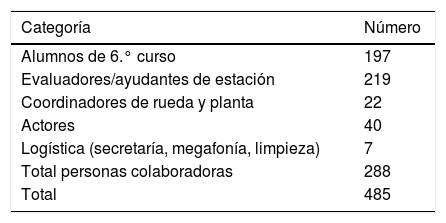

Personas convocadas para evaluar a 197 alumnos de 6.° curso en el examen clínico objetivo y estructurado (ECOE) de la Facultad de Medicina de la Universidad Autónoma de Madrid (FM-UAM), curso 2015/2016

| Categoría | Número |

|---|---|

| Alumnos de 6.° curso | 197 |

| Evaluadores/ayudantes de estación | 219 |

| Coordinadores de rueda y planta | 22 |

| Actores | 40 |

| Logística (secretaría, megafonía, limpieza) | 7 |

| Total personas colaboradoras | 288 |

| Total | 485 |

Los actores y evaluadores recibieron un diploma de «colaborador clínico docente» como muestra de reconocimiento por su participación.

Un aspecto muy debatido del ECOE es si en las estaciones de actor la evaluación del acto clínico debe ser realizada por este o por un evaluador presencial mientras transcurre la acción. Para dilucidarlo, durante el ECOE de grado y el mini-ECOE de 3.°, solicitamos a actores y evaluadores que rellenasen el listado evaluativo por separado (concordancia), siendo el «parámetro oro» la evaluación por terceros de una grabación del examen en vídeo. Los resultados se presentan más adelante.

Materiales (fig. 2, área 4)El apartado «materiales necesarios en cada estación» fue elaborado por el responsable de cada estación. La comisión de logística y los coordinadores de cada estación se encargaron de procurarlos. Así, en la estación de «suturas» el responsable obtuvo los materiales necesarios, cedidos por el hospital (paños quirúrgicos, desinfectante, agujas, suturas, jeringas, anestésico local, patas de cerdo, etc.); en la estación de «reanimación cardiopulmonar» el responsable consiguió los maniquíes necesarios. El comité de logística se encargó de todo el papel: hojas de «situación de partida» en la puerta de cada despacho, hojas de examen para las estaciones en las que el alumno debía escribir, radiografías, pruebas complementarias, hojas de evaluación, etc.

Talleres (fig. 2, área 5)Los talleres, prácticas tuteladas, o seminarios preparatorios del ECOE deben impartirse no solo a los alumnos sino también a los organizadores de la logística, coordinadores de rueda y de planta, evaluadores, ayudantes en las estaciones de habilidades clínicas y actores. El objetivo de estos talleres es que cada persona conozca muy bien el ECOE, su función en el mismo y que asuma que es un elemento clave para el buen funcionamiento global de la prueba. Los talleres se impartieron entre enero y mayo de 2016 (fig. 1). Se programaron los siguientes:

- •

Cuatro seminarios de 2horas para los alumnos del grado de medicina.

- •

Un seminario de «organización y tareas a desarrollar» para cada responsable o grupo de personas:

- ∘

Secretaria de la prueba ECOE.

- ∘

Secretaria de materiales y «papeles».

- ∘

Personal del hospital.

- ∘

Coordinadores de rueda (uno cada 5 estaciones) y de planta.

- ∘

Megafonía.

- ∘

Evaluadores y ayudantes en las estaciones de habilidades clínicas (2 seminarios).

- ∘

Actores (2 seminarios).

- ∘

Se celebró durante la mañana y tarde del sábado 7 y durante la mañana del domingo 8 de mayo de 2016. Los alumnos se distribuyeron aleatoriamente en 3 grupos: sábado mañana (n=75), sábado tarde (n=75) y domingo mañana (n=47). El día anterior se prepararon las 25 estaciones (una por despacho, en las 3 plantas de las consultas externas del Hospital Universitario La Paz). La prueba comenzó a las 08:30h. Una hora antes se convocó a los evaluadores, ayudantes y actores. Cada colaborador recibió por correo electrónico una tarjeta identificativa con su nombre, cargo en el ECOE, grupo, planta y estación donde debía dirigirse. Un duplicado de la tarjeta se recogió para acreditar su participación. Todos dispusieron de al menos 30minutos para familiarizarse con los contenidos y con el trabajo a realizar (especialmente, el método de evaluación). Los coordinadores de rueda (uno por cada 5 estaciones) y de planta resolvieron en unos 30 minutos las dudas de los evaluadores, ayudantes y actores, y se cercioraron de que todas las personas a su cargo supieran la función que debían desempeñar. Los alumnos acudieron con una tarjeta identificativa con su nombre, grupo, planta y estación por la que debían comenzar el examen. Tras unas breves explicaciones finales fueron conducidos a las estaciones; la prueba duró 260minutos. Cada 5 estaciones (50min) había una de «descanso» de 10minutos. A media mañana y a media tarde se programó un descanso de 20minutos para los colaboradores. En estos descansos los alumnos permanecieron en el interior del despacho cuya estación hubiesen finalizado, para evitar «intercambios de información».

Al terminar el examen los coordinadores de rueda y de planta ofrecieron una encuesta de satisfacción a los alumnos y colaboradores. Esta encuesta evaluó 10 aspectos: información previa del ECOE, duración, grado de estrés, comprensión de las tareas a realizar, organización, presencia de visitantes, formación recibida durante la carrera, grado de dificultad, valoración de competencias, y si mide mejor la adquisición de competencias que otro tipo de exámenes. Los coordinadores de rueda y planta recogieron los listados evaluativos de cada estación para su procesamiento.

Evaluación del examen clínico objetivo estructurado (fig. 2, área 7)Los evaluadores rellenaron el listado evaluativo de cada estación (soporte papel) con las preguntas de cada alumno. Los actores solamente evaluaron la competencia de «comunicación».

La cuantificación de respuestas correctas y su valoración (de 1 a 5 puntos) se realizó con un lector óptico, utilizando el programa Gexcat (http://www.gexcat.com).

El archivo informático del ECOE proporcionó los siguientes análisis:

- •

Nota de cada alumno en cada estación y nota global del ECOE.

- •

Resultados por unidad docente hospitalaria (4 hospitales).

- •

Resultados de cada alumno por competencias.

- •

Resultados de cada estación.

- •

Resultados por turno de examen.

- •

Encuestas de satisfacción de alumnos y colaboradores.

De los 197 alumnos 2 obtuvieron las notas más altas: 1.298/1.566 puntos (8,29/10). En el extremo inferior 2 alumnos obtuvieron 832 y 858 puntos (5,31/10 y 5,48/10, respectivamente). La nota media de la clase fue de 1.122 puntos (7,17/10).

Resultados por unidad docente hospitalariaLa nota media de las 4 unidades docentes fue de 7,26. 7,25. 7,14 y 7,00 sobre 10. Entre la unidad docente con puntuación media más elevada y más baja tan solo hubo 41 puntos de diferencia (2,6% de 1.566 puntos posibles).

Resultados por competenciasLa competencia mejor calificada fue «habilidades clínicas» (8,44/10), seguida de «prevención y promoción de la salud» (8,09/10) y «relaciones interprofesionales» (8,06/10), y las peor calificadas fueron «anamnesis» (6,31/10) y «juicio clínico, manejo diagnóstico y tratamiento» (6,34/10).

Resultados por estacionesLa estación con mejor nota media fue la de «reanimación cardiopulmonar» (RCP, 8,76/10), tal vez porque todos los alumnos habían efectuado durante el curso talleres de RCP básica. Apoya esta interpretación el que las 2 estaciones que siguieron a la de RCP fueran la de traumatología («vendaje»; 8,45/10), y la de obstetricia («parto»; 8,12/10), que impartieron talleres específicos durante el curso. Dos estaciones tuvieron una nota media inferior a 5,0/10.

Resultados por turno de examenLa nota media fue sábado mañana, 6,93/10; sábado tarde, 7,19/10; y domingo mañana, 7,51/10. La diferencia entre los grupos del sábado por la mañana y por la tarde fue de 41 puntos (2,6%) y entre el sábado mañana y el domingo de 91 puntos (5,8%). Cabe pensar que la mejor nota media del tercer grupo pudo deberse a un efecto «copia» o de «transmisión de la información» entre los alumnos. Sin lugar a dudas, esto sucedió. Pero ¿es tan relevante como para implementar acciones tendentes a modificar el examen en cada turno? ¿Conseguiríamos así reducir el «efecto copia», preservando un grado de dificultad semejante? Al comparar las notas medias de las diferentes plantas de cada turno, la diferencia entre la planta con mejor y peor puntuación (turno sábado mañana) fue de 35 puntos (2,2%), el sábado tarde de 40 puntos (2,6%) y el domingo mañana de 60 puntos (3,8%). Por tanto, de los 91 puntos (5,8%) de diferencia entre el tercer y primer turno es posible que hasta 60 puntos (66%) pudieran explicarse por un efecto casual de «planta diferente», o lo que es lo mismo, de distribución aleatoria de alumnos.

Al indagar sobre las diferencias entre los 3 turnos del ECOE, la competencia «juicio clínico, manejo diagnóstico y tratamiento» evidenció la máxima variación, 32 puntos (2,0%) entre el primer y tercer turno. Esta diferencia, junto con la hallada por la distribución aleatoria entre plantas, podrían explicar casi por completo las diferentes puntuaciones medias entre los 3 turnos del examen. Estos resultados invitan a implantar, al menos, 2 posibles actuaciones futuras: a) reducir la ponderación de la competencia «juicio clínico», que en nuestro caso fue del 24% (la CND-medicina admite un 20±5%; tabla 1); y b) formular las preguntas que examinan esta competencia de forma que haya varias posibles opciones correctas.

Encuesta de satisfacciónLa valoración media de los alumnos fue de 4,13/5,00. Los aspectos mejor valorados fueron la organización (4,7/5,0) y la información previa sobre el ECOE (4,1/5,0). Los peor valorados fueron el grado de estrés y la duración del examen (ambos, 3,6/5,0). La encuesta de los colaboradores ofreció un resultado medio algo superior al de los alumnos (4,3/5,0).

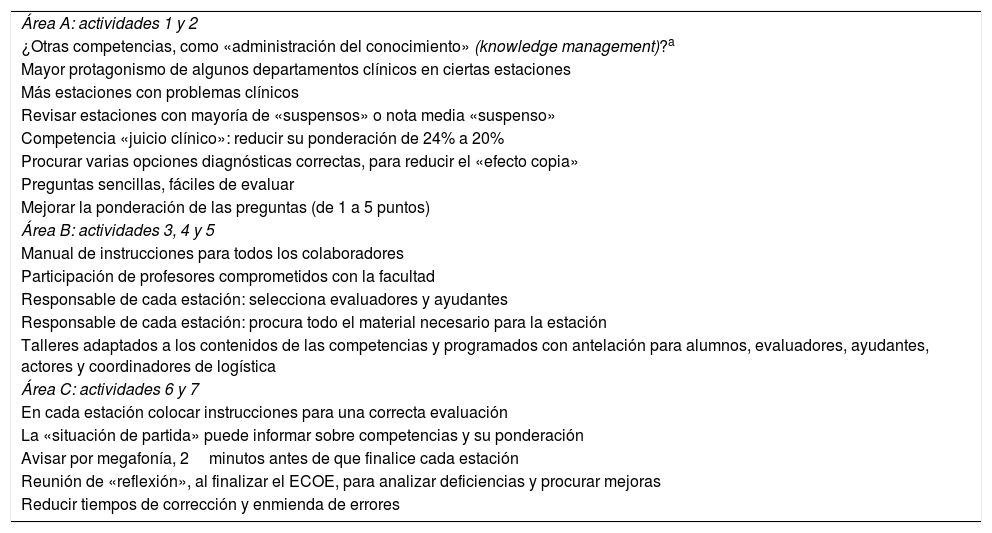

Acciones para mejorarLa organización e implantación del ECOE puede estructurarse en 3 áreas (fig. 2), de forma que las «mejoras» pueden estar dirigidas a cada una de estas 3 áreas. La denominada A comprende las actividades 1 y 2 (fig. 2). La tabla de competencias que se utilizó fue la establecida por la CND-medicina (tabla 1) y no parece oportuno efectuar modificaciones, si bien en el apartado «otras competencias» cabría establecer, por ejemplo, una búsqueda bibliográfica, o de «información relevante», ante un determinado problema médico frecuente (tabla 3, área A).

Posibles mejoras en el examen clínico objetivo y estructurado (ECOE) de la Facultad de Medicina de la Universidad Autónoma de Madrid (FM-UAM). El ECOE se puede estructurar en 3 áreas (ver fig. 2): A, actividades 1 y 2. B, áreas 3, 4 y 5. C, actividades 6 y 7

| Área A: actividades 1 y 2 |

| ¿Otras competencias, como «administración del conocimiento» (knowledge management)?a |

| Mayor protagonismo de algunos departamentos clínicos en ciertas estaciones |

| Más estaciones con problemas clínicos |

| Revisar estaciones con mayoría de «suspensos» o nota media «suspenso» |

| Competencia «juicio clínico»: reducir su ponderación de 24% a 20% |

| Procurar varias opciones diagnósticas correctas, para reducir el «efecto copia» |

| Preguntas sencillas, fáciles de evaluar |

| Mejorar la ponderación de las preguntas (de 1 a 5 puntos) |

| Área B: actividades 3, 4 y 5 |

| Manual de instrucciones para todos los colaboradores |

| Participación de profesores comprometidos con la facultad |

| Responsable de cada estación: selecciona evaluadores y ayudantes |

| Responsable de cada estación: procura todo el material necesario para la estación |

| Talleres adaptados a los contenidos de las competencias y programados con antelación para alumnos, evaluadores, ayudantes, actores y coordinadores de logística |

| Área C: actividades 6 y 7 |

| En cada estación colocar instrucciones para una correcta evaluación |

| La «situación de partida» puede informar sobre competencias y su ponderación |

| Avisar por megafonía, 2minutos antes de que finalice cada estación |

| Reunión de «reflexión», al finalizar el ECOE, para analizar deficiencias y procurar mejoras |

| Reducir tiempos de corrección y enmienda de errores |

El ECOE se puede estructurar en 3 áreas (ver la fig. 2): A, actividades 1 y 2; B, áreas 3, 4 y 5; y C, actividades 6 y 7.

Abarca desde el planteamiento de una pregunta clínica hasta la búsqueda de pruebas (evidencias) para contestar la pregunta. Comprende 3 fases o preguntas: a) la información obtenida, ¿ofrece datos con significación estadística?; b) ¿son los datos relevantes, desde el punto de vista clínico?; y c) ¿son los resultados aplicables a mi paciente?

Los resultados de cada estación sugieren que hay varios aspectos mejorables (tabla 3, área A). Así, es deseable que algunos departamentos clínicos tengan una mayor participación en la formulación de preguntas y casos. Al tratarse de un examen «clínico» parece lógico que el número de estaciones con problemas clínicos (actores) sea, al menos, de un 40-50%. Esto exige mayores recursos de actores y evaluadores que los empleados por nosotros. También parece razonable revisar a fondo las estaciones en las que la mayoría de los alumnos han suspendido o cuando la nota media ha sido inferior a 5,0 sobre 10.

Se puede mejorar la formulación de preguntas. Así, la siguiente: «¿ha preguntado por síntomas respiratorios, cardiovasculares, renales o digestivos?» (debe haber 2 para puntuar como «sí») resulta muy difícil de evaluar en una anamnesis, por la posible dispersión de respuestas e interpretaciones por parte del evaluador.

También se puede revisar la ponderación de cada pregunta de cada estación.

En relación con los colaboradores (tabla 3, área B), además de resultar obligatoria la asistencia a un seminario/taller, se pueden redactar unas guías o manual de instrucciones con indicaciones concretas para cada categoría o función.

Es deseable que el responsable de cada estación también lo sea de seleccionar a los evaluadores y ayudantes, y procure todo el material necesario.

Los talleres se diseñan en función de los contenidos de las competencias establecidas y pueden ser diferentes en las sucesivas ediciones del ECOE. Deben programarse con suficiente antelación y, si es posible, deben figurar en el calendario lectivo de cada curso.

Ante algunas dificultades con el procedimiento de evaluación (tabla 3, área C) el manual de instrucciones puede incorporar indicaciones precisas, con imágenes, y ubicar las instrucciones, de forma permanente, en cada estación.

Algunos alumnos sugirieron que la «situación de partida» de cada estación podría ser más informativa: ¿es una estación con actor?, ¿qué competencias se evalúan en cada estación? También sugirieron que sería de ayuda recibir, 2minutos antes de finalizar cada estación, un aviso del próximo final de cada estación.

En cuanto a los resultados, cada alumno recibió: a) la nota del ECOE; b) su nota por competencias; y c) su nota de cada estación, todo ello con respecto a la nota media de toda la clase. Es discutible si debe proporcionarse la nota de cada estación (Prof. García Seoane, comunicación personal), ya que para algunos sería como «ofrecer la nota de cada pregunta de un examen».

Por último, parece importante programar una reunión final del comité ejecutivo del ECOE, en la que se analicen las 3 áreas: competencias y estaciones (área A), personas, materiales y talleres impartidos (área B) y realización del ECOE con su evaluación (áreaC). Esta reunión se celebró 4,5 semanas después de finalizar el ECOE de 6.° y a las 2,5 semanas de la segunda edición del ECOE de 3.°. Si se disminuyen los errores cometidos por los evaluadores, y la necesaria corrección subsiguiente, estos tiempos podrían acortarse.

InvestigaciónEl ECOE ofrece oportunidades de investigación en muchas áreas relacionadas con la pedagogía médica. No obstante, cualquier innovación debe ser correctamente evaluada para que ofrezca la mayor utilidad12-17. En esta primera edición tuvimos la oportunidad de plantear la siguiente pregunta: ¿quién debe efectuar la evaluación en las estaciones con actor, este o el evaluador? La pregunta surgió en diversos foros de formación (años 2012 y 2013). Nuestra primera experiencia con el ECOE de 3.° (mayo de 2015) parecía indicar que «el evaluador puntúa mejor que el actor». Sin embargo, es el actor quien evalúa en la Facultad Complutense de Madrid (Prof. García Seoane, comunicación personal). El actor (enfermo) es el protagonista del acto médico. Debe estar atento al guión, al alumno, al tiempo para formular frases de «rescate» o de ayuda, si percibe que el alumno se retrasa o no realiza ciertas actuaciones. En nuestro caso, cada actor debió realizar estas funciones 25 veces en una jornada de mañana o de tarde. El evaluador solo tiene por misión puntuar lo que dice o hace el alumno en 8minutos. Por tanto, es cuestionable quién de los 2 evalúa mejor.

Para contestar a esta pregunta se seleccionaron 2 estaciones con actor, tanto del ECOE de 6.° («cefalea y fiebre» y «dolor en la fosa iliaca derecha»), como del mini-ECOE de 3.° («dolor torácico» y «dolor abdominal»). El actor y el evaluador rellenaron por separado el listado evaluativo de cada estación sin intercambiar información. Los listados evaluativos solo contenían preguntas de 2 competencias: anamnesis y exploración física. Como «patrón oro» se utilizó una grabación en vídeo, que fue calificada por separado por 2 médicos residentes de 4.° y 5.° año. Las escasas discrepancias entre los 2 médicos residentes se resolvieron por consenso, visualizando de nuevo los vídeos. Los resultados se analizaron con el coeficiente de correlación intraclase.

Se seleccionó una muestra de 149 exámenes de otros tantos alumnos: 85 del ECOE de 6.° y 64 del mini-ECOE de 3.°. No fueron evaluables 11 exámenes de 6.° y 10 de 3.° (6 y 5 por listado evaluativo incompleto, y 5 y 5 por grabación defectuosa, respectivamente). Observamos que en la competencia de «anamnesis» de 3.° la diferencia entre los coeficientes de correlación intraclase entre el evaluador (0,816) y el actor (0,441), con respecto al «patrón oro», fue considerable (0,375; 46%) (tabla 4). Esta diferencia apenas existió para la «anamnesis» en el ECOE de 6.° (diferencia 0,003; 0,5%). En la competencia de «exploración física» de 3.° también apreciamos una diferencia relevante entre los coeficientes de correlación intraclase del evaluador y del actor (34%), con respecto al «patrón oro». Esta diferencia fue mucho menor en el ECOE de 6.° (diferencia 0,003; 12%). Las correlaciones entre el actor y el evaluador con el patrón oro (vídeo), para las 2 competencias, fueron adecuadas (anamnesis 0,754 y 0,853; exploración física 0,595 y 0,739). No obstante, la concordancia para el binomio evaluador-vídeo fue claramente mejor (0,845 para ambas competencias) que para el binomio actor-vídeo (0,722; diferencia, 12%), sobre todo por la diferencia entre el actor y el evaluador en la competencia de la exploración física (0739 vs 0,595; diferencia, 14%). Estos resultados muestran que la evaluación de una persona externa (evaluador) se acerca más a la valoración del «patrón oro» (vídeo) que la realizada por el actor. Las diferencias observadas pueden no ser relevantes si el coste de procurar evaluadores para las estaciones con actor es superior a su beneficio.

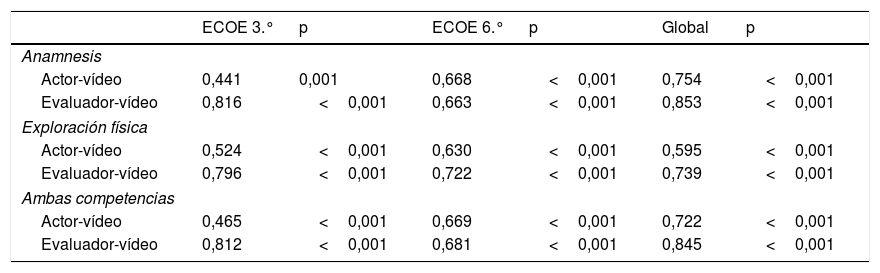

Análisis de la concordancia entre el evaluador y el actor con el «patrón oro» (grabación del examen mediante vídeo evaluada por 2 médicos residentes). Se muestran los coeficiente de correlación de intraclase (r), para las competencias clínicas anamnesis y exploración física, de 4 estaciones con actor, en una muestra de alumnos de 3.° (n=54) y de 6.° (n=74), y de todos los alumnos (global, n=128 alumnos), durante el examen clínico objetivo y estructurado (ECOE) de la Facultad de Medicina de la Universidad Autónoma de Madrid

| ECOE 3.° | p | ECOE 6.° | p | Global | p | |

|---|---|---|---|---|---|---|

| Anamnesis | ||||||

| Actor-vídeo | 0,441 | 0,001 | 0,668 | <0,001 | 0,754 | <0,001 |

| Evaluador-vídeo | 0,816 | <0,001 | 0,663 | <0,001 | 0,853 | <0,001 |

| Exploración física | ||||||

| Actor-vídeo | 0,524 | <0,001 | 0,630 | <0,001 | 0,595 | <0,001 |

| Evaluador-vídeo | 0,796 | <0,001 | 0,722 | <0,001 | 0,739 | <0,001 |

| Ambas competencias | ||||||

| Actor-vídeo | 0,465 | <0,001 | 0,669 | <0,001 | 0,722 | <0,001 |

| Evaluador-vídeo | 0,812 | <0,001 | 0,681 | <0,001 | 0,845 | <0,001 |

La grabación del examen y su posterior evaluación puede reducir el número de personas que deben colaborar en el ECOE, pero debemos considerar, por el contrario, que además de los recursos técnicos necesarios (cámaras grabadoras), en nuestro caso, se hubieran requerido, al menos, 690horas de visualización y evaluación.

Cometarios finalesEste trabajo describe la implantación de la prueba ECOE en la FM-UAM durante el curso 2015/2016 según las directrices de la CND-medicina de España. No se han encontrado publicaciones españolas que detallen este proceso en todos sus pormenores, pero sí numerosos artículos acerca de la evaluación de competencias clínicas, de diferentes especialidades, utilizando la metodología del ECOE13–15. La descripción de todos los pasos y etapas necesarias para implantar el ECOE puede ser de utilidad para reflexionar sobre lo que hemos hecho en la FM-UAM, la mejor calificada en el examen MIR durante el periodo 2003 a 201116. Este trabajo también puede ser de utilidad para los responsables docentes de las facultades de medicina que han implantado el ECOE y deseen conocer cómo lo han hecho otros.

Brevemente, queremos resaltar 4 reflexiones:

Primero: el ECOE es un proyecto de facultad. En la medida en que todos los departamentos clínicos, claustro de profesores y personal administrativo estén comprometidos con la evaluación de las competencias, el ECOE puede ser un instrumento aglutinador de las personas que trabajan en la facultad. Además, puede ser un vínculo adicional con el hospital universitario donde se celebre, por la necesaria colaboración institucional para el desarrollo de la prueba.

Segundo: el ECOE evalúa competencias. Este examen se ha instaurado en cumplimiento con las directrices del plan Bolonia y permite saber si los alumnos y, en consecuencia, los programas docentes, cumplen el objetivo de «formar en competencias»18. Una derivada del ECOE de grado es que los responsables de cada asignatura pueden implantar un examen similar, de competencias, para cada materia o curso18–20.

Tercero: el ECOE es un instrumento dinámico, en continua «fase de mejora». El análisis de este examen para los alumnos de 6.° ha permitido detectar áreas de mejora en todas sus etapas (tabla 3). Esta evolución natural del ECOE ha sido descrita en Cataluña11, y enriquecida con un examen escrito con preguntas de elección múltiple para examinar ciertas competencias de difícil valoración en el examen de «multiestación»10,11.

Cuarto: el ECOE es una oportunidad para la investigación del proceso evaluativo19,20. En este caso se ha observado que en las estaciones de actor el evaluador puntúa mejor que el actor. Esta conclusión puede ser relevante a la hora de planificar futuras ediciones del ECOE.

En resumen, la decisión de la CND-medicina fue un gran acierto que ha llevado a implantar el ECOE en la FM-UAM, con un balance global muy positivo. Esta conclusión concuerda con la experiencia de 6 años en la Facultad de Medicina de Illinois, uno de los primeros lugares donde se implantó el ECOE para los estudiantes de medicina21 y con la de la Facultad de Medicina de la Universidad Complutense, que fue pionera en nuestra comunidad (Prof. Jorge García Seoane, comunicación personal). Es necesario que desde el rectorado de la UAM se aprecie el trabajo realizado y se aseguren futuras ediciones del ECOE con los medios necesarios. Es deseable que este examen sea acreditado y se celebre, al igual que el MIR, en diferentes localidades de España, como una prueba nacional, que también deberían superar los médicos extranjeros que optan a una plaza MIR. El ECOE de medicina puede ser un modelo para la evaluación de competencias que adquieren los estudiantes de otras facultades universitarias.

Conflicto de interesesNinguno.

Expresamos nuestro reconocimiento a todas las personas que han colaborado en el ECOE de 6.° (curso, 2015/2016) y en las 2 ediciones del ECOE de 3.° (cursos 2014/2015 y 2015/2016), de la Facultad de Medicina de la Universidad Autónoma de Madrid.

De forma especial queremos reconocer el esfuerzo de los profesores que han elaborado las estaciones del ECOE de 6.°: Carmen Martin Hervás, Leandro Soriano Guillén, María Victoria Castell Alcalá, Beatriz Rodríguez Vega, Esteban González López, Nuria Ruiz Giménez, Javier Gavilán, Manuel Quintana, Óscar Martínez Pérez, Tirso Pérez de Medina, José Luis Bartha, Alberto Cózar Llístó, Álvaro Anula, Luis Riera, Víctor Sánchez Turrión, Arturo García Pavía, Javier López Monclús, José Cordero e Isabel Prieto Osuna.

Agradecemos a los profesores asociados de la cátedra de patrocinio «Laboratorios Alcalá Farma» (Dra. Ana de Santiago, Dr. Pedro Luis Martínez, Dr. Juan Carlos Martín Gutiérrez y Dr. Luis Matías Beltrán Romero) su dedicación para dotar de contenidos clínicos al ECOE de 3.° y de 6.°.

La Dra. Marta Yagüe Martín, organizó todo lo concerniente a la selección y ensayo de los actores y actrices. El Prof. Juan José Ríos Blanco procuró que toda la infraestructura necesaria del hospital estuviera operativa.

Agradecemos a Carolina Velasco García, Inés Narillos, Almudena Ligos, Arantxa Sánchez, Dr. Carlos Mejía, Dra. Araceli Menéndez y Dra. María Lizariturry, de la Unidad Metabólico Vascular del Servicio de Medicina Interna del Hospital Universitario La Paz, su contribución en la secretaría y logística durante el ECOE de 6.° y las 2 ediciones del ECOE de 3.°.

El personal de soporte de la empresa Gexcat ofreció su asesoría y ayuda en el procesamiento de los resultados.

Agradecemos a la Srta. Sandra García y a Dña. Maite Montero su apoyo desde la administración de la facultad de medicina. De forma singular agradecemos a Dña. Susana Molina Sánchez, licenciada en biológicas, su colaboración en todo el proceso evaluativo.

Las Dras. Lucía Bailón y María Lizariturry evaluaron los vídeos por separado y resolvieron las discrepancias por consenso.

Los Profs. José Ramón Banegas y Juan José de la Cruz realizaron el estudio de concordancia para saber quién evalúa mejor, el actor o el evaluador. El Prof. Fernando Rodríguez Artalejo nos ofreció comentarios muy relevantes.

Queremos agradecer el trabajo del Prof. Jorge García Seoane, como delegado de la CND-medicina para la implantación del ECOE en España, que nos ha mostrado toda su disponibilidad para resolver las dudas que nos han surgido durante la implantación del ECOE.