La evaluación de competencias es un proceso sistemático y riguroso que valora la compleja actividad de la educación. Es primordial elaborar un diagnóstico del conocimiento existente sobre el proceso de evaluación de las competencias del ejercicio de la medicina, que contribuya a la mejora del proceso formativo.

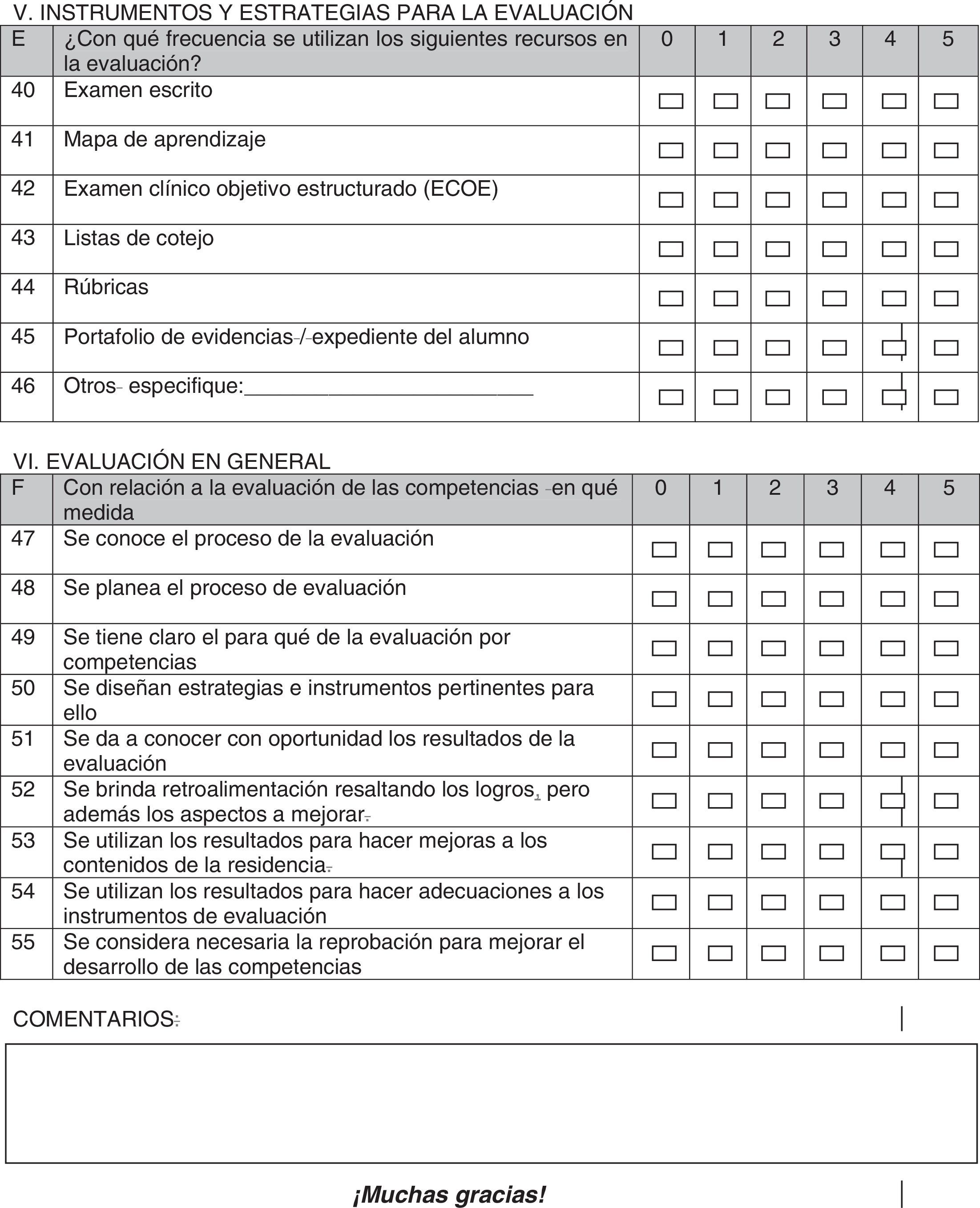

Material y métodosEstudio descriptivo, transversal, que mide el conocimiento sobre la evaluación de competencias clínico-quirúrgicas del programa de Cirugía de la Facultad de Medicina de la Universidad Autónoma de Chihuahua (UACH). Esto a través de un cuestionario que integra 55 preguntas, en 6 secciones (percepción, planeación, práctica, función, instrumentos y estrategias y evaluación en general), con una escala de Likert. El procesamiento de la información se realizó mediante un análisis descriptivo de correlación y comparativo, con un nivel de significación de 0.001.

ResultadosLa percepción que tienen los residentes y adscritos de la evaluación es en mayor medida de calificación. En cuanto a los instrumentos, el más conocido fue el examen escrito. Respecto a la función de la evaluación se consideró en mayor medida como un requisito administrativo. En el análisis correlacional la evaluación como calificación se relacionó significativamente con medición, valoración y acreditación. En la comparación entre residentes y adscritos encontramos que existen diferencias significativas en lo que se refiere a la percepción de la evaluación como medición del conocimiento (t de Student p=0.04).

ConclusiónLos resultados aportan información sobre la concepción que se tiene sobre la evaluación de las competencias clínico-quirúrgicas, considerándola como una medición del logro de aprendizajes para una certificación requerida socialmente. Existe confusión en cuanto a la percepción de la evaluación, sus funciones, sus metas y alcances como beneficio para el evaluado.

Evaluation is a means for significant and rigorous improvement of the educational process. Therefore, competence evaluation should allow assessing the complex activity of medical care, as well as improving the training process. This is the case in the evaluation process of clinical-surgical competences.

Materials and methodsA cross-sectional study was designed to measure knowledge about the evaluation of clinical-surgical competences for the General Surgery residency program at the Faculty of Medicine, Universidad Autónoma de Chihuahua (UACH). A 55-item questionnaire divided into six sections was used (perception, planning, practice, function, instruments and strategies, and overall evaluation), with a six level Likert scale, performing a descriptive, correlation and comparative analysis, with a significance level of 0.001.

ResultsIn both groups perception of evaluation was considered as a further qualification. As regards tools, the best known was the written examination. As regards function, evaluation was considered as a further administrative requirement. In the correlation analysis, evaluation was perceived as qualification and was significantly associated with measurement, assessment and accreditation. In the comparative analysis between residents and staff surgeons, a significant difference was found as regards the perception of the evaluation as a measurement of knowledge (Student t test: p=0.04).

ConclusionThe results provide information about the concept we have about the evaluation of clinical-surgical competences, considering it as a measure of learning achievement for a socially required certification. There is confusion as regards the perception of evaluation, its function, goals and scopes as benefit for those evaluated.

Hoy la universidad, mediante una educación basada en competencias, propicia la formación integral, con características de una preparación científica y humana, capaz de permitir un desarrollo intelectual, procedimental y actitudinal para la solución de problemas científicos, tecnológicos y sociales, que permitan al estudiante insertarse adecuadamente en la estructura laboral y adaptarse a los cambios sociales en donde no basta considerar los elementos por separado, sino su articulación, siendo evaluado en el desempeño y no en la teoría1.

La evaluación como estrategia de aprendizaje constituye un medio para la mejora del proceso educativo. Ello implica dejar de verla como herramienta para valorar lo que saben los estudiantes respecto a un contenido específico y, con ello, acreditar o reprobar un curso, para visualizarla como un proceso formativo que potencia el aprendizaje y contribuye a mejorar el desempeño académico y profesional en el proceso de formación2.

En el contexto de la medicina, la enseñanza clínica yace en el corazón de la formación médica. El aprendizaje clínico es el centro del desarrollo profesional, con varias fortalezas: 1) está enfocado en problemas reales dentro del contexto de la práctica profesional; 2) el estudiante es motivado por su relevancia y la participación activa; 3) el pensamiento, comportamiento y actitud profesionales son evaluados por el docente; y 4) es el único ambiente en el que las habilidades y destrezas (realización de historia clínica, examen físico, procedimientos, razonamiento clínico, toma de decisiones, empatía y profesionalismo) pueden ser mostradas y aprendidas como un todo, que permite la posibilidad de evaluar diferentes competencias implicadas en esta compleja actividad de la atención médica3.

Lo mismo aplica para la enseñanza quirúrgica. El aprendizaje quirúrgico también se logra con la puesta en práctica de las técnicas operatorias, conocidas y aceptadas, a través de las habilidades y destrezas que el residente va adquiriendo y perfeccionando durante este periodo de entrenamiento, los cuales también son previamente evaluados por el docente. La mediación contribuye a que los estudiantes apliquen estrategias para buscar, procesar y aplicar el conocimiento en la solución de los problemas de la clínica quirúrgica, empleando diversos medios, entre ellos las tecnologías de la información y la comunicación4.

Por lo tanto, la evaluación de las competencias se debe diseñar para poder evaluar el conocimiento, las habilidades y destrezas, así como el juicio en la toma de decisiones clínicas en un dominio específico5.

Para examinar las habilidades quirúrgicas se requiere de una diversidad de herramientas de evaluación, que se implementan en escenarios en donde no existe un modelo ideal que refleje fielmente que un cirujano sabe operar6.

Es incluso reconocido por el Consejo Mexicano de Cirugía General que por muchos años se ha basado la certificación en exámenes escritos y orales, lo cual genera duda de si los cirujanos acreditados en realidad cuentan con verdaderas habilidades quirúrgicas, y si los sistemas de capacitación en el país son adecuados7. Por lo tanto, es necesaria la estructuración de un método para la evaluación de las competencias propias de la especialidad en cirugía general.

Un paso primordial, previo a la elaboración de dicho método para la evaluación de las competencias clínico-quirúrgicas, es elaborar un diagnóstico del conocimiento existente sobre el proceso de evaluación de competencias clínico-quirúrgicas en un programa de residencia en cirugía general, para precisar qué tanto conocen los médicos adscritos y los residentes acerca del proceso de evaluación de dichas competencias en el posgrado, lo cual se abordó a través de 6 ejes: 1) lo que es la evaluación; 2) su planeación; 3) sus prácticas; 4) las funciones que cubre; 5) instrumentos y estrategias; y 6) la evaluación en general respecto a dichas competencias.

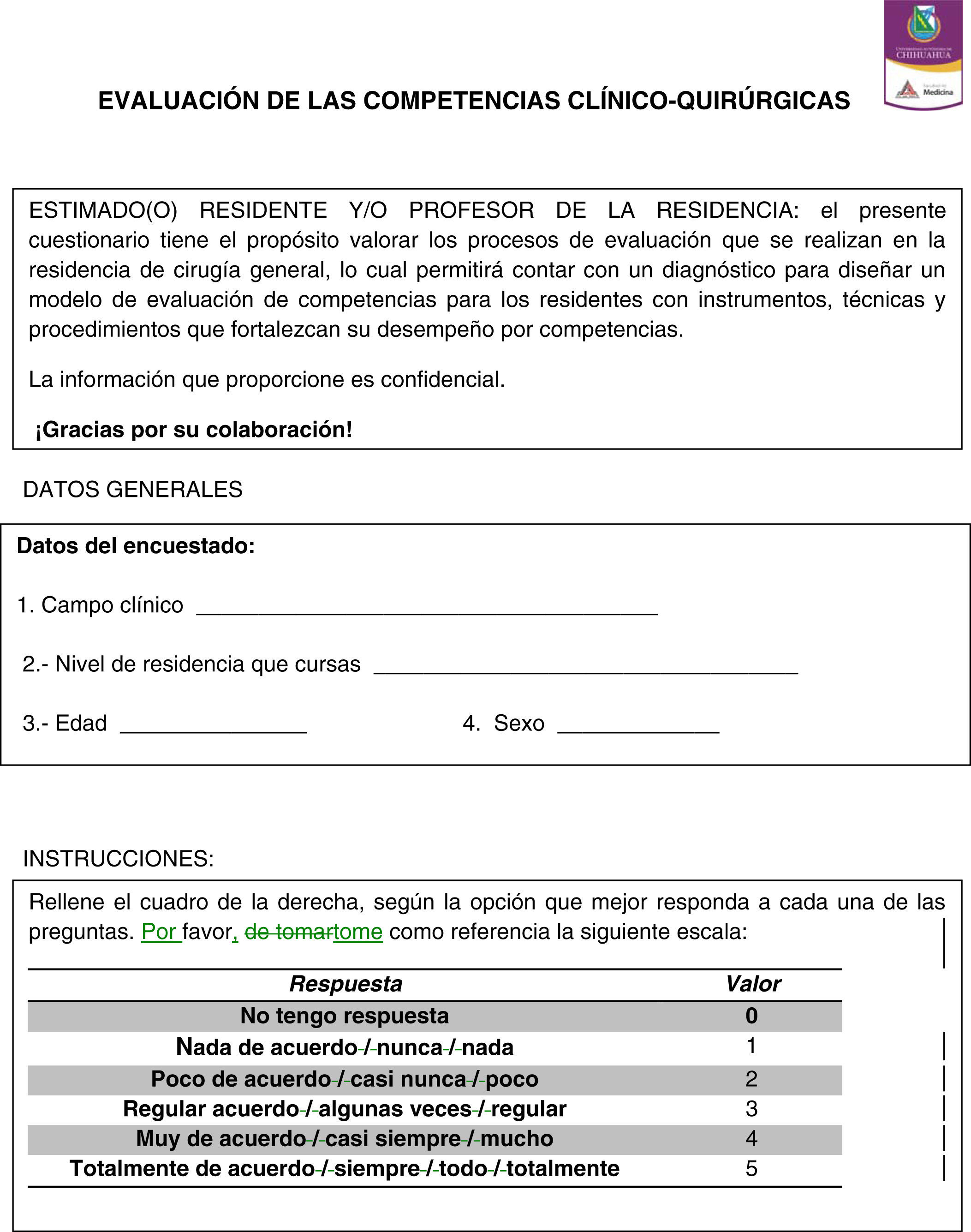

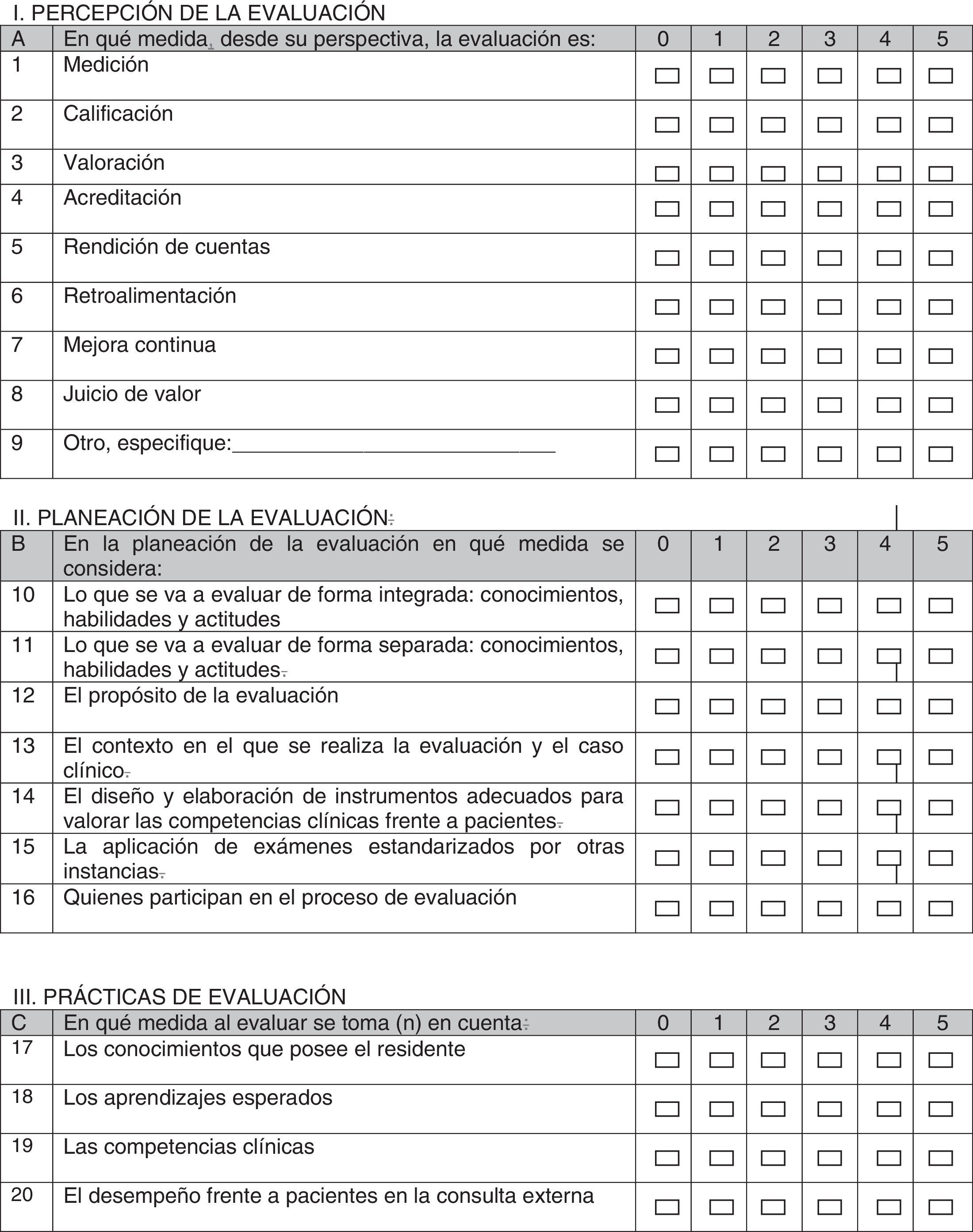

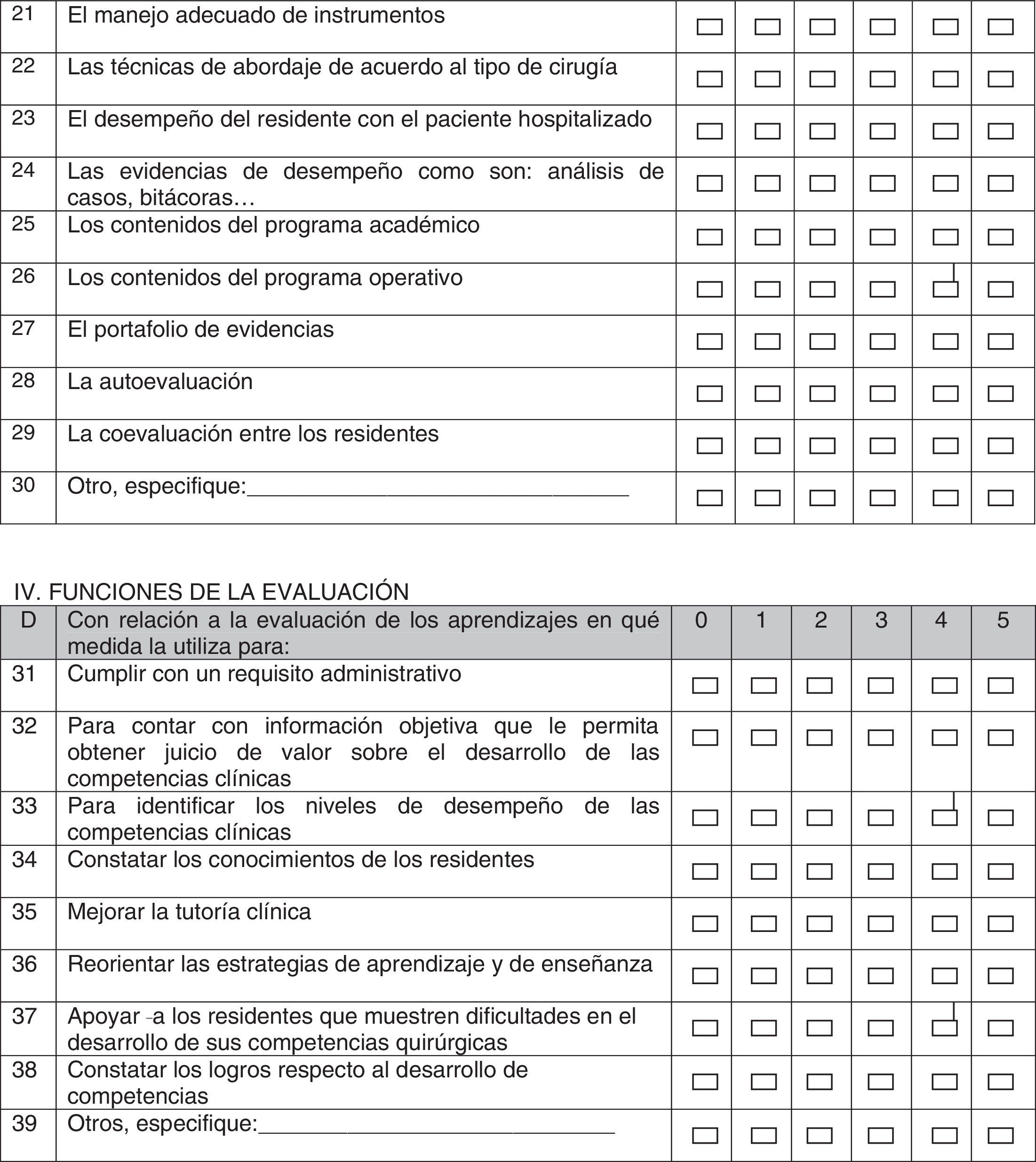

Material y métodosSe realizó un estudio descriptivo, transversal, con el propósito de medir el conocimiento de médicos adscritos y residentes, acerca de la evaluación de las competencias clínico-quirúrgicas del programa de la Especialidad de Cirugía de la Facultad de Medicina de la Universidad Autónoma de Chihuahua (UACH), mediante el diseño de un cuestionario que integró 55 preguntas (anexo 1) distribuidas en 6 secciones (percepción, planeación, práctica, función, instrumentos y estrategias, y la evaluación en general), con una escala de Likert de 6 niveles (0=no tengo respuesta; 1=nada de acuerdo, 2=poco de acuerdo; 3=regular acuerdo; 4=muy de acuerdo; y 5=totalmente de acuerdo), validado previamente en un grupo piloto (n=12). La participación fue voluntaria, respetando el anonimato de los encuestados, siendo autorizado por el Comité de Ética en Investigación del Hospital General de Chihuahua Salvador Zubirán Anchondo.

Durante el mes de julio de 2013 se realizó un primer instrumento (piloto), el cual se aplicó a 12 residentes de la especialidad de cirugía general no pertenecientes al programa de la Universidad Autónoma de Chihuahua (UACH), con el fin de evaluar el instrumento, encontrando inconsistencia en 5 preguntas, que requirieron la realización de ajuste en 3 de ellas y retirando 2 que mostraron no ser adecuadas para el propósito del estudio.

Del 20 de agosto al 13 de septiembre de 2013 se realizó la encuesta, con el instrumento corregido y validado, a los residentes de 1.er a 4.° año de la especialidad de cirugía general, así como a los cirujanos generales maestros de dicha especialidad, adscritos al programa de cirugía general avalado por la Universidad Autónoma de Chihuahua, en los 2 hospitales sede del programa (Hospital Central del Estado y Hospital General de Chihuahua Salvador Zubirán Anchondo), aplicándose dicho instrumento a 9 residentes de 1.er año, 2 residentes de 2.°, 3 residentes de 3.°, 4 residentes de 4.° año y 13 cirujanos adscritos.

El procesamiento y análisis de la información se desarrolló mediante la estadística descriptiva e inferencial en 3 niveles (descriptivo, de correlación y comparativo) en el grupo de estudio definitivo con un nivel de significación 0.001-0.05.

Análisis descriptivoEn este primer nivel se realizó un análisis descriptivo de la situación actual de los residentes, en cuanto a la manifestación de competencias clínico-quirúrgicas de acuerdo a su grado de formación, a través frecuencias, medidas de tendencia central y variabilidad. Los límites de normalidad se establecieron a una desviación estándar para destacar, a partir del análisis de las medias, las variables simples que se comportaron como atípicos superiores, por observarse por encima de lo normal o como atípico inferior por encontrarse por debajo de lo normal.

Análisis comparativoSe precisaron las diferencias significativas entre las respuestas de los residentes y los médicos adscritos con la prueba de t de Student.

Análisis correlacionalSe estableció la relación entre 2 o más variables a través del coeficiente de correlación r de Pearson.

ResultadosLos resultados se organizaron en 6 secciones, de acuerdo a los ejes considerados: 1) percepción; 2) planeación; 3) práctica; 4) función; 5) instrumentos y estrategias; y 6) evaluación en general.

En cuanto a la percepción, tanto de residentes como de adscritos, se observó que en mayor medida se considera la evaluación como una calificación (A2=3.33), mientras que se considera en menor medida como un juicio de valor (A8=2.97).

Respecto a la planeación, destacó en mayor medida la consideración de lo que se va a evaluar de forma integrada; conocimientos, habilidades y actitudes (B10=3.33), mientras que en menor medida el propósito de la evaluación (B12=2.9).

En lo concerniente a las prácticas de la evaluación se consideraron en mayor medida los conocimientos que posee el residente (C17=3.53), y en menor medida el portafolio de evidencias (C27=2.33).

Respecto a la función, se consideró en mayor medida como un requisito administrativo (D31=3.33), y en menor medida como fuente de información objetiva, que permite obtener un juicio de valor sobre el desarrollo de las competencias clínicas (D33=3).

En cuanto a los instrumentos encontramos que el más conocido fue el examen escrito (E40=3.33), mientras que el menos conocido fue la rúbrica (E44=1.7).

Finalmente, en cuanto a la evaluación en general, se considera en mayor medida que se planee el proceso de evaluación (F48=2.866667), mientras que en menor medida que se considere necesaria la reprobación, para mejorar el desarrollo de competencias (F55=1.933).

Lo más destacado en el análisis correlacional fue que al percibir la evaluación como una calificación (A2), se relaciona con la medición (A1; r=0.64), con la valoración (A3; r=0.77) y con acreditación (A4; r=0.63).

La percepción de la evaluación como una calificación se correlaciona más significativamente con la importancia que se da a las competencias clínicas en la práctica de la evaluación (C19; r=0.64), y como una función de la evaluación para identificar los niveles de desempeño de las competencias clínicas (D33; r=0.68).

De acuerdo a lo que se va a evaluar de forma integrada (conocimientos, habilidades y actitudes) (B10) se relaciona más fuertemente con: las competencias clínicas (C19; r=0.74), el desempeño frente a pacientes en la consulta externa (C20; r=0.77), el manejo adecuado de instrumentos (C21; r=0.71), el desempeño del residente con el paciente hospitalizado (C23; r=0.75), las evidencias de desempeño como son: análisis de casos, bitácoras (C24; r=0.82), la autoevaluación (C28; r=0.77) para identificar los niveles de desempeño de las competencias clínicas (D33; r=073) y para constatar los logros con respecto al desarrollo de competencias (D38; r=0.83).

En cuanto a los conocimientos que posee el residente (C17) existe una fuerte correlación con los aprendizajes esperados (C18; r=0.84), con el manejo adecuado de instrumentos (C21; r=072) y con los contenidos del programa operativo (C26; r=0.75).

Las técnicas de abordaje de acuerdo al tipo de cirugía (C22) se correlacionan con los aprendizajes esperados (C18; r=0.73), con el desempeño frente a pacientes en la consulta externa (C20; r=0.73) y el manejo adecuado de instrumentos (C21; r=0.72), mientras que cumplir con un requisito administrativo (D31) se correlaciona con medición (A1; r=0.58), con rendición de cuentas (A5; r=0.57).

El constatar los conocimientos de los residentes (D34) se correlaciona con lo que se va a evaluar de forma integrada: conocimientos, habilidades y actitudes (B10; r=0.72), para apoyar a los residentes que muestren dificultades en el desarrollo de sus competencias quirúrgicas (D37; r=0.70), para constatar los logros respecto al desarrollo de competencias (D38; r=0.72).

El examen escrito (E40) se correlaciona con los aprendizajes esperados (C18; r=0.53).

La planeación del proceso de evaluación (F48) se correlaciona con que se conozca el proceso de evaluación (F47; r=0.76), con que se brinda retroalimentación resaltando los logros, pero además los aspectos a mejorar (F52; r=0.60).

En la comparación entre las opiniones de los residentes contra los adscritos a través de la prueba de t de Student encontramos una diferencia significativa en lo que se refiere a percepción de la evaluación como medición (p=0.04), sin encontrar diferencia en el resto de las variables.

DiscusiónLa evaluación educativa con enfoque amplio constituye un proceso sistemático, a través del cual se valora el grado en que medios, recursos y procedimientos permiten el logro de finalidades y metas en la institución, y se concibe como una actividad indispensable y previa a toda acción conducente a mejorar el nivel de calidad. En el presente estudio se identificó que existe una confusión en cuanto a la percepción de la evaluación, sus funciones, sus metas y alcances como beneficio para el evaluado.

Los resultados obtenidos aportan información sobre la concepción que tienen tanto los residentes como los adscritos sobre la evaluación de las competencias clínico-quirúrgicas, considerándola como una medición que se refiere a la función social de la evaluación, donde se realiza solo para constatar el logro de los aprendizajes para una certificación requerida socialmente8. En ningún momento se considera la posibilidad de una función educativa continuada en el sentido de identificar deficiencias y proponer cómo superarlas. Ello se confirma en el análisis correlacional, al observar que la evaluación se percibe como una calificación y se relaciona con medición, valoración y acreditación. Sin embargo, encontramos una diferencia en la percepción de la evaluación como método de medición en el análisis comparativo entre residentes y médicos adscritos, a través del cual se identificó que los médicos adscritos lo consideraron en mayor medida. Es decir, el residente no considera este tipo de evaluación como importante para su formación, aun cuando existe coincidencia al considerar la percepción de la evaluación en menor medida como un juicio de valor.

Respecto a la planeación de la evaluación, solo se considera importante por ambos grupos lo que se va a evaluar de forma integrada (conocimientos, habilidades y actitudes) y se le da una menor importancia a su utilidad como propósito de la evaluación, o como contexto de la evaluación, lo cual permite observar que existe un gran desconocimiento sobre la importancia de la planeación de la evaluación.

En cuanto a las prácticas se considera en mayor medida que evaluar permite identificar el conocimiento que se posee en general, y se considera en menor medida como un portafolio de evidencias y como coevaluación, confirmando nuevamente el desconocimiento que existe en cuanto a la utilidad de la evaluación para la planeación de las prácticas, que permiten mejorar las competencias de los médicos en formación.

Refiriéndose a la función de la evaluación, se considera importante como un requerimiento administrativo y como una forma de constatar el conocimiento del residente, sin embargo, no se identifica la función en cuanto a la obtención de información objetiva o en la identificación de niveles de desempeño, ni mucho menos a su contribución como parte del proceso de aprendizaje.

La evaluación tiene 2 funciones: a) la función social de la evaluación (acreditativa), es decir, dar cuenta del grado de logro de los propósitos educativos, así como determinar y/o constatar el logro de los aprendizajes determinados al término de un período, curso o ciclo de formación, para la promoción o no a grados inmediatos superiores o para la certificación requerida por la sociedad; y b) la función pedagógica se emplea para saber qué pasó con las estrategias de enseñanza y cómo están ocurriendo los aprendizajes de los estudiantes y, con ello, mejorar y orientar el proceso de enseñanza y de aprendizaje de acuerdo con los propósitos del programa educativo, proporcionar ayuda al estudiante en el momento en que se detecten problemas con el aprendizaje, reorientar la organización de los contenidos y/o las estrategias de enseñanza8.

El único instrumento de evaluación que demostraron conocer los residentes y los adscritos fue el examen escrito, confirmando el desconocimiento que existe sobre el proceso de evaluación de las competencias de manera integrada.

Finalmente, en cuanto a la evaluación de manera general, es considerado por ambos grupos que permite la planeación del proceso, pero no consideran que la reprobación pueda mejorar las competencias, al considerar la identificación de puntos débiles en los cuales poner atención para mejorar el aprendizaje.

ConclusionesBasándonos en los resultados obtenidos, y contrastándolos con la literatura, nos podemos dar cuenta de que, de manera global, tanto de parte de residentes como de adscritos, se considera la evaluación como un sistema de calificación que se obtiene únicamente a través de un examen escrito, que permite en la práctica identificar los conocimientos que posee y evaluar de forma integral los conocimientos, habilidades y actitudes, pero en ninguno de los 2 grupos se le identifica una función pedagógica que nos permitiera mejorar y orientar el proceso de enseñanza aprendizaje, en relación con los propósitos del programa educativo, e incluso nos permite observar que no existe una noción clara sobre cómo evaluar de manera integrada no solo los conocimientos, sino las diferentes destrezas y habilidades que muestren el nivel de competencia que se va adquiriendo durante el proceso de formación, lo que confirma la necesidad de proponer la estructuración de un método para la evaluación formativa e integral de las competencias propias de la especialidad en cirugía general.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.