Las revistas biomédicas deben cumplir unos rigurosos estándares de calidad editorial. En un contexto académico globalizado, las revistas médicas deben competir, en primer lugar, para publicar los mejores trabajos originales de investigación y, en segundo lugar, para incrementar su visibilidad y la difusión de sus contenidos científicos. El proceso de «peer review» sigue siendo la piedra angular del proceso científico, pero no se puede olvidar la importancia de otros parámetros de calidad editorial. Las bases de datos bibliométricas como MEDLINE, ISI Web of Science y Scopus proporcionan una exhaustiva información de la literatura médica. Clásicamente, el prestigio de una publicación se mide por el factor de impacto, pero más recientemente otros indicadores como el SCImago SJR o el Eigenfactor representan nuevos índices alternativos para estimar la calidad de las publicaciones. Valorar los meritos académicos de la investigación y, sobre todo, los méritos individuales de los científicos continúa siendo un reto formidable. La valoración de las contribuciones de los diferentes autores tampoco es fácil. En un mundo tan kafkiano como el que vivimos es frecuente que se prefiera contar a leer los artículos que se valoran. Las mediciones cuantitativas de las publicaciones realizadas (producción científica) y los análisis de las citaciones (impacto científico) son determinantes clave del éxito científico de los investigadores. No obstante, el mundo académico está siendo receptivo al valor de nuevos indicadores objetivos (como el índice «h») en la valoración de los méritos académicos. En esta revisión discutiremos algunos temas editoriales que afectan a las revistas médicas, describiremos las bases de datos bibliométricas actualmente disponibles, revisaremos los índices bibliométricos de la calidad de las revistas y, finalmente, analizaremos los indicadores de la producción y el éxito científico de los investigadores.

Biomedical journals must adhere to strict standards of editorial quality. In a globalized academic scenario, biomedical journals must compete firstly to publish the most relevant original research and secondly to obtain the broadest possible visibility and the widest dissemination of their scientific contents. The cornerstone of the scientific process is still the peer-review system but additional quality criteria should be met. Recently access to medical information has been revolutionized by electronic editions.

Bibliometric databases such as MEDLINE, the ISI Web of Science and Scopus offer comprehensive online information on medical literature. Classically, the prestige of biomedical journals has been measured by their impact factor but, recently, other indicators such as SCImago SJR or the Eigenfactor are emerging as alternative indices of a journal's quality. Assessing the scholarly impact of research and the merits of individual scientists remains a major challenge. Allocation of authorship credit also remains controversial.

Furthermore, in our Kafkaesque world, we prefer to count rather than read the articles we judge. Quantitative publication metrics (research output) and citations analyses (scientific influence) are key determinants of the scientific success of individual investigators. However, academia is embracing new objective indicators (such as the “h” index) to evaluate scholarly merit. The present review discusses some editorial issues affecting biomedical journals, currently available bibliometric databases, bibliometric indices of journal quality and, finally, indicators of research performance and scientific success.

Un número creciente de revistas de biomedicina españolas están alcanzando un merecido reconocimiento entre la comunidad científica internacional1–12. Todas estas revistas han realizado encomiables esfuerzos para mejorar su calidad y para adaptarse, dentro de sus posibilidades, a los requisitos editoriales estrictos y los estándares de calidad que, posteriormente, serán valorados por diferentes instituciones internacionales que las juzgarán y las clasificarán atendiendo a su calidad, su influencia y su prestigio1–12. La gran mayoría de estas revistas pertenece a sociedades científicas y deben realizar este camino hacia la excelencia como un verdadero peregrinaje en el desierto, sin el amparo de organismos científicos asesores externos y, lo que quizás es todavía más preocupante, sin ningún tipo de ayuda oficial o subvención económica1–12. De hecho, el peso de estas iniciativas editoriales, y todo el esfuerzo empleado en conseguir las anheladas metas bibliométricas, suele basarse en la capacidad de liderazgo y de persuasión de los diferentes equipos de redacción que, con mayor o menor fortuna, logran que la sociedad científica correspondiente considere a su revista oficial como una de sus prioridades y trasmiten a todos los socios su entusiasmo por mejorar la publicación. En definitiva, estas sociedades, de diferentes especialidades médicas y quirúrgicas, tienen carácter científico, y todos sus miembros son los máximos beneficiarios de disponer de una revista de alta calidad.

En un mundo científico cada vez más globalizado y competitivo, especialmente desde la irrupción de las nuevas tecnologías electrónicas, no hay posibilidad de descanso en esta carrera por alcanzar la excelencia editorial13–16. En España existen múltiples ayudas en I+D para diferentes actividades y proyectos, pero no deja de sorprender que nuestras mejores revistas científicas se encuentren completamente «huérfanas» de este tipo de estímulos1,2,9. Hay países cuyos programas en I+D financian una parte sustancial del coste de la publicación de sus mejores revistas17. Sabemos que todas las estrategias editoriales encaminadas a favorecer la calidad editorial y científica y la difusión de los contenidos de una publicación tienen una cosa en común: son muy caras1–3,13. Además, en etapas de recesión, como la que actualmente padecemos, la publicidad procedente de empresas farmacéuticas o de tecnologías médicas ya no aporta los mismos beneficios y difícilmente compensa los gastos derivados del funcionamiento de muchas de nuestras revistas que, de este modo, se ven abocadas bien a prescindir de las últimas iniciativas editoriales para mejorar su calidad o difusión o bien a solicitar ayudas económicas adicionales a su sociedad científica. En este contexto, competir con las mejores revistas internacionales de cada especialidad es cada vez más difícil, cuando no un sueño imposible. Esto condiciona, al menos en parte, que las revistas extranjeras sistemáticamente se beneficien de los mejores esfuerzos de investigación realizados en nuestro país1–3,9. Obviamente, no se puede censurar a nuestros investigadores cuando apuestan por publicar sus mejores trabajos científicos en las revistas de mayor impacto. Todos lo hacemos. Los investigadores competitivos tienen la obligación de conseguir que sus trabajos alcancen la máxima difusión y reconocimiento internacional. El problema es especialmente patente cuando la revista española correspondiente no ha logrado alcanzar reconocimiento internacional, no está indexada y no tiene «factor de impacto» (FI)1–3,9. Sin embargo, ¿no sería más sensato diseñar estrategias para romper este círculo vicioso y apostar decididamente por nuestras propias revistas? ¿No deberíamos invertir mucho más en mejorar la calidad de nuestras mejores revistas para hacerlas cada vez más atractivas para los investigadores y conseguir así que mejoren sus contenidos, sean más apreciadas por sus lectores y, como colofón, alcancen reconocimiento internacional?

Este año, Endocrinología y Nutrición está de enhorabuena. Tras una decidida apuesta editorial por la calidad y la excelencia4–8, ha conseguido entrar en MEDLINE (Medical Literature Analysis and Retrieval System Online)/PubMed. Esta importante base bibliométrica internacional representa la «ventana al mundo de la ciencia»18–25. A partir de ahora, todos los trabajos publicados en la revista estarán disponibles en esta importante base de datos y todos los investigadores de cualquier parte del mundo que realicen búsquedas sobre contenidos específicos encontrarán los títulos de los artículos publicados en Endocrinología y Nutrición situados entre los de las revistas más prestigiosas de la especialidad. Hoy en día, los sistemas electrónicos de búsquedas bibliográficas han permitido poner en «situación de igualdad» la información procedente de las diferentes revistas, independientemente de su prestigio y de su FI18. Así, los investigadores tienden a leer los artículos más atractivos de entre todos los presentados en esta importante base de datos, especialmente si están disponibles de forma libre, a texto completo y en inglés3,9,18. Clásicamente, para revisar un tema concreto era necesario analizar meticulosamente las aportaciones publicadas en las revistas más influyentes de cada especialidad. PubMed, por el contrario, no solo permite realizar búsquedas electrónicas exhaustivas de forma inmediata, sino que «democratiza» la información disponible al presentar, en igualdad de condiciones, los contenidos de todas las revistas que cumplen unos ciertos criterios de calidad19–25.

A continuación revisaremos las principales bases de datos bibliométricas existentes y las diferentes formas de medir el impacto científico de las revistas biomédicas, de los trabajos de investigación y de los propios autores.

Acceso a la información biomédica: bases de datos bibliográficasEn los ambientes académicos se considera que las revistas científicas de prestigio deben estar incluidas en las bases de datos de referencias bibliográficas internacionales1–3. Por este motivo, los editores cuidan que sus revistas alcancen los criterios de calidad necesarios para ser aceptadas por dichas bases de datos1–3. Las 3 bases de referencias bibliográficas más reconocidas por su influencia científica son MEDLINE, Web of Science y Scopus18. Las 2 primeras realizan un exhaustivo proceso de revisión y análisis antes de aceptar e incluir las diferentes publicaciones. De forma adicional, más recientemente, motores de búsqueda generales, como Google Scholar, también favorecen navegar por la Web en busca de los contenidos científicos deseados.

MEDLINEMEDLINE pertenece a la National Library of Medicine de los National Institutes of Health de Estados Unidos y actualmente sustituye al ya clásico Index Medicus19–25. Es la única base de datos importante de carácter público. Representa la mayor base de datos internacional existente sobre Ciencias de la vida y Biomedicina (incluye unas 5.300 revistas) y constituye la mayor fuente mundial de citas bibliográficas de literatura médica19–25. Los contenidos incluidos en MEDLINE se encuentran libremente accesibles desde el motor electrónico de búsquedas en la web de PubMed (que, a su vez, pertenece a «Entrez», un sistema de obtención de información con capacidad para interrogar múltiples bases de datos simultáneamente)19.

Para entrar en MEDLINE, las revistas biomédicas deben cumplir unos rigurosos estándares de calidad. Así, un comité de selección «ad hoc» de la National Library of Medicine compuesta por 15 miembros se reúne 3 veces por año para revisar los aspectos técnicos y científicos de las revistas candidatas22–25. De esta forma, anualmente se evalúan unas 450 revistas de todo el mundo y las decisiones sobre su aceptación se basan, fundamentalmente, en aspectos de calidad técnica, criterios editoriales y méritos científicos. Todos los contenidos de la revista de un año concreto son analizados. Finalmente, solo un 20–30% de las revistas «aspirantes» alcanzan la anhelada indexacion22–25. Hay que recordar que el 50% de los títulos incluidos recientemente en MEDLINE son estadounidenses y el 90% de estos se publican en inglés20,21.

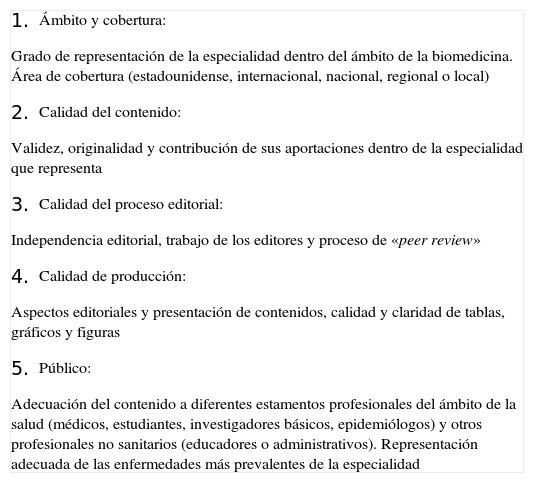

Al preparar una solicitud para que una determinada revista sea considerada en MEDLINE hay que prestar especial cuidado en documentar la calidad de la publicación en ciertos apartados. Entre ellos destacan la temática y las áreas de cobertura, la calidad de los contenidos, la calidad del trabajo editorial, el sistema de producción, el público y el área de influencia geográfica (tabla 1)22–25. Sin embargo, desde MEDLINE se insiste en que las valoraciones más determinantes analizan el mérito científico y la calidad de los contenidos22. Además, también se valora la adherencia a los estándares éticos de la publicación, según el Comité Internacional de Editores de Revistas Médicas26,27, y a los diferentes estándares de calidad que garantizan la transparencia en la presentación de aspectos metodológicos en los estudios aleatorizados (CONSORT)28,29, en los metaanálisis (QUORUM)30 y en los trabajos de precisión diagnóstica (STARD)31. El comité de selección otorga una puntuación, en una escala de 0 a 5, de cada apartado. La puntuación media para poder ingresar debe ser mayor a 3,75. En el caso de que una revista no haya sido seleccionada puede volver a presentarse una vez trascurridos 2 años, ya que se estima que este es el tiempo mínimo necesario para que los editores puedan introducir las mejoras propuestas por el comité de selección22–25.

Apartados valorados por MEDLINE para la inclusión de revistas biomédicas

|

Una de las ventajas de ser aceptado en MEDLINE es que los contenidos de los títulos se incluyen en PubMed de forma retrospectiva, abarcando varios años atrás (todos los contenidos en revistas de menos de 3 años, el año en curso en las demás). Además, se ha sugerido que la presencia en PubMed es una de las consideraciones más importantes que valoran los autores antes de enviar un artículo científico a una revista22–25. Finalmente, también se ha sugerido que la inclusión de una revista en esta base de datos aumenta el número de artículos que recibe, su visibilidad y su prestigio22–25. Como botón de muestra, baste recordar que hoy en día se producen 80 millones de consultas mensuales desde PubMed20-22.

Otras bases de datos y motores de búsquedaWeb of Science: Una empresa privada norteamericana, Thomson-Reuters, previamente denominada Institute for Scientific Information (ISI), computa, analiza y clasifica de forma continua las citas bibliográficas que se producen en las referencias bibliográficas de una importante lista de revistas seleccionadas de todo el mundo32,33. Desde 1963, estos datos se recogen en la base de datos Science Citation Index Expanded. La información puede obtenerse directamente desde la Web of Science. Además, los resultados derivados del análisis de estas citas se publican desde 1975 en el Journal Citation Reports/Science Edition, que analiza las publicaciones más importantes en ciencia, tecnología y áreas sociales. El Science Citation Index Expanded es una base de referencia bibliográfica de las ciencias en general que indiza las publicaciones periódicas de 150 disciplinas científicas que conforman la Web of Science, actualmente con 8.200 títulos en total (6.400 de ciencias, 1.800 de disciplinas sociales)32,33. Proporciona el acceso a toda la información desde 1900 hasta la fecha. Cada año, Thomson-ISI evalúa unos 2.000 títulos adicionales y, de ellos, menos de un 10% son indexados. Su principal característica es que permite diseminar el trabajo de los principales investigadores en el ámbito internacional y, a su vez, conocer quiénes citan a estos autores. Esta base de datos ha sido la referencia clásica para las búsquedas bibliográficas y, sobre todo, para el análisis de las citaciones durante las últimas 5 décadas1–3. Se ha utilizado tanto para el recuento de citaciones como para calcular el FI de las revistas científicas. Su prestigio está fuertemente consolidado y, de hecho, actualmente sigue considerándose como el patrón oro en el ámbito científico.

En 2004 nació Scopus y, desde el principio, representó una alternativa al «monopolio» que hasta entonces tenía la Web of Science. Scopus recoge la información (resúmenes y citas) de más de 17.000 revistas publicadas por Elsevier, la mayor empresa editorial del mundo18,34–36, y otras editoriales. De hecho, el número de títulos incluidos en esta base de datos es mucho mayor que el de la Web of Science. Scopus cubre el 100% de los títulos que aparecen en MEDLINE. Sin embargo, las citaciones encontradas por Scopus que no se encuentran en la Web of Science suelen corresponder a artículos de revistas con menor FI36. Además, a diferencia de la Web of Science, que fundamentalmente incluye títulos norteamericanos y en donde el inglés tiene una preponderancia absoluta, más del 50% de los contenidos de Scopus provienen de Europa, Latinoamérica y Asia, por lo que las revistas no publicadas en inglés están mucho mejor representadas. A pesar de todo, algunos autores35 insisten en que esta base de datos también tiende a infrarrepresentar a las revistas no publicadas en inglés, que únicamente representan el 15% de todas las incluidas. El análisis de citaciones de Scopus solo se realiza a partir del año 199618.

SienceDirect, que también pertenece a Elsevier, representa la mayor base de datos de artículos «completos» actualmente existente (más de 2.500 revistas «peer reviewed» y más de 10.000 libros). En esta base de datos se encuentran digitalizados cerca de 10 millones de artículos y cada año se incorporan 0,5 millones más. Recordemos que Endocrinología y Nutrición está incluida tanto en Scopus como en ScienceDirect.

Finalmente, desde otra perspectiva, Google Scholar también permite recuperar adecuadamente artículos científicos de la World Wide Web37,38. Este buscador está enfocado en bibliografía especializada y especialmente diseñado para obtener el material más relevante dentro del mundo de la investigación académica. Como es bien conocido, este sistema de búsqueda utiliza el algoritmo de análisis de vínculos denominado PageRank (por Larry Page)37,38, de la Universidad de Stanford, que calcula la importancia relativa de los vínculos de la Web y los ordena jerárquicamente. Así, el número de conexiones es importante (como si se tratara de una votación) pero también lo es de dónde proceden éstas (no todos los votos cuentan igual). Las conexiones desde páginas importantes hacen que aumente el valor de las páginas que las reciben. En definitiva, lo que hace es analizar la distribución de probabilidades de que una persona que navegue aleatoriamente entre todos los posibles vínculos existentes termine entrando en una página determinada. Como luego veremos, en este concepto también se basan SCImago y Eigenfactor.

De forma general, podemos decir que los resultados de las búsquedas realizadas en Web of Science y Scopus son relativamente similares, mientras que los resultados proporcionados por Google Scholar brindan información algo diferente. Muchos investigadores consideran que esto no es una limitación y que, en realidad, estas herramientas deben considerarse como complementarias en cuanto a la búsqueda de información científica. En un reciente artículo, Kulkarni et al39 compararon los perfiles de recuentos de citas producidas por la Web of Science, Scopus y Google Scholar a 3 importantes revistas médicas (N Engl J Med, Lancet y JAMA). Google Scholar y Scopus recuperaron más citaciones por artículo que la Web of Science. Además, en comparación con la Web of Science, Scopus encontró más citaciones desde revistas no publicadas en inglés y desde revisiones, pero menos citaciones desde artículos, editoriales y cartas. Finalmente, Google Scholar presentó menos citaciones a artículos en los que existía una declaración explícita de la participación de la industria, a estudios sobre fármacos o dispositivos médicos y a artículos con autoría de grupo. Por tanto, este estudio confirma que estas 3 bases de datos producen recuentos de citaciones a artículos médicos cuantitativa y cualitativamente diferentes39.

Por último, también debemos recordar que el Índice Médico Español40 y Scielo41, desarrollados en nuestro país y en Latinoamérica, son alternativas muy interesantes y que los resultados de sus búsquedas complementan los proporcionados en las bases de datos más establecidas.

Impacto, prestigio y calidad de las publicacionesFactor de impactoEl FI fue concebido en 1955 por Eugene Garfiel, el fundador del ISI, como un indicador de la calidad de las revistas y ha sido extensamente utilizado en los últimos 30 años42,43. Inicialmente fue desarrollado para ayudar a los bibliotecarios a elegir de entre las revistas más citadas a las que les convenía suscribirse42,43. Es un indicador sencillo que permite comparar las diferentes revistas científicas independientemente de su tamaño42–50. Básicamente, calcula la media de citaciones por artículo durante un determinado periodo de tiempo. El FI de una revista para un año determinado se calcula según el número de citas recibidas durante ese año (solo desde revistas indexadas por el ISI) a cualquier artículo publicado por la revista en los 2 años precedentes (numerador) dividido por el número total de artículos «citables» publicados por la revista en esos 2 años (denominador)42–53. Debemos insistir en que solo se contabilizan las citas que provienen de revistas seleccionadas por el ISI y que el denominador no incluye todos los artículos publicados, sino tan solo los considerados como citables por esta entidad (se excluyen cartas al editor y editoriales).

Este índice se ha «sacralizado» como el mejor indicador de calidad existente para las revistas médicas42–52. Es muy sencillo de calcular y ha sido plenamente aceptado por la comunidad científica internacional e incluso por el mundo de los editores. De hecho, a pesar de sus limitaciones obvias (es imposible reducir toda la calidad que atesora una publicación científica a una sola cifra), los editores siempre se congratulan, y escriben editoriales, cuando el FI de sus revistas crece. Los FI de las diferentes revistas se publican anualmente en el Journal Citations Reports.

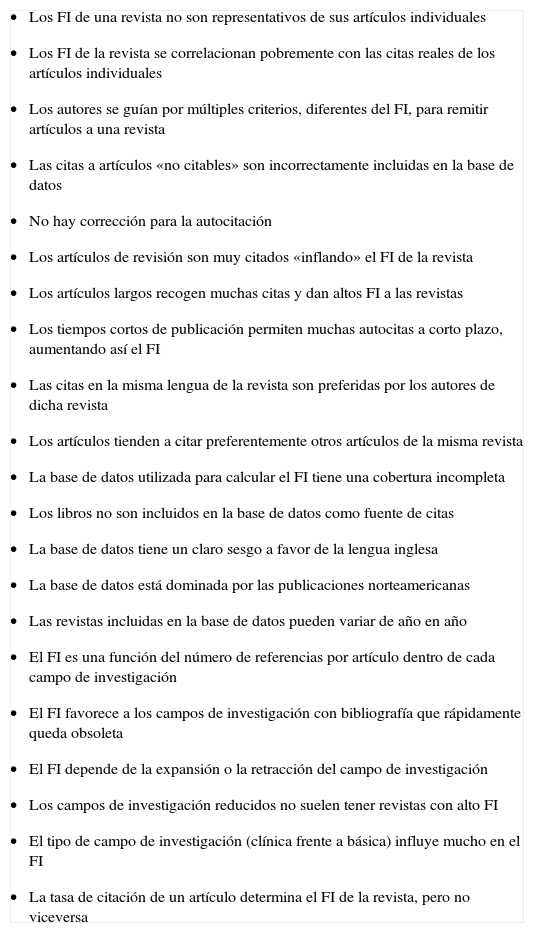

Seglen analizó brillantemente, en un artículo que ya se considera un clásico44, las limitaciones fundamentales del FI (tabla 2). Una muy aparente es que solo analiza las citaciones a corto plazo. Sin embargo, hay áreas científicas donde la dinámica de las citaciones es más lenta y se ha considerado que en muchas especialidades médicas el «cénit» de las citaciones ocurre a los 5 años tras la publicación del artículo51. Por eso, actualmente el ISI también calcula un FI diferente basado en un análisis de las citaciones durante 5 años. Además, si existen muchas revistas de una determinada especialidad o área del conocimiento también se producirá un mayor número de citaciones que lógicamente afectará al FI calculado. Por eso, el FI permite solo comparar revistas dentro de cada disciplina científica42–52. Un ejemplo claro son las revistas básicas que, en general, gozan de mayores FI (sus artículos son citados tanto por clínicos como por básicos) mientras que las revistas clínicas, aunque pueden ser incluso más influyentes a la hora de cambiar la práctica asistencial, suelen recibir un menor número de citas. Las revistas de medicina general, por sus amplios contenidos y gran público, también reciben más citas que las revistas de especialidades. Las revistas que incluyen muchos artículos de revisión (artículos con muchas citas y, a su vez, hasta 3 veces más citados) también disfrutan de mayores FI aunque no aporten información original novedosa42–52. Las revistas en inglés están mucho mejor representadas en la base de datos del Science Citation Reports. Además, se han demostrado importantes sesgos en la dinámica de citaciones por los que las revistas europeas reciben menos citas desde artículos con autores norteamericanos. Estos 2 factores explican el porqué el FI de las revistas europeas publicadas en lenguas diferentes del inglés suele ser mucho menor42–52. Como veremos, esto ha condicionado diferentes propuestas para intentar contabilizar todas las citaciones que se producen desde cualquier revista científica. Además, el FI no valora la calidad de las citas. Un claro ejemplo de este problema es la autocitación y, parece lógico, no dar el mismo valor a estas citas como medida de influencia científica. Actualmente, el ISI ya informa de la tasa de autocitación. Sin embargo, este comportamiento es completamente natural en determinadas situaciones, como en revistas nacionales, especialmente en revistas de sociedades científicas no editadas en inglés y en disciplinas con un reducido ámbito de influencia42–52. Por último, se ha criticado mucho la falta de transparencia del ISI en el cálculo de los artículos que determinan el denominador del FI y, lo que todavía es peor, su falta de reproducibilidad53.

Problemas y limitaciones del factor de impacto de las revistas científicas

|

Adaptada de Seglen et al44.

FI: factor de impacto.

Teóricamente, los editores también pueden influir en el FI de sus revistas, disminuyendo el número de artículos publicados (reducirá el denominador), estimulando las autocitas y publicando un mayor número de artículos de revisión, cartas y editoriales. Sin embargo, la mejor forma de incrementar el FI de una revista es mejorar la calidad científica de los artículos publicados, mejorar los estándares de calidad editorial y científica de la publicación y, finalmente, impulsar la difusión internacional de sus contenidos42–52.

El FI solo debe aplicarse a las revistas (permite un benchmark de éstas), pero los artículos o los investigadores se valoran mejor por el número de citas recibidas. De hecho, el FI de la revista no es representativo del FI de un artículo determinado. En realidad, menos del 20% de los artículos son responsables de más del 80% de las citas recibidas por la revista. Por eso, el FI de una revista está decisivamente condicionado por sus artículos más citados (al no ser una variable normal debería expresarse como mediana, no como media)42–52. Si tuviéramos que juzgar un artículo atendiendo a un único parámetro, este probablemente debería ser el número de citaciones que recibe. Lo que realmente importa es el contenido científico de un artículo, es decir, su aportación original al avance del conocimiento, y ningún análisis puede sustituir a su lectura y su valoración crítica por un panel de expertos. Muchas veces, los científicos son más valorados por dónde publican que por qué es lo que publican. Eugene Garfield (creador del FI) ya alertaba desde un principio de los riesgos de utilizar este índice para valorar a los investigadores o a los artículos individuales42,43.

A pesar de todas las limitaciones mencionadas, múltiples estudios han encontrado una buena correlación entre el FI y diferentes indicadores de la calidad científica de las publicaciones52. Además, este sencillo y popular índice bibliométrico ha sido ampliamente aceptado por la comunidad científica internacional y ningún nuevo indicador ha logrado superarlo42–52.

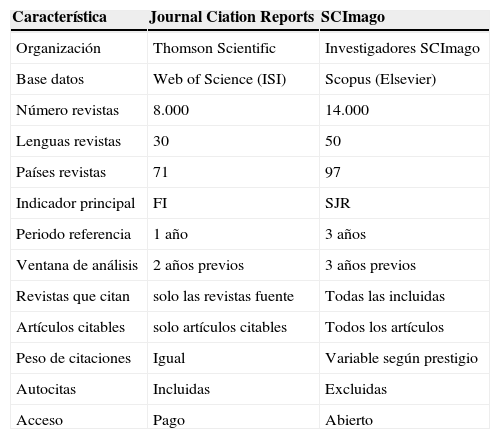

SCImago Journal & Country RankSCImago Journal & Country Rank (SJR)35,54 es una nueva herramienta de libre acceso generada desde varias universidades españolas que permite analizar la «visibilidad» de las revistas que se encuentran en Scopus. Se basa en la transferencia de «prestigio» que se produce desde una revista a otra. El prestigio se transfiere por las referencias que una revista da al resto de las revistas y a sí misma54. El algoritmo utiliza la metodología de PageRank38 para atribuir diferente valor a las citaciones dependiendo del prestigio de la revista de procedencia. Además, en la valoración final se elimina la influencia de las autocitas. Es más que plausible que los artículos de una revista tengan un mayor impacto científico si son citados en las revistas de mayor prestigio. El SJR básicamente correlaciona las citaciones recibidas por la revista durante un determinado tiempo (3 años previos) con el número total de artículos publicados. Sin embargo, a diferencia del cálculo del FI, para este índice todos los documentos cuentan en el denominador y no solo los artículos citables (tabla 3)35,54. La mayor cobertura de la base de datos Scopus ha hecho sugerir que este indicador podría tener especial interés en la valoración de revistas que se publiquen en lenguas diferentes del inglés. De forma similar al FI, también permite clasificar a las revistas por cuartiles dentro de cada categoría. Además, esta base de datos facilita un uso social de la información y ha creado cuentas para Facebook y Twitter a fin de contactar con los usuarios de una forma más versátil54. Este nuevo indicador tiene muy buenas expectativas y se está consolidando como una verdadera alternativa al clásico FI debido a 1) su accesibilidad (es de acceso gratuito); 2) la mayor cobertura de su base de datos (mayor variedad de países y lenguas) y, sobre todo, 3) que valora la diferente calidad de las citas recibidas por cada revista según el prestigio de la revista de donde provienen35.

Comparación de indicadores sobre revistas científicas

| Característica | Journal Ciation Reports | SCImago |

| Organización | Thomson Scientific | Investigadores SCImago |

| Base datos | Web of Science (ISI) | Scopus (Elsevier) |

| Número revistas | 8.000 | 14.000 |

| Lenguas revistas | 30 | 50 |

| Países revistas | 71 | 97 |

| Indicador principal | FI | SJR |

| Periodo referencia | 1 año | 3 años |

| Ventana de análisis | 2 años previos | 3 años previos |

| Revistas que citan | solo las revistas fuente | Todas las incluidas |

| Artículos citables | solo artículos citables | Todos los artículos |

| Peso de citaciones | Igual | Variable según prestigio |

| Autocitas | Incluidas | Excluidas |

| Acceso | Pago | Abierto |

Adaptado de Falagas et al35.

FI: factor de impacto; ISI: Institute for Scientific Information; SJR: SCImago Journal & Country Rank.

Recientemente, Falagas et al35 realizaron un estudio para comparar el FI con el SJR en 100 revistas de alta calidad. De las 20 revistas con mayor FI, 13 estaban entre las 20 primeras del SJR, y viceversa. Sin embargo, muchas revistas variaban ampliamente su posición de orden según el indicador utilizado. Así, entre las 100 mejores revistas ordenadas según su FI, el cambio absoluto de posición era considerable (32 puestos de mediana) cuando se ordenaban según el SJR35.

EigenfactorEste indicador, inicialmente propuesto por Carl Bergstrom en Whasington, clasifica las revistas según su influencia55,56. Ésta, a su vez, se mide también de una forma similar a la que Google utiliza para clasificar la importancia de las diferentes páginas web en sus búsquedas. Se basa en un algoritmo que permite seguir las cadenas de citaciones realizadas por los investigadores cuando navegan por la Web de revista en revista. El score del Eigenfactor permite estimar la importancia total de la revista para la comunidad científica55,56. De este modo, si una revista duplicara la cantidad de artículos publicados, pero mantuviera la calidad de éstos, duplicaría su score del Eigenfactor. Básicamente, permite identificar a las revistas que son más citadas por las mejores revistas. Actualmente, el Journal Citation Reports también presenta información del Eigenfactor56. Desde el punto de vista práctico, este parámetro guarda una estrecha correlación con el número total de citas recibidas por cada revista. El score del Eigenfactor también puede aplicarse también a los artículos para estimar la influencia media de un artículo de una revista, y su cálculo estará normalizado para el total de artículos publicados55.

Valoración académica de los investigadoresEl patrón oro para la valoración de los méritos académicos de un investigador siempre será la valoración meticulosa de la importancia y la repercusión de sus aportaciones científicas por parte de expertos de reconocido prestigio en cada área del conocimiento50. A veces, sin embargo, es preciso valorar el extenso currículum vítae de un gran número de investigadores de una forma rápida y precisa y, en este contexto, algunos indicadores pueden ser de gran ayuda57,58. Además, estos parámetros proporcionan herramientas simples, empíricas, trasparentes y alejadas de la subjetividad, que pueden complementar las valoraciones de los expertos. Actualmente, las bases de datos bibliométricas permiten realizar estudios de la producción de los autores que antes eran antes impensables. No obstante, estos análisis deben ser muy cuidadosos. Por ejemplo, un problema inicial, es identificar correctamente a los autores homónimos o todas las variaciones del mismo nombre (uno o dos apellidos, separados o no por guión) utilizadas en distintas publicaciones59. Además, cada uno de estos indicadores refleja una visión muy parcial de la realidad y ningún parámetro aislado puede competir con la revisión realizada en un proceso de valoración por pares. Finalmente, los propios investigadores pueden adaptar sus políticas de investigación, elegir las revistas, o seleccionar las citas bibliográficas que les sean más convenientes para mejorar estos índices17.

La valoración de la investigación es importante en la estimación de méritos para promociones académicas o profesionales50,57–69. También es fundamental para los organismos de financiación de la investigación competitiva que, habitualmente, trabajan en un escenario de asignación de recursos limitados. Las becas y los proyectos financiados también pueden valorarse pero, en realidad, no representan la producción científica final y, a veces, tienen una pobre correlación con ella51. No obstante, algunas universidades tienden a contratar a los investigadores atendiendo más a su capacidad de conseguir becas que a su producción científica final. Esto solo refleja la actual necesidad de los hospitales académicos de reducir gastos. Además, este mérito ya está recompensado (el aporte económico de la beca) y, en general, no parece adecuado volver a premiarlo cuando se analizan los méritos de la investigación51.

Quizá sea oportuno reflexionar también sobre el mérito relativo de los investigadores51. Está claro que las diferencias en los recursos dedicados a la investigación de los diferentes países, dentro de las propias instituciones o dentro de un contexto general que estimule en mayor o menor medida la investigación afectarán a la capacidad productiva de los investigadores70,71. Los investigadores que producen a pesar de tener una gran presión asistencial, escaso reconocimiento académico, poco apoyo institucional y a veces con unos medios muy limitados merecen especial reconocimiento. Sin embargo, no se debe penalizar a los investigadores que trabajan en las instituciones más punteras simplemente por el mero hecho de que se hayan profesionalizado o tengan mejores condiciones de trabajo. Es probable que ambas cosas, el mérito y los resultados o éxitos cosechados, deban ser tenidas en cuenta.

Número de artículos y citacionesClásicamente se ha considerado que el número total de artículos publicados, el número total de citaciones recibidas y la media de citaciones por artículo producen una estimación razonable de la producción y la calidad científica de los investigadores57–65. En definitiva, se debe valorar la productividad (número total de publicaciones) y también el impacto científico alcanzado (número total de citaciones recibidas). Aunque en principio esto podría parecer una cuestión muy simple, veremos cómo, a veces, su correcto análisis puede no ser tan sencillo.

No todos los artículos tienen el mismo valor57–65. En primer lugar, un artículo original que presente datos novedosos representa una mayor aportación al avance del conocimiento que una revisión, por muy buena que ésta sea. En segundo lugar, no todos los artículos originales son iguales. En este sentido, los artículos de mayor calidad tienden a publicarse en las revistas con mayor FI y, por eso, se ha asumido que la suma total del FI de los artículos publicados en las diferentes revistas podría ayudar a diferenciar la calidad de los artículos. Sin embargo, como antes hemos indicado, aunque el FI es adecuado para comparar revistas dentro de cada disciplina, tiene muchas limitaciones para comparar artículos y, en general, no debe utilizarse para la comparación de los investigadores50. Algunas instituciones europeas aplican en la valoración de los investigadores una ponderación de «cero» para todos los artículos publicados en revistas con FI inferior a 556 o bien valoran únicamente las publicaciones en las revistas del primer cuartil. Esto podría ayudar a identificar a los investigadores más competitivos pero, en definitiva, sigue presentando los problemas derivados de emplear el FI en la valoración de los científicos50.

La competición por producir es cada vez mayor y también lo es la necesidad de los diferentes grupos de investigación de ser cada vez más productivos. Esto puede favorecer distorsiones del proceso científico50,66,67. El efecto «panadería» (bakery effect) consiste en la necesidad de seguir publicando constantemente en revistas de prestigio. Esto podría favorecer la publicación de información en pequeñas dosis (unidad mínima publicable), el «salami slicing», las publicaciones redundantes, el autoplagio o incluso el fraude científico50,66,67. Estas estrategias inadecuadas tienden a incrementar el número de artículos publicados, pero finalmente reducen el valor de su contenido, por lo que, en el mejor de los casos, pagarán el precio de recibir un menor número de citaciones. Los lectores merecen recibir toda la información necesaria en un solo artículo.

Los recuentos de las citaciones recibidas tienen valor para estimar el impacto real que las aportaciones realizadas han tenido en la comunidad científica, pero no discriminan si las citas provienen de revistas influyentes, son del cuartil inferior de la disciplina o bien si las citas corresponden a autocitaciones57–65. Los investigadores también pueden valorarse por el número medio de citas que reciben sus artículos. De esta forma se valora, no solo unos pocos artículos muy citados, sino la repercusión completa del trabajo global del investigador. Por otra parte, cada vez se resalta más la importancia de la colaboración entre centros en la investigación para ser más eficientes y productivos. Esto conduce al aumento de artículos multiautor y multiinstitución. Sin embargo, se diluyen los méritos científicos y su valoración se hace más compleja, ya que estos artículos tienen muchas más probabilidades de ser citados, especialmente en autocitas57–65. No es infrecuente que los artículos más citados correspondan a guías clínicas, documentos de consenso o estudios multicéntricos internacionales con un número muy alto de investigadores, donde no es posible definir adecuadamente la aportación intelectual real de cada autor ni si la autoría se debe a aportaciones científicas o de otra índole. De hecho, se ha sugerido que colaboraciones anecdóticas pero afortunadas con investigadores de prestigio permiten producir verdaderos «pelotazos científicos» que distorsionan el análisis de las citaciones recibidas64.

En artículos con muchos autores, el crédito de la investigación se otorga habitualmente de forma completa a cada autor o, como mucho, se corrige dividiéndolo entre el número de autores. Sin embargo, esto produce importantes sesgos en las estimaciones (denominados inflacionistas y de ecualización) que distorsionan las medidas bibliométricas y que sistemáticamente benefician a los autores secundarios. Para evitar este problema, se ha prestado mucho interés en realizar una «valoración armónica» del crédito otorgado a las publicaciones científicas con muchos autores60. Esta idea, inicialmente propuesta por Hodge ya en 198161, sugiere otorgar el mérito científico atendiendo al rango del autor (máximo para el primer firmante) y al número total de autores. Así, el crédito se comparte entre todos los autores pero garantizando que el primer autor recibe el máximo crédito y que cuanto mayor es el número de autores menor es el crédito de cada uno. Se ha sugerido que estas correcciones tienden a disminuir las disparidades entre las estimaciones automáticas del mérito con respecto a las valoraciones basadas en el juicio de los expertos60.

Tanto cuando se analiza el número de artículos publicados como las citas recibidas deben considerarse las aportaciones propias del autor en cuestión en cada trabajo. Como hemos indicado, en parte por presiones académicas, el número de autores de los trabajos va aumentando progresivamente. Por eso los editores de las revistas científicas cada vez exigen que se sea más explícito al presentar la aportación intelectual de cada autor y su participación en cada fase de la investigación. Según el Comité Internacional de Editores de Revistas Médicas26,27 son necesarios 3 criterios para que se cumplan los requisitos de autoría: 1) contribución sustancial en la concepción y el diseño del estudio o en la adquisición, el análisis y la interpretación de los datos; 2) redacción o revisión crítica del trabajo, y 3) aceptación de la versión final del manuscrito. Para ser autor se deben cumplir los 3 requisitos. Otras colaboraciones parciales o de distinta índole (adquisición de fondos, obtención de datos, supervisión general del equipo investigador) no justifican autoría, pero deberían ser reconocidas en los agradecimientos. Este grupo también insiste en los problemas derivados de los autores que no aparecen en la publicación (autores fantasma) y de los autores que aparecen sin justificación (autores honorarios). No infrecuentemente en la lista de autores se incluyen nombres, simplemente por trabajar en el mismo grupo, por amistad, por motivos políticos, de financiación o de simple jerarquía26,27.

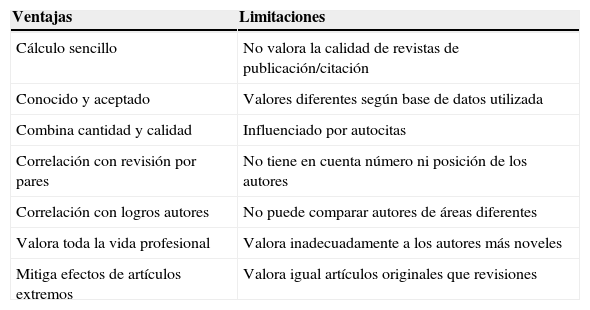

Índice de HirschSe ha sugerido que el índice de Hirsch, o índice «h» (tabla 4), propuesto por Jorge Hirsch, un físico de la universidad de California, podría ayudar a determinar el valor científico de las contribuciones de un determinado investigador, clasificando los artículos de acuerdo con el número de citaciones recibidas por cada uno de ellos57,58,60,61. Para calcularlo, en primer lugar, los artículos de un autor son ordenados por el número de citas recibidas. Posteriormente, se identifica el lugar donde coinciden el número de artículos publicados con el número de citas recibidas por dichos artículos (ordenados por orden decreciente). Es decir, se identifica la publicación con un número de citas mayor o igual que su número de orden57,58,60,61. Un autor con un índice h de 100 significa que 100 de sus artículos han sido citados por lo menos 100 veces cada uno. A su vez, el conjunto de publicaciones que determinaran el índice h se denominan «core» de Hirsch57,58.

Ventajas y limitaciones del índice «h», o de Hirsch

| Ventajas | Limitaciones |

| Cálculo sencillo | No valora la calidad de revistas de publicación/citación |

| Conocido y aceptado | Valores diferentes según base de datos utilizada |

| Combina cantidad y calidad | Influenciado por autocitas |

| Correlación con revisión por pares | No tiene en cuenta número ni posición de los autores |

| Correlación con logros autores | No puede comparar autores de áreas diferentes |

| Valora toda la vida profesional | Valora inadecuadamente a los autores más noveles |

| Mitiga efectos de artículos extremos | Valora igual artículos originales que revisiones |

Cuanto mayor sea el índice h de un investigador mayor será su impacto en la literatura científica. Es un índice relativamente estable y refleja bien la productividad global —mantenida en el tiempo— de cada investigador, es decir, su trayectoria científica, y por eso se ha asimilado a un verdadero «índice bibliográfico». Por tanto, será útil para comparar investigadores con similar tiempo de carrera profesional o años de experiencia57,58. Se ha sugerido que este índice sería el menos malo de los indicadores cuando se pretende utilizar tan solo uno de ellos para valorar a los investigadores56. Generalmente se basa en los artículos y las citaciones recogidas por el ISI, pero también pueden utilizarse otras bases de datos como Scopus. En el índice h calculado por el ISI, las citaciones que no se produzcan en revistas incluidas en la Web of Science no serán consideradas, independientemente de cuántas veces sean citadas. Lamentablemente, una vez más, este índice no parece valorar adecuadamente a los investigadores mas noveles ni reconoce adecuadamente los méritos de los investigadores españoles o iberoamericanos sistemáticamente infrarrepresentados en el ISI68. Además, el índice h es diferente para cada disciplina al estar (como el FI) afectado por el número de revistas que la forman y por la actividad científica global generada en cada campo. Hay áreas de investigación más «populares», donde los investigadores obtendrían un mayor índice h con las mismas aportaciones científicas, mientras que en áreas más reducidas, con pocas revistas, los índices h serán menores a pesar de que los descubrimientos puedan ser más relevantes. No todos los motores de búsquedas estiman los mismos índices h; por ejemplo, el de Scopus es generalmente mayor que el estimado con el ISI)57,58,60,61.

Entre sus ventajas se han destacado que su cálculo es muy sencillo, que combina de forma equilibrada la cantidad de las publicaciones (número) con su calidad (citas que reciben), que tiene buena correlación con procesos de revisión por pares y con la progresión de la carrera científica y que valora el esfuerzo mantenido a lo largo de toda la vida profesional. Se ha demostrado que este índice se correlaciona tanto con los resultados obtenidos en la petición de ayudas competitivas para la investigación como con la valoración del juicio de expertos de los méritos de investigación. Además, elimina la influencia de los artículos extremos, más y menos citados57,58,60–65.

Entre sus limitaciones es preciso recordar que no tiene en cuenta la calidad de las revistas donde se publican los artículos ni de las revistas desde las que provienen las citaciones y que prima a las carreras científicas mas dilatadas. Además, no tiene en cuenta el número de autores ni su posición relativa, con lo que puede favorecer que muchos investigadores de grupos muy activos simplemente se beneficien de dejarse «arrastrar» por el esfuerzo del resto del grupo. El índice depende del campo o la disciplina y está afectado por las autocitas57,58,60–65. Este problema puede ser importante, ya que Fowler et al69 demostraron que en determinadas situaciones hasta el 50% de las citaciones de una investigación pueden deberse, directa o indirectamente, al efecto de las autocitaciones. Además, las revisiones y los artículos de investigación cuentan lo mismo en el índice h, cosa que no deja de ser sorprendente cuando se intenta valorar la creación de conocimiento nuevo. Finalmente, le falta sensibilidad para ver si el nivel productivo del investigador progresa o está estancado (el índice siempre crece con el tiempo)57,58,60–65.

Por todos estos motivos ya se han propuesto algunas modificaciones y ajustes de este índice57,58,60–65. El cociente «m» de un científico se calcula dividiendo su índice h por el número de años de actividad investigadora desde la publicación de su primer artículo. El índice «h1» reduce los sesgos que sobrestiman el mérito de los autores que únicamente participan como coautores, mientras que el índice «hc» excluye el valor de las autocitas. A su vez, el índice «a» es el número de las citaciones recibidas por las publicaciones que forman el «core» de Hirsch. Finalmente, como el índice h puede igualar a investigadores independientemente de las citas recibidas por sus artículos más citados (valora solo los artículos que forman el «core» Hirsch), se ha propuesto un índice «g» y también un índice «e», que permiten reconocer el valor diferencial aportado por los artículos más citados de cada investigador62,63. En realidad estos índices son estimadores complementarios, ya que investigadores con un índice h muy similar (su margen es relativamente estrecho) pueden tener importantes diferencias en el número total de citas recibidas por el efecto de los artículos más citados. Recientemente se ha sugerido calcular un índice h «armónico», en el que se valora mejor el mérito científico real de los investigadores al tener en cuenta el número de los autores de las publicaciones y, sobre todo, los méritos del primer autor. Otros investigadores aconsejan calcular directamente el índice h de las publicaciones realizadas como primer autor51. Esto parece tener mucho sentido, ya que el índice h se ha considerado como un FI «personal».

Si este índice se impusiera de forma hegemónica en las valoraciones curriculares podría tener implicaciones impredecibles en los hábitos de publicación o en las estrategias de los investigadores. Así, algunos investigadores podrían favorecer la autocitación selectiva de los artículos que más beneficio obtengan con dichas citas al encontrarse ya cerca de la famosa «línea verde» que les permite entrar a formar parte del «core» de Hirsh e incrementar el número h60–65. También podría desestimular la realización de trabajos que terminen en publicaciones modestas o prestar ayuda a jóvenes investigadores, ya que los trabajos resultantes difícilmente contribuirán a mejorar el índice h del investigador principal65. Peor aún, en vez de supervisar estrechamente el trabajo del equipo de investigadores, el investigador senior podría encontrar más rentable escribir múltiples revisiones en las que, de una forma discreta y elegante, se describan (y citen) sus trabajos previos65. Debemos recordar que «invertir» en promocionar el índice h es una estrategia muy efectiva a largo plazo, ya que este indicador nunca desciende, sino que aumenta linealmente con el tiempo de forma relativamente independiente de si continúa el esfuerzo investigador. Muchos investigadores, actualmente «seniors», vivieron una juventud cualitativa y cuantitativamente diferente, donde la presión para la supervivencia científica era diferente de la generada por la competitividad actual. Sin embargo, parece recomendable que los investigadores seniors que dirijan grupos de investigadores atesoren un número adecuado de publicaciones como primer autor con alto impacto. De hecho, se ha sugerido que debe existir una buena correlación en un autor entre su índice h global y su índice h como primer autor51. Finalmente, debemos recordar que, aunque el índice h se diseñó para investigadores, también se ha propuesto su utilidad para la comparación de departamentos completos o de instituciones diferentes.

Probablemente lo más razonable sea tener una idea desmitificadora de los índices bibliométricos y nunca fiarse de un solo parámetro que necesariamente reflejará una aproximación incompleta, sino que es recomendable analizar varios estimadores. Además, debemos recordar la famosa frase de Albert Einstein: «No todo lo que cuenta se puede contar y no todo lo que se puede contar cuenta»62. Después de todo, el objetivo de la ciencia es el progreso en el conocimiento y, por tanto, su valoración necesariamente precisa del juicio humano y este puede asimilarse tanto a un arte como a una ciencia.

Reflexiones finalesDebemos felicitar a los editores de Endocrinología y Nutrición por su apuesta por mejorar la calidad editorial de la revista, que actualmente ha sido recompensada con su inclusión en MEDLINE4–8. Este merecido logro asegura un futuro prometedor para la publicación. Los lectores de la revista serán los más beneficiados de las medidas de calidad adoptadas. Además, la mayor visibilidad de la revista y su internacionalización atraerán más y mejores contenidos hacia sus páginas con lo que, tras el adecuado proceso de selección, mejorará la calidad de los artículos finalmente publicados. Todos los profesionales dedicados al estudio y al tratamiento de pacientes con enfermedades endocrinológicas disponen ahora de una prestigiosa revista, que deben considerar como una herramienta de inestimable valor para publicar y difundir entre la comunidad científica internacional sus mejores trabajos de investigación. Pueden estar seguros de que el esfuerzo les resultará científicamente rentable.

Conflicto de interesesEl autor declara no tener ningún conflicto de intereses.