Describir el proceso de evaluación de comunicaciones al Congreso de la Sociedad Española de Calidad Asistencial 2011, con énfasis en el procedimiento para controlar la variabilidad interevaluador.

Material y métodoProceso descrito mediante IDEF0. Estudio de intervención en ciego para conocer y controlar la variabilidad de los evaluadores. Cinco comunicaciones fueron valoradas por los 27 evaluadores del congreso utilizando 4 criterios explícitos. La suma de puntuaciones fue utilizada para calcular la variabilidad. La razón de variabilidad (RV) de cada evaluador, obtenida al dividir la media de puntuaciones por su puntuación, se empleó para controlar la variabilidad ajustando las puntuaciones brutas.

ResultadosMisión del proceso: «evaluar de forma ágil, transparente y equitativa las comunicaciones recibidas al congreso de la SECA». Se identificó como clientes y se exploraron necesidades y expectativas de congresistas, autores y SECA. Se desarrolló diagramado IDEF0. Variabilidad: puntuación máxima 170, mínima 37, media 115,4, coeficientes: variación 23%, asimetría −0,7, curtosis 2,1. RV máxima 3,12, mínima: 0,68.

ConclusionesIDEF0 puede servir para avanzar en la mejora del proceso de evaluación y facilitar el trabajo de futuros comités. La variabilidad entre evaluadores es alta. RV es una herramienta fácil de obtener y sencilla de aplicar que produce puntuaciones ajustadas para controlar la variabilidad interevaluador.

To describe the abstracts assessment process in the 2011 Conference of the Spanish Society for Quality in Health Care, focusing on the procedures adopted to control the interobserver variability.

Material and methodsProcess described using the IDEF0 model. An interventional blinded study is designed to know and control the interobserver variability of the 27 Conference appraisers, who scored 5 submitted abstracts using 4 explicit criteria. The sum of these scores is used to estimate the variability. The variability ratio (VR) of every appraiser is obtained dividing the average score by his total score, and used to control the variability adjusting the gross score of every abstract.

ResultsProcess mission: “to assess the abstracts submitted to Conference in an easy, open and fair way”. Attendants to the conference, abstract authors and the Society have been identified as clients, their needs and explored expectations. Variability scores: maximum 170, minimum 37, average 115.4. Coefficients: variation 23%, asymmetry −.7, kurtosis 2.1. VR: maximum 3.12, minimum .68.

ConclusionsIDEF0 diagrams could be useful to improve the evaluation process and facilitate the work of future scientific committees. The appraisers’ variability was too important to be omitted. VR is an easy to get and simple to use tool that produces adjusted scores to control this

Desde su constitución, la Sociedad Española de Calidad Asistencial (SECA) desarrolla un congreso anual. Este congreso constituye la principal actividad para sus socios y la que más repercusión científica, social y económica le produce. Por este motivo, SECA ha elaborado un Manual de Congresos con la aspiración de ser reconocida por su objetividad, transparencia, innovación, respeto, pluralidad y orientación al congresista como destinatario principal de sus actuaciones. Además analiza, revisa y evalúa sistemáticamente los congresos celebrados para propiciar su mejora continua y aportar nuevos elementos que permitan rediseñar futuras ediciones1–12.

Aunque los formatos de los congresos de SECA son similares a los de otras sociedades científicas e incluyen la presentación de ponencias y comunicaciones orales y en póster, se dan en ellos 2 elementos no habituales: 1) la selección de 4 de las comunicaciones presentadas para transformarlas en ponencias en una mesa denominada de «mejores experiencias», y 2) la concesión de premios tanto a la mejor de ellas como a las mejores comunicaciones presentadas de forma oral y en póster. Estos elementos aportan un indudable valor añadido a los congresos de SECA pero hacen más complejo el proceso de evaluación. Además de decidir si cada comunicación presentada es aceptada o rechazada para su exposición en el congreso, es necesario seleccionar las comunicaciones candidatas a premio y a «mejores experiencias» para después elegir, tras su exposición en el congreso, las que resultan finalmente premiadas. Por ello, el proceso de evaluación es sometido a mejora continua a fin de mejorar su objetividad y disminuir la variabilidad interevaluador que se ha detectado en diferentes ocasiones9. Las medidas correctoras introducidas con relación al anonimato de los evaluadores, a la transparencia de los criterios de puntuación, a la utilización de criterios explícitos y a la mejora de la participación y democratización de la toma de decisiones, no han terminado de resolver los problemas inherentes a este tipo de evaluación. El estudio pretende describir el proceso de evaluación de comunicaciones seguido en el xxix Congreso de la SECA realizado en Murcia en 2011, con especial énfasis en el procedimiento adoptado para controlar la variabilidad interevaluador.

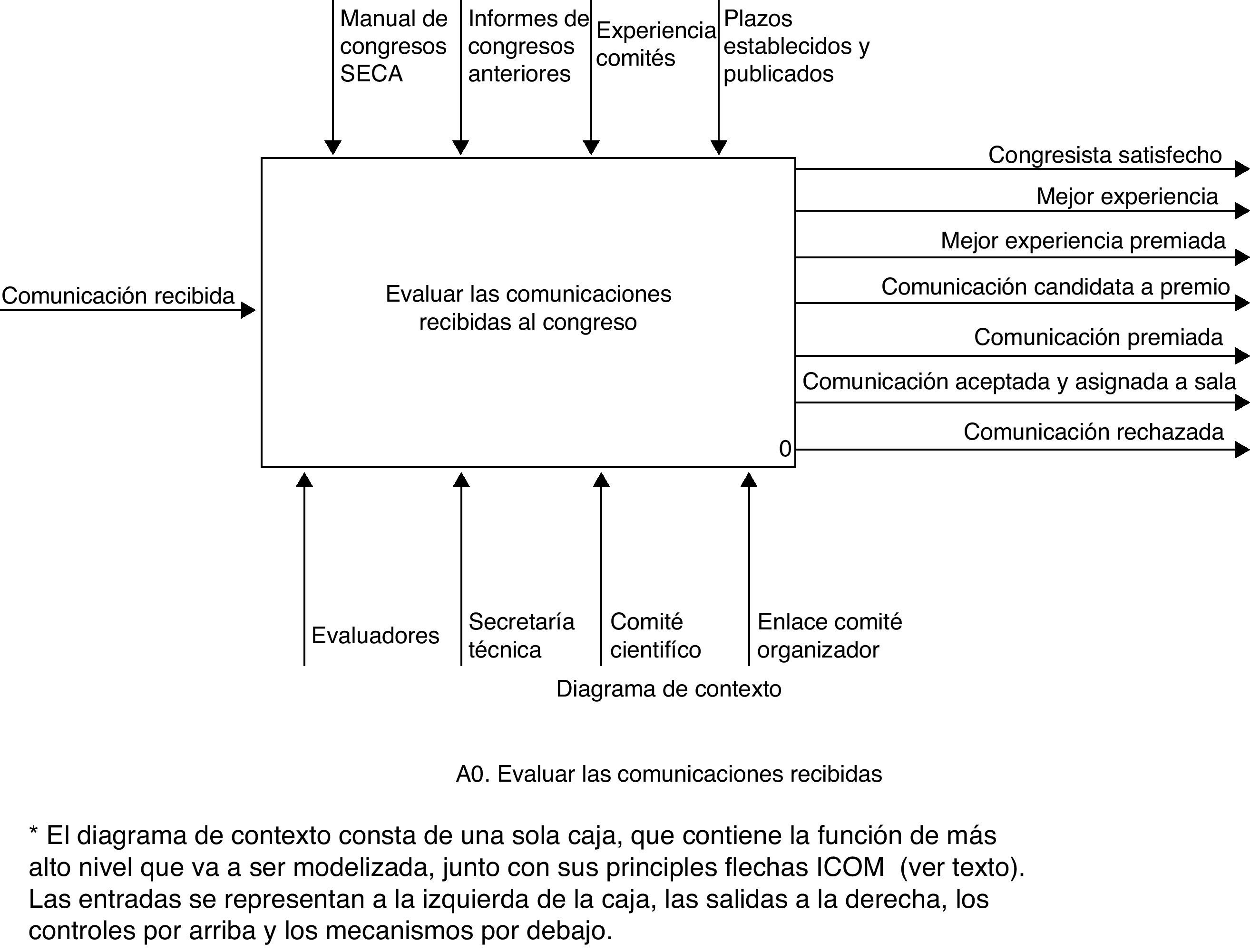

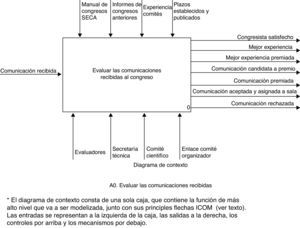

Material y métodoProceso de evaluación de comunicacionesSu descripción se realizó mediante la metodología IDEF0 (Integration Definition for Function Modeling: definición de la integración para la modelización de las funciones), que abordaba los procesos como una serie de funciones interrelacionadas13,14. Estas funciones se analizaron de forma totalmente independiente de cómo, en qué orden y por quién deban llevarse a cabo, para lo que existían otras técnicas más apropiadas. El modelo IDEF0 produjo una serie de diagramas jerárquicos formados por cajas, que representan las funciones, y 4 tipos de flechas conocidas con el acrónimo ICOM: entradas («inputs»), controles (condiciones requeridas para producir un «output» correcto), salidas («outputs») y mecanismos (lo que se necesita para desarrollar una función). Previamente al diagramado fue necesario definir la misión y alcance del proceso, los clientes y sus necesidades y expectativas. Para este fin se ha recurrido a los resultados de la encuesta de satisfacción del congresista de ediciones anteriores12, los estatutos de la SECA15, y a la experiencia de los autores.

Procedimiento para el análisis y control de la variabilidad interevaluadorEl comité científico del congreso SECA 2011 contaba con 27 vocales que actuaron como evaluadores distribuidos por parejas (un trío). Cada uno de ellos evaluó un número similar de comunicaciones no procedentes de su misma comunidad autónoma (para minimizar la redistribución de comunicaciones por conflictos de interés), y que le fueron remitidas por secretaría técnica en 2 o 3 envíos. Para ello se utilizaron 4 criterios explícitos que se puntuaron en una escala de 1 a 10 (tabla 1). La puntuación total de una comunicación fue la media de puntuaciones otorgada por sus evaluadores.

Criterios de evaluación de comunicacionesa

| Criterios de evaluación |

| Objetivos y metodología |

| Los objetivos están formulados explícitamente y claramente definidos, el método seguido para conseguirlos es adecuado y está descrito suficiente y adecuadamente |

| Resultados y conclusiones |

| Existen resultados, que son claros y precisos y guardan relación con los objetivos y el método utilizado. Las conclusiones son claras y se derivan de los resultados obtenidos |

| Interés y originalidad |

| El tema tiene un especial interés por su carácter novedoso y original, el valor de las conclusiones o el ámbito del estudio |

| Valoración global |

| Impresión general del evaluador |

Para conocer y controlar la variabilidad de los evaluadores se diseñó un estudio de intervención en ciego. Las 5 primeras comunicaciones recibidas procedentes de una comunidad autónoma a la que no pertenecía ningún evaluador fueron remitidas a la totalidad de ellos para su valoración, junto al resto de las comunicaciones que conformaban el primer envío. Ni los autores de las comunicaciones ni los evaluadores eran conocedores del estudio. La suma de las 5 puntuaciones emitidas por cada evaluador fue la variable utilizada en el cálculo de la variabilidad.

La razón de variabilidad, así como los coeficientes de variación, asimetría y curtosis y los estadísticos descriptivos de tendencia central y dispersión habituales fueron los parámetros utilizados para valorar la variabilidad. La razón de variabilidad se obtuvo al dividir la media global de puntuaciones por la puntuación total de cada evaluador. Para controlar la variabilidad se ajustó la puntuación bruta de cada comunicación recibida multiplicándola por la razón de variabilidad del evaluador del que procede, a fin de obtener la puntuación ajustada.

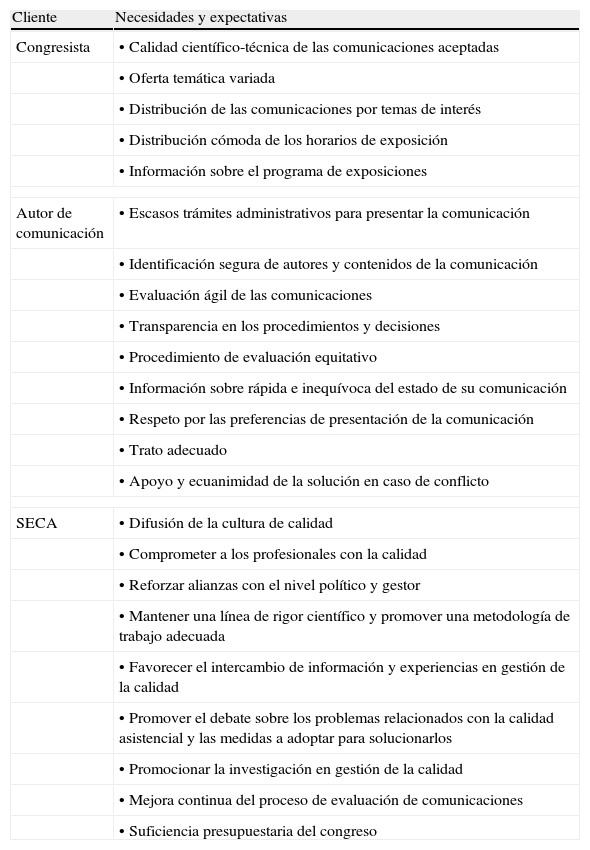

ResultadosProceso de evaluación de comunicacionesEl proceso se ha desarrollado desde una perspectiva organizacional y tuvo por misión «evaluar de forma ágil, transparente y equitativa las comunicaciones recibidas al congreso de la SECA», siendo su alcance desde que se recibían las comunicaciones hasta que se adjudicaron los premios del congreso. Se identificó como clientes a los congresistas y, en particular, a los que son autores de comunicaciones, así como a la propia SECA. De entre las necesidades y expectativas identificadas en los congresistas destacó la calidad científico-técnica de las comunicaciones aceptadas, la temática variada y la información sobre el programa. En los autores, la transparencia y equidad en la evaluación y la información sobre el estado de la comunicación presentada. Por fin, para SECA fue de especial interés conseguir difusión de la cultura de calidad, el compromiso de los profesionales, el rigor científico y la promoción del debate e investigación en calidad asistencial. Una relación detallada de todas ellas se recoge en la tabla 2.

Necesidades y expectativas identificadas en los principales clientes del proceso de evaluación de comunicaciones

| Cliente | Necesidades y expectativas |

| Congresista | • Calidad científico-técnica de las comunicaciones aceptadas |

| • Oferta temática variada | |

| • Distribución de las comunicaciones por temas de interés | |

| • Distribución cómoda de los horarios de exposición | |

| • Información sobre el programa de exposiciones | |

| Autor de comunicación | • Escasos trámites administrativos para presentar la comunicación |

| • Identificación segura de autores y contenidos de la comunicación | |

| • Evaluación ágil de las comunicaciones | |

| • Transparencia en los procedimientos y decisiones | |

| • Procedimiento de evaluación equitativo | |

| • Información sobre rápida e inequívoca del estado de su comunicación | |

| • Respeto por las preferencias de presentación de la comunicación | |

| • Trato adecuado | |

| • Apoyo y ecuanimidad de la solución en caso de conflicto | |

| SECA | • Difusión de la cultura de calidad |

| • Comprometer a los profesionales con la calidad | |

| • Reforzar alianzas con el nivel político y gestor | |

| • Mantener una línea de rigor científico y promover una metodología de trabajo adecuada | |

| • Favorecer el intercambio de información y experiencias en gestión de la calidad | |

| • Promover el debate sobre los problemas relacionados con la calidad asistencial y las medidas a adoptar para solucionarlos | |

| • Promocionar la investigación en gestión de la calidad | |

| • Mejora continua del proceso de evaluación de comunicaciones | |

| • Suficiencia presupuestaria del congreso | |

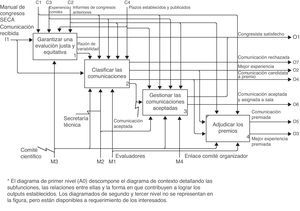

El proceso de evaluación incluyó 4 funciones principales: evaluar las comunicaciones, clasificarlas, gestionar las que resultan aceptadas y adjudicar los premios. El árbol nodal identificado fue:

A0. Evaluar las comunicaciones recibidas al congreso.

A1. Garantizar una evaluación justa y equitativa.

A1.1. Construir el formulario de evaluación.

A1.2. Asignar evaluadores a grupos.

A1.3. Distribuir las comunicaciones recibidas.

A1.4. Ajustar la variabilidad interevaluador.

A2. Clasificar las comunicaciones.

A2.1. Enviar comunicaciones a evaluadores.

A2.2. Recibir y ajustar los resultados.

A2.3. Decidir la distribución de las comunicaciones.

A2.3.1. Elegir las mejores experiencias.

A2.3.2. Elegir comunicaciones candidatas a premio.

A2.3.3. Rechazar las comunicaciones de calidad insuficiente.

A3. Gestionar las comunicaciones aceptadas.

A3.1. Agrupar las comunicaciones por temas.

A3.2. Distribuir las comunicaciones por día y sala.

A3.3. Informar a los autores.

A4. Adjudicar los premios.

La entrada al proceso fue la comunicación recibida, mientras que sus principales salidas fueron las comunicaciones y mejores experiencias aceptadas y asignadas a sala, las candidatas a premio, las premiadas y las rechazadas, así como el congresista satisfecho. Como controladores, se identificaron en el manual de congresos de SECA, los informes de congresos anteriores, los plazos publicados y la experiencia de los miembros de los comités. Por último, se distinguieron 4 mecanismos: los evaluadores, la secretaría técnica, el comité científico y la figura de enlace con el comité organizador. Tanto el diagrama de contexto como su desarrollo de primer nivel se detallan en las figuras 1 y 2.

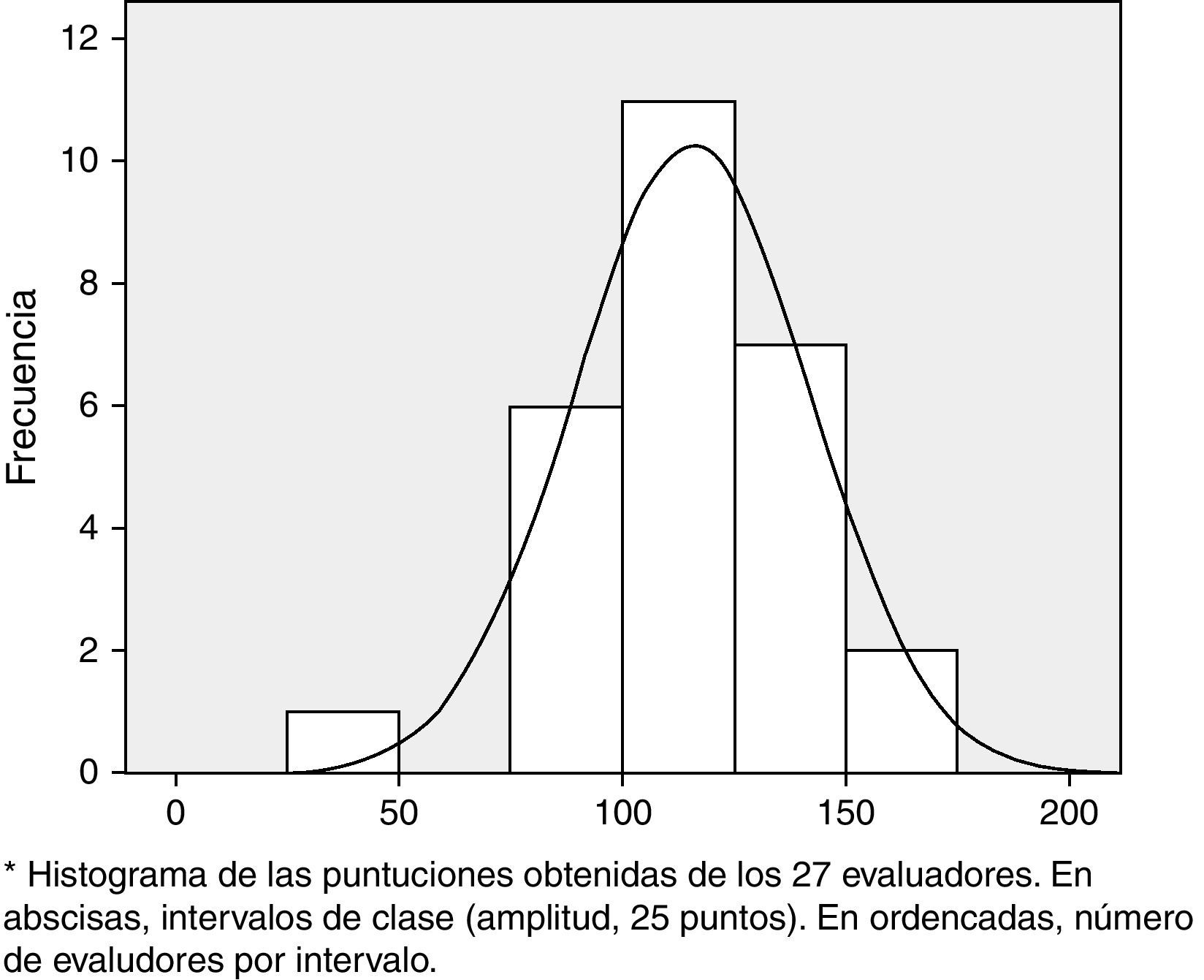

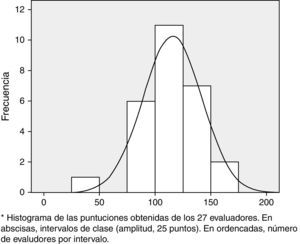

Análisis y control de la variabilidad interevaluadorLos 27 evaluadores puntuaron las 5 comunicaciones enviadas. La media fue de 115,4 puntos (mediana, 118,0), el rango de 133 y el coeficiente de variación: 23%. La distribución de puntuaciones resultó asimétrica leptocúrtica (coeficiente de asimetría, -0,725) y más aglutinada en torno a la media de lo que lo haría una distribución normal (curtosis, 2,094). El histograma de puntuaciones aparece en la figura 3.

Las razones de variabilidad oscilaron entre 3,119 y 0,679, con una media superior a la unidad (1,085) consecuente con la asimetría de la distribución. Dieciséis evaluadores obtuvieron una razón de variabilidad inferior a la unidad, y 7 superior. Los datos de variabilidad se recogen en la tabla 3.

Variabilidad interevaluadora

| Evaluador | Sumatorio de puntuaciones | Razón de variabilidad |

| 1 | 144 | 0,801 |

| 2 | 131 | 0,881 |

| 3 | 118 | 0,978 |

| 4 | 137 | 0,842 |

| 5 | 105 | 1,099 |

| 6 | 120 | 0,962 |

| 7 | 129 | 0,895 |

| 8 | 116 | 0,995 |

| 9 | 89 | 1,297 |

| 10 | 117 | 0,986 |

| 11 | 137 | 0,842 |

| 12 | 107 | 1,079 |

| 13 | 102 | 1,131 |

| 14 | 124 | 0,931 |

| 15 | 99 | 1,166 |

| 16 | 82 | 1,407 |

| 17 | 37 | 3,119 |

| 18 | 131 | 0,881 |

| 19 | 170 | 0,679 |

| 20 | 82 | 1,407 |

| 21 | 120 | 0,962 |

| 22 | 120 | 0,962 |

| 23 | 97 | 1,190 |

| 24 | 97 | 1,190 |

| 25 | 113 | 1,021 |

| 26 | 152 | 0,759 |

| 27 | 140 | 0,824 |

| Estadísticos descriptivos | ||

| Máximo | 170,0 | 3,119 |

| Mínimo | 37,0 | 0,679 |

| Media | 115,4 | 1,085 |

| Mediana | 118,0 | 0,978 |

| DE | 26,2 | 0,446 |

| C. Asimetría | -0,725 | - |

| C. Curtosis | 2,094 | - |

C.: coeficiente; DE: desviación estándar.

Sumatorio de las puntuaciones asignadas a las 5 comunicaciones remitidas a cada evaluador. Los estadísticos nos informan de su dispersión. La razón de variabilidad es obtenida al dividir la media global de puntuaciones (en negrita) por la puntuación total de cada evaluador y puede ser utilizada para controlar esta variabilidad.

La finalidad de este trabajo es difundir el proceso de evaluación de comunicaciones que se ha llevado a cabo en el congreso de la SECA de 2011 explicitando las funciones que debe satisfacer y sus relaciones, a juicio de los autores. Como puede deducirse por el enunciado de su misión y alcance, se centra en parte de las actividades que desarrolla el comité científico: aquellas de naturaleza más técnica y que quizá más controversias pueden generar, en especial por el procedimiento de preselección y adjudicación de premios. Nuestra intención es que el diagramado IDEF0 construido sirva de ayuda para reconocer de forma explícita las funciones del proceso (qué debe hacerse durante la evaluación de comunicaciones). Son, junto al propio Manual de Congresos de SECA y los informes anteriores, puntos de partida útiles para mejorar (explicitando los procedimientos necesarios: cómo, cuándo y quién realiza estas funciones) y facilitar el trabajo de futuros comités.

Independientemente de que el diagramado propuesto pueda ser reinterpretado en mayor profundidad por un equipo más amplio y de mayor experiencia, consideramos que la función A1 «garantizar una evaluación justa y equitativa» es esencial para el diseño del proceso. En la figura 2 pueden apreciarse sus 2 salidas: el congresista satisfecho (una expectativa clara de asistentes y sobre todo de autores) y la razón de variabilidad. Esta última actúa como controlador de la función A2 «clasificar las comunicaciones».

Por razones de extensión se ha omitido la descripción de los diagramas IDEF0 de segundo y tercer nivel, así como los procedimientos seguidos para acometer las funciones representadas, con excepción de los referidos al control de la variabilidad interevaluador por su especial interés, si bien es cierto que los referidos a la adjudicación de premios una vez presentadas las comunicaciones y mejores experiencias en el Congreso (de los que disponemos) son también tradicionalmente objeto de debate por los comités. En el diagrama IDEF0 esta función (A4) no se desarrolla porque IDEF0 acota el número de subdivisiones posibles de cada actividad o función entre un mínimo de 3 (que no alcanza) y un máximo de 6. Esta dinámica obliga a un esfuerzo de síntesis en aras de una mejor comprensión y simplicidad.

La distribución leptocúrtica de la curva de variabilidad, más aglutinada en torno a la media de lo que lo haría una distribución normal, es fruto sin duda de las mejoras implementadas en congresos anteriores, que ya se han comentado en la introducción, y entre las que destacan la revisión por varios evaluadores (en nuestro caso, 2 o 3) y el empleo de la media de puntuaciones en la toma de decisiones1,5,7,9,10,12.

La asimetría negativa de la distribución nos indica que la mayor cantidad de puntuaciones otorgada se aglomeran en valores menores que la media. En nuestro caso se debe en gran parte a un evaluador, cuyas puntuaciones por criterio (que siguen un espectro de 10 puntos) nunca superaron los 5, el teórico «aprobado» (fig. 3, tabla 3). Es posible que, a pesar de todas las defensas del sistema, asumiera una puntuación máxima de 5 puntos en vez de 10 puntos por cada criterio, como se hizo en algún congreso anterior. Parafraseando a Reason16, esta situación corrobora que no hay queso sin agujeros y que, en nuestro caso, añadir a nuestro proceso de evaluación un ajuste sistemático de esta variabilidad es recomendable.

Pero además, el coeficiente de variación señala un 23% de dispersión de puntuaciones, una variabilidad entre evaluadores todavía demasiado alta para obviarla a la hora de elegir las comunicaciones candidatas a premio. La situación es más evidente si centramos nuestra atención en los casos extremos: nuestro estudio arroja un rango de 133 puntos entre evaluadores. Supone un promedio de 26,6 puntos de diferencia entre el evaluador que mayores y el que peores puntuaciones otorgó. Para un autor que envía su comunicación, significa que esta pueda ser valorada con un 66% de más o menos puntos en función del evaluador que le toque en suerte, algo totalmente inaceptable en una sociedad como la nuestra y que apoya la necesidad de ajuste no como algo recomendable, sino además imprescindible.

La razón de variabilidad es una herramienta de ajuste fácil de obtener y sencilla de aplicar que no supone un aumento de trabajo importante ni para los evaluadores ni para la secretaría del comité científico. Los evaluadores con razón de variabilidad superiores a la unidad tienden a infrapuntuar las comunicaciones que evalúan. Por ello, al multiplicar la puntuación bruta de cada comunicación evaluada por esta razón se obtienen puntuaciones ajustadas superiores a las iniciales. Lo contrario sucede para evaluadores con razones de variabilidad inferiores a la unidad. El resultado final es una puntuación ajustada que minimiza, junto al resto de medidas adoptadas hasta ahora, la variabilidad propia de cada evaluador. Representa un elemento necesario de ajuste que creemos válido para el resto del proceso de evaluación, tanto a la hora de dirimir las comunicaciones aceptadas y las rechazadas como para preseleccionar las candidatas a premio.

Ya que el propósito de este trabajo era comprobar la factibilidad del método, solo hemos utilizado 5 comunicaciones, remitidas a los evaluadores en su primer envío, como base para el cálculo de la razón de variabilidad que hemos trasladado a todas las comunicaciones presentadas al congreso. Por ello, además de proponer a los comités científicos de los próximos congresos la incorporación de esta metodología, para su aplicación en sucesivas ocasiones recomendamos: 1) aumentar el número de comunicaciones utilizadas a fin de mejorar la precisión de la medida sin menoscabo significativo de su eficiencia, y 2) distribuirlas entre todos los envíos de comunicaciones que se remitan a los evaluadores, en vez de ceñirse solo al primer envío. Los criterios y rango de puntuaciones que han de utilizar los evaluadores, así como los de selección de las comunicaciones sobre las que construir la razón de variabilidad (que en esta ocasión se han limitado a los puramente territoriales) representan otras oportunidades de mejora.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.