Presentar el nuevo instrumento de valoración de resúmenes que se aplica desde 2014 en los congresos de la SCCh, de forma tal de estandarizar su aplicación ítem por ítem.

Material y métodoEstudio bietápico con metodología cualitativa para generación de ítems y construcción de instrumentos de medición. En la primera etapa se realizó recopilación de ítems a partir de una revisión de la literatura. En la segunda se construyó el instrumento, aplicando reducción de ítems a través de un panel de expertos. Así, se generó la validación de contenido. El panel de expertos estuvo compuesto por 6 integrantes (3 epidemiólogos clínicos y 3 académicos, miembros de la SCCh), todos con grado de Magíster o Doctor y experiencia en investigación. Se aplicó estrategia cualitativa mediante técnica Delphi; luego se presentó el borrador a un panel de expertos distinto al anterior, oportunidad en la que se discutió la propuesta, se afinó la fraseología de los ítems y dominios y se definió el instrumento definitivo.

ResultadosLos ítems generados en la primera etapa (15), se agruparon en 5 dominios: introducción, material y método, resultados, conclusión, importancia, originalidad e interes del estudio; y presentación general. Al aplicar el cuestionario al segundo panel de expertos, se redujeron ítems y se adicionó otro. Así, se construyó el instrumento definitivo, compuesto por 10 ítems, agrupados en 6 dominios.

ConclusiónSe presenta una descripción pormenorizada de la escala y una guía para su aplicación, lo que permitirá conferir una adecuada confiabilidad de las mediciones.

The aim of this article is to present the new instrument for evaluating congress abstracts of SCCh, in use from 2014, so as to standardize its application item by item.

Material and methodTwo-stage study with qualitative methodology for generating items and construction of the measuring instrument. In the first stage a collection of items was based on a review of the literature. In the second, the instrument was built by applying reduction items through a panel of experts. Thus, content validity was determined. The expert panel consisted of 6 members. Three clinical epidemiologists and three members of the SCCh. All with Master's degree or PhD and research experience. Qualitative strategy is applied by Delphi technique; after the draft was presented to a panel of experts other than the above, at a meeting of ad-hoc working group, organized by the SCCh; at which time the proposal was discussed, the wording of items and domains was refined based on examples and the final instrument defined.

ResultsThe items generated in the first stage (n=15), who finished with the second draft; were grouped into 5 domains: introduction, material and method, results, conclusion, importance, originality and interest of the study; and overall presentation. When applying the questionnaire to the second panel of experts, a reduction items was generated and an item is added. Thus, the final instrument was composed of 10 items, grouped into 6 domains was constructed.

ConclusionA detailed description of the scale and guidelines for its implementation is presented, which will confer adequate reliability of the measurements.

Las mediciones son observaciones que describen fenómenos en términos que puedan ser analizados estadísticamente; por ende, son un componente esencial del quehacer clínico y de la investigación asociada.

Aunque las mediciones en un laboratorio pueden ser más o menos complejas por el equipamiento necesario para su ejecución, desde la perspectiva del proceso en sí una medición en estos escenarios siempre es más reproducible que en clínica, donde existen un sinnúmero de elementos que dan subjetividad al proceso y por ende posibilidad de error. Las mediciones deben ser válidas (exactas o seguras; es decir, libres de error sistemático) y confiables (precisas, consistentes o reproducibles; es decir, libres de error por azar), única forma de afirmar el valor final del (de los) resultado(s) de una investigación1.

Sabemos que los resultados de una investigación pueden ser presentados como ponencias en un congreso (ya sea en la modalidad de trabajo libre o póster), previo a lo cual han de pasar la correspondiente evaluación por parte del comité científico del congreso, para lo que suelen utilizarse instrumentos de valoración arbitrarios o adaptados a partir de otros2.

El propósito de un resumen es informar de forma precisa y concisa sobre lo que se pretende presentar en el congreso; por ende, y siguiendo la estructura del método científico, el resumen de una ponencia debe estructurarse en las siguientes secciones: introducción (debe contener el objetivo al final de esta); material y método; resultados, y conclusión (si corresponde).

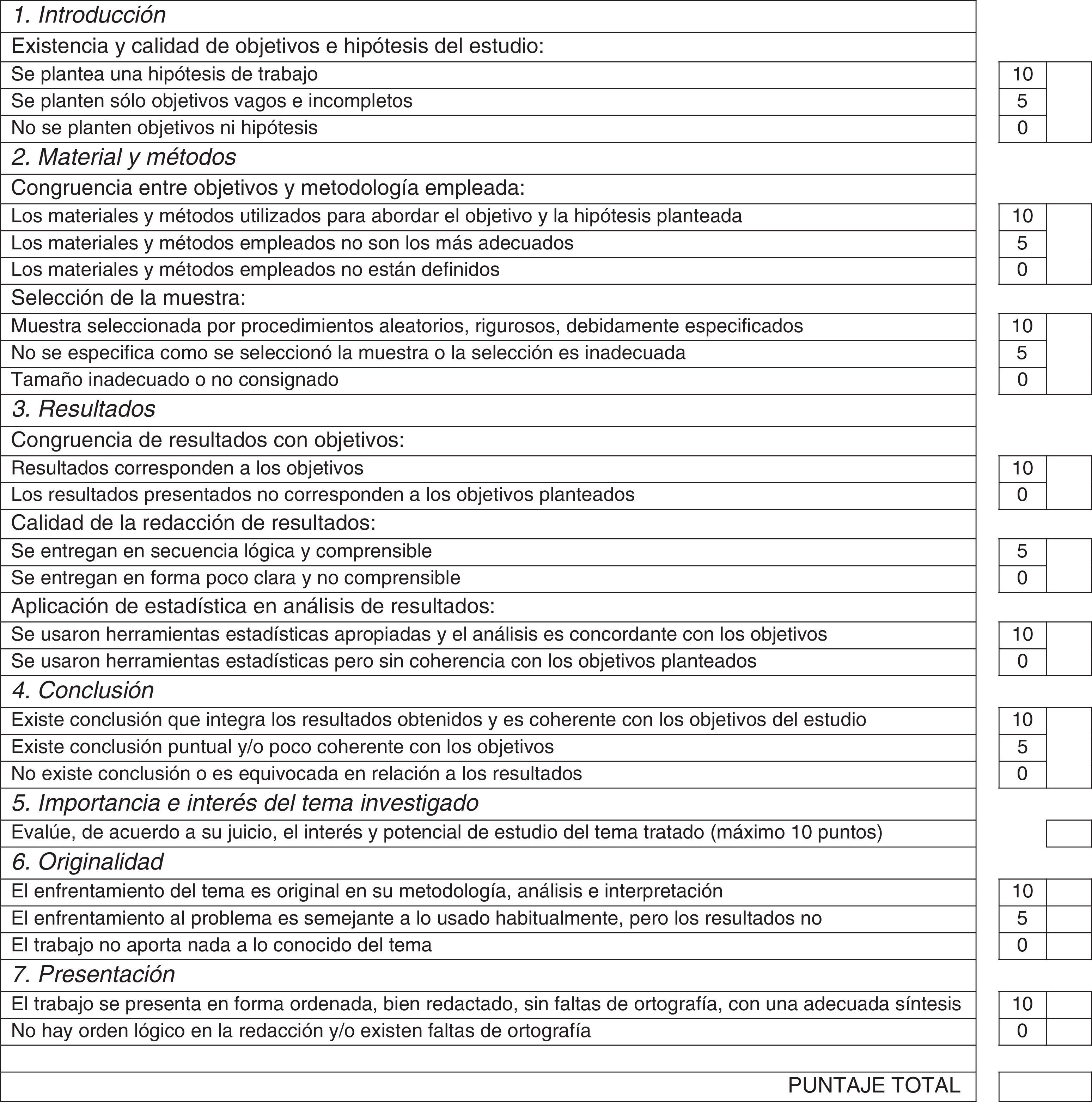

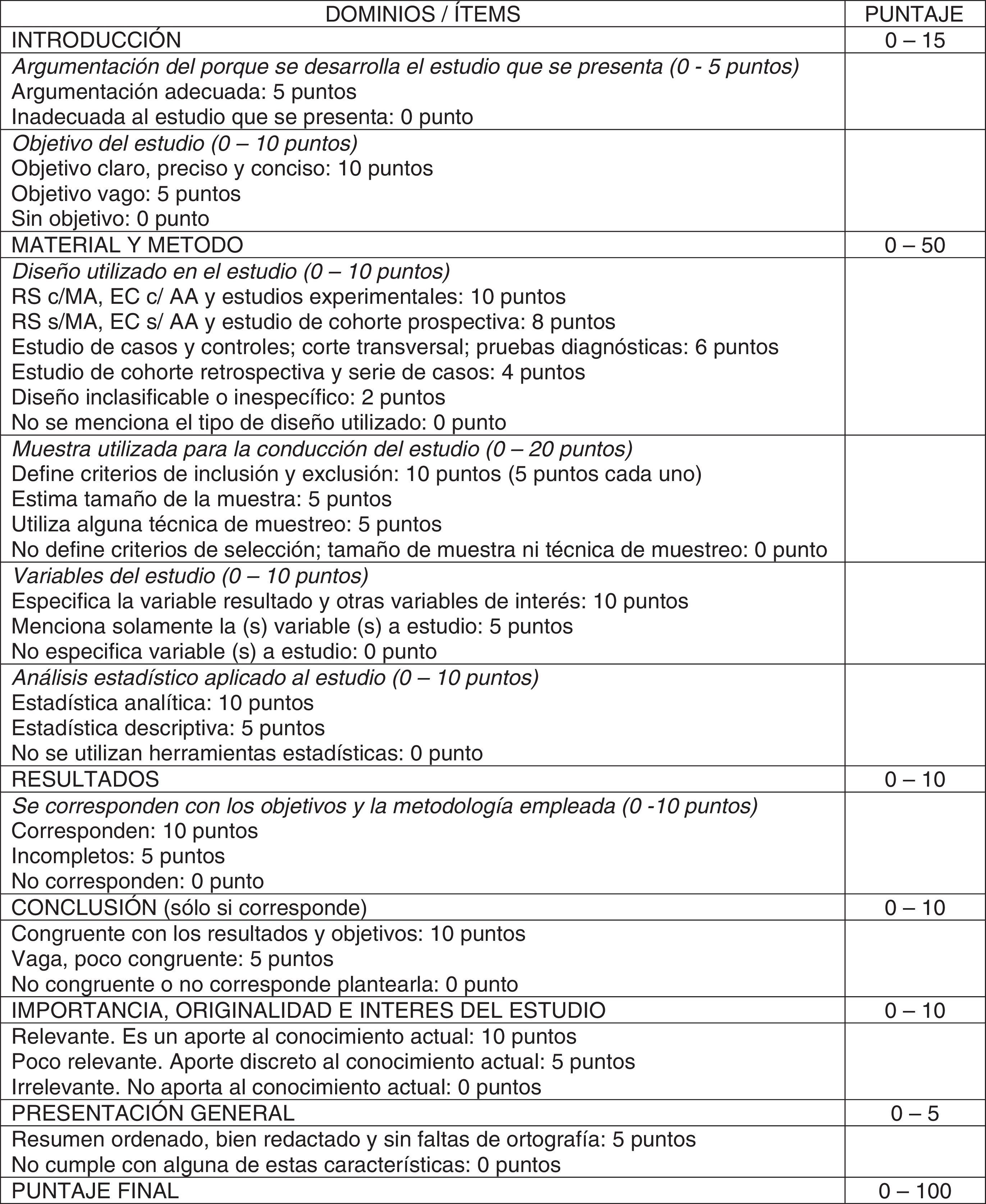

En 2000, el Comité Científico de la Sociedad de Cirujanos de Chile (SCCh) diseñó un instrumento de medición para aplicar a los resúmenes que se presentarían en los congresos societarios (tabla 1). Este fue el primer instrumento utilizado para evaluar y seleccionar de acuerdo a criterios metodológicos, permitiendo por ende una mejoría sustancial de la calidad de los resúmenes que se aceptaban; sin embargo, tenía algunas desventajas: consideraba algunos parámetros no discriminantes (p.ej., la existencia de hipótesis), utilizaba conceptos subjetivos, de difícil evaluación (p.ej., «los materiales y métodos empleados son adecuados») y sobrevaloraba ítems relacionados más con «la forma» que con el fondo (p.ej., la importancia, la originalidad y la presentación del resumen tenían igual puntaje que algunos ítems de la metodología y los resultados). Esto motivó la necesidad de diseñar y construir un nuevo instrumento, esta vez válido y confiable, decisión que adoptó el Comité Científico de la SCCh, proyecto que comenzó con el diseño de esta nueva herramienta en 2013 y su primera aplicación en 2014 (tabla 2).

Para ello se han organizado 2 seminarios de capacitación para la aplicación de este instrumento, que han permitido, entre otros objetivos, realizar pilotajes, afinar la fraseología de ítems y dominios, y avanzar en los procesos de validación del instrumento.

El objetivo de este artículo es presentar el instrumento de valoración de resúmenes que se aplica desde 2014 en los congresos de la SCCh, de forma tal de estandarizar su aplicación ítem por ítem.

MetodologíaDiseñoEstudio bietápico con metodología cualitativa para la generación de ítems y construcción del instrumento3-5. En la primera etapa se generaron los ítems y dominios, y en la segunda etapa se diseñó y construyó el instrumento.

CentroEl estudio fue realizado en el Departamento de Cirugía y CEMyQ de la Universidad de La Frontera, entre los meses de julio de 2013 y junio de 2014.

MetodologíaEn la primera etapa se diseñó una propuesta mediante la recopilación de ítems y dominios a partir de una extensa revisión de la literatura relacionada (primer borrador). En la segunda se construyó el instrumento, aplicando reducción de ítems y dominios a través de un panel de expertos, a quienes se consultó a través de un cuestionario semiestructurado y autoadministrado, compuesto por 25 ítems provenientes de la literatura. A estos ítems, los expertos podían agregar otros según su experiencia o particular visión de la situación (segundo borrador). De este modo se generó la validación de contenido, tanto de fachada como de muestreo, asegurando así que el instrumento contiene ítems representativos de todas las áreas que definen el concepto o constructo en estudio.

ParticipantesEl panel de expertos estuvo compuesto por 6 integrantes: 3 epidemiólogos clínicos y 3 académicos miembros de la SCCh, todos ellos con grado de Magíster o Doctor y experiencia en investigación. La mediana de edad de estos fue de 48años (35 a 60años). Cinco son de género masculino (83,3%) y todos se desempeñan en centros universitarios.

Plan de análisisSe aplicó estrategia cualitativa mediante técnica Delphi6-10. Tras realizar la revisión bibliográfica se verificó que no existe consenso plasmado en una pauta para la valoración de resúmenes de congresos, y se construyó el tercer borrador. Este último se presentó a un panel de expertos distinto al anterior, en una sesión de trabajo ad-hoc, organizada por la SCCh, en el mes junio de 2014. A esta asistieron 36 cirujanos, representantes de todos los diversos departamentos que componen la SCCh. En esta oportunidad se discutió la propuesta, se afinó la fraseología de ítems y dominios en base a ejemplos y se definió el instrumento definitivo.

ResultadosLos ítems generados en la primera etapa (n=15), que finalizó con el segundo borrador, se agruparon inicialmente en 6 dominios: introducción; material y método; resultados; conclusión; importancia, originalidad e interés del estudio; y presentación general.

Al aplicar el cuestionario al segundo panel de expertos, se generó una reducción de ítems y se adicionó un ítem a sugerencia del panel.

De este modo se construyó el instrumento definitivo, que quedó compuesto por 10 ítems (Argumentación del porqué se desarrolla el estudio que se presenta. Objetivo del estudio. Diseño utilizado en el estudio. Muestra utilizada para la conducción del estudio. Variables del estudio. Análisis estadístico aplicado al estudio. Resultados. Conclusión. Importancia, originalidad e interés del estudio. Presentación general), agrupados en 6 dominios: introducción; material y método; resultados; conclusión; importancia, originalidad e interés del estudio; y presentación general.

Se procedió a la socialización de los resultados, momento en el que los miembros del panel de expertos revisaron los ítems, los dominios y sus respectivos comentarios aclaratorios, llegando al instrumento final (tabla 2).

Finalmente, es menester señalar que este instrumento ha sido utilizado en 2 congresos consecutivos de la SCCh (Congresos números LXXXVII, realizado en Antofagasta, y LXXXVIII en Pucón) para valorar las respectivas contribuciones científicas a estos. Se aplica en modalidad on-line, a través del sitio Web http://www.cirujanosdechile.cl de la SCCh.

Explicación a los autores y revisoresA continuación se explicará la forma de utilización de cada ítem y dominio del instrumento en cuestión.

Dominio 1. IntroducciónTomar en consideración que es el comienzo de su resumen, por ende debe ser atractiva, de no más de un párrafo (3 a 5 líneas). Se debe redactar en tiempo presente y se ha de tomar en consideración que la pregunta a responder es: ¿Por qué se realizó? Debe incluir el objetivo del estudio2.

Ítem 1. Argumentación del porqué se desarrolla el estudio que se presenta. Es el argumento del estudio. Con base en el diccionario de la RAE, se entiende en una de sus acepciones como «sumario que, para dar breve noticia del asunto de la obra literaria o de cada una de las partes en que está dividida, suele ponerse al principio de ellas». Se trata entonces del asunto o materia de una obra. Si la argumentación es adecuada se asignan 5 puntos y si no parece adecuada, 0 puntos.

Ítem 2. Objetivo del estudio. Es un resumen de la meta global del estudio. Debe estar dirigido a los elementos básicos del problema que se está investigando. Debe ser claro, preciso, medible y congruente. Debe identificar la variable de interés y el grupo de estudio o población en que se estudiará2. Las opciones de respuesta son: objetivo claro, preciso y conciso (10 puntos); objetivo vago (5 puntos); sin objetivo (0 puntos).

Dominio 2. Material y métodoReflexionar que se redacta en tiempo pasado y que se ha de responder a la pregunta ¿Cómo se ha hecho?2.

Ítem 3. Diseño utilizado en el estudio. Consiste en identificar el diseño utilizado en la conducción del estudio que se evaluará. Este se puntúa en orden descendente según los niveles de evidencia11:

- •

RS. Revisión sistemática de la literatura. Puede ser con o sin metaanálisis (recordar que esta última es solo una herramienta estadística, NO el tipo de diseño). Con metaanálisis se asignan 10 puntos y sin metaanálisis se asignan 8 puntos.

- •

EC. Estudios de tipo experimental y carácter prospectivo. Se realizan en seres humanos. Comparan el efecto y el valor de una intervención contra otra o un control. Requieren asignación aleatoria (AA) y mediciones enmascaradas. También pueden encasillarse aquí los estudios cuasi experimentales (p.ej., estudios antes y después). Deben considerar cálculo de incidencias, riesgo relativo, número necesario a tratar, etc.12.

- •

Estudios experimentales. Se refieren a experimentación con material biológico (células, tejidos, animales de experimentación).

- •

A los EC con AA y mediciones enmascaradas; así como a los estudios experimentales, se les asignan 10 puntos. A los EC sin AA o que carezcan de mediciones enmascaradas se les asignan 8 puntos.

- •

Estudio de cohorte prospectiva (o concurrente). Estudios observacionales y analíticos. Consisten en el seguimiento a lo largo del tiempo de grupos de sujetos, esperando el desarrollo de un «evento de interés» en relación con un «factor de exposición». Su objetivo es determinar si el riesgo de desarrollar el «evento de interés» difiere entre un grupo de sujetos expuestos y otro de no expuestos a un determinado «factor de exposición». Deben considerar cálculo de incidencias, riesgo relativo, etc. (mediciones que NO pueden estar ausentes en su plan de análisis)12,13. También puede encasillarse aquí a los estudios de casos y controles anidados en una cohorte. Se les asignan 8 puntos.

- •

Estudio de casos y controles. Estudios observacionales y analíticos basados en la recopilación de datos ya generados. Se realiza un análisis comparativo de un grupo de sujetos que han desarrollado un evento (casos) con un grupo de individuos que no lo desarrollaron (controles). Su objetivo es determinar si la frecuencia del factor en estudio es diferente entre el grupo de casos vs. los controles. La estadística que los diferencia es el cálculo de los odds ratios (que NO puede estar ausente en su plan de análisis). Se les asignan 6 puntos.

- •

Estudio de corte transversal. Estudio observacional descriptivo que permite evaluar una exposición y enfermedad o evento de interés de forma simultánea. No existen períodos de seguimiento y todas las mediciones se hacen en una ocasión. La estadística que los identifica es el cálculo de prevalencia (que NO puede estar ausente en su plan de análisis)14. Se le asignan 6 puntos.

- •

Estudio de pruebas diagnósticas. Estudios observacionales y analíticos, que consisten en la comparación del comportamiento de 2 pruebas diagnósticas (el estándar de referencia y la que se considera en evaluación o en estudio) en 2 grupos de sujetos (con y sin el evento de interés que se intenta medir o diagnosticar). Deben considerar cálculos de sensibilidad, especificidad, valores predictivos e idealmente razones de probabilidad (mediciones que NO pueden estar ausentes en el plan de análisis)15,16. Se les asignan 6 puntos.

- •

Estudio de cohorte retrospectiva (o histórica). Estudios observacionales y analíticos, de carácter retrospectivo, en los que se comparan 2 grupos que se identifican en el presente y se siguen a partir del pasado al presente en búsqueda de diferencias respecto del riesgo de desarrollar un «evento de interés» entre el grupo de sujetos supuestamente expuestos y el otro supuestamente no expuesto a un determinado «factor de exposición». Deben considerar cálculo de incidencias, riesgo relativo, etc.12,13. Se les asignan 4 puntos.

- •

Serie de casos. Estudios observacionales descriptivos. Permiten describir un cuadro clínico, la descripción de enfermedades raras, formular hipótesis de posibles factores de riesgo, describir manifestaciones inusuales de una enfermedad o evento de interés y obtener frecuencias. Tienen subjetividad personal y no permiten hacer comparaciones. La estadística que los representa es la descriptiva (cálculo de porcentajes, promedios y desviación estándar, medianas, rangos, etc.)14. Se les asignan 4 puntos.

- •

Diseño inclasificable o inespecífico. Cuando el resumen no clarifica el diseño estudiado, o aparecen diseños inexistentes, o solo una mera descripción de alguna característica de algún tipo de diseño que impide definir a cuál corresponde (p.ej., estudio prospectivo, estudio longitudinal, o estudio prospectivo de corte transverso, etc.). Se les asignan 2 puntos.

- •

No menciona tipo de diseño utilizado. Cuando el resumen carece de diseño. No es posible identificar algún vestigio de lo realizado por los autores en esta materia. Se asignan 0 puntos.

Ítem 4. Muestra utilizada para la conducción del estudio. Una muestra será o no representativa si fue seleccionada al azar, es decir, todos los sujetos de la población blanco tienen la misma posibilidad de ser seleccionados en ella. Esto es lo que permitirá posteriormente extrapolar los resultados. Los criterios de inclusión son cualquier característica de los sujetos que componen la población en estudio, y los de exclusión, las características que pueden interferir con la calidad de los datos o la interpretación de los resultados. No son lo contrario (p.ej., se incluye mujeres y se excluyen hombres).

El tamaño de la muestra no siempre se podrá calcular. Es deseable que se calcule en algunos diseños como EC, estudios de cohortes, estudios de casos y controles, y estudios de pruebas diagnósticas.

Las técnicas de muestreo pueden ser probabilísticas (muestreo aleatorio simple, estratificado, por conglomerados y sistemático) y no probabilísticas (consecutivo, por conveniencia e intencional)17.

La asignación de puntaje para este ítem es de la siguiente forma: si definen criterios de inclusión y exclusión se asignan 10 puntos (por uno solo de los 2, corresponden 5 puntos), si se estima el tamaño de la muestra se asignan 5 puntos, si se aplica alguna técnica de muestreo se asignan 5 puntos, y si no se definen criterios de inclusión o exclusión, así como de no existir estimación del tamaño de la muestra y técnicas de muestreo, se asignan 0 puntos.

Ítem 5. Variables del estudio. Se define como variables cualquier cualidad o característica, constituyente de un sujeto, que es posible medir y que es susceptible de cambio. La variable resultado se denomina también variable dependiente o de desenlace.

Otras variables de interés pueden ser: la variable independiente, de exposición o predictiva, y las denominadas variables asociadas o de control, que son aquellas que, no siendo relevantes al estudio, están presentes y pueden influir en los resultados.

Las variables pueden ser cualitativas (dicotómicas, nominales y ordinales) y cuantitativas (continuas y discretas). Según como sea la variable resultado será la estadística que se aplique posteriormente17.

Las opciones de respuesta para este ítem son las siguientes: especifica la variable resultado y otras variables de interés (10 puntos), solo menciona las variables en estudio (5 puntos), y no especifica cuáles son las variables en estudio (0 puntos).

Ítem 6. Análisis estadístico aplicado al estudio.

Estadística descriptiva: Cálculo de porcentajes, promedios con su desviación estándar, medianas y sus valores extremos, moda, rango, intervalos de confianza, etc.

- •

Estadística analítica. Dependerá del tipo de variables. Comparación de promedios con t de Student o T-test; variables categóricas o cualitativas con χ2 de Pearson o exacto de Fisher, etc. Si se usan medianas, tendrán que utilizarse métodos no paramétricos.

- •

Puede ser necesario el uso de estadísticas más complejas, como modelos de regresión simple, logística u ordinal, lo que dependerá del tipo de diseño y variable resultado. Por ejemplo, los modelos de regresión se utilizan para controlar variables que puedan actuar como confundentes, lo que se puede requerir en estudios de casos y controles, así como también en estudios de cohortes.

- •

Cálculo de la magnitud de la asociación. Es opcional. Sin embargo, en el caso de EC y estudios de cohortes debe utilizarse cálculo de incidencia y riesgos. En estudios de casos y controles se debe describir el uso de odds ratios12.

- •

En el caso de reportes de casos, en general no se utilizan estadísticas.

Para la asignación de puntaje de este ítem hay 3 opciones de respuesta: utilización de estadística analítica (10 puntos), utilización de estadística descriptiva (5 puntos), y no utiliza herramientas estadísticas (0 puntos).

Dominio 3. ResultadosÍtem 7. Resultados. Lo que se debe aclarar aquí es ¿Qué se encontró? Se deben presentar solo las cifras relevantes al objetivo de la investigación y que puedan ser la base de la conclusión. Se recomienda seguir el orden descrito en el material y método, comenzando por la descripción general de la muestra2. Para la asignación de puntaje de este dominio hay 3 opciones de respuesta: los resultados corresponden al objetivo y metodología empleada (10 puntos), los resultados son incompletos (5 puntos), y los resultados no corresponden al objetivo y metodología empleada (0 puntos).

Dominio 4. Conclusión (solo si corresponde)Ítem 7. Conclusión. En este dominio monoitémico se trata de establecer un nexo entre el objetivo y los resultados observados (por ende debe existir congruencia con estos). Se redacta en tiempo presente. La pregunta a contestar es: ¿Qué importancia tienen los hallazgos?

No se deben repetir los resultados, y no corresponde escribir una discusión2. Para la asignación de puntaje de este dominio hay 3 opciones de respuesta: la conclusión (cuando corresponde) es congruente con los resultados y objetivo planteado (10 puntos), la conclusión es vaga o poco congruente con los resultados y objetivo planteado (5 puntos), y la conclusión es incongruente o no corresponde plantearla (0 puntos).

Dominio 5. Importancia, originalidad e interés del estudioÍtem 9. Importancia, originalidad e interés del estudio. En este dominio monoitémico se trata de determinar si acaso el resumen en evaluación es relevante y por ende constituye un aporte al conocimiento actual en la disciplina (se asignan 10 puntos); es poco relevante y por ello representa un aporte discreto al conocimiento actual (se asignan 5 puntos), o simplemente es irrelevante y no representa un aporte al conocimiento (se asignan 0 puntos).

Dominio 6. Presentación generalÍtem 10. Presentación general. En este dominio monoitémico se debe evaluar si es que el resumen en evaluación está ordenado, bien redactado y sin faltas de ortografía (se asignan 5 puntos) o, por el contrario, no cumple con alguna de las características antes señaladas (se asignan 0 puntos).

Finalmente, se deben tomar en cuenta las siguientes consideraciones: los resúmenes no estructurados no serán considerados, debido a que es imposible que puedan ser evaluados aplicando este instrumento.

El puntaje máximo posible es de 100 puntos, y se ha establecido que el punto de corte de aceptación es de un mínimo de 50 puntos.

DiscusiónRespecto de la metodología utilizada, vale la pena señalar algunos hechos relevantes. En primer término, se definió como expertos a sujetos que pueden realizar contribuciones válidas, es decir, que poseen conocimientos basados en la práctica y experiencia actualizadas en este tipo de materias6,7, optándose por un grupo heterogéneo, lo que resulta fundamental ya que permite diversidad de puntos de vista8. Y en segundo término, la metodología utilizada: en este caso una técnica de consenso, que permite obtener estimadores cuantitativos mediante el grado de acuerdo existente entre los participantes3. Esta estrategia, denominada técnica Delphi4, es un medio efectivo para construir consenso en un grupo sin que los integrantes se reúnan físicamente. Se realiza a distancia contactando a los participantes a través de cuestionarios (que en este caso fueron vía electrónica). Las ventajas de esta técnica son: que el anonimato de los aportes e ideas garantiza que cada una de ellas tenga el mismo valor e igual importancia en el análisis posterior5-8; que se elimina la influencia que podría ejercer sobre los demás el experto más persuasivo o de renombre; que la iteración entre los participantes es con retroalimentación controlada y dirigida por un coordinador de modo que gradualmente la información irrelevante es eliminada (no existe intercambio de información entre los componentes del panel); por último, existe mayor franqueza en la expresión de ideas de cada uno de los expertos9.

Todos los congresos reciben un gran número de resúmenes, que habitualmente superan la disponibilidad para su presentación y defensa. Es por ello que hay una necesidad de que estos pasen por un proceso de selección más o menos riguroso realizado por pares, quienes han de velar porque, aparte de un valor científico aceptable y una calidad metodológica (CM) adecuada, los resúmenes cuenten con una estructura correcta, acorde a las normas del congreso18,19. Entonces cabe preguntarse: ¿por qué se rechazan resúmenes?, lo que puede contestarse tomando en consideración los siguientes ítems: buena parte de ellos no aportan información relevante o su CM es defectuosa; sin embargo, una proporción no despreciable se rechaza por falta de claridad en los objetivos, incoherencias en la secuencia «objetivo, metodología, resultados, conclusión»; por desorden, etc.4,20-22.

Es por ello que, antes de comenzar a escribir el resumen, los autores deberían reflexionar de forma autocrítica respecto de la real trascendencia de lo que se quiere presentar, intentando dar respuesta a las preguntas clásicas: ¿tiene razón de ser la presentación de los datos disponibles?, ¿se dispone de pruebas sólidas y respuestas claras en relación con el objetivo planteado?, ¿es la conclusión relevante?23. Si a pesar de lo anteriormente planteado se piensa que vale la pena reportar esta contribución, es fundamental obtener el formato del congreso, circunscribirse al espacio que corresponde y generar un mensaje claro y concreto2,23,24, en especial si existe una pauta de evaluación de resúmenes con la que se valorará la aplicación del método científico: introducción y objetivo, metodología, resultados y conclusión, es decir, si existe respuesta a las preguntas: ¿qué problema se estudió y por qué?, ¿cómo se estudió?, ¿cuáles fueron los hallazgos?, y ¿qué significan esos resultados?

Se han estudiado predictores de buena CM de un resumen de congreso. Por ejemplo, la Asociación Italiana de Salud Pública estudió la CM de los resúmenes de su congreso en el período 2005-2010 a través de 8 dominios: coherencia, estructura, originalidad, objetivos, diseño, fuentes, resultados y conclusiones (puntuación de 0 a 3, con un máximo de 24 puntos). De los 4.399 resúmenes estudiados (1.172 comunicaciones orales y 3.227 pósters), identificaron como predictores de mala CM el área geográfica y filiación de donde provenían estos (ciudades periféricas y centros no universitarios). Al mismo tiempo, determinaron que eran predictores de buena CM los que tenían objetivos, resultados y conclusiones bien escritos25. Sin embargo, existe muy poca información referente a estas materias que son cruciales en el desarrollo de la ciencia, pues la presentación de resultados en congresos constituye una de las principales formas de comunicación científica, lo que hace indispensable continuar con políticas de educación continua para los cirujanos de Chile, en especial para los miembros de la SCCh.

Otro punto que merece ser discutido es el rol de los pósters, instrumento de comunicación de resultados, que en nuestro medio suele ser visto de forma casi discriminatoria en relación con las comunicaciones orales. Al respecto, es interesante señalar que existe evidencia que sugiere que los pósters pueden ser de mejor CM que las comunicaciones orales. Por ejemplo, en el congreso Asociación Americana de Trauma de 2009, al comparar 67 presentaciones orales vs 120 pósters se objetivó que estos últimos habían tenido mayor puntaje de selección que los seleccionados para presentaciones orales26.

A modo de conclusión, se puede mencionar que se diseñó y construyó una herramienta que permite valorar los resúmenes de congresos, y que el instrumento generado pretende ser una ayuda no solo a los investigadores que deciden reportar sus resultados a través de este formato, sino también a los revisores, al comité científico de la SCCh, así como también al comité organizativo del congreso y a la Directiva de la SCCh.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.

Agradecer a la Directiva de la SCCh, encabezada en su oportunidad por el Dr. Mario Uribe, que incentivó y apoyó esta iniciativa, y a los Dres. Francisco López, Rimsky Álvarez y Marcelo Beltrán, miembros del Comité Científico de la SCCh de la época, por los comentarios y opiniones que permitieron delinear el primer borrador de la escala de evaluación de resúmenes que hoy se presenta en este manuscrito. Finalmente, al Dr. Claudio Heine, con quien se ha trabajado la valoración de resúmenes a través de la plataforma electrónica de nuestra sociedad.