El presente trabajo de investigación tiene como objetivo analizar la influencia que tiene sobre el rendimiento académico la información recibida por los estudiantes respecto al proceso de evaluación acumulativo por actividades realizadas durante los seminarios activos. Para ello se ha realizado un experimento con 3 condiciones intrasujeto en las que se controla la información disponible para 377 estudiantes. Los resultados obtenidos indican que, cuando se facilita información a los estudiantes sobre el proceso de evaluación, estos realizan un mayor esfuerzo en las actividades de los seminarios activos. También se han encontrado resultados significativos en el impacto que tiene, en las calificaciones finales de los estudiantes, la elección por parte de estos del peso porcentual de los seminarios activos en la evaluación final.

The present research shows how the information provided to students about the evaluation process influences their academic performance. We ran an experiment with 3 intrasubject conditions in which different information was available by 377 students. Results show that providing information to students implies that they make a greater effort in the active seminars. Finally, we found interesting results regarding the students¿ preferences about the seminars final grading.

Los cambios que se han venido produciendo en los últimos años con la adaptación del Espacio Europeo de Educación Superior han implicado también reformas tanto en la metodología docente como en el sistema de aprendizaje de los estudiantes. La incorporación de diferentes seminarios activos en la metodología docente tiene como objetivo el desarrollo de nuevas competencias por parte de los estudiantes. El desarrollo de estas competencias implica que el sistema de aprendizaje se ha modificado y los resultados obtenidos por los estudiantes mejoran, dado que existe una mayor retención de los conocimientos a largo plazo (Lord y Robertson, 2006; Tovia y Liu, 2007).

Evidentemente, si se producen cambios en la metodología docente y los contenidos se reajustan, el sistema de evaluación no se puede limitar a un examen. El nuevo modelo de enseñanza-aprendizaje impone que estén alineados con las competencias tanto los métodos como los sistemas de evaluación (Rodríguez-Izquierdo, 2014). Esto es debido a que, por una parte, el sistema de evaluación está directamente relacionado con la metodología docente y con el sistema de aprendizaje y, por otra, a que los conocimientos adquiridos se vinculan directamente con el sistema de evaluación (Villardón y Yániz, 2004).

Trabajos recientes han evidenciado la existencia de ciertas ineficiencias en el sistema de evaluación acumulativa por actividades que se está aplicando desde la implantación del Espacio Europeo de Educación Superior. Pascual-Ezama, Camacho-Miñano, Urquia Grande y Müller (2011) encontraron que aquellos estudiantes con mejores resultados en el examen final y, por tanto, con mayores conocimientos de la materia, obtenían sistemáticamente una calificación final en la asignatura más baja que la obtenida en el examen. Por el contrario, aquellos estudiantes con peores resultados en el examen obtenían mejor calificación final en la asignatura. Esto fue interpretado por los autores en términos de beneficio/perjuicio debido al sistema de evaluación acumulativa por actividades y al desconocimiento de los estudiantes respecto a dicho sistema.

El objetivo de este trabajo es analizar si la información disponible para los estudiantes respecto a la forma en la que se les evalúa tiene un impacto en el esfuerzo que estos realizan y, por lo tanto, si sus resultados académicos mejoran. Para ello se ha realizado un experimento con 3 condiciones intrasujeto en las que se ha controlado la información disponible para 377 estudiantes. Los resultados obtenidos indican que, cuando se facilita información a los estudiantes sobre el proceso de evaluación, estos realizan un mayor esfuerzo en las actividades propuestas en los seminarios activos. También se han conseguido resultados significativos respecto al impacto que tiene, en las calificaciones finales de los estudiantes, la elección por parte de estos del peso porcentual de los seminarios activos en la evaluación final.

El artículo se estructura de la siguiente forma: en el segundo apartado se desarrolla el marco teórico y se plantean al final las hipótesis del estudio; en el tercer apartado se describe la metodología utilizada; en el apartado cuarto se muestran los resultados encontrados y su implicación y, finalmente, en el último apartado se ofrecen las conclusiones generales que se desprenden del trabajo.

Marco teóricoExisten numerosos trabajos que han demostrado la importancia del sistema de evaluación tanto en el aprendizaje de los estudiantes como en sus resultados académicos finales (Gibbs y Simpson, 2004; Garside, Nhemachena, Williams y Topping, 2009; Fletcher, Meyer, Anderson, Johnston y Rees, 2012; Cano, Chamizo y Valiente, 2014). El sistema de evaluación ha ido evolucionado desde el sistema del examen final exclusivo, propio de la metodología docente tradicional, hasta el sistema de evaluación acumulativa por actividades (Pascual-Ezama et al., 2011) propio de la metodología docente activa.

En varios de estos trabajos se analiza el motivo por el que los resultados obtenidos por los estudiantes en el examen final son inferiores a los obtenidos en las actividades realizadas a lo largo de la asignatura (Dalziel, 1998; Bridges et al., 2002; Simonite, 2003; Gibbs y Simpson, 2004; Tian, 2007). Algunos de ellos concluyen que se debe a las características particulares de las materias que se evalúan (Bridges et al., 2002; Murdan, 2005) y a que las diferencias son mayores cuando las actividades que se desarrollan a lo largo del curso son de carácter cuantitativo y menores las diferencias cuando las actividades son de carácter cualitativo.

Ciertos trabajos infieren que, en términos generales, el sistema de evaluación consistente en un único examen final tiene un impacto limitado o incluso negativo en el aprendizaje global de los estudiantes (Muldoon, 2012); otros estudios como el de Gibbs y Simpson (2004), consideran que la aplicación de diferentes tipos de evaluación incrementa el aprendizaje de los estudiantes; según un estudio realizado por Vallès et al. (2014) sobre preferencias de evaluación, estudiantes de diferentes grados valoraban muy bien la evaluación acumulativa por actividades.

Otros trabajos como el de Pascual-Ezama et al. (2011) van más allá y observan que aquellos estudiantes con mayor nota en el examen final obtienen una nota media final inferior, motivado por el sumatorio con el resto de las notas de los seminarios activos. Sin embargo, a los que obtenían peor calificación en el examen les sucedía lo contrario. En concreto, los estudiantes con una calificación superior al 70% en el examen final veían reducida la nota en la asignatura a la hora de aplicar el sistema de evaluación acumulativa por actividades, mientras que aquellos estudiantes con puntuaciones inferiores al 70% en el examen final, por el contrario, se veían «beneficiados» en su calificación final. Estos resultados se encontraron en aquellos casos en los que la valoración final de la asignatura se calculaba como una proporción entre el examen final y el resto de las tareas. Por el contrario, otros autores como Jareño y López (2015) consideran que todos los alumnos se ven beneficiados con el nuevo sistema de evaluación, independientemente de la nota obtenida en el examen.

Sin embargo, en ninguno de estos trabajos se analiza qué porcentaje deberían tener el examen y el resto de las actividades evaluadas. Es muy importante establecer estos parámetros de forma adecuada, ya que dicha elección podría modificar el comportamiento de los estudiantes respecto a la asignatura y, por lo tanto, podrían verse modificados sus resultados finales (Smith, 2011). También existen evidencias empíricas que concluyen que cuando los estudiantes conocen perfectamente las características del sistema de evaluación obtienen mejores resultados que cuando no disponen de toda la información (Payne y Brown, 2011). Además, en términos generales, se ha comprobado que los estudiantes prefieren la evaluación acumulativa por actividades respecto a la realización de un único examen al final del curso (Furnham, Batey y Martin, 2011). A partir de esto, podemos plantear nuestra primera hipótesis:Hipótesis 1 Los resultados obtenidos por los estudiantes se ven modificados en caso de que dispongan de información, en la literatura previa existente, sobre las diferencias encontradas entre las calificaciones en el examen final y los seminarios activos.

Con relación a la información ofrecida a los estudiantes sobre el sistema de evaluación, es necesario considerar relevante el peso que cada parte tendrá en la evaluación final. Dicho peso no está establecido de forma unánime, sino que cada asignatura, en la aplicación VERIFICA presentada en la ANECA, marca sus criterios y la horquilla sobre la que podría variar el peso del examen y el del resto de las actividades. Estas horquillas estarán condicionadas por el tipo de actividades que se desarrollen, por la carga de trabajo que suponga cada una en términos de recursos y por el coste temporal.

Un aspecto fundamental en el que se está trabajando es en encontrar un sistema homogéneo real (e.g. Yorke, 2010, 2011) ya que el sistema de evaluación utilizado condicionará la forma en la que los estudiantes asimilan los contenidos y afectará tanto a su proceso de aprendizaje (Murphy, 2006) como a la calidad de los conocimientos adquiridos (Fletcher et al., 2012).

En el trabajo de Pascual-Ezama et al. (2011), se han encontrado evidencias de que el sistema de evaluación acumulativa por actividades no afecta a todos los estudiantes por igual: algunos son más proclives a obtener unos buenos resultados en el examen final, mientras que otros lo hacen en los seminarios activos. Esto implica que a unos estudiantes les vendría mejor que el porcentaje o peso que representase el examen final en la calificación de la asignatura fuera mayor, mientras que a otros les favorecería más lo contrario. Por lo tanto, esto nos lleva a plantear nuestra segunda hipótesis:Hipótesis 2 Los resultados académicos de los estudiantes mejorarían si se les permite elegir el peso asignable al examen final y a los seminarios activos en la calificación final de la asignatura.

Finalmente, una de las principales preocupaciones de los estudiantes es el hecho de ser evaluados en un único momento mediante una sola prueba, con todos los problemas que eso puede suponer (enfermar el día del examen, tener un mal día, que el examen tenga una dificultad excesiva, etc.), y que iría en detrimento del trabajo realizado. Este problema se ha tratado de solventar con los exámenes parciales, eliminatorios o no, que evaluaban los conocimientos que los estudiantes iban adquiriendo en momentos intermedios del curso académico. Con el Espacio Europeo de Educación Superior algunas asignaturas han mantenido los exámenes parciales dentro del sistema de evaluación acumulativo por actividades. De hecho, el estudio realizado por San Martín, Jiménez y Jerónimo, 2016 con alumnado preuniversitario en el momento que llegan a la universidad, revela que entre las formas de evaluación preferidas por los estudiantes españoles destacan los exámenes parciales a lo largo del curso, con más de un 70% de valoración, mientras que como una de las menos valoradas aparece, con un 8%, la realización de un único examen al final del curso. Estos exámenes parciales podrían reducir el tiempo dedicado a los seminarios activos pero, por otra parte, podrían disminuir las diferencias entre las calificaciones de los exámenes y los seminarios activos que se han venido encontrando en la literatura (e.g. Gibbs y Simpson, 2004; Tian, 2007). Por todo ello nos surge, en relación con esto, una última hipótesis:Hipótesis 3 Realizar exámenes parciales disminuye, en la evaluación acumulativa por actividades, las diferencias encontradas entre los resultados obtenidos en los exámenes y los obtenidos en los seminarios activos.

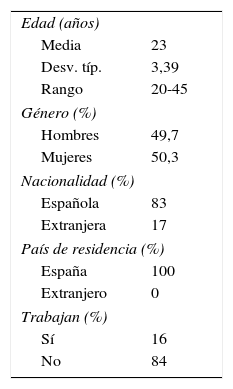

Los participantes fueron 377 estudiantes de la asignatura de Contabilidad Financiera (49,7% hombres y 50,3% mujeres; con una edad media de 23 años DT: 3,39) y un rango de 20-45 repartidos en 6 grupos o clases. Todos ellos la cursaron de forma obligatoria en el primer curso de su grado. Esta asignatura contiene fundamentalmente una introducción a la contabilidad financiera y conceptos básicos de empresa. Los estudiantes pertenecen al grado de Ingeniería Informática y el examen es de cátedra. El 16% de los estudiantes trabajan, bien por cuenta ajena o bien por cuenta propia, mientras que el 84% restante no lo hacen mientras estudian. La distribución de los estudiantes en cada uno de los grupos se realizó de forma aleatorizada, si bien se realizó una prueba de capacidad para comprobar que no había diferencias entre los diferentes grupos (tabla 1).

MaterialesSe utilizó un cuestionario (Anexo 1) en el que se recogieron datos de caracterización, como la edad, género, nota de acceso a la universidad, si los estudiantes trabajaban, y algunas otras preguntas de carácter general. Además, se recogieron las preferencias con relación al porcentaje de nota que los estudiantes consideraban adecuado respecto al examen final y a los seminarios activos. Este cuestionario se llevó a cabo tanto al comienzo como al final de la asignatura.

ProcedimientoLos estudiantes fueron divididos de acuerdo a 3 condiciones diferentes. En la primera, a los estudiantes se les explicó en qué consistiría la asignatura, cómo se desarrollarían los seminarios activos y cómo se evaluarían las competencias adquiridas en ellos. En la segunda condición, además de lo anterior, a los estudiantes se les mostraron los resultados que se habían encontrado previamente en la literatura respecto a la evaluación acumulativa por actividades y a las diferencias encontradas entre los resultados de los exámenes finales y de los seminarios activos. La tercera condición fue exactamente igual que la segunda, con el añadido de que los estudiantes, además de ser evaluados mediante los seminarios activos y el examen final, también tendrían exámenes parciales.

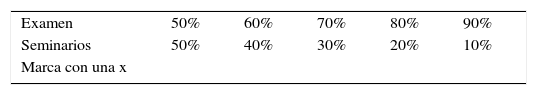

Una vez que los estudiantes distribuidos de acuerdo a las 3 condiciones supieron en qué consistirían sus responsabilidades y sus tareas, se les preguntó, en el cuestionario inicial, acerca de sus preferencias con relación al porcentaje de calificación final que ellos consideraban adecuado respecto al examen final y a los seminarios activos. Se les notificó que era meramente informativo para los profesores, de cara a valorar futuras modificaciones, dado que el porcentaje ya estaba establecido en un 70% el examen y un 30% los seminarios activos, tal y como figuraba en el programa de la asignatura. Se les ofreció 5 alternativas, que eran las opciones posibles según la aplicación VERIFICA aceptada por la ANECA respecto a la asignatura. Estas opciones comprendían porcentajes de examen entre el 50% y el 90% y, complementariamente, los seminarios activos se valorarían entre el 50% y el 10%. Al finalizar la asignatura, se volvió a recoger dicha preferencia tras haber realizado las tareas que componían los seminarios activos y antes de conocer su calificación final. Con esta segunda medición quisimos comparar si existían variaciones en las preferencias de los estudiantes con respecto al comienzo de curso. Todos los estudiantes completaron el cuestionario.

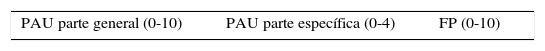

Medidas de rendimiento pre- y post-Prueba de Acceso a la Universidad (PAU). Dado que los resultados previos son la mejor medida para analizar los resultados actuales (García, Alvarado y Jimenez, 2000; House, Hurst y Keely, 1996; Wilson y Hardgrave, 1995), se tomaron los resultados obtenidos por los estudiantes en la PAU. Es un examen en el que se miden los conocimientos que los estudiantes tienen sobre las materias que han cursado en la educación preuniversitaria y el resultado es utilizado como prueba de acceso a la universidad. Como esta prueba es aceptada como una medida de capacidad (Gil-Gómez de Liaño, León y Pascual-Ezama, 2012; García et al., 2000; House et al., 1996; Wilson y Hardgrave, 1995), nos sirve para observar si sus preferencias respecto a los porcentajes de evaluación tienen que ver con dicha capacidad. Por lo tanto, previamente a la realización del estudio, se comprobó que no existiesen diferencias entre los distintos grupos respecto a este concepto, utilizando una diferencia de medias.

Seminarios activos. Los seminarios activos suponían el 30% de la nota final de la asignatura y consistían, por una parte, en la elaboración de 2 informes acerca de la utilización de herramientas necesarias para el análisis de la información contable y financiera de la empresa y, por otra parte, en una exposición oral en grupos de 3 o 4 estudiantes en la que tenían que presentar una empresa española que cotizara en bolsa, mostrar sus fortalezas y debilidades, analizar sus cuentas y decidir si consideraban que era una buena empresa para invertir o no.

Exámenes. Los exámenes consistieron en una parte teórica sobre conceptos básicos referidos al lenguaje contable y financiero y, una parte práctica, en la que los estudiantes tenían que desarrollar el lenguaje contable e interpretar ciertos conceptos básicos referidos a la empresa. Todos los estudiantes realizaron el mismo examen final, al ser este de cátedra, en el mismo día y a la misma hora. Aquellos que realizaron los exámenes parciales también cumplieron con este mismo requisito. Evidentemente, no se puede evaluar de forma diferente a los alumnos, por lo que, el estudio del efecto que produciría la existencia de exámenes parciales se realizó durante 2 cursos consecutivos.

Análisis de resultadosDiferencias en la muestraComo ya se ha comentado, los estudiantes fueron matriculados en cada una de las 6 clases de forma aleatorizada por parte de la secretaría de alumnos de la facultad. No obstante, como podría haber alguna preferencia entre los estudiantes a la hora de realizar la matrícula que implicase un sesgo y para asegurarnos de que no había diferencias entre los estudiantes distribuidos según las 3 condiciones en los que dividimos las 6 clases para hacer el estudio, utilizamos un análisis de ANOVA respecto a la nota de acceso a la universidad (PAU). No se encontraron diferencias estadísticamente significativas para el promedio de las notas de la PAU obtenidas por los estudiantes de las 6 clases (F=1,470; p=0,202)1, ni para los estudiantes de cada una de las 3 condiciones (F=2,298; p=0,103). Esto implica que los estudiantes de las 3 condiciones no presentan diferencias en la variable más utilizada para medir el rendimiento académico (Gil-Gómez de Liaño et al., 2012; García et al., 2000; House et al., 1996; Wilson y Hardgrave, 1995). Tampoco se encuentran diferencias entre las clases que fueron impartidas por los distintos profesores (Z=−0,25; p=0,980).

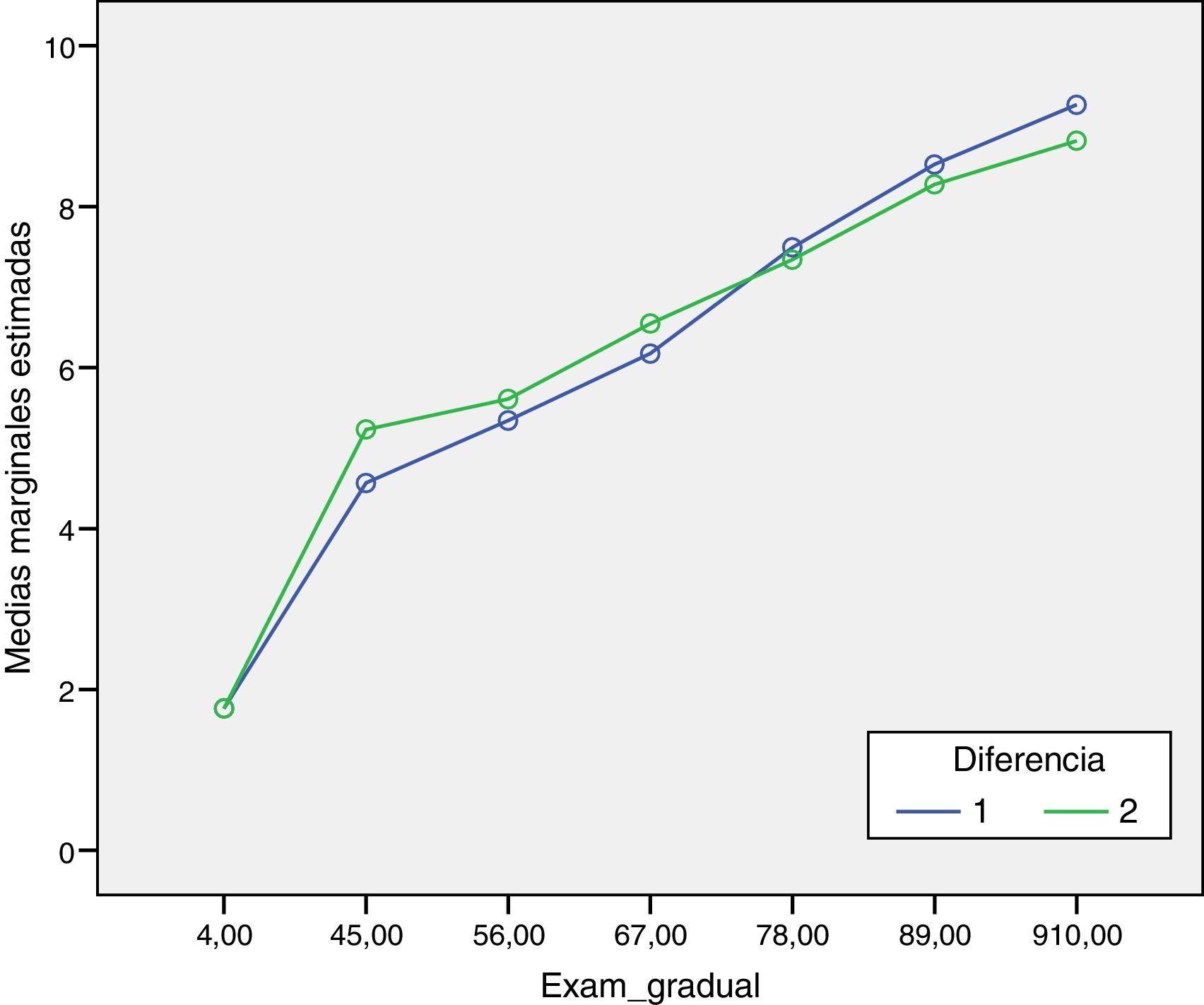

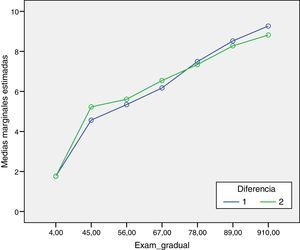

Relación examen final–calificación final según el grupo y las condiciones previasEn los grupos a los que se les asignó la primera de las condiciones (a los estudiantes se les explicó en qué consistiría la asignatura y en qué consistirían los seminarios activos en los que se valorarían las competencias adquiridas), se obtienen resultados similares a los encontrados por Pascual-Ezama et al. (2011) en los que aquellos estudiantes con peores resultados en el examen final tienden a obtener una calificación final superior a la nota del examen, mientras que los estudiantes con mejores resultados en el examen final tienden a obtener una calificación final inferior al propio examen (fig. 1). Más concretamente, se ven «beneficiados» aquellos estudiantes con notas inferiores a 6 (F=4,07; p<0,047), mientras que sucede lo contrario con aquellos con notas superiores a 9 (F=3,44; p<0,06).

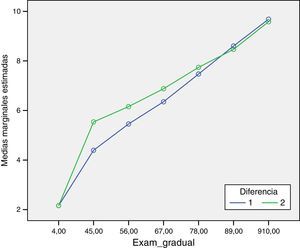

Sin embargo, cuando se analizan los resultados obtenidos en los grupos a los que se les asignó la segunda condición (se explicaba a los estudiantes los resultados encontrados sobre las diferencias entre las calificaciones en los exámenes finales y los seminarios activos), se encuentran diferencias respecto a la primera (fig. 2). El hecho de que los estudiantes supieran que la calificación final podía ser superior a los resultados obtenidos en el examen con notas bajas e inferior con notas altas, supuso que los estudiantes con mayores notas en los exámenes obtuvieran mejores calificaciones en los seminarios activos. Por lo tanto, desaparecieron esas diferencias para calificaciones de los exámenes inferiores a 6 (F=2,47; p<0,11) en términos significativos aunque se mantuvo la tendencia para calificaciones inferiores a 5 (F=2,47; p<0,08).

Esos resultados implican que ya no existen tantas diferencias en los resultados obtenidos en el examen final respecto a la calificación global de la asignatura para aquellos estudiantes con mejores resultados en el examen. Además, aquellos estudiantes «beneficiados» pasan de ser los de notas inferiores a 6 a aquellos con notas inferiores a 8 (aunque solo por debajo de 5 los resultados son estadísticamente significativos), lo que nos aproxima a los resultados encontrados por Jareño y López (2015).

Por lo tanto, el hecho de que los estudiantes dispongan de la información facilitada parece incrementar, en línea con Payne y Brown (2011), el esfuerzo dedicado a los seminarios. Aquellos estudiantes a los que antes no afectaba la diferencia obtienen mejores calificaciones finales respecto al examen y los que obtenían peores calificaciones finales respecto al examen ya no se ven «perjudicados».

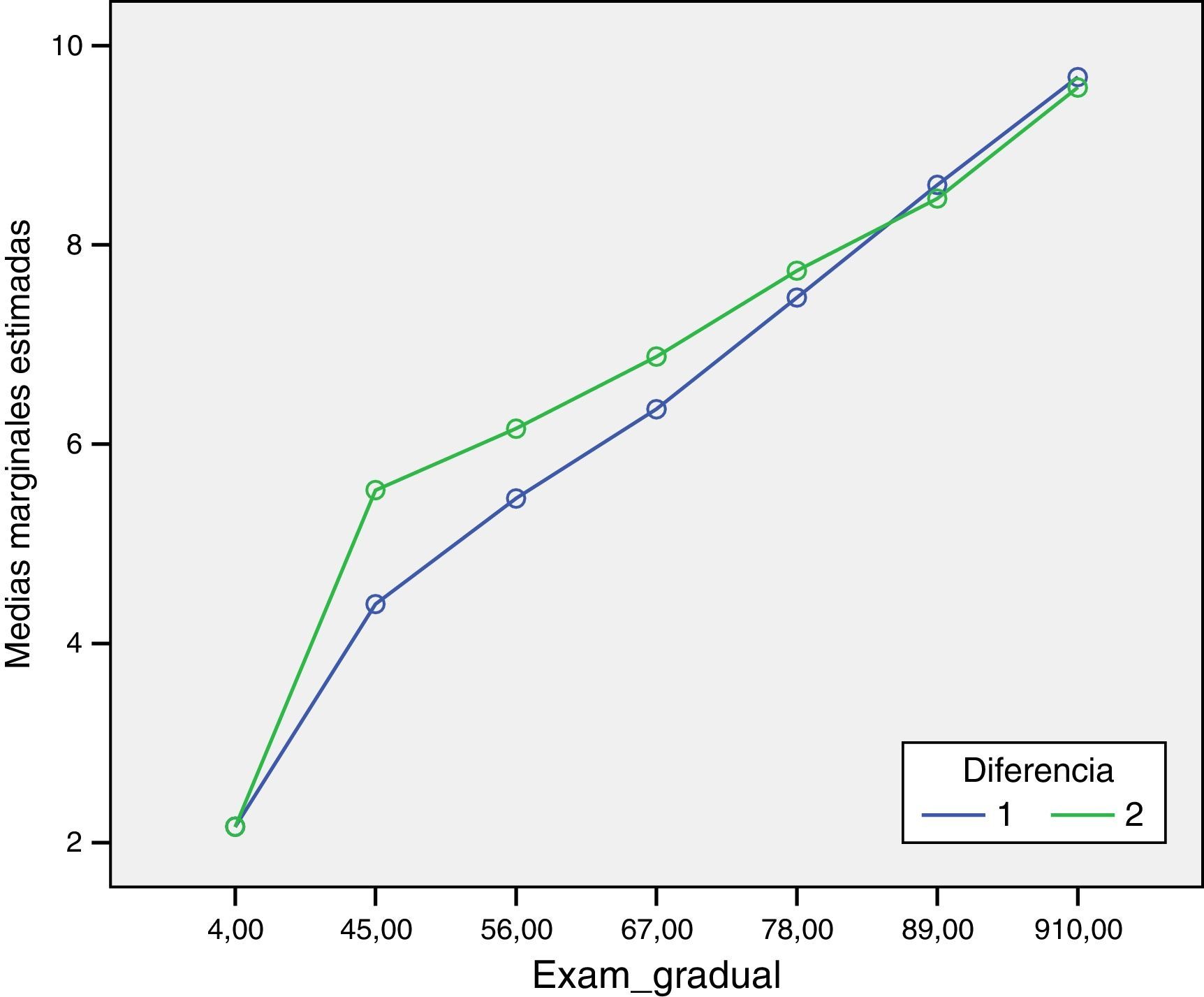

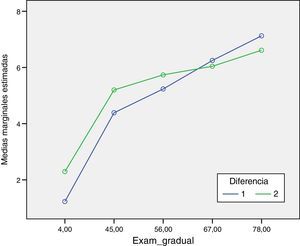

Ahora bien, cuando se les da la posibilidad de que sus conocimientos puedan ser evaluados con exámenes parciales y no mediante un único examen final (grupos a los que se les asignó la tercera condición), los resultados cambian radicalmente. En el caso de incluir exámenes parciales en el sistema de evaluación acumulativa por actividades, las diferencias desaparecen totalmente para todos los estudiantes que superan la asignatura (F=2,47; p > 0,12) en línea con lo encontrado por Jareño y López (2015) (fig. 3).

Aunque la tendencia sigue siendo la misma que en las condiciones anteriores, en este caso las diferencias no son estadísticamente significativas. Esto parece ser debido al mayor esfuerzo que los estudiantes realizan en los seminarios, ya que no se encuentran diferencias con respecto a la calificación de los exámenes en ninguna de las condiciones (F=0,746; p=0,475).

La media de seminarios en la primera condición es de 1,49 (1,02) sobre 3 mientras que en la segunda condición es de 2,13 (0,83); también en este caso la máxima calificación que los alumnos podían obtener en los seminarios activos era de 3. Por lo tanto, los grupos que estaban informados sobre los resultados que se han encontrado en la literatura respecto a la evaluación acumulativa por actividades y las diferencias entre los resultados en los exámenes finales y los seminarios, han dedicado un mayor esfuerzo a la preparación de los seminarios.

En los grupos asignados en la tercera condición, en la que se incluyen los parciales, la media es de 1,75 (0,92) sobre 3. Los resultados vuelven a ser superiores a los encontrados en la primera condición, si bien es inferior a los resultados obtenidos en la segunda condición. Esto se podría explicar porque, al tener que dedicar tiempo a preparar los exámenes parciales, dedican menos tiempo a preparar los seminarios activos. A pesar de ello, los resultados siguen siendo superiores a los obtenidos por los estudiantes de la primera condición, lo que implica que la información facilitada hace que el esfuerzo dedicado en los seminarios activos sea mayor.

Finalmente, uno de los resultados más interesantes es el incremento en el esfuerzo realizado en los seminarios por parte de todos los estudiantes, ya que no hay diferencias, independientemente de los resultados en el examen final. Tanto aquellos que tienen expectativas de obtener un buen resultado en el examen final porque tratan de evitar ser «perjudicados», como los que tienen expectativas de no obtener unos buenos resultados en el examen final porque saben que pueden ser «beneficiados».

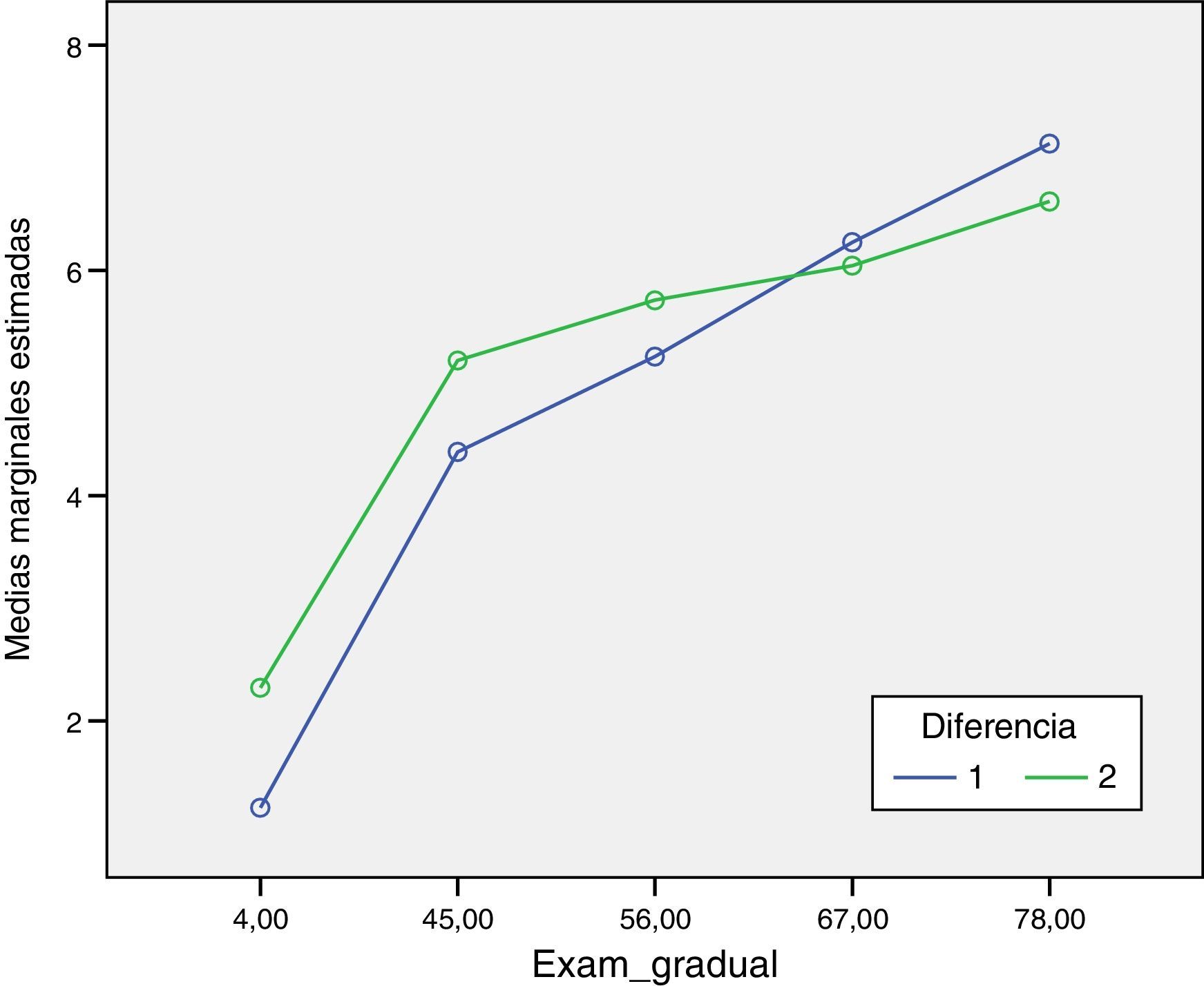

Análisis de las preferencias de los estudiantes (a priori)Respecto a las preferencias que los estudiantes tienen sobre el peso o porcentaje que deberían tener los seminarios activos en la calificación final, se tomaron 2 medidas. Una primera medida, previa al comienzo de la asignatura y una vez explicado en qué consistían lo seminarios y el examen final. Una segunda medida, una vez finalizados los seminarios y previamente a que los estudiantes supiesen su calificación y antes de realizar el examen final.

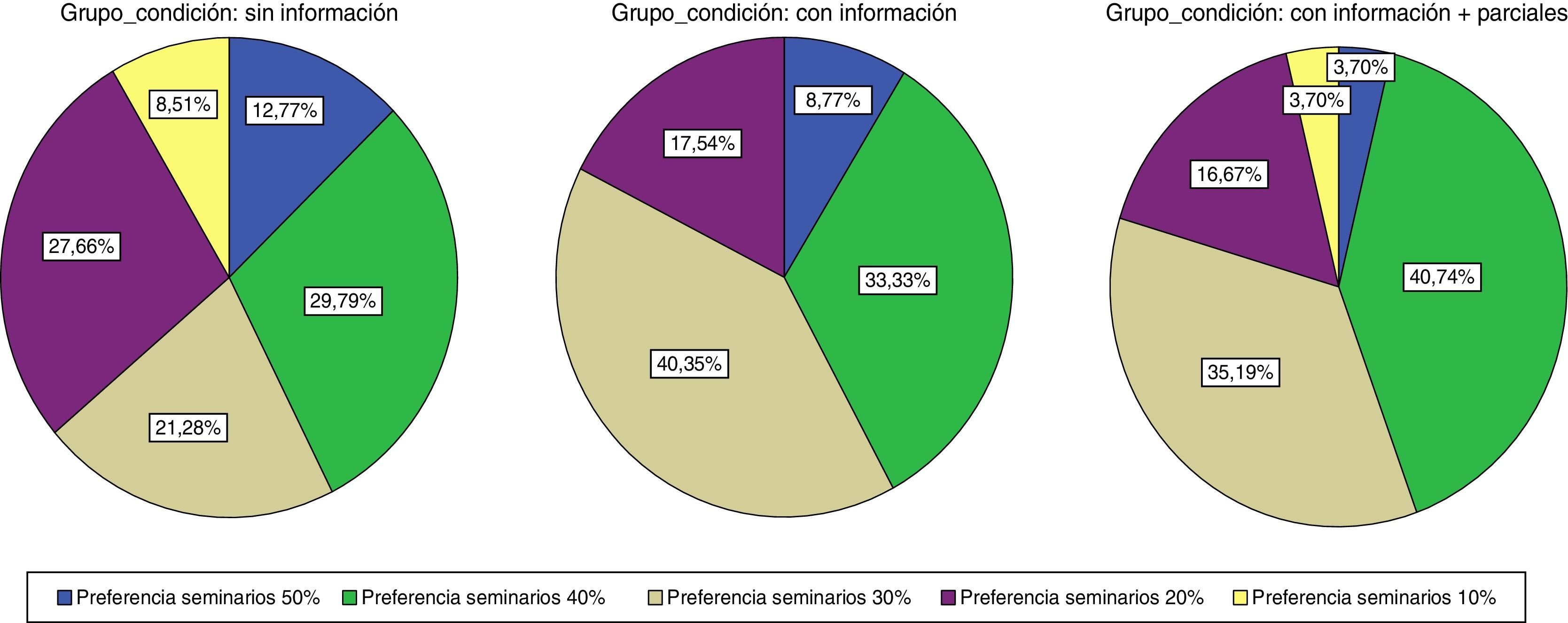

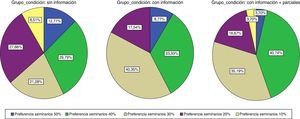

En las 3 condiciones los seminarios pesan un 30% de la calificación final. Algunos resultados obtenidos explican parte de lo encontrado anteriormente. Se ha podido observar que, independientemente de la calificación obtenida en el examen final, todos los estudiantes se esfuerzan más en los seminarios y, por lo tanto, obtienen mejores resultados. Esto va en línea con la preferencia de los estudiantes por potenciar más los seminarios (Furnham et al., 2011). Como se puede ver en el figura 4, en la primera condición (sin información) casi un 40% prefiere que el peso de los seminarios sea del 20% o inferior, es decir, el mínimo posible. Sin embargo, en la segunda condición (con información), tan solo el 17,5% prefieren el peso del 20%. Algo similar sucede en la condición con exámenes parciales. A pesar de que no ha habido diferencias estadísticamente significativas entre los estudiantes de las diferentes condiciones (F=0,977; p=0,378), estos resultados indican una tendencia a que los estudiantes den más valor a los seminarios. Esto podría tener importantes implicaciones si esta mayor importancia y los mejores resultados obtenidos, como hemos visto anteriormente, se trasladara a un mayor desarrollo de las competencias adquiridas por los estudiantes. Por lo tanto, habría que informar convenientemente a los estudiantes sobre todo el proceso y sus posibles consecuencias.

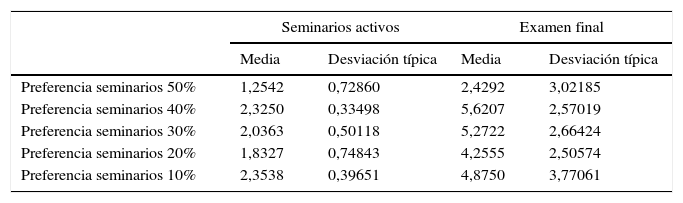

Sin embargo, al analizar si existen diferencias estadísticamente significativas en las calificaciones obtenidas en los seminarios en función de las preferencias, si nos centramos en los estudiantes que no disponían de información, obtenemos resultados muy interesantes. En esta condición, los estudiantes que prefieren que los seminarios tengan el máximo peso en la calificación final son los que peores resultados obtienen. Encontramos, por lo tanto, diferencias estadísticamente significativas (F=4,405; p<0,005) en función de las preferencias previas en esta condición. Esto es debido a que los estudiantes que prefieren a priori mayor peso de los seminarios son los que obtienen peores resultados globales tanto en el examen final como en la calificación total (tabla 2).

Medias de calificaciones en función de preferencias

| Seminarios activos | Examen final | |||

|---|---|---|---|---|

| Media | Desviación típica | Media | Desviación típica | |

| Preferencia seminarios 50% | 1,2542 | 0,72860 | 2,4292 | 3,02185 |

| Preferencia seminarios 40% | 2,3250 | 0,33498 | 5,6207 | 2,57019 |

| Preferencia seminarios 30% | 2,0363 | 0,50118 | 5,2722 | 2,66424 |

| Preferencia seminarios 20% | 1,8327 | 0,74843 | 4,2555 | 2,50574 |

| Preferencia seminarios 10% | 2,3538 | 0,39651 | 4,8750 | 3,77061 |

En la segunda condición, en la que sí se ofrecía información a los estudiantes, los resultados son los que podríamos haber predicho. Aquellos estudiantes cuya preferencia a priori es que los seminarios tengan más peso en la calificación final de la asignatura obtienen mejores resultados, con unas diferencias marginalmente significativas (F=2,508; p=0,063).

Tal y como se podía esperar, en la tercera condición no existen diferencias estadísticamente significativas en función de las preferencias previas, y el esfuerzo dedicado a los seminarios activos se diluye respecto a la condición anterior debido a los exámenes parciales (F=0,812; p=0,520). Esto puede ser debido a que el aumento de las oportunidades (con el examen parcial) de obtener una buena calificación hace que a los seminarios no se les dé la misma importancia y, por tanto, los estudiantes no desarrollen sus competencias de la misma forma.

Análisis de las preferencias de los estudiantes (a posteriori) y efectos del cambio de preferenciasNo existen diferencias estadísticamente significativas en los resultados obtenidos por los estudiantes en los seminarios activos en función de las preferencias a posteriori para ninguna de las 3 condiciones: (F=0,541; p=0,707); (F=1,765; p=0,159); (F=0,283; p=0,888). Esto se explica porque independientemente de la información de la que dispusieran, una vez finalizados los seminarios, cada estudiante podría realizar una estimación de sus posibilidades y, por lo tanto, tener preferencias basadas en los resultados esperados fundamentados en la experiencia de la realización de los seminarios. En las 3 condiciones, más de un 50% de los estudiantes cambian sus preferencias, ya sea para darles un mayor o un menor peso a los seminarios, aunque no hemos encontrado diferencias estadísticamente significativas para ninguna de las 3 condiciones en función de los cambios de preferencia de los estudiantes: (F=2,546; p=0,103); (F=0,023; p=0,977); (F=0,019; p=0,982). Por lo tanto, los estudiantes no varían globalmente sus preferencias una vez desarrollados los seminarios, lo que es muy relevante ya que con el simple hecho de aportar información a priori es suficiente para el mejor rendimiento de los estudiantes, independientemente de la tarea.

Discusión y conclusionesLos resultados de nuestro trabajo muestran que facilitar información a los estudiantes sobre el sistema de evaluación puede incrementar el rendimiento académico de estos. En los casos en los que los estudiantes han sido previamente informados sobre la posibilidad de que el nuevo sistema de evaluación puede ofrecer los resultados mencionados, los estudiantes realizan un mayor esfuerzo en las tareas de los seminarios activos. Esto implica que todos los estudiantes, independientemente de sus resultados en el examen final, estarán en igualdad de condiciones. Además, el resto de estudiantes también obtienen mejores resultados. La calificación final de la asignatura es superior a la nota media obtenida en el examen final para estudiantes con resultados más altos en el examen que cuando no disponían de la información facilitada. Por lo tanto, todo parece indicar que el aprendizaje de los estudiantes, su evolución y la calidad de los conocimientos adquiridos no solo estarán condicionados por el sistema de evaluación utilizado (Fletcher et al., 2012), sino que también vienen condicionados por la información que tengan los estudiantes respecto a los resultados obtenidos previamente por ese sistema de evaluación.

También ha quedado constatado en este trabajo que el sistema de evaluación utilizado condicionará la forma en la que se estudia y, por tanto, afecta en el proceso de aprendizaje de los estudiantes (Murphy, 2006). El hecho de incluir exámenes parciales en el sistema de evaluación acumulativa por actividades implica que los estudiantes reparten el tiempo dedicado a la asignatura entre la preparación de los seminarios activos y la preparación de los exámenes parciales. La inclusión de los exámenes parciales junto con la facilitación de información sobre los resultados obtenidos mediante el sistema de evaluación acumulativa por actividades en el pasado provoca que desaparezcan las diferencias existentes entre la calificación final de la asignatura y la obtenida en el examen final. Desde nuestro punto de vista, esto es debido a que el efecto de la información facilitada provoca que se dedique más esfuerzo a la preparación de los seminarios y, al mismo tiempo, la realización de exámenes parciales hará que se dedique más tiempo a la adquisición de conocimientos. Si bien es cierto que se necesita más investigación al respecto, con estas 2 modificaciones parecen solucionarse las carencias del sistema de evaluación acumulativa por actividades planteado por Pascual-Ezama et al. (2011).

Finalmente, tenemos ciertas limitaciones que podrían condicionar los resultados. En primer lugar, las preferencias medidas tan solo eran consultivas. Esto quiere decir que, independientemente de las respuestas obtenidas por los estudiantes, los seminarios activos tenían un peso previamente establecido en la calificación final y, por lo tanto, no sabemos si una organización individualizada podría variar los resultados encontrados. En segundo lugar, debido a que hay literatura en la que se ha encontrado que los resultados en el examen final son inferiores a los del resto de las actividades realizadas a lo largo de la asignatura (e.g. Dalziel, 1998; Bridges et al., 2002; Simonite, 2003; Gibbs y Simpson, 2004; Tian, 2007) y a que, en función del peso que tenga cada parte evaluable, el esfuerzo será calculado por los estudiantes en términos de coste-beneficio (Hand et al., 1996), nuestros resultados no pueden ser concluyentes.

A pesar de dichas limitaciones, los resultados encontrados en este trabajo parecen indicar que no hay una relación directa entre las preferencias que tienen los estudiantes respecto al porcentaje que deberían tener los seminarios activos en la calificación final y los resultados obtenidos. En términos generales, no hay diferencias ni en las calificaciones obtenidas en los seminarios, ni en los resultados del examen final, ni, por supuesto, en la calificación final de la asignatura en función de las preferencias de los estudiantes a este respecto. Esto implica que si los profesores informasen a sus estudiantes sobre los resultados obtenidos en el pasado con el sistema de evaluación aplicado, los conocimientos adquiridos serían globalmente mejores, al mismo tiempo que se desarrollarían las competencias de los estudiantes. Esto debería poder ser trasferido a cualquier disciplina, ya que el proceso y la ejecución no son inherentes a la disciplina aplicada. Estas implicaciones deberían dar paso a futuras líneas de investigación en las diferentes áreas de conocimiento existentes dentro de la disciplina educativa.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.

Nombre y apellidos:

Por favor, escoge solo una de las siguientes respuestas:

- 1.

Por favor, indica tu género.

- 1.

Masculino

- 2.

Femenino

- 1.

- 2.

¿En qué año naciste?:

- 3.

¿Qué nacionalidad tienes?

- 1.

Española

- 2.

No española

- 3.

Ambas

- 1.

- 4.

¿Trabajas?

- 1.

No

- 2.

Sí. En este caso, ¿cuántas horas a la semana?

- I.

Menos de 6

- II.

Entre 6 y 10

- III.

Entre 10 y 20

- IV.

Más de 20

- I.

- 1.

- 5.

¿Cuál fue la calificación que obtuviste en la PAU?:

- 6.

¿Por qué escogiste el grado de Informática?

- 1.

Por las salidas profesionales futuras de la carrera

- 2.

Motivación personal o familiar

- 3.

Vocación

- 4.

Por mi forma de pensar

- 5.

Por eliminación

- 6.

Otros

- 1.

- 7.

¿En qué posición escogiste la carrera?

- 1.

Primera

- 2.

Segunda

- 3.

Tercera

- 4.

Cuarta

- 5.

Última

- 1.

- 8.

¿Cuál es el grado de satisfacción que tienes con la carrera que cursas (0-10)?:

- 9.

¿En que te gustaría trabajar en el futuro?

- 1.

En una empresa privada

- 2.

Ser funcionario

- 3.

Ser emprendedor

- 4.

Otros

- 1.

- 14.

¿Has cursado alguna asignatura relacionada con economía antes de la universidad?

- 1.

Sí

- 2.

No

- 1.

- 15.

¿Cuántas veces has cursado esta asignatura en el pasado?

- 1.

0

- 2.

1

- 3.

2

- 4.

3

- 5.

4

- 6.

5 o más

- 1.

- 16.

¿Piensas que Gestión Empresarial será útil en tu futuro profesional (0-10)?:

- 17.

¿Cómo preferirías ser evaluado en esta asignatura?

- 1.

Solo el examen final

- 2.

Por evaluación continua

- 1.

- 18.

¿Qué tipo de profesor te gusta tener?

- 1.

Un profesor tradicional

- 2.

Uno que corrige los errores de los alumnos

- 3.

Uno que establezca un modelo determinado de enseñanza

- 4.

Uno que favorezca discusiones en clase sobre la asignatura

- 5.

Uno que incite al autoaprendizaje

- 1.

- 19.

¿Qué forma tienes de estudiar?

- 1.

Cada día

- 2.

Solo fines de semana

- 3.

Solo unas semanas antes del examen

- 4.

Solo unos días antes del examen

- 1.

- 20.

¿Cuál crees que es tu método de aprendizaje fundamental?

- 1.

Visual: leer los apuntes del profesor

- 2.

Auditivo: escuchar las explicaciones del profesor

- 3.

Kinestético: buscando las cosas por ti mismo, sin tanto leer ni escuchar

- 4.

Táctil: haciendo las cosas por ti mismo, más práctica y menos teoría

- 5.

Grupal: trabajando con otros y discutiendo ideas

- 6.

Individual: haciendo todo tú por ti mismo

- 1.

- 21.

¿Te gusta trabajar en grupos?

- 1.

No, prefiero trabajar solo

- 2.

No, pero los resultados son mejores

- 3.

Sí, pero a veces se hace más complicado

- 4.

Sí, prefiero trabajar en grupo

- 1.

Muchas gracias por tu colaboración.

Todos los datos serán tratados de forma confidencial en cuanto se identifiquen con los resultados académicos.