Neste trabalho é dada uma ênfase especial à inclusão das incertezas na avaliação do comportamento estrutural, objetivando uma melhor representação das características do sistema e uma quantificação da importância destas incertezas no projeto. É tratado o problema da análise de confiabilidade de estruturas, incluindo o efeito da variabilidade espacial das suas propriedades. Para tanto, é proposto um modelo de elementos finitos para a representação do comportamento do concreto armado para cargas de curta e longa duração, o qual inclui as principais características observadas neste material. Também é desenvolvido um modelo para a geração de campos estocásticos multidimensionais não Gaussiano para as propriedades do material e que é independente da malha de elementos finitos. Um exemplo da geração de campos estocásticos bidimensionais não Gaussianos numa placa quadrada de aço é apresentado em primeiro lugar. Posteriormente, a análise de confiabilidade é realizada em relação a uma função de estado limite, a qual estabelece que a flecha na secção localizada no centro do vão de uma viga de concreto armado não deve ultrapassar um valor prescrito. Finalmente, a influência dos efeitos de longa duração na confiabilidade de uma viga de concreto armado é estudada, com e sem a consideração da corrosão da armadura.

In this paper, special emphasis is given to the inclusion of uncertainties in the evaluation of structural behaviour aiming at a better representation of the system characteristics and the quantification of the importance of these uncertainties in the project. It deals with the structural reliability analysis problem accounting the effect of spatial variability of material properties. To this end it is proposed a finite element model to represent the behaviour of reinforced concrete for short and long-term loads, which includes the main features observed in this material. It was developed a model for the generation of multidimensional non-Gaussian stochastic fields for the material properties that is independent of the finite element mesh. First, an example of a two-dimensional non-Gaussian stochastic field generation in a square steel plate is presented. Latter, the reliability analysis is performed to a limit state function based on prescribed values of mid-span displacements on a simply-supported reinforced beam. Finally, the influence of long-term effects on the reliability of a reinforced concrete beam is studied considering the effect of steel reinforcement corrosion.

O termo confiabilidade estrutural é geralmente empregado para designar a medida de segurança de determinado sistema estrutural frente a um determinado desempenho esperado. Alternativamente, a confiabilidade estrutural pode ser entendida como o complemento da probabilidade de falha, ou seja, a hipótese ou propensão de determinado sistema em violar um estado limite, quer seja por falha ou por não atender a seu desempenho esperado. Obviamente, a confiabilidade estrutural está relacionada com as variáveis que descrevem o sistema estrutural e, mais precisamente, com a variabilidade das mesmas. Particularmente, esta variabilidade está presente nos sistemas estruturais sob a forma de incertezas. De acordo com Melchers [1], estas incertezas podem ser divididas em incertezas físicas, incertezas estatísticas, incertezas devido a fatores humanos, incertezas de cunho fenomenológico provenientes da existência de eventos não previsíveis e incertezas de modelagem provenientes das simplificações e hipóteses adotadas.

Neste trabalho pretende-se determinar a probabilidade de falha, através do índice de confiabilidade, em estruturas de concreto armado sob o efeito de cargas de curta e longa duração, incluindo campos estocásticos. Para este fim, utilizam-se o Método de Confiabilidade de Primeira Ordem (First Order Reliability Method ou FORM) e o Método de Monte Carlo com Amostragem por Importância (Monte Carlo Method with Importance Sampling). Como exemplos de aplicação são apresentados o caso da geração de campos estocásticos numa placa de aço (comparando diversos métodos), a análise de confiabilidade de uma viga de concreto armado em circunstâncias diversas e que inclui um campo estocástico para o módulo de elasticidade e, finalmente, é analisada a confiabilidade de uma viga de concreto armado sob efeito de cargas de longa duração sem considerar a corrosão da armadura e incluindo posteriormente este efeito. Em cada caso, são apresentadas algumas conclusões.

2Modelo de elementos finitos para o concreto armado sob efeito de carregamentos de curta duraçãoPara a modelagem do concreto armado são empregados elementos tridimensionais isoparamétricos de 20 nós. O concreto é modelado como um material de comportamento elastoviscoplástico com amolecimento e rutura frágil, com seu comportamento pós-pico definido pelas curvas dadas no CEB-FIP/90 [2]. Para o comportamento frágil, emprega-se um modelo de fissuras distribuídas ortogonais e fixas em 3 direções juntamente com um modelo de amolecimento à tração. É utilizado o critério do CEB-FIP/90 [2] para a escolha do tipo de rutura do material (se por deformação viscoplástica excessiva ou por fissuração). A superfície de 4 parâmetros de Ottosen [3] é empregada como superfície de falha e de carregamento.

Para a modelagem das armaduras são utilizados elementos de treliça de 2 ou 3 nós, os quais estão incorporados na matriz de rigidez dos elementos de concreto, assumindo-se uma total aderência entre os 2 materiais. É empregado um modelo uniaxial elastoviscoplástico com 3 ramos (um linear, um ramo com encruamento linear e um ramo com encruamento e amolecimento parabólicos) para modelar o comportamento das barras da armadura. O modelo incorporado de armaduras é implementado, através da técnica do mapeamento inverso, o qual permite a colocação das armaduras totalmente independentes da malha de elementos finitos definida para o concreto, reduzindo-se o esforço para a geração dos dados para a definição da geometria das armaduras. Como sistema de solução, emprega-se o Método do Controle dos Deslocamentos Generalizados (MCDG), o qual possibilita a captura do comportamento pós-pico com precisão. Detalhes sobre este modelo são apresentados por Gomes e Awruch [4].

2.1Modelo reológico do concreto sob o efeito de cargas de longa duraçãoOs efeitos de longa duração em estruturas de concreto armado são caracterizados por deformações e tensões dependentes do tempo. Estes fenômenos são observados nos primeiros meses, mas prolongam-se durante quase toda a vida útil da estrutura, resultando, às vezes, em deslocamentos da mesma ordem daqueles devido às deformações instantâneas das cargas de serviço.

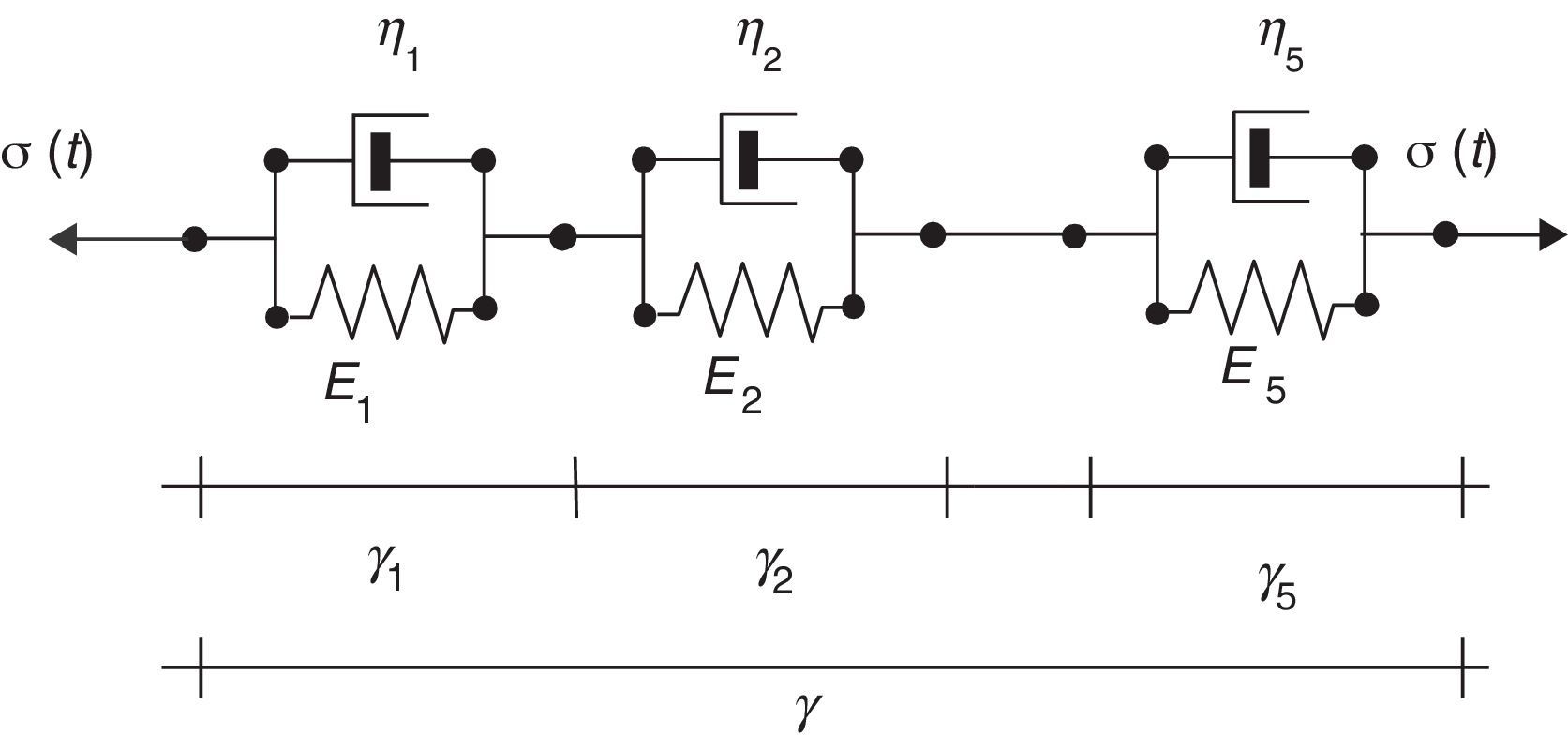

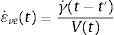

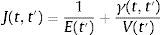

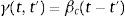

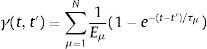

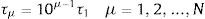

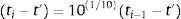

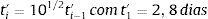

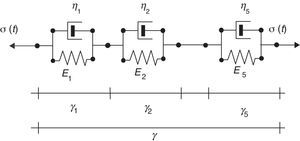

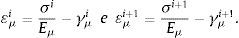

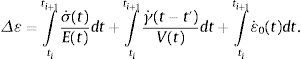

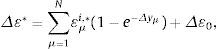

Segundo a teoria de solidificação proposta por Bazant [5], é possível associar um modelo reológico ao comportamento de um pequeno elemento do material. De acordo com este autor, o resultado desta associação pode ser expresso da seguinte forma:

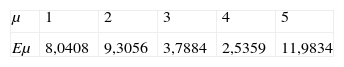

em que γ˙(t−t′) e V(t) são a taxa de deformação viscoelástica do material sem envelhecimento e o volume do material solidificado, respetivamente, para um dado instante de tempo t. Na equação (1), t’ indica o tempo em que o carregamento foi aplicado. Assim, emprega-se o modelo reológico apenas para a determinação das deformações no material sem envelhecimento, o que implica que as viscosidades e os módulos de elasticidade dos elementos reológicos são independentes do tempo, como na viscoelasticidade clássica. Segundo a teoria de solidificação, para um dado material, o comportamento quanto à fluência pode ser representado pela seguinte função de fluência:que, quando comparada com a função de fluência dada pelo CEB-FIP/90 [2], fornece as relações:Estas relações são utilizadas na aproximação pela série de Dirichlet, aquando do cálculo dos parâmetros da cadeia. Neste trabalho, adotou-se uma cadeia de Kelvin com 5 elementos, como é indicado na figura 1, por ser suficiente para representar o comportamento do concreto sob efeito de cargas de longa duração da ordem de décadas. A função de fluência da cadeia de Kelvin com propriedades constantes (ou seja, sem considerar o envelhecimento) vem dada por:em que τμ=ημ/Eμ é o tempo de retardamento à fluência da μ-ésima unidade da cadeia. A equação (5) pode ser ajustada para diversos tempos de carregamento (t-t’) através de um simples algoritmo de aproximação por mínimos quadrados para funções não lineares com o objetivo de encontrar os valores dos parâmetros. Para a faixa de tempo que se deseja cobrir com a cadeia, neste trabalho (que é da ordem de algumas décadas), os tempos de retardamento são tomados como:com τ1=1dia, de forma a assegurar uma resposta da cadeia para longos períodos de carregamento.Para o ajuste da equação (5) utilizaram-se 33 pontos para a discretização da função apresentada no CEB-FIP/90 [2]. Os tempos de carregamentos foram então escolhidos numa razão crescente em escala logarítmica, assim definida:e, para as idades de carregamento, adotou-se:Com a cadeia de 5 elementos, obtiveram-se, para os parâmetros, os valores indicados na tabela 1.Parâmetros da cadeia de Kelvin com 5 elementos para a função de fluência do CEB-FIP/90

| μ | 1 | 2 | 3 | 4 | 5 |

| Eμ | 8,0408 | 9,3056 | 3,7884 | 2,5359 | 11,9834 |

Fonte: Comité Euro-Internacional du Beton2.

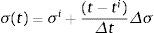

Assume-se neste trabalho que as tensões variam linearmente num passo de tempo, ou seja, que:

em que Δt=(ti+1−ti).

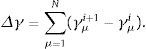

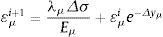

A solução geral da equação (5), utilizando-se a condição inicial de γμ=γμi em t=ti, dada por Bazant [5], vem dada pela seguinte expressão:

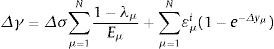

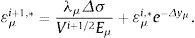

em que Δyμ=Δtτμ e λμ=1−e−ΔyμΔyμ.O incremento de deformação é dado por:

Introduzindo (10) em (11), tem-se:

em que

Lembrando que σi+1=σi+Δσ, a equação para atualizar as variáveis ¿μ em função do incremento de tensões Δσ é escrita como:

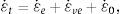

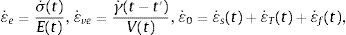

Para calcular a taxa de deformação total (ε˙t), devem somar-se as parcelas devidas à parte elástica (ε˙e), viscoelástica (ε˙ve), devido à temperatura (ε˙T), devido à retração (ε˙s) e à fissuração (ε˙f). Consequentemente, a deformação total vem dada por:

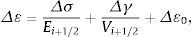

em que,sendo que cada uma das taxas de deformações, já foram definidas anteriormente. Integrando-se (15) no intervalo de tempo ti,ti+1, obtém-se o incremento de deformação total:Utilizando-se a regra de integração do trapézio, tem-se:

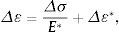

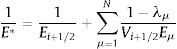

sendo o índice i+1/2 o meio do intervalo de integração ti,ti+1. A equação (18) pode escrever-se também como:em quee

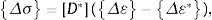

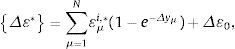

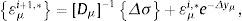

sendo as variáveis εμi,∗ atualizadas através da seguinte expressão:Admitindo-se isotropia, as equações anteriores podem ser generalizadas para o caso tridimensional, ficando a equação (19) na forma:

comem que [D∗] é a matriz de um material elástico-linear, utilizando-se E* dado pela equação (20) no lugar do módulo de elasticidade clássico e {Δ¿*} é o vetor de deformações de longa duração, que é atualizado através da seguinte expressão:sendo a matriz [Dμ]−1 a inversa da matriz constitutiva isotrópica linear.3Confiabilidade estruturalAssume-se que o comportamento de uma estrutura, representada por um modelo numérico, é afetado por um vetor de variáveis aleatórias básicas X={x1, x2,..., xn}, no qual se pode incluir parâmetros que definem ações, propriedades do material, tamanho das secções, etc. Para poder calcular a probabilidade de falha, deve formular-se uma Função de Estado Limite G(X), localizada no espaço das variáveis aleatórias X, e tal que

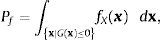

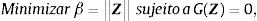

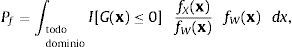

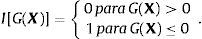

seja satisfeita sempre que as condições de segurança tenham sido cumpridas. Uma função de estado limite como G(X), separa 2 situações: uma de segurança e outra de falha. Se G(X)≥0, considera-se que os requerimentos de projeto têm sido devidamente satisfeitos e corresponde a um ponto da região de segurança. Se G(X)<0, isto significa que algum dos requerimentos de projeto não foi satisfeito e esta condição corresponde a um ponto da região de falha. A probabilidade de falha Pf é então dada porem que, fX(x) é a função de densidade de probabilidade conjunta das variáveis aleatórias. A avaliação da integral da equação (27) é frequentemente impossível de se obter, pois fX(x) não é conhecida. Também é grande o trabalho que demanda resolver a mesma integral para funções de estado limite comuns presentes em problemas de estruturas de concreto armado, com grande dimensão do espaço de variáveis aleatórias (superiores a 10 variáveis).3.1Método de confiabilidade de 1.a ordem (first order reliability method)Para a análise de confiabilidade de 1.a ordem, o cálculo do índice de confiabilidade é feito no espaço Gaussiano padrão independente. Assim, uma transformação probabilística S(.) é feita nas variáveis básicas X do espaço real, de forma a transformá-las para o espaço Gaussiano padrão independente Z, de forma que Z=S(X). Assim, o problema fica resumido ao problema de otimização com uma restrição:

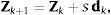

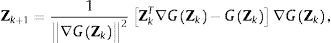

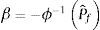

em que β é a mínima distância da origem deste espaço à função de estado limite, e que constitui o índice de confiabilidade, Z e G(Z) são, respetivamente, as variáveis e a função de estado limite transformadas do espaço real ao espaço Gaussiano padrão não correlacionado (independente) e || || indica a distância (norma euclidiana). A probabilidade de falha relaciona-se com o índice de confiabilidade, aproximadamente, através da relaçãoem que ϕ é a função de distribuição acumulada gaussiana padrão. Este índice proporciona uma alternativa mais cômoda para medir a segurança de um sistema, pois, enquanto a probabilidade de falha varia de 0,1 a 1x10−9 na maioria dos sistemas estruturais, o índice de confiabilidade varia de 1 a 6.No método modificado de Hasofer e Lind - Rackwitz e Fiessler (Hasofer e Lind [6]), para se resolver o problema de otimização com uma restrição, indicado na equação (28), e obter o valor do índice de confiabilidade β e as correspondentes coordenadas do ponto de projeto (design point)Z*, uma sequência de aproximações para este ponto é gerada na seguinte forma:

em que Zk é o vetor que contém as coordenadas do ponto de projeto numa iteração k, dk é o vetor de direção de procura e «s» é um parâmetro que define o comprimento do passo. Para o cálculo do vetor de direção de procura, é empregue a seguinte equação, na qual implicitamente está imposta a restrição GZ=0:em que ▿G é o gradiente da função de estado limite, avaliado em zk. Em grande parte das vezes, como neste trabalho, este gradiente é avaliado através de diferenças finitas à frente (forward finite differences) aplicadas ao programa de elementos finitos de concreto armado.3.2Simulação de Monte Carlo com amostragem por importânciaUma alternativa ao first order reliability method (FORM) para a determinação da probabilidade de falha é a simulação direta de Monte Carlo, que é a técnica mais tradicional e que pode ser utilizada como referência para comparação com outros métodos (Ang e Tang [7]). Um dos inconvenientes deste método é o grande tempo de processamento computacional requerido. Para aliviar o custo computacional da simulação direta de Monte Carlo, o índice de confiabilidade β é avaliado usando a simulação de Monte Carlo com amostragem por importância (Bourgund et al. [8] e Liu & der Kiureghian [9]). Emprega-se uma função de densidade de probabilidade de amostragem, como indicada na equação abaixo, o que traz as simulações para uma região próxima da região de falha.

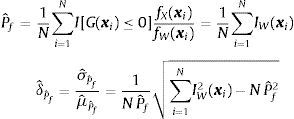

em que X é o vetor de variáveis aleatórias básicas, G(X) é função de estado limite, fX(x), é a função de densidade de probabilidade conjunta, fW(x) é a função de densidade de probabilidade de amostragem e I[.] é a função indicadora, a qual assume os seguintes valores:Primeiramente, amostras das variáveis aleatórias básicas uniformemente distribuídas e independentes são geradas e transformadas ao espaço Gaussiano padrão. Então, a matriz de correlação destas variáveis é imposta através do modelo de Nataf [10]. Após este estágio, as amostras são retornadas ao espaço original, sendo o método da transformação inversa (inversa da probabilidade acumulada) usado para aplicar as correspondentes funções de densidade de probabilidade a cada variável aleatória. As simulações são feitas com o modelo determinístico para cada uma das amostras geradas. O valor médio da probabilidade de falha e o coeficiente de variação são calculados como indicado na equação (34) enquanto o índice de confiabilidade β é calculado usando a relação dada pela equação (35)

Nas expressões anteriores, N é o número de simulações, ϕ é da função de distribuição acumulada gaussiana padrão, Pˆf é uma estimativa da probabilidade de falha, σˆPˆf e μˆPˆf são os valores estimados do desvio padrão e do valor médio da probabilidade de falha, respetivamente e δˆ é o coeficiente de variação (relação entre o desvio padrão e o valor médio).

4Geração de campos estocásticos multidimensionais não GaussianosA geração de campos aleatórios é um assunto muito importante relacionado com a análise estrutural de elementos finitos estocásticos e de confiabilidade estrutural, pois pode explicar a incerteza associada aos comportamentos observados nas estruturas de concreto armado. Nestes casos, a despeito da aleatoriedade das diferentes variáveis, o projetista está preocupado com a aleatoriedade espacial das propriedades dos materiais, geometria, cargas externas aplicadas e condições de contorno, de forma a melhorar a representação das características do sistema. Na análise da confiabilidade de estruturas tridimensionais, a geração destes campos é de grande importância, principalmente na geração das geometrias e cargas, uma vez que se pretende trabalhar com modelos que melhor representem o comportamento das estruturas reais.

Devido às dificuldades matemáticas e à falta de dados observados, a maioria das técnicas de geração, assim como as aproximações analíticas para a geração de campos estocásticos, é limitada ao tratamento de campos Gaussiano. Em algumas situações, a hipótese de um campo estocástico Gaussiano não é adequada devido ao facto de que os dados reais observados apresentam características não gaussianas. Por exemplo, a variabilidade espacial do módulo de Young e outras propriedades mecânicas não devem ser consideradas como gaussianas, porque, teoricamente, estas propriedades não assumem valores negativos. É mais apropriado considerá-las como campos estocásticos com distribuição log-normal.

Embora atualmente existam diversas metodologias para a geração de campos estocásticos (expansão de Kahunen-Loeve, polinómios de Chaos, fractais), aqui serão citados os principais 3 procedimentos largamente empregados: (a) Representação espectral; (b) Modelamento ARMA (auto-regressive moving average); (c) Procedimentos de decomposição da matriz de autocovariância (Yamazaki e Shinozuka [11,12]).

Os métodos de decomposição da matriz de autocovariância, tais como decomposição de Cholesky e decomposição modal, permitem a geração de campos estocásticos em pontos discretos, desde que as suas funções de correlação ou, opcionalmente, suas funções de densidade espectral sejam conhecidas a priori. A grande vantagem destes métodos recai no facto de que a geração de campos estocásticos multivariáveis, multidimensionais, não homogêneos e não Gaussianos é tão fácil quanto para campos unidimensionais. Entretanto, o método de decomposição da matriz de autocovariância pode necessitar de uma grande quantidade de amostras para alcançar estatísticas estáveis e de alta precisão.

A geração de campos estocásticos com distribuições não gaussianas segue a técnica do mapeamento inverso usada para a geração de variáveis simples com função de densidade de probabilidade prescrita. Assim como no caso de variáveis aleatórias simples, é necessário gerar variáveis com média 0 e desvio padrão unitário. A técnica do mapeamento inverso é então usada para impor a correta função de densidade de probabilidade.

Pode-se começar por gerar um vetor de números aleatórios uniformemente distribuídos (U=u1,u1,...,unT) entre 0 e 1 na mesma quantidade dos campos discretos. Então, a inversa da função de distribuição acumulada gaussiana padrão é usada para obter o campo Gaussiano padrão (média zero, desvio padrão unitário) denominado Z′, como descrito na seguinte equação:

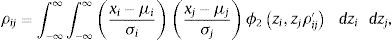

em que ϕ−1 é a inversa da função de distribuição acumulada gaussiana padrão.Na análise estatística de campos estocásticos reais, as estatísticas obtidas a respeito das variáveis estão no espaço das variáveis aleatórias originais. Portanto, os dados disponíveis a respeito de um dado conjunto de variáveis aleatórias são o seu tipo de distribuição parâmetros e sua matriz de autocorrelação. Se, por exemplo, uma variável tem um tipo de distribuição log-normal, então a descrição em termos da sua média, do desvio padrão e da matriz de autocorrelação RXi j no espaço real é suficiente para a posterior geração do campo. O modelo de Nataf [10] pode ser usado para a transformação da matriz de autocovariância para o espaço Gaussiano padrão não correlacionado (independente) como descrito em Liu e der Kiureghian [9]. Basicamente, dada a matriz de coeficientes de correlação no espaço real (cujos termos são ρij), a matriz de coeficientes de correlação no espaço Gaussiano padrão (ρ′ij) pode ser encontrada através da solução numérica da integral dada abaixo:

em que μi e σi são a média e o desvio padrão da i-ésima variável e ϕ2zi,zjρ′ij é a função de densidade de distribuição Gaussiana bidimensional de média 0 e desvio padrão unitário. Como os coeficientes de correlação estão dentro da integral, uma integração numérica ou fórmulas empíricas podem ser usadas para resolver este tipo de problema (Liu e der Kiureghian [9], Rosenblatt [13]).Como não se conhece ρ′ij, é necessário transformar a função de autocorrelação RXij numa matriz de coeficientes de correlação (ρ′ij) de forma a poder utilizar o modelo de Nataf (Lebrun e Dutfoy [14]). A seguinte definição da matriz de coeficientes de correlação é usada, tendo em conta da homogeneidade do campo gerado que tem média 0:

em que σXi é o desvio padrão da i-ésima variável.Para que a matriz de coeficientes de correlação (ρ) no espaço real seja obtida e a matriz de coeficientes de correlação no espaço Gaussiano padrão (ρ′) seja calculada, podem ser usados 2 métodos para a decomposição matricial, conforme indicado abaixo: (a) Decomposição de Cholesky, em que a matriz é decomposta como ρ′=LLT, sendo L é uma matriz triangular inferior; (b) Decomposição modal em que a matriz é decomposta como ρ′=θ ΛθT, sendo Λ a matriz diagonal de autovalores em ordem descendente e θ é a matriz de autovetores associada correspondente, cujo problema de autovalores e autovetores vem dado por ρ′θ=θΛ.

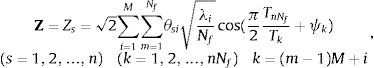

Os seguintes 3 procedimentos são aplicáveis à geração de variáveis correlacionadas gaussianas prescritas (Z): (a) Multiplicar a matriz triangular inferior da decomposição de Cholesky pelo vetor de números Gaussianos padrão já calculados (método de decomposição de Cholesky) Z=LZ′; (b) Multiplicar a matriz de autovetores (ou parte dela) pela raiz quadrada dos autovalores e pelo vetor de números Gaussianos padrão (método da decomposição modal), ou seja Z=θΛ1/2Z′; (c) Gerar diretamente números gaussianos padrão pela representação espectral usando autovetores e autovalores do procedimento anterior e séries de cosseno (Shinozuka e Deodatis [15]), como indicado na seguinte expressão (método da representação espectral por séries de cosseno):

em que λi é o i-ésimo autovalor da matriz de coeficientes de correlação (em ordem descendente), θsi é a s-ésima componente do vetor θi, ψk é o k-ésimo ângulo de fase uniformemente distribuído entre 0 e 2π(ψ=2πZ′), M é o número de modos da matriz de autovalores retidos, Nf é o número de funções cosseno a serem adicionadas à série, n é o tamanho do campo discreto e Tk=1/k.Para que o campo Gaussiano padrão correlacionado seja encontrado, estes valores devem ser mapeados ao espaço real das variáveis através da inversa da função de densidade de probabilidade acumulada, originando o campo de variáveis reais:

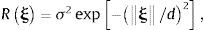

em que FX−1 é a inversa da função acumulada da distribuição de probabilidade das variáveis de interesse.5Exemplos numéricos5.1Geração de um campo estocástico em uma placa quadrada de açoNeste exemplo, cujo objetivo é demonstrar a aplicabilidade das metodologias aqui estudadas para geração de campos estocásticos, é gerado um campo estocástico bidimensional com distribuição log-normal numa placa quadrada de aço de 10,0m de cada lado. Este exemplo também foi resolvido por Liu et al. [16]. A placa quadrada é discretizada em 100 elementos de igual área (1,0m×1,0m). As propriedades dos elementos são consideradas como constantes ao longo da área do elemento e representada pelo seu valor no centro geométrico do elemento, assumindo uma função de autocorrelação isotrópica com forma exponencial, como mostrado na seguinte expressão:

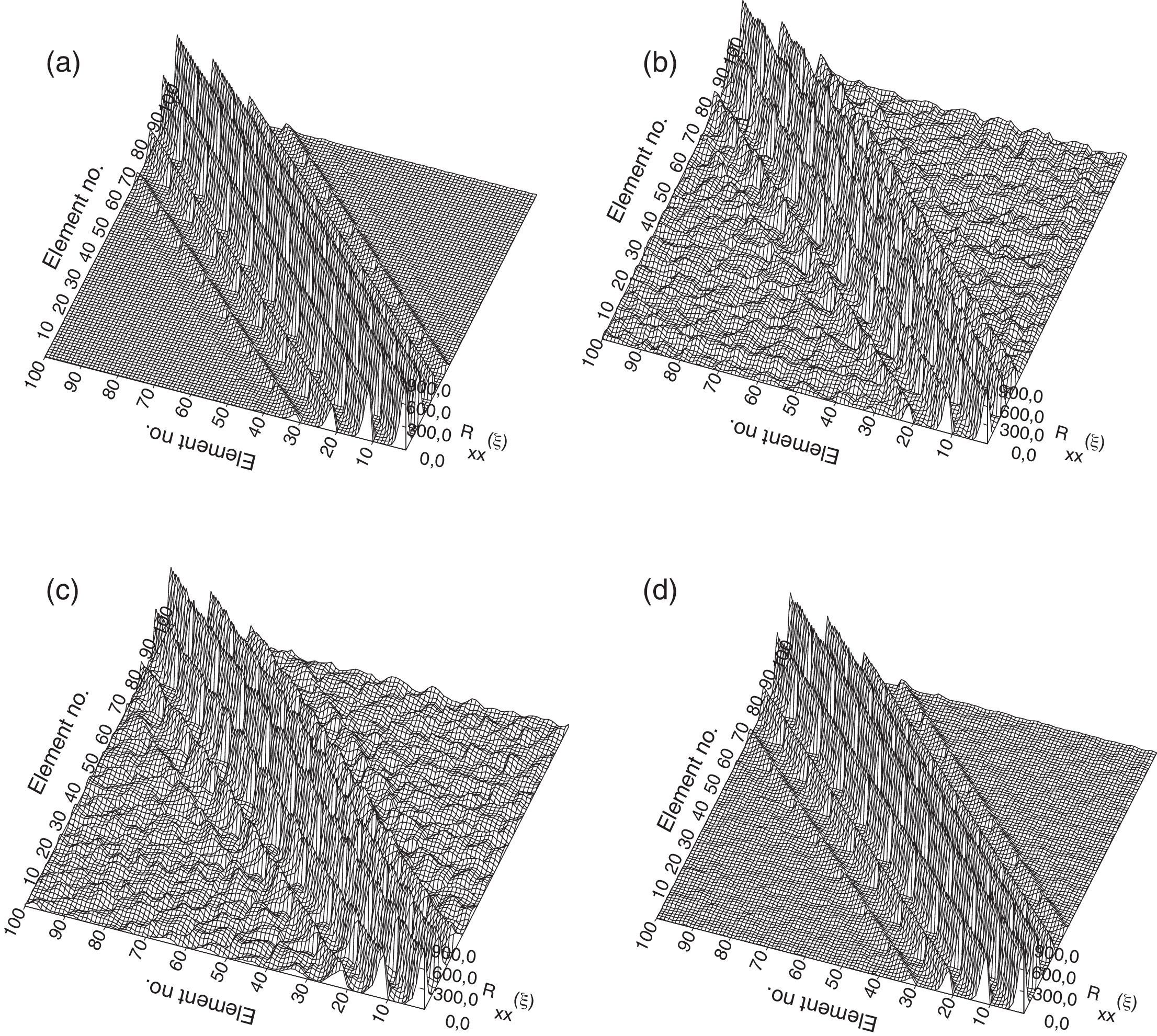

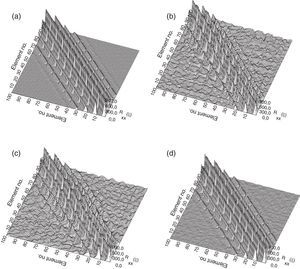

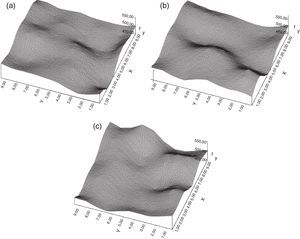

em que ξ=x−x′ é o vetor que contém as distâncias entre os centros de dois elementos, d é o parâmetro que representa a escala de correlação (quanto maior d, mais lentamente a correlação desaparece em função da distância de separação ξ), e σ é o desvio padrão do campo estocástico. No presente trabalho, a discretização da malha é considerada pequena o suficiente para representar a variabilidade espacial requerida. Para uma discussão mais precisa a respeito deste problema, veja, por exemplo, Liu et al. [16].Neste exemplo, o campo estocástico é representado pela variabilidade espacial da tensão de escoamento (fy) da placa quadrada de aço. Adota-se μ=500 MPa, σ=30 MPa com uma função de densidade de probabilidade do tipo log-normal e d=2m. Com o intuito de validar os resultados, a matriz de covariância foi calculada com uma série de 500 amostras geradas segundo os procedimentos anteriormente vistos, assumindo isotropia e ergodicidade dos campos gerados. Na figura 2 são comparadas a função de autocorrelação original e os resultados para os 3 métodos anteriormente expostos.

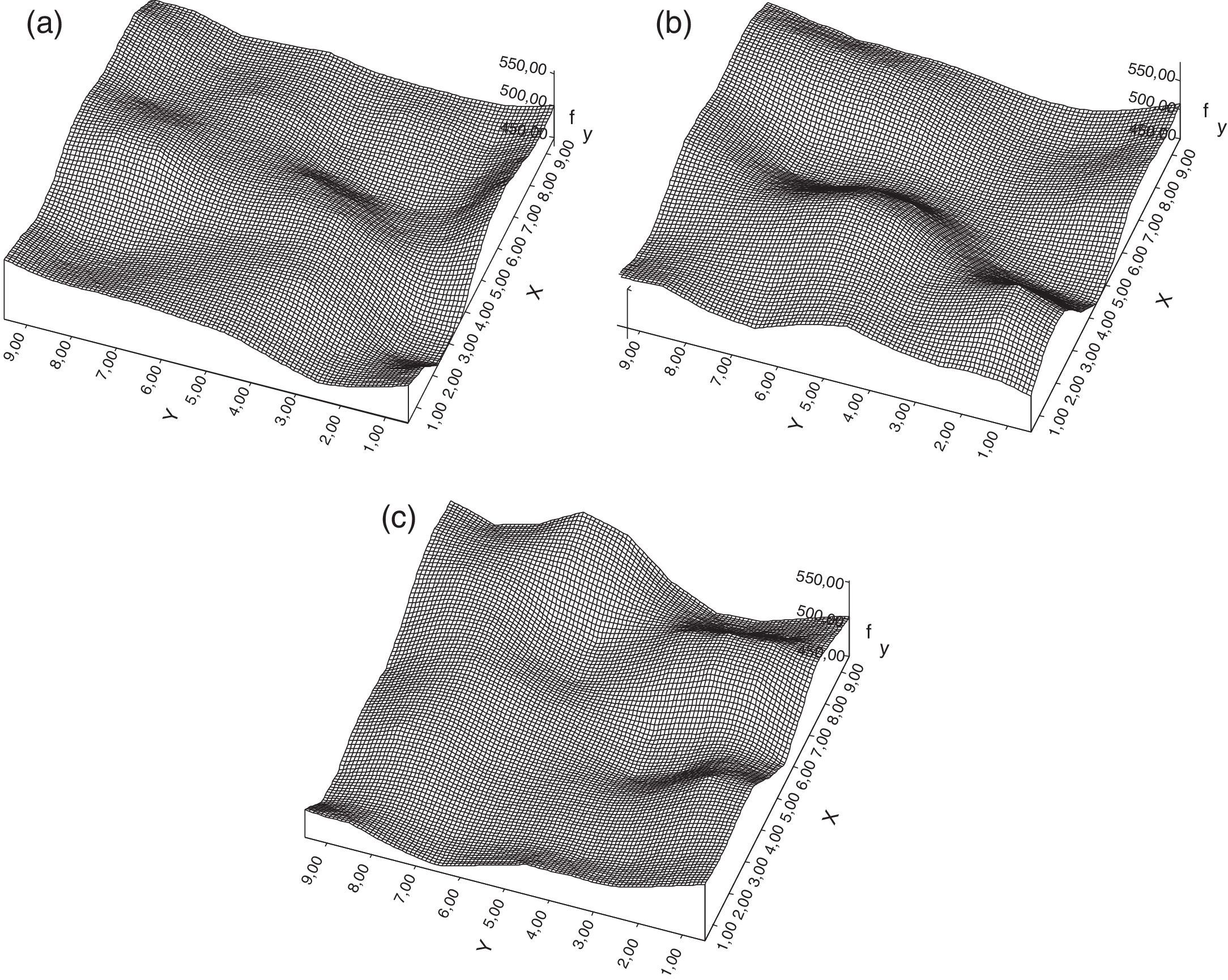

Nos exemplos apresentados aqui, para o método da representação espectral tomou-se M=50, (os primeiros 50 modos), e Nf=1 (somente um cosseno é adicionado à série). As seguintes comparações podem ser estabelecidas entre as diferentes formulações: o método de decomposição de Cholesky parece ser mais atrativo quando o campo estocástico é pouco correlacionado, ou os elementos de fora da diagonal da matriz de coeficiente de correlação são muito pequenos quando comparados com os elementos diagonais. Por outro lado, o método da decomposição modal parece ser mais vantajoso quando o método de decomposição de Cholesky não funciona adequadamente (o algoritmo de fatorização do método de Cholesky falha), isto é, quando o campo é altamente correlacionado ou os elementos fora da diagonal da matriz de coeficientes de correlação são da mesma magnitude que os elementos diagonais. Uma vez que o método da representação espectral depende dos autovalores e autovetores da matriz de coeficiente de correlação, este método tem as mesmas vantagens e desvantagens que o método da decomposição modal. Entretanto, deve ser enfatizado que não é necessário avaliar todos os autovalores e autovetores, uma vez que grande parte dos campos reais é moderadamente correlacionada, sendo necessários apenas alguns modos para uma geração precisa. Na figura 3, são apresentados os correspondentes campos gerados.

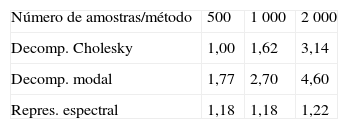

O tempo relativo de CPU requerido para gerar os campos estocásticos, para cada um dos diferentes métodos, para 3 tamanhos de amostras, é mostrado na tabela 2.

Analisando a figura 2, é possível notar a avaliação mais precisa da função de autocorrelação pelo método da representação espectral com séries de cosseno mesmo para um pequeno número de amostras. Podem ser obtidos resultados mais precisos com o método da decomposição modal e decomposição de Cholesky aumentando-se o número de amostras, mas em prejuízo do tempo de CPU usado. Como indicado na tabela 2, para um pequeno número de amostras, os 3 métodos são aproximadamente equivalentes em termos de tempo de CPU.

Para grande número de amostras, ou seja, com resultados mais precisos, a vantagem do método de representação espectral é evidente com respeito aos outros métodos.

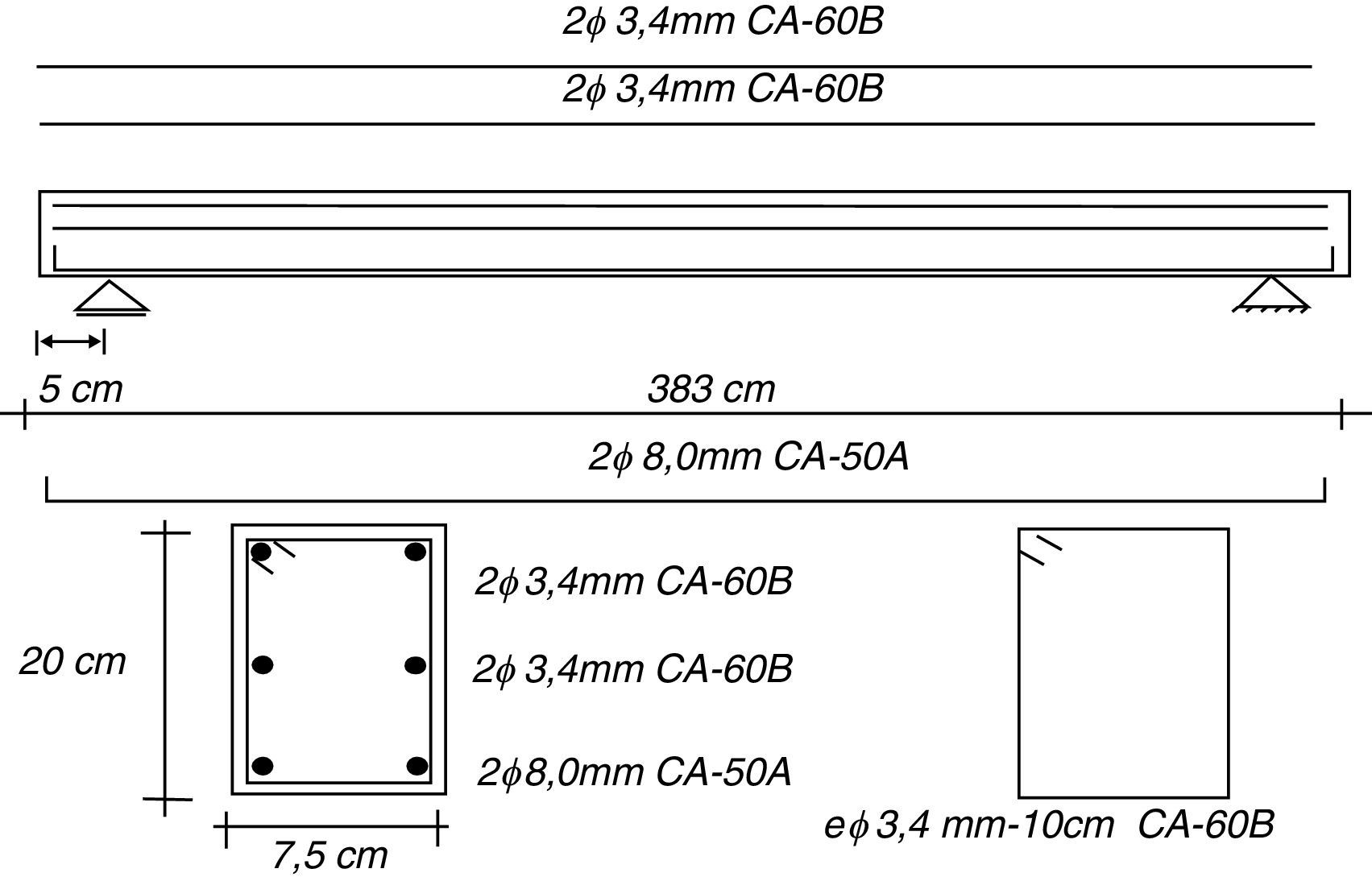

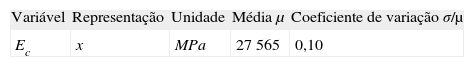

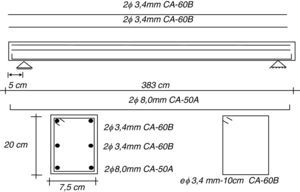

5.2Confiabilidade de uma viga de concreto armado com um campo estocástico bidimensional do módulo de elasticidadeNeste exemplo será analisada a confiabilidade de uma viga simplesmente apoiada de concreto armado com as seguintes propriedades: fc=21,14MPa (resistência à compressão do concreto), ft=1,67MPa (resistência à tração do concreto), Gf=0,506x10−4MN/m (energia de fratura do concreto), Ec=27565MPa (módulo de elasticidade do concreto). A viga está sujeita a um carregamento determinístico uniforme ao longo de seu vão de (Q+G)=3,04KN/m (em que G é a parcela de carga permanente e Q a parcela de carga acidental), sendo mostrada na figura 4. A viga foi discretizada até à metade do seu vão com 10 elementos tridimensionais de 20 nós (5 no comprimento e 2 na altura) e também na totalidade de seu vão, com 20 elementos (10 no comprimento e 2 na altura). Foi especificado para esta viga um campo estocástico bidimensional para seu módulo de elasticidade, representado no centroide de cada elemento utilizado na discretização da viga. A função de estado limite é a ultrapassagem de um valor máximo admitido para a flecha no vão central de δ<1,219x10−2m. Na tabela 3 são apresentadas as características estatísticas para o campo estocástico correspondente ao módulo de elasticidade (admitindo que a sua distribuição é do tipo log-normal).

Considerou-se o campo com uma matriz de autocorrelação do tipo exponencial dada pela seguinte equação:

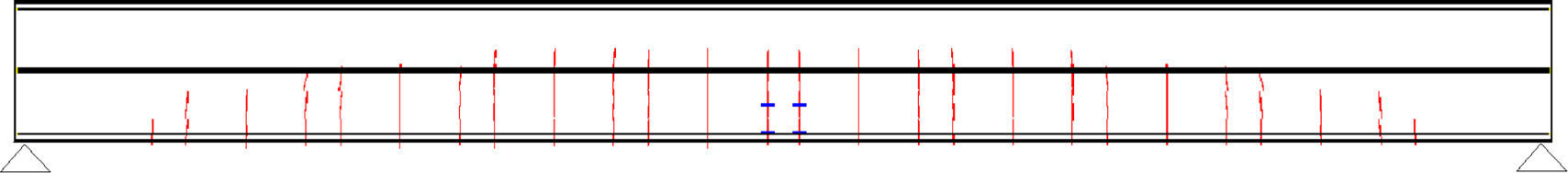

em que x é o vetor posição entre 2 centroides de elementos finitos da discretização da viga, d é o comprimento de correlação para o campo (em metros). As demais propriedades relacionadas ao o módulo de elasticidade (resistência à compressão, resistência à tração, energia de fratura, etc.) foram assumidas como totalmente correlacionadas através da avaliação de seus valores pelas relações determinísticas dadas no CEB-FIP/90 [2].Na figura 5 mostra-se a configuração final das fissuras, assumindo-se os valores médios das propriedades da viga e carregamento (G+Q=3,04KN/m).

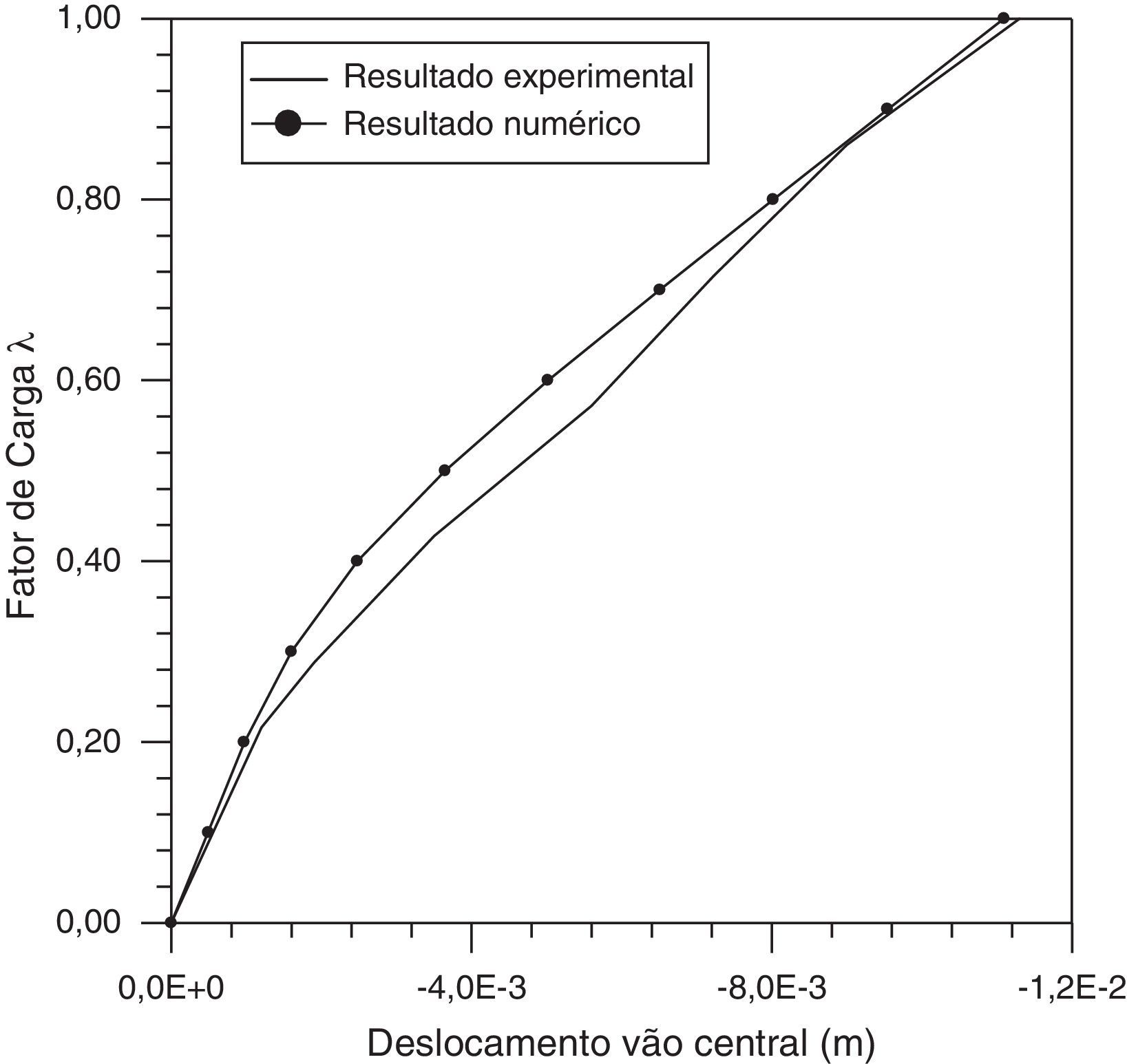

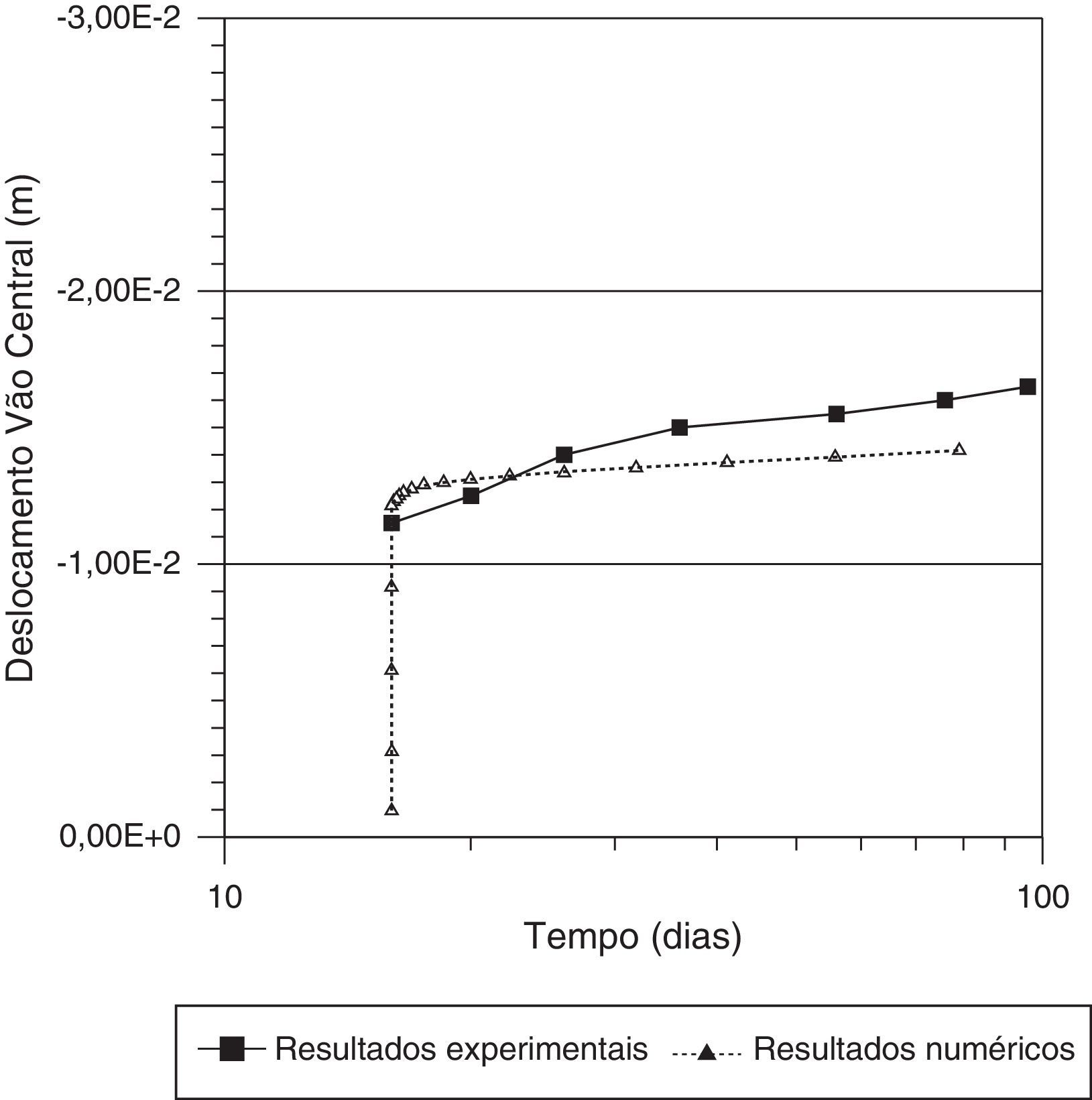

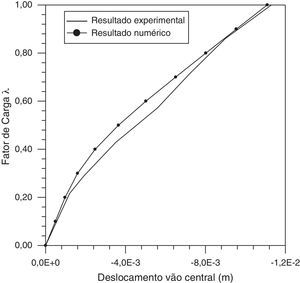

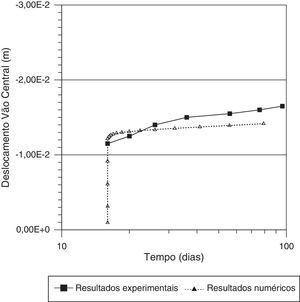

Na figura 6, apresenta-se uma comparação entre os valores da flecha na face inferior da secção localizada no centro do vão central da viga, observada experimentalmente (Gobetti et al. [17]) e aquelas obtidas numericamente com o modelo de elementos finitos utilizando apenas os valores médios das propriedades. Pode-se observar que há uma boa concordância entre os resultados experimentais e os numéricos.

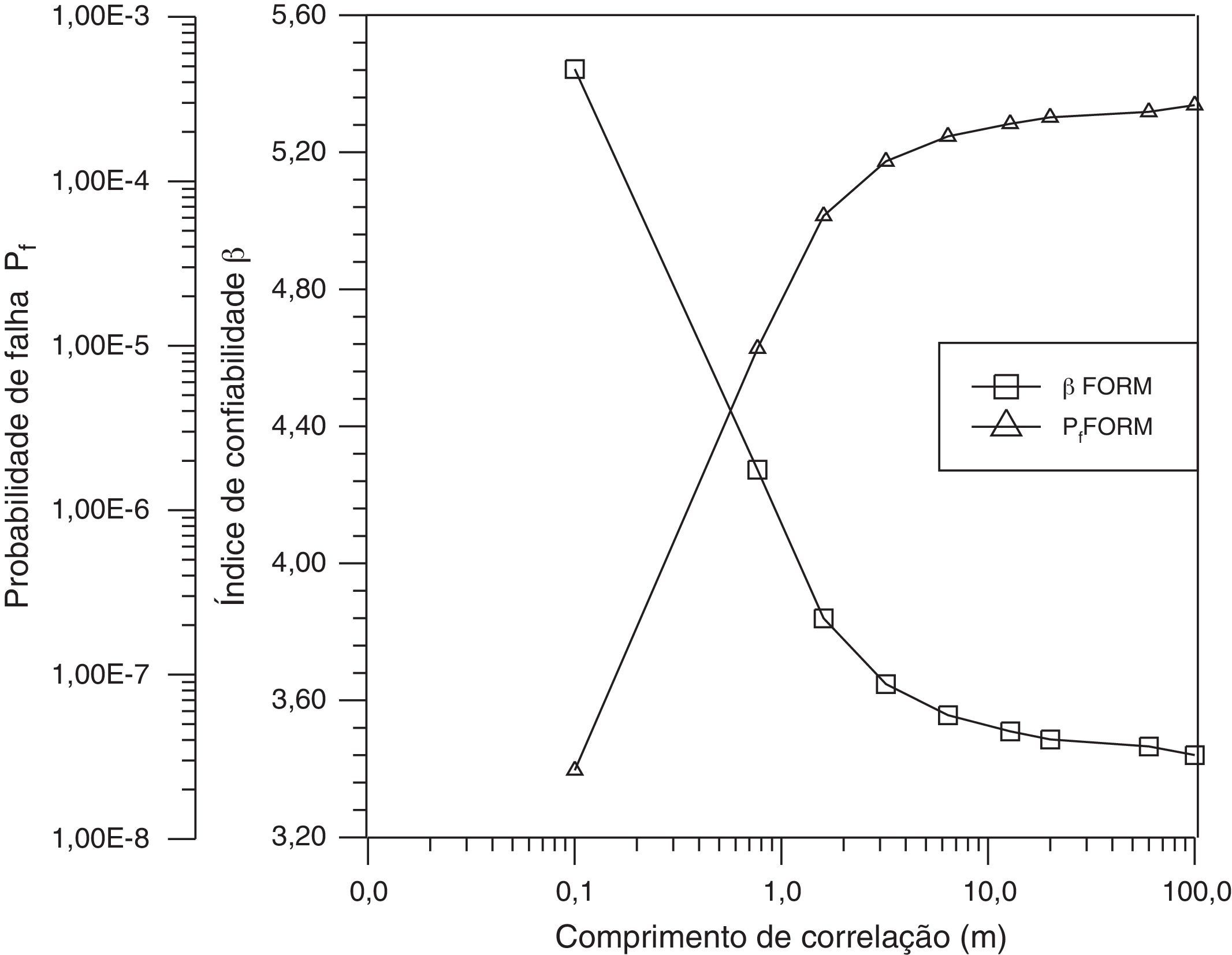

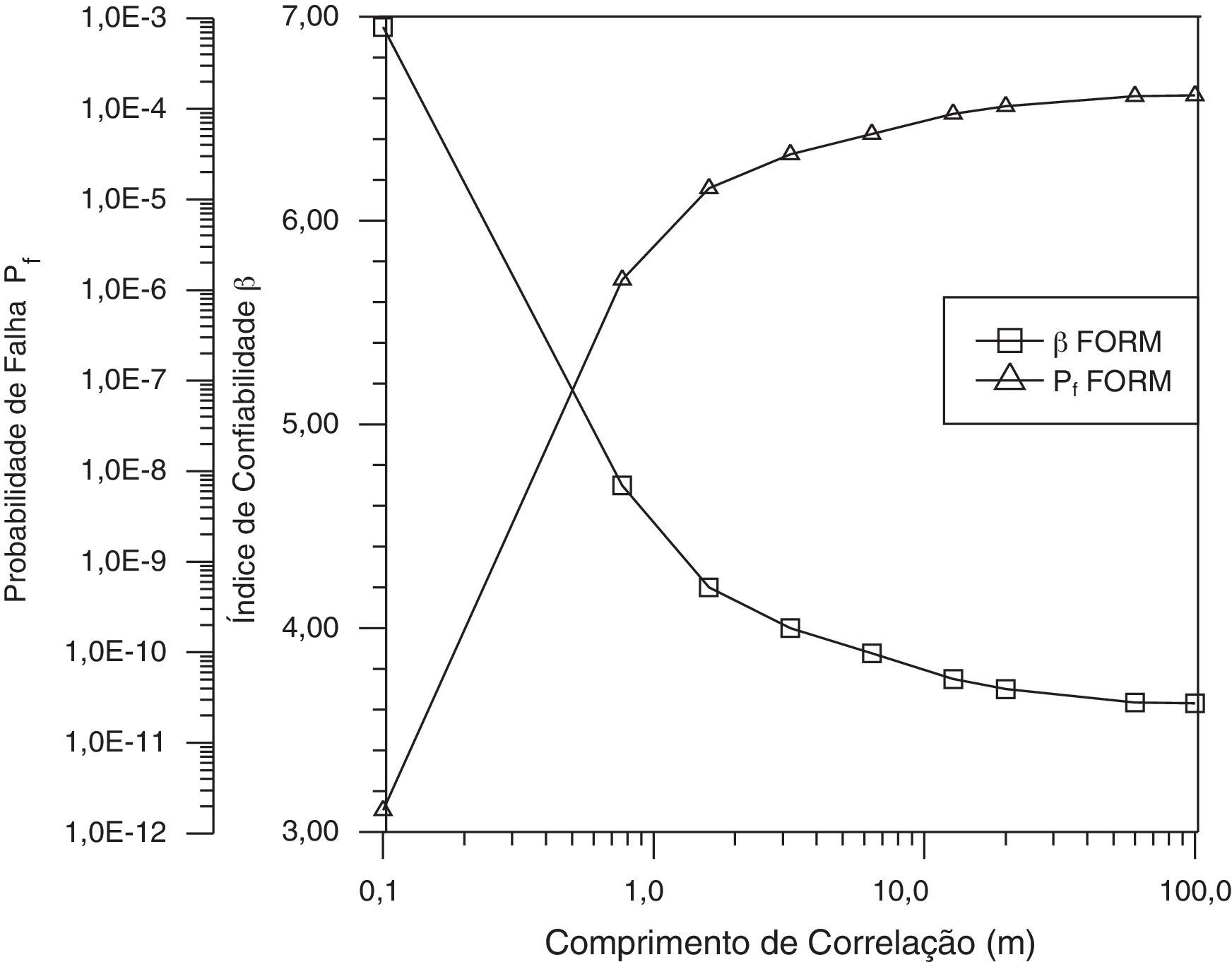

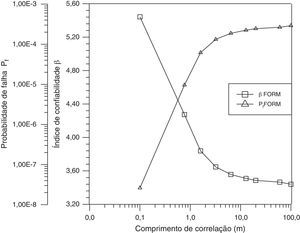

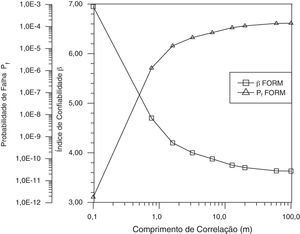

A seguir, são apresentados resultados usando FORM para o caso de discretização com 10 (metade da viga e simetria) e 20 elementos (viga completa), respetivamente. Uma vez que há poucos dados disponíveis a respeito do comprimento de correlação d em estruturas de concreto armado, fez-se variar o comprimento de correlação para o campo do módulo de elasticidade. Na figura 7 é apresentada a curva de comprimento de correlação em relação ao índice de confiabilidade para a discretização da metade da viga com 10 elementos. O mesmo gráfico é apresentado na figura 8 para o caso em que a viga completa é discretizada utilizando 20 elementos. No caso da viga discretizada pela metade, o número médio de avaliações da função de estado limite para o cálculo de cada ponto no gráfico da figura 7, foi de aproximadamente 121 vezes. Já para o caso da viga discretizada completamente, o número médio de avaliações da função de estado limite para o cálculo de cada ponto no gráfico da figura 8 foi de aproximadamente 273 e o tempo de processamento, no mesmo computador, foi aproximadamente 3,5 vezes maior do que no caso anterior.

Analisando-se os resultados do índice de confiabilidade, por exemplo, para o caso de um campo com fraca correlação, ou seja, com d=0,1, percebe-se uma diferença significativa nos seus valores usando a discretização da metade da viga e da viga completa. Deve descartar-se o primeiro caso, pois, ainda que exista simetria de carga, geometria e condições de contorno, não existe simetria sob o ponto de vista da análise de confiabilidade considerando campos estocásticos. A razão pela qual o índice de confiabilidade é maior com a discretização de toda a viga em relação ao obtido com a discretização levando em conta a simetria pode explicar-se, em parte, pelo facto de que, no caso da discretização completa, o campo aleatório é mais bem representado e então a hipótese de que o módulo de Young numa região contígua ao centro do vão seja alterado significativamente é menor, impedindo que a flecha nesse local seja afetada. Isto será mais pronunciado quanto maior for a dispersão (ou o desvio padrão) da propriedade.

Se o cálculo do índice de confiabilidade é realizado sem considerar um campo estocástico (o que significa um campo com correlação total, ou seja, com o comprimento de correlação d tendendo a infinito), os resultados serão mais conservadores, com índices de confiabilidade menores em relação a um campo com alguma correlação, que é uma situação mais real.

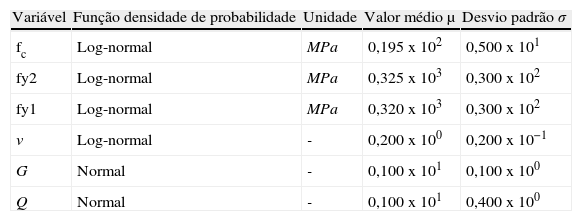

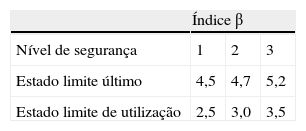

5.3Estudo dos efeitos de longa duração na análise da confiabilidade de uma viga de concreto armadoPrimeiramente, é realizada uma análise determinística para cargas de longa duração da viga esquematizada na figura 4. A viga está sujeita a uma carga uniformemente distribuída de 3,04KN/m (22,36% correspondem à carga permanente e 77,64% à carga variável). Na idade de carregamento (16.od), a temperatura e a humidade eram 20oC e 70%, respetivamente, e, na idade de 100d, a temperatura e a humidade eram 25oC e 65%, respetivamente. Na figura 9 é apresentada uma comparação entre os resultados numéricos e experimentais para cargas de longa duração para 100d. Os resultados são relacionados com os deslocamentos no centro do vão da viga e comparados com os resultados experimentais apresentados por Gobetti et al. [17]. Os parâmetros para a análise de confiabilidade do exemplo estudado são resumidos na tabela 4. Para efeitos de comparação, alguns índices de confiabilidade alvo indicados norma alemã (para o tempo de vida da estrutura) citados por Vismann e Zilch [18] são apresentados na tabela 5. Valores similares são apresentados na ISO 2394:1998. A análise de confiabilidade foi feita para cargas de longa duração, usando a máxima flecha na secção central (< 0,019m), esmagamento de qualquer ponto de integração ou divergência no processo de solução como funções de estado limite.

Variáveis aleatórias básicas e parâmetros para as funções de densidade de probabilidade

| Variável | Função densidade de probabilidade | Unidade | Valor médio μ | Desvio padrão σ |

| fc | Log-normal | MPa | 0,195x102 | 0,500x101 |

| fy2 | Log-normal | MPa | 0,325x103 | 0,300x102 |

| fy1 | Log-normal | MPa | 0,320x103 | 0,300x102 |

| ν | Log-normal | - | 0,200x100 | 0,200x10−1 |

| G | Normal | - | 0,100x101 | 0,100x100 |

| Q | Normal | - | 0,100x101 | 0,400x100 |

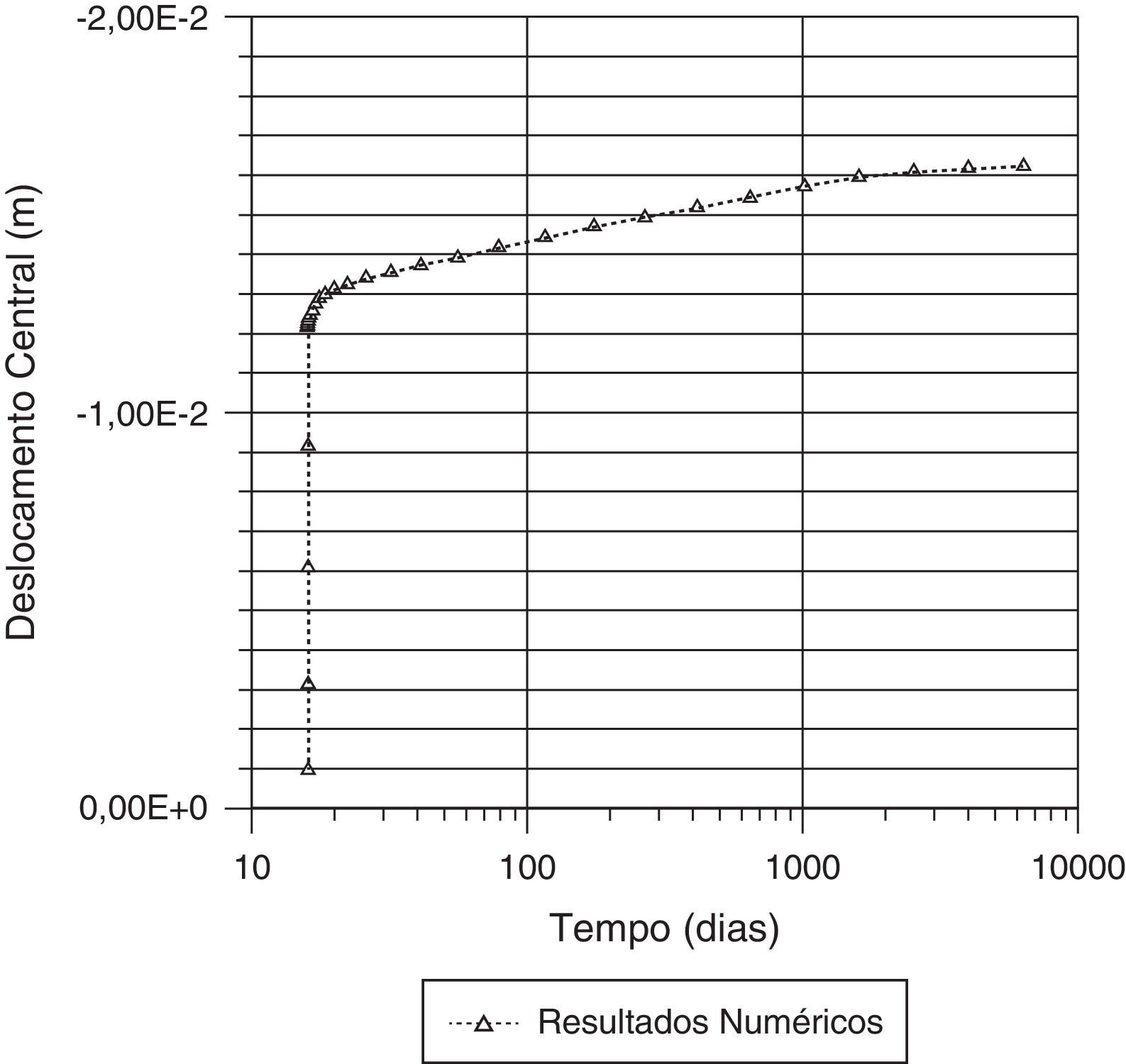

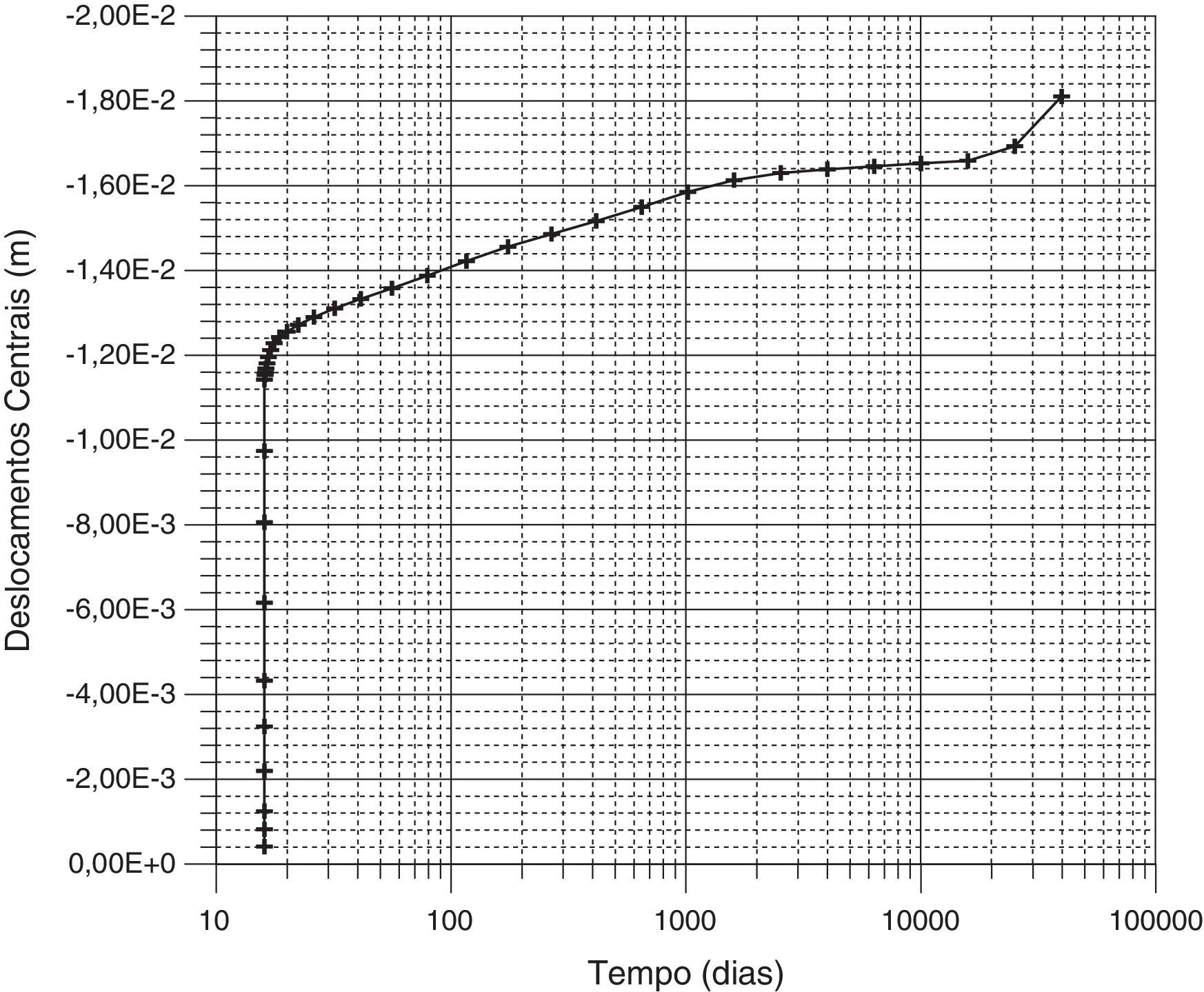

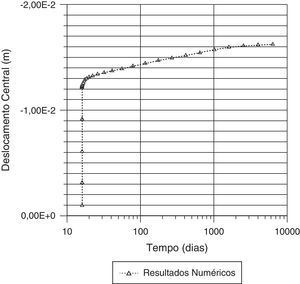

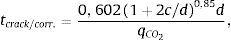

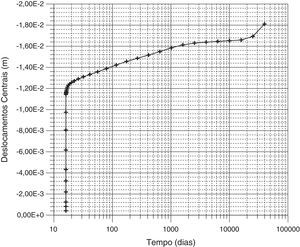

Resultados de uma análise determinística são apresentados na figura 10 para cargas de longa duração correspondentes há 10 000 d (aproximadamente 27 anos). A análise de confiabilidade foi feita para esta mesma idade. Para cargas de longa duração, o índice de confiabilidade calculado foi β=0,71 com um coeficiente de variação de δ=0,21, enquanto que, para cargas de curta duração, ou seja, para a carga instantânea aplicada aos 16 d, o valor do índice de confiabilidade calculado foi de β=1,96, com um coeficiente de variação de δ=0,20. Uma simples análise de curta duração pode levar a um índice diferente de confiabilidade quando comparado com aquele obtido considerando os efeitos de longa duração. Em ambos os casos, os índices de confiabilidade calculados estão um tanto abaixo dos índices alvo citados por Vismann e Zilch [18], para qualquer nível de segurança considerado.

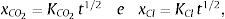

5.4Análise de confiabilidade de estruturas de concreto armado levando em conta a corrosão das armadurasPode determinar-se o tempo de propagação da frente de carbonatação requerido para o início do aumento da deterioração estrutural por corrosão de armaduras em estruturas de concreto armado (usualmente chamado de tempo de iniciação). Este pode ser definido como o tempo necessário para que a frente de carbonatação atinja as armaduras e que a taxa de iões cloreto atinja um valor específico. A relação entre a frente de carbonatação, a taxa de iões cloreto e o tempo pode ser avaliada pela 2.a lei de Fick, a qual pode expressar-se da seguinte forma:

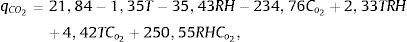

em que xCO2 é a profundidade da frente de carbonatação em mm, xCl é a profundidade dos iões cloretos em mm, KCO2 é o coeficiente de difusividade de CO2, em mm.ano−1/2, KCl é o coeficiente de difusividade efetivo do Cl− em mm.ano−1/2 e t é o tempo em anos.Uma formulação mais geral envolvendo as variáveis ambientais é proposta por Morinaga [19] e pode ser expressa da seguinte forma:

em que, W é a relação água-cimento (adimensional), Cco2 é a concentração de CO2 (adimensional), xco2 é a profundidade da frente de carbonatação em mm, T é a temperatura em °C, RH é a humidade relativa (adimensional), R é a razão da velocidade da frente de carbonatação, a qual é função do material de revestimento (ajustado a dados reais) e t é o tempo em anos.No estágio do aumento da deterioração estrutural, os agentes atuantes são caracterizados pela perda da área de secção de aço e por fissuras originadas pelos produtos expansivos da corrosão. A avaliação da perda de área de aço é estimada por meio da lei de Faraday. Assume-se que a taxa de corrosão seja proporcional à densidade de corrente. Assim, de acordo com Andrade [20], pode avaliar-se a perda da área de aço por meio da fórmula:

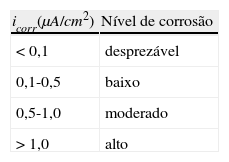

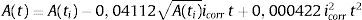

em que A(t) é a área de aço em função do tempo em mm2, A(ti) é a área de aço inicial em mm2, icorr é a densidade de corrente de corrosão em μA/cm2 e t é o tempo em anos. A densidade de corrente de corrosão (icorr) pode ser medida in situ por equipamentos. Broomfield et al. [21], de acordo com a tabela 6, sugere as seguintes interpretações para os valores da densidade da corrente de corrosão.Quando a corrosão é devida à carbonatação, Morinaga [20] sugere a seguinte equação para a taxa de corrosão:

em que, qCO2 é a taxa de corrosão em 10−4g/cm2/ano, T é a temperatura em °C, RH é a humidade relativa (adimensional), CO2 é a concentração de oxigénio (adimensional).O mesmo autor sugere, para a avaliação do tempo requerido para o surgimento de fissuras devido à corrosão, a seguinte equação:

em que d é a altura efetiva e c o recobrimento.

A influência da temperatura na maturidade do concreto e nos dias subsequentes ao carregamento (efeitos dilatacionais), tipo de cimento e retração são levados em consideração como deformações impostas. Em todos estes casos, as recomendações do CEB-FIP/90 [2] são também seguidas.

Sugere-se a geração de amostras das variáveis aleatórias básicas e sua posterior simulação direta até uma idade fixa e o cálculo dos casos de ultrapassagem de algum estado limite. A avaliação da probabilidade de falha é feita através de uma contagem balanceada dos casos de falha observados com o método de Monte Carlo com amostragem por importância.

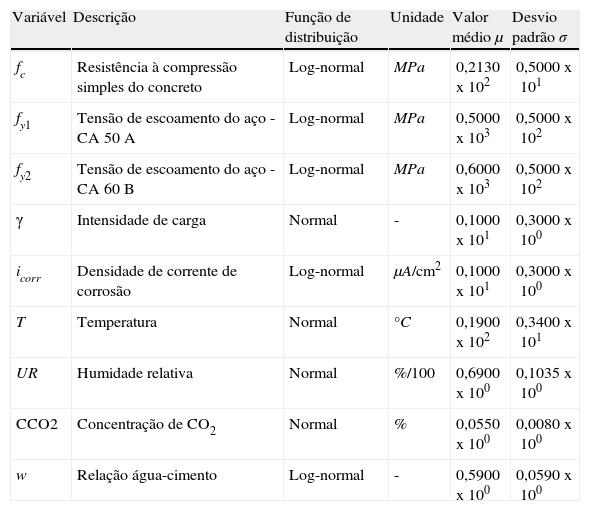

Na tabela 7 são mostrados os parâmetros para as variáveis aleatórias básicas (média e desvio padrão) e, da mesma forma, são adotadas as funções de distribuição.

Parâmetros das funções de distribuições das variáveis

| Variável | Descrição | Função de distribuição | Unidade | Valor médio μ | Desvio padrão σ |

| fc | Resistência à compressão simples do concreto | Log-normal | MPa | 0,2130x102 | 0,5000x101 |

| fy1 | Tensão de escoamento do aço - CA 50 A | Log-normal | MPa | 0,5000x103 | 0,5000x102 |

| fy2 | Tensão de escoamento do aço - CA 60 B | Log-normal | MPa | 0,6000x103 | 0,5000x102 |

| γ | Intensidade de carga | Normal | - | 0,1000x101 | 0,3000x100 |

| icorr | Densidade de corrente de corrosão | Log-normal | μA/cm2 | 0,1000x101 | 0,3000x100 |

| T | Temperatura | Normal | °C | 0,1900x102 | 0,3400x101 |

| UR | Humidade relativa | Normal | %/100 | 0,6900x100 | 0,1035x100 |

| CCO2 | Concentração de CO2 | Normal | % | 0,0550x100 | 0,0080x100 |

| w | Relação água-cimento | Log-normal | - | 0,5900x100 | 0,0590x100 |

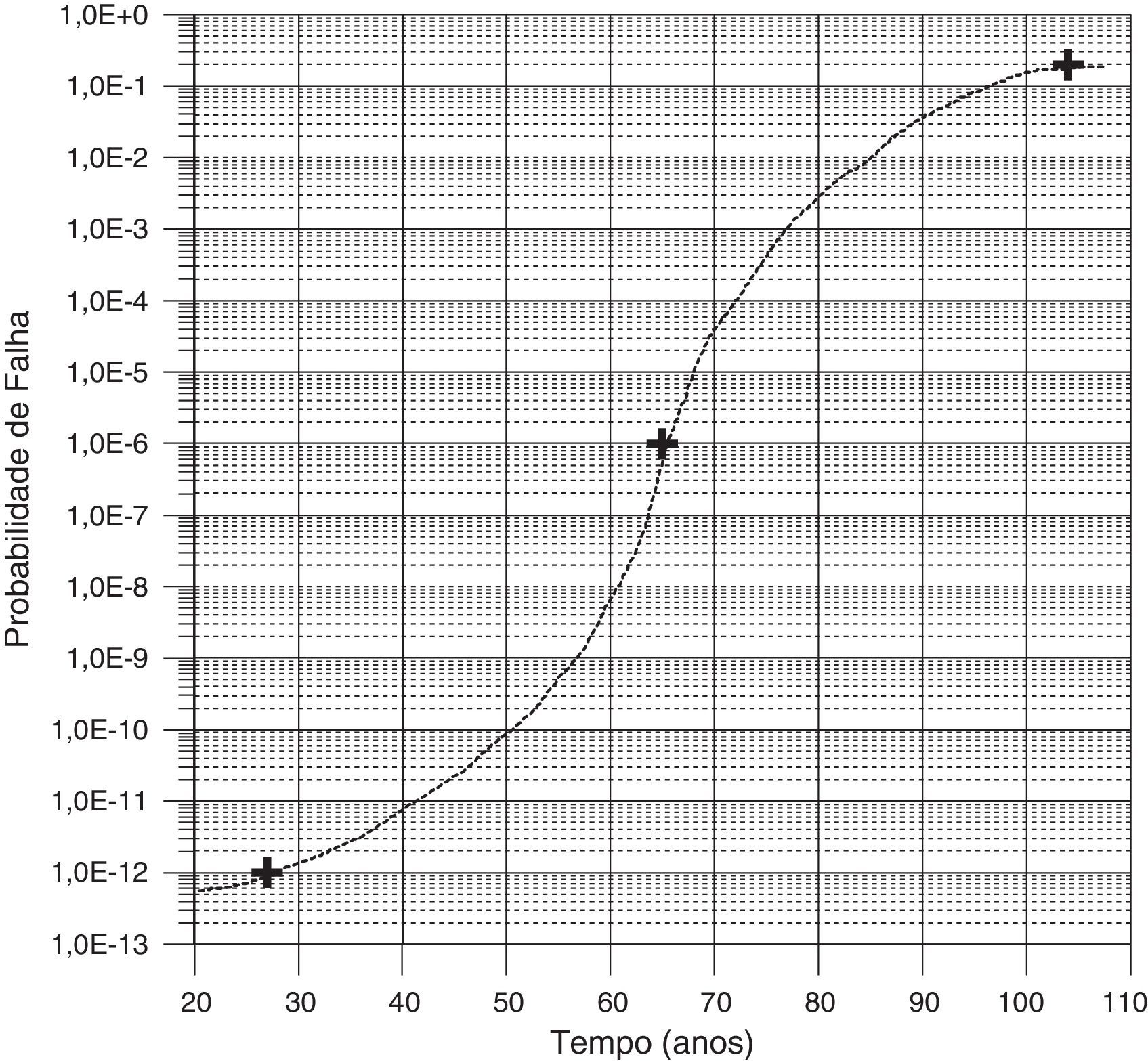

É usada uma estrutura de concreto armado simples (viga de concreto armado, simplesmente apoiada e com carregamento uniforme) para ilustrar este procedimento. A figura 4 mostra um esquema da estrutura. Alguns outros dados podem ser encontrados em Gomes [22]. Assume-se como vida total útil a idade de 100 anos.

A análise de confiabilidade é feita para uma carga de longa duração, usando a flecha máxima na seção central de (< 2,0×10−2m), esmagamento de qualquer ponto de integração ou divergência do processo de solução como funções de estado limite. Assim, espera-se a avaliação da probabilidade de falha para aquelas idades e para um dado critério de projeto.

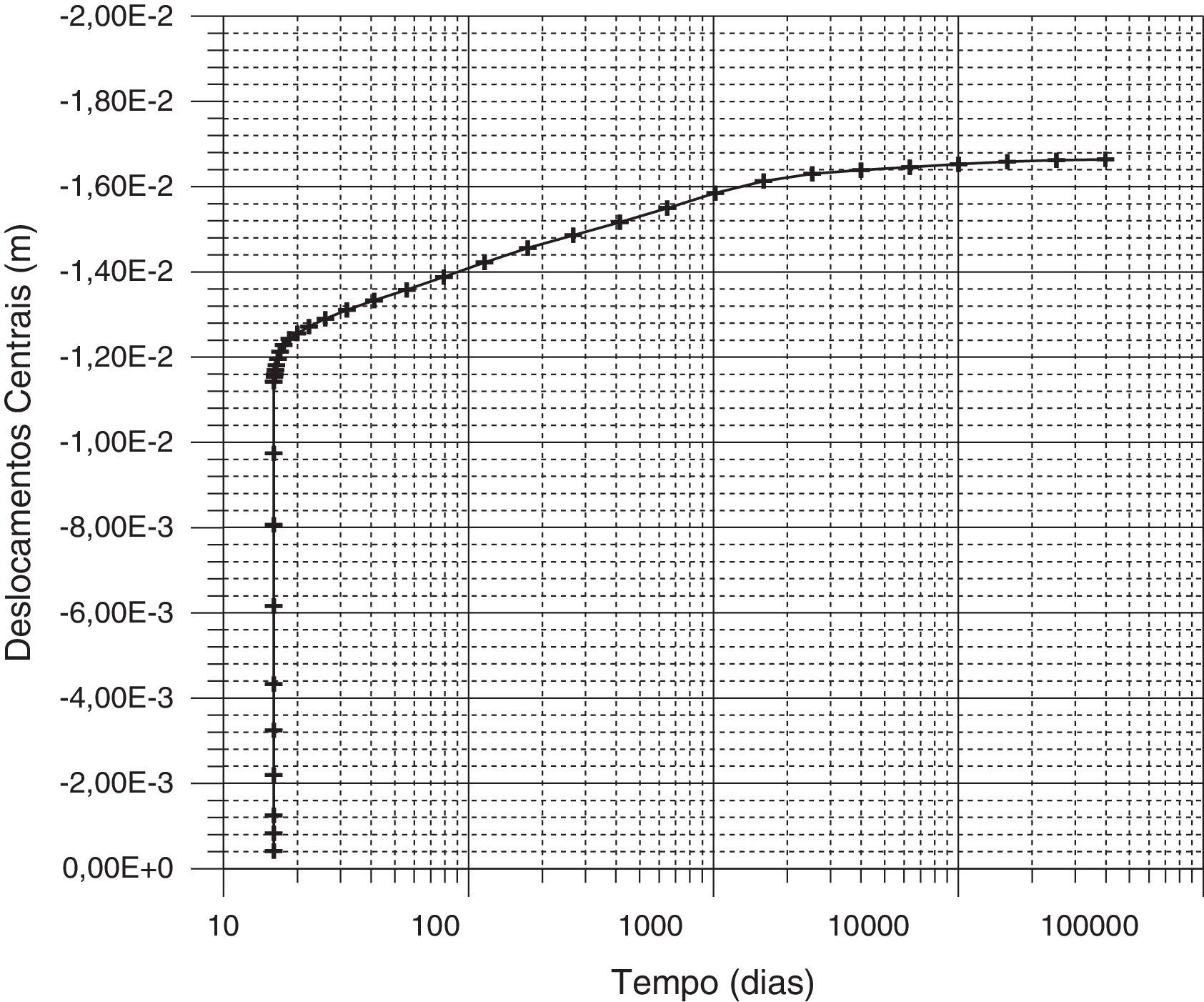

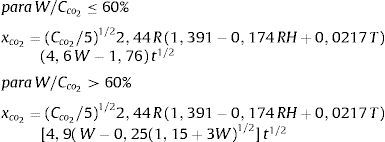

A figura 11 mostra um gráfico de deslocamentos centraisxtempo para 100 anos para o exemplo analisado. Os valores adotados são valores médios.

A figura 12 mostra o gráfico dos deslocamentos centrais no tempo considerando os efeitos da corrosão. Há um aumento nos deslocamentos com o tempo, principalmente após 27 anos (10 000d), quando então a frente de carbonatação atinge as armaduras.

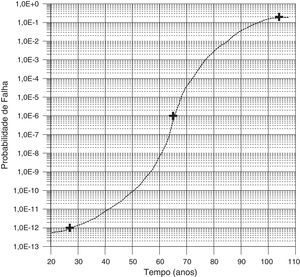

Levando-se em conta a tabela 5, pode-se assumir, por exemplo, para efeitos de comparação, o valor β=3,0, o qual corresponde a uma probabilidade de falha (estado limite de serviço) de Pf=0, 001 (uma hipótese em 1 000).

Um gráfico é feito com a probabilidade de falha vs. tempo com resultados numéricos nas idades de 27 anos, 50 anos e 100 anos, interpolando os valores intermediários é indicado na figura 13. O gráfico elaborado para esta estrutura, o qual foi projetado sob certo critério e sujeito ao processo de deterioração, permite a seguinte conclusão: se a estrutura não experimentar nenhum tipo de manutenção, recuperação ou reparo, na idade de aproximadamente 80 anos, a sua probabilidade de falha limite (0,001, o que equivale a um índice de confiabilidade igual a 3,0) será atingida. Após esta idade, a estrutura pode ser assumida como insegura para este critério de segurança.

6ConclusõesNeste trabalho foi apresentada a análise de confiabilidade para estruturas simples de concreto armado, a qual pode incluir campos estocásticos, efeitos de longa duração e corrosão de armaduras.

Em relação a campos estocásticos, foi apresentado um exemplo simples em que se pode concluir que a representação espectral com série de cossenos inclui vantagens em relação aos outros métodos na representação do campo e em tempo de CPU, especialmente quando se trata de problemas em que um grande número de amostras do campo necessita ser gerado.

Foi apresentado um exemplo para estudar a confiabilidade numa estrutura com cargas de curta duração, seguindo-se uma metodologia probabilística. Foi realizado um estudo da influência do comprimento de correlação na probabilidade de falha, verificando-se o quanto o índice de confiabilidade diminui à medida que o comprimento de correlação aumenta, mostrando a importância deste nas avaliações da segurança de estruturas de concreto. Foi também observado que, em estruturas com um campo aleatório para o módulo de Young onde se leva em conta a simetria de cargas, geometria e condições de contorno na discretização, os índices de confiabilidade são menores do que os obtidos quando se discretiza a totalidade da estrutura. No caso do cálculo de confiabilidade quando não é considerado um campo estocástico (o que significa uma correlação total ou comprimentos de correlação tendendo a infinito), os resultados são mais conservadores do que aqueles com algum tipo de correlação.

Foi estudada uma viga de concreto armado levando em conta efeitos de longa duração aplicando a teoria de solidificação apresentada por Bazant [5], verificando-se como o índice de confiabilidade diminui devido a este efeito em relação ao valor calculado com cargas instantâneas.

Como último exemplo, foi analisada a mesma viga que no caso anterior para o caso em que o efeito da corrosão de armaduras seja levado em conta. Neste caso, ao contrário dos outros exemplos, foi utilizado o método de Monte Carlo com amostragem por importância como método de análise de confiabilidade. Estudando um período de 100 anos, verificou-se que existe um aumento nos deslocamentos no tempo, especialmente após os 27 anos, que é o tempo em que a frente de carbonatação atinge as armaduras e se inicia o processo de corrosão. Foi apresentado um gráfico da probabilidade de falha vs. tempo, estimando-se o tempo em que a estrutura se torna insegura (em função de um determinado critério de projeto-índice de confiabilidade) se não for realizado nenhum tipo de manutenção, recuperação ou reparo.

Logicamente que podem ser adicionadas algumas ferramentas para melhorar o projeto, como, por exemplo, o emprego de métodos de otimização estrutural e redes neurais artificiais para aceleração do processo de cálculo; entretanto, estes recursos poderão posteriormente avaliados.

Por último, salienta-se que devam ser feitos estudos de confiabilidade levando em consideração estas incertezas intrínsecas que estão presentes neste tipo de material (geométricas, propriedades do material e de modelamento do comportamento estrutural), assim como no seu processo de fabricação, não só em análises individuais, como a apresentada aqui, como também diretamente nos códigos e normas que regem o processo de cálculo destes materiais.

Os autores desejam agradecer ao Conselho Nacional de Pesquisas (CNPq) pelo seu apoio financeiro na realização deste trabalho.