Analizar el proceso de evaluación de comunicaciones presentadas al Congreso de SECA celebrado en 2006 para contribuir a su mejora continua y presentar sus resultados científicos.

Material y métodosDiseño: estudio descriptivo. Evaluación de las comunicaciones por 11 parejas de evaluadores mediante criterios explícitos puntuables y cuestionario estructurado. Población: todas las comunicaciones recibidas. Proceso: selección de comunicaciones según decisión concordante de las parejas de evaluadores. Las discrepancias fueron reevaluadas por una terna de evaluadores. Para la adjudicación de premios todos los evaluadores reevaluaron las comunicaciones propuestas que no mostrasen discrepancias de puntuación mayores de 25 puntos. La presentación de las comunicaciones seleccionadas fue revisada por un jurado seleccionado al efecto que contaba con una guía de evaluación expresamente diseñada. La satisfacción de los congresistas fue evaluada mediante cuestionario anónimo.

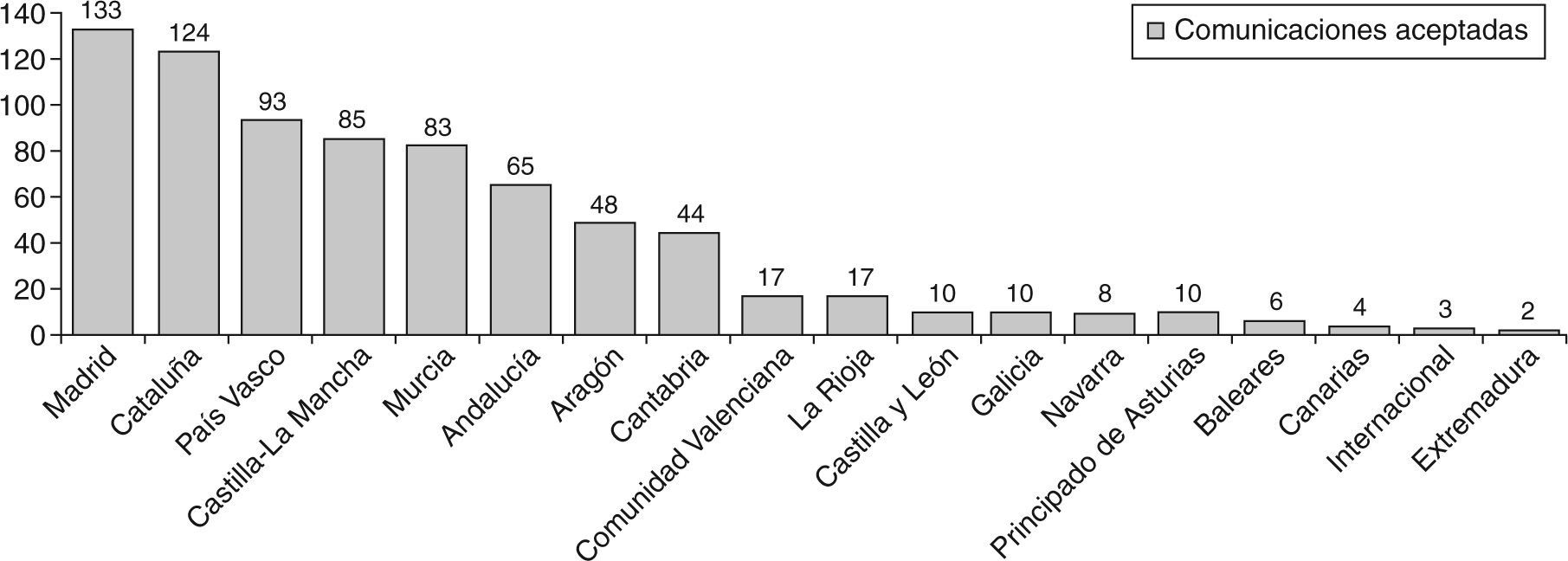

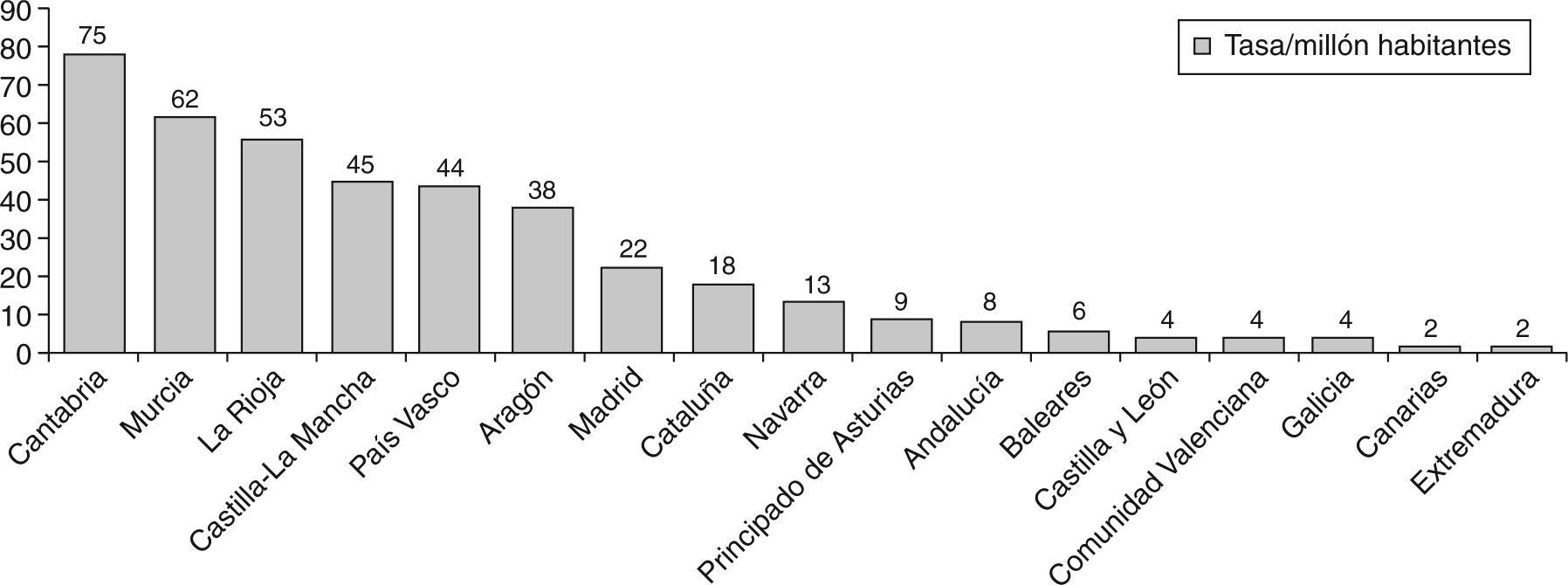

ResultadosSe recibieron 849 comunicaciones. Cada evaluador evaluó una media de 79 (puntuación media, 56 puntos). Fueron aceptadas 762 (89,7%), el 56,8% en formato póster. En números absolutos, el mayor número de comunicaciones procedió de Madrid (133) y Cataluña (124). Ajustado por millón de habitantes, destacan Cantabria y Murcia.

ConclusionesLa evaluación de comunicaciones es un proceso metodológicamente complejo y, a pesar de las medidas correctoras introducidas en los últimos años, continúa siendo mejorable, condicionado por la necesidad de limitar la extensión de las comunicaciones a evaluar y de compatibilizar con la gestión de tiempos en la organización del Congreso. Las aportaciones científicas al Congreso mantienen la tendencia ascendente; su sede representa una oportunidad territorial para impulsar trabajos de calidad.

To analyze the process of evaluating abstracts in the 2006 National Quality in Healthcare Conference in order to contribute to its continuous improvement, and to present its main scientific results.

Material and methodsDesign: descriptive study. 11 pairs of reviewers using explicit criteria evaluated abstracts. Population: all the abstracts received. Process: abstracts were accepted/rejected according to reviewers’ concordant decisions. Disagreements were re-evaluated by 3 reviewers. Accepted abstracts were organized and distributed in the Conference according to the following criteria: total amount, available room and time, number of reviewers. The abstracts nominated for awards and which did not have discrepancies higher than 25 points were re-evaluated by all the reviewers. Their presentations in the Conference were also reviewed by a panel of judges created for this purpose, according to an evaluation guide.

Results849 communications were received. Each reviewer evaluated a mean of 79 communications, obtaining an average score of 56 points. 762 communications were accepted (89.7%), 56.8% of them as a poster. Madrid (133) and Catalonia (124) had the highest amount of presentations in the Conference, but Cantabria and Murcia obtained the highest rates per million inhabitants.

ConclusionsDespite the recently introduced changes, evaluating abstracts is a complex methodological process that still can be improved. It is conditioned by the need for limiting the extension of oral presentations and Conference time management. The scientific contribution to the Conference keeps rising. Its venue represents a geographic opportunity to encourage quality works.

Desde la constitución de la Sociedad Española de Calidad Asistencial (SECA), y tras una experiencia de 23 reuniones científicas, se ha avanzado en madurez y capacidad de convocatoria, como lo demuestra el hecho de los casi 1.000 congresistas que han acudido a su última edición. Paralelamente, las expectativas y necesidades de sus asistentes también han progresado para demandar, tal y como indican los resultados de las encuestas de satisfacción recogidas, máxima calidad científica y eficacia organizativa.

Analizar, revisar y evaluar los procesos implicados en la organización de una reunión científica es una fuente de incalculable valor para su mejora continua y un excelente y necesario punto de partida para rediseñar el proceso con vista a sus futuras ediciones. Esto es precisamente lo que la SECA ha venido haciendo desde hace años1-6.

El diseño del programa científico es responsabilidad del Comité Científico del Congreso y, sin duda, una de las actividades estrella a la hora de juzgar el éxito obtenido. Asimismo, tiene un proceso, el de la gestión de las comunicaciones remitidas, con un componente de máxima trascendencia: la relación directa entre un cliente que solicita un modo de participación activa en el evento con el necesario papel evaluador de un comité, que tiene que juzgar la calidad e idoneidad de un trabajo que representa el esfuerzo de un buen número de profesionales y de recursos. Engloba, entre otras actividades, la recepción, la evaluación y la decisión sobre su aceptación y modo de exposición, así como la valoración de las merecedoras de premios del congreso, lo que exige la máxima transparencia, objetividad, fiabilidad y rigor metodológico.

Con este estudio se pretende describir y analizar estas actividades con el fin de contribuir a la mejora continua de este proceso, así como presentar los resultados científicos del Congreso de SECA celebrado en Toledo en octubre de 2006.

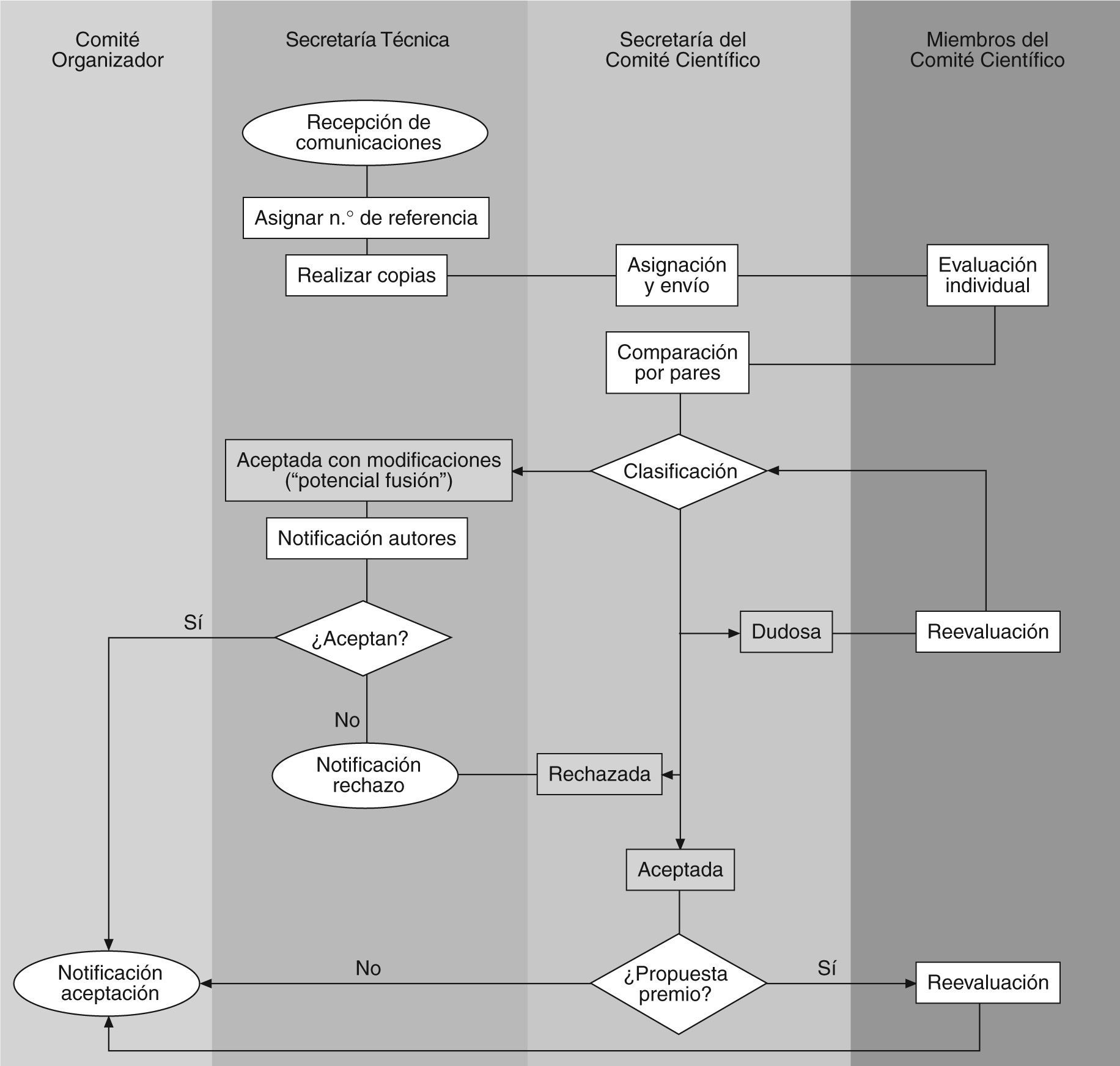

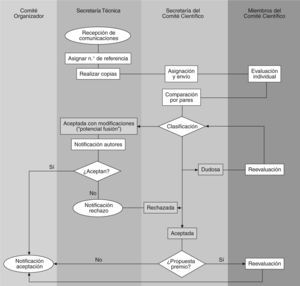

Material y métodosEstudio descriptivo del proceso seguido para la definición del programa científico, así como para la evaluación de las comunicaciones remitidas para su presentación en el Congreso SECA 2006; se utilizó, como fuentes, la base de datos oficial de comunicaciones del Comité Científico y los formularios de evaluación remitidos por sus 21 miembros. La figura 1 muestra el flujograma general del proceso.

Para la definición del programa científico se tomó como base su organización temporal, que consiste en 4 días de duración con una distribución de talleres, conferencias, sesiones plenarias, sesiones de comunicaciones orales y defensa de póster.

Para el diseño del programa científico y con el objetivo de hacer partícipe a todo el comité, se solicitó a los miembros del Comité Científico sugerencias sobre los temas a incluir, en sucesivas rondas, mediante correo electrónico. El proceso se inició con la constitución del Comité en Cádiz durante la celebración del XXIII Congreso; el programa quedó elaborado en el primer trimestre de 2006, y conformado con 7 talleres, 2 conferencias y 5 sesiones plenarias, con 15 ponencias y 4 comunicaciones elevadas a mejores experiencias.

Recepción y evaluación de los trabajos científicosLos 21 miembros del Comité Científico se agruparon en parejas de evaluadores, de los que un miembro debía ser un profesional de reconocida experiencia en el desempeño de estas tareas (haber participado en el Comité Científico en anteriores ediciones del congreso, ser revisor de la Revista de Calidad Asistencial o pertenecer a la Junta Directiva de SECA).

Los resúmenes de las comunicaciones, sin los datos de los autores y centros de trabajo para garantizar el anonimato, fueron distribuidos y asignados a las diferentes parejas de evaluadores, procurando que ninguna comunicación enviada desde una determinada comunidad autónoma fuera evaluada por ningún equipo en que uno de sus miembros residiera en esa misma comunidad. Si esto sucedía, el secretario del Comité Científico permutaba la asignación con el equipo inmediatamente posterior hasta que se cumpliera esta condición de asignación. No obstante, y además de tomar esta precaución, los evaluadores debían avisar a la secretaría del comité y abstenerse de evaluar una determinada comunicación en la que existiera conflicto de intereses.

Con el fin de agilizar el proceso y dar repuesta a las incidencias surgidas, se realizó un total de 4 envíos de comunicaciones a las parejas de evaluadores entre el 31 de mayo y el 15 de junio. Para evaluar las comunicaciones se definieron los siguientes criterios:

- −

Diseño. Objetivos explícitos y claramente definidos.

- −

Metodología. Incluye la descripción precisa del método de trabajo y si es adecuada a los objetivos.

- −

Resultados. Claros y precisos, relacionados con los objetivos y el método.

- −

Conclusiones. Claras y derivadas de los resultados.

- −

Valoración global. Es un trabajo original y aporta conocimientos nuevos, que genera debate y estimula la discusión.

Cada uno de estos criterios recibe una valoración de entre 0 y 20 puntos (puntuación máxima posible, 100). Además, cada comunicación fue calificada como: aceptada-rechazada-incierta, presentación oral-póster y si era propuesta por el evaluador para ponencia-premio.

Las comunicaciones preseleccionadas por los evaluadores como candidatas a ponencia (mesa de mejores comunicaciones) o a premio del congreso fueron reenviadas a todos los demás evaluadores para su reevaluación. Además, un grupo formado por 3 miembros del Comité Científico reevaluó todos los resúmenes cuyas evaluaciones fueron discordantes entre la pareja de evaluadores en cuanto a aceptación o rechazo y en cuanto a la forma de presentación.

Criterios para organizar y distribuir en tiempo y espacio las mesas de comunicaciones y sesiones de defensa de pósterEn las comunicaciones a póster se han tenido en cuenta los siguientes criterios: número total de póster, número de sesiones de defensa (6) y su tiempo de duración (60, 90 o 120 min), número de evaluadores (5) y minutos disponibles para exposición (6). Asimismo, se han identificado las comunicaciones de un mismo autor para que no coincidiera su presentación en tiempo y se ha procurado que no coincidieran áreas temáticas de orales y póster en las mismas sesiones.

Para las comunicaciones orales: número total de comunicaciones orales, tiempo disponible por sesión plenaria (60, 90 o 120 min), número de salas disponibles (6) y el tiempo disponible para la exposición (8 min). Se han agrupado por salas las comunicaciones de una misma área temática y se han identificado las comunicaciones de un mismo autor para que no coincidiera su presentación en tiempo.

Procedimiento seguido para la adjudicación de premio a las mejores comunicaciones y experienciasEn una primera fase se analizaron todas las propuestas de premio realizadas por los evaluadores y se descartaron aquellas en las que la diferencia de puntuación entre los dos evaluadores era mayor de 25 puntos. Las comunicaciones seleccionadas fueron remitidas nuevamente a todos los miembros del Comité Científico para su reevaluación. Tras esta segunda evaluación y priorización, se seleccionaron las comunicaciones con mayor puntuación.

Se diseñó una guía de ayuda a los evaluadores para la valoración de comunicaciones (oral o póster) que optaban a premios en el Congreso, teniendo en cuenta tanto el contenido de la comunicación como la valoración de la forma en que es presentada en el Congreso. Se designó un jurado de miembros del Comité Científico que asistieron a la presentación de todas la comunicaciones orales propuestas a premio y visitaron todos los póster seleccionados por los miembros del Comité Científico que moderaron las correspondientes sesiones de defensa. En cuanto al premio a la mejor experiencia, se hizo por votación de todo el Comité Científico al finalizar la mesa donde se expusieron.

Evaluación de las encuestas de satisfacciónPara conocer la valoración de los congresistas se utilizaron dos cuestionarios, uno para los talleres y otro para el Congreso. Los cuestionarios eran anónimos con preguntas tipo Likert (5 opciones de respuestas) y abiertas.

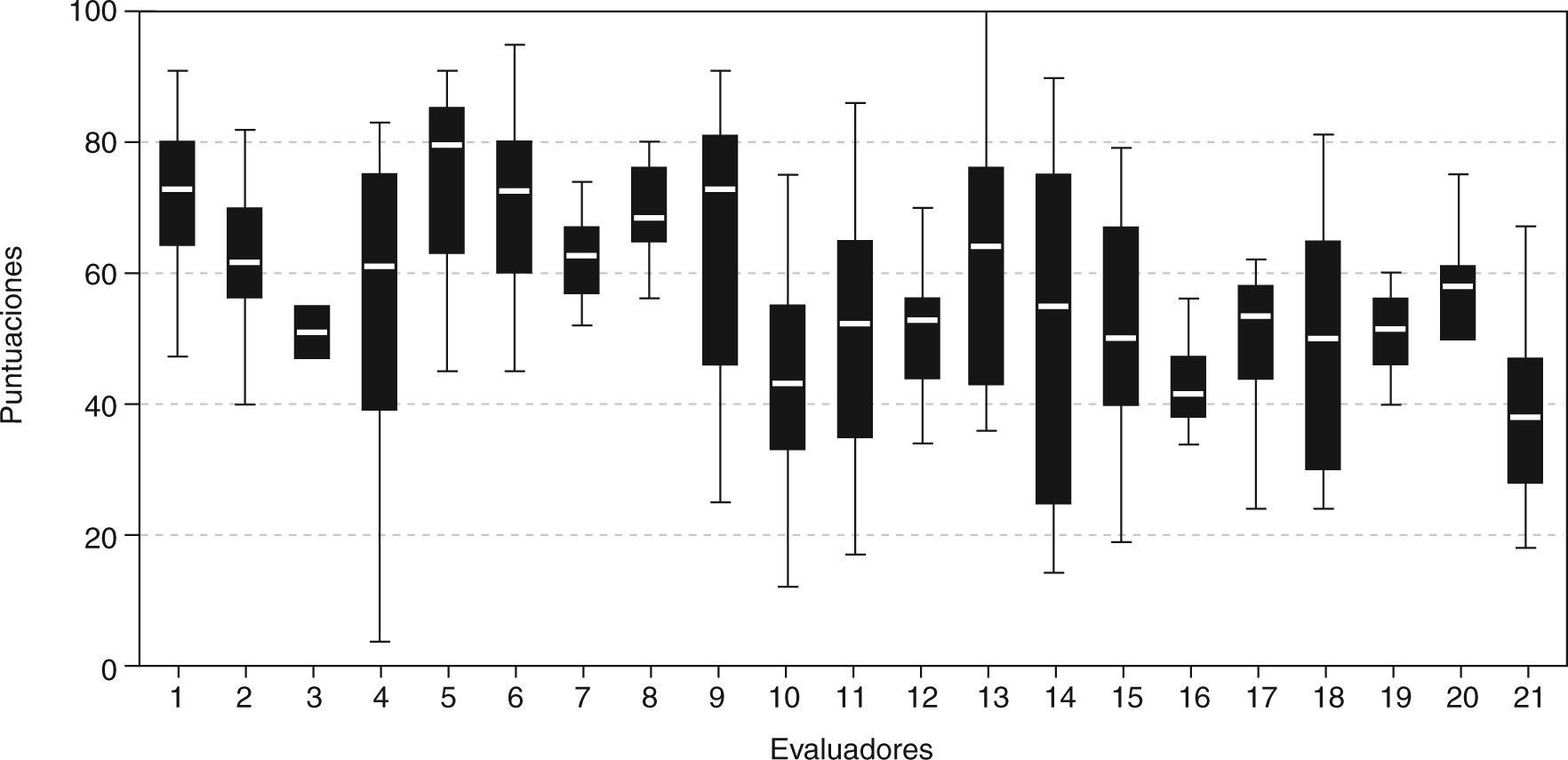

ResultadosEvaluación de los trabajos científicosUna vez finalizado el proceso, los 21 evaluadores valoraron una media de 76 comunicaciones (mediana, 82; máximo, 96; mínimo, 24). Las puntuaciones otorgadas oscilaron entre 100 y 2 puntos (rango, 98) con una media ± desviación estándar de 56 ± 18. La mediana fue de 55 puntos, el percentil (P25) de 44 y el percentil (P75) de 69 puntos. La variación del evaluador y entre los evaluadores se recoge en la figura 2, que refleja los datos para cada evaluador en forma de gráfico de cajas y bigotes.

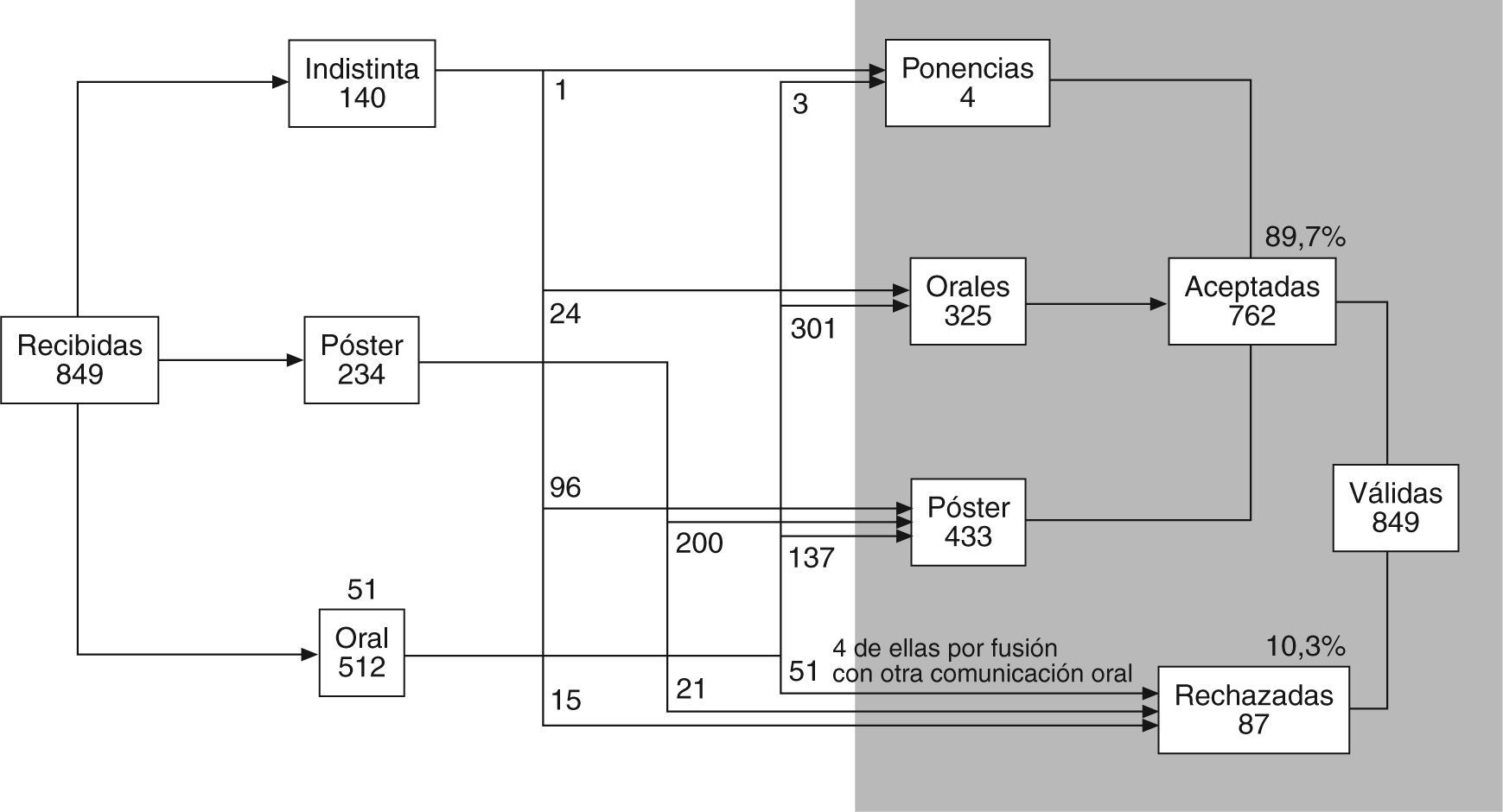

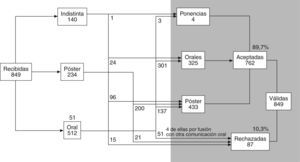

De las 849 comunicaciones recibidas fueron aceptadas 762 (89,7%). El modo de presentación más solicitado fue el oral (512 comunicaciones, 60,3%) seguido del formato póster con 234, así como 140 de presentación indistinta. Finalmente, el formato más frecuentemente aprobado por el Comité fue como póster (433 comunicaciones, 56,8%), lo que implicó que en 137 (18%) ocasiones una comunicación aceptada hubo de ser presentada en forma distinta de la solicitada inicialmente. En la figura 3 se resume el proceso de aceptación y modo de presentación de las comunicaciones.

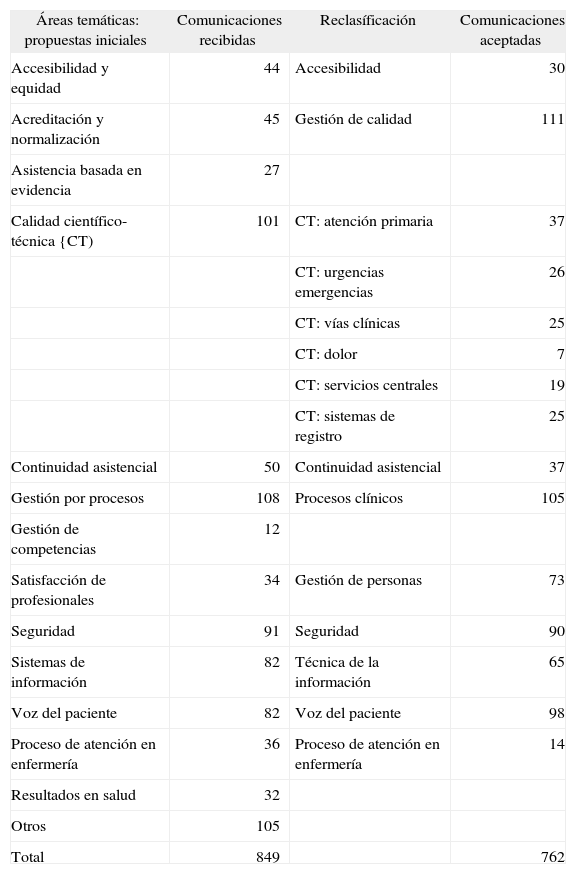

Respecto a la distribución por áreas temáticas, los autores adscribían las comunicaciones que presentaban a una de las 14 áreas temáticas del congreso. Tras el proceso de evaluación, el Comité Científico realizó una reclasificación con el fin de facilitar la organización de su exposición en el congreso, teniendo en cuenta los intereses de los asistentes y las áreas de las comunicaciones aceptadas (tabla 1).

Distribución de las comunicaciones aceptadas por áreas temáticas: propuesta inicial y reclasificación

| Áreas temáticas: propuestas iniciales | Comunicaciones recibidas | Reclasíficación | Comunicaciones aceptadas |

| Accesibilidad y equidad | 44 | Accesibilidad | 30 |

| Acreditación y normalización | 45 | Gestión de calidad | 111 |

| Asistencia basada en evidencia | 27 | ||

| Calidad científico-técnica {CT) | 101 | CT: atención primaria | 37 |

| CT: urgencias emergencias | 26 | ||

| CT: vías clínicas | 25 | ||

| CT: dolor | 7 | ||

| CT: servicios centrales | 19 | ||

| CT: sistemas de registro | 25 | ||

| Continuidad asistencial | 50 | Continuidad asistencial | 37 |

| Gestión por procesos | 108 | Procesos clínicos | 105 |

| Gestión de competencias | 12 | ||

| Satisfacción de profesionales | 34 | Gestión de personas | 73 |

| Seguridad | 91 | Seguridad | 90 |

| Sistemas de información | 82 | Técnica de la información | 65 |

| Voz del paciente | 82 | Voz del paciente | 98 |

| Proceso de atención en enfermería | 36 | Proceso de atención en enfermería | 14 |

| Resultados en salud | 32 | ||

| Otros | 105 | ||

| Total | 849 | 762 |

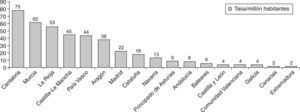

Como se recoge en las figuras 4 y 5, el mayor volumen de comunicaciones aceptadas procedía de la Comunidad Autónoma de Madrid (133) y de Cataluña (124), aunque, tras el cálculo de la tasa por millón de habitantes, Cantabria (78) y Murcia (62) obtuvieron las cifras más elevadas. La comunidad sede del congreso, Castilla-La Mancha, con 85 comunicaciones, obtuvo una tasa de 45 por millón, muy superior a la de los últimos años.

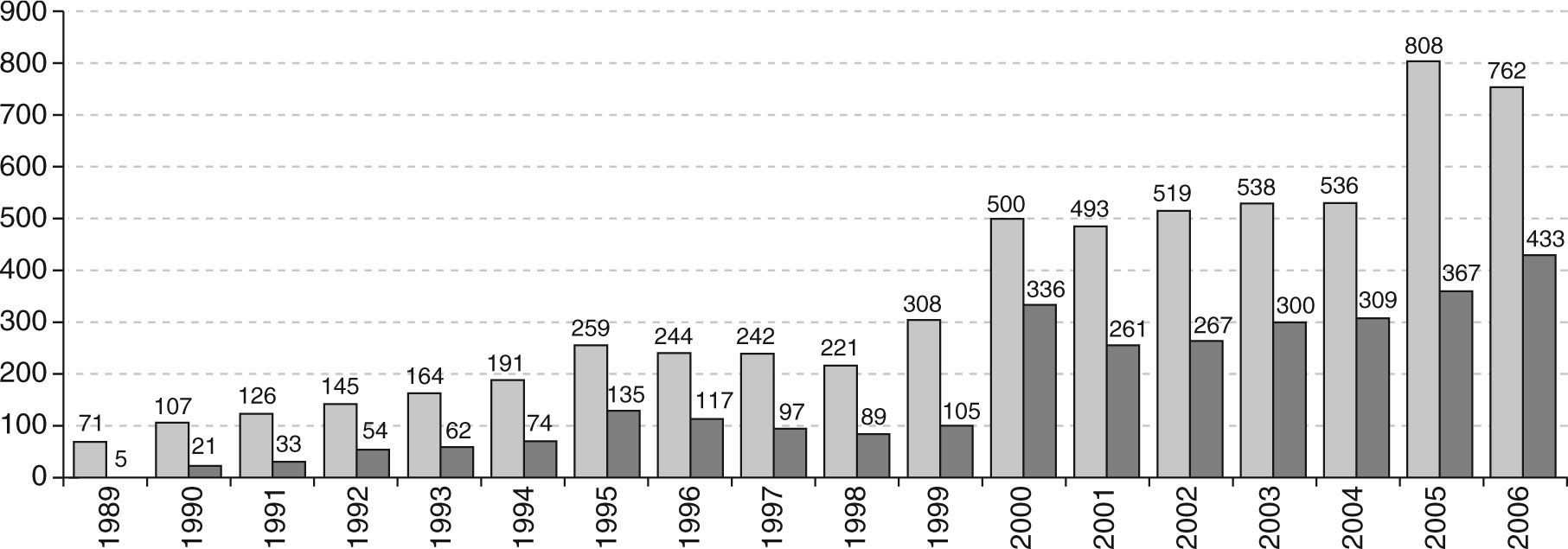

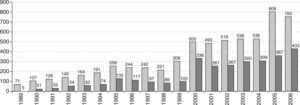

La evolución del número de comunicaciones aceptadas en los congresos de la Sociedad Española de Calidad Asistencial desde 1989 hasta 2006 se muestra en la figura 6. Estos datos están influidos por la alta variación de los grados de rechazo en los diferentes congresos.

Adjudicación de premio a las mejores comunicaciones y experienciasEn una primera fase se seleccionaron 24 comunicaciones para su reevaluación. Tras ésta se priorizaron las 11 con mayor puntuación, de las que las 4 primeras fueron propuestas para la sesión de mejores experiencias, y las 7 restantes quedaron como candidatas al premio a la mejor comunicación oral.

Evaluación de las encuestas de satisfacciónTalleres: se cumplimentaron 52 cuestionarios. Entre los aspectos mejor valorados destacan la experiencia y la calidad de los ponentes, así como la documentación entregada y la metodología utilizada. Entre las áreas a mejorar destaca la falta de tiempo para los contenidos del taller, así como la necesidad de hacerlo más práctico y con mayor número de ejercicios.

Congreso: tras el análisis de las 95 encuestas que se recogieron cumplimentadas, cabe destacar como cuestiones bien valoradas la organización de las mesas de comunicaciones y el contenido de las conferencias y sesiones plenarias. Entre los aspectos a mejorar se demanda una selección más rigurosa de las comunicaciones orales y de los póster, así como avanzar hacia la acreditación de horas docentes.

DiscusiónCon este trabajo se ha pretendido hacer explícito el proceso y los criterios utilizados para organizar los aspectos científicos del Congreso de Calidad Asistencial y, específicamente, los utilizados para adoptar las decisiones sobre la participación de los trabajos externos recibidos en forma de comunicaciones.

El número de comunicaciones remitidas a los congresos de la Sociedad Española de Calidad Asistencial mantiene un incremento a lo largo de su historia, con un salto importante con el Congreso de 2000, desde el que se mantiene con escasas variaciones hasta que en 2005 se alcanza el techo actual de 808 comunicaciones aceptadas. Los datos están referidos al número de comunicaciones aceptadas, ya que no se dispone de la serie completa del porcentaje de comunicaciones rechazadas en cada uno de los congresos. De las 849 comunicaciones recibidas para el Congreso de Toledo, se ha rechazado un 10%, con un total de 762 comunicaciones aceptadas.

La evaluación de las comunicaciones es un procedimiento metodológicamente complejo y, desde nuestro punto de vista y a pesar de los cambios introducidos en los últimos años, continúa siendo un proceso mejorable. Las medidas correctoras introducidas en relación con el anonimato de los evaluadores, la transparencia de las puntuaciones, la utilización de criterios explícitos y la mejora en participación y democratización de la toma de decisiones no han terminado de resolver los problemas inherentes a este tipo de evaluación. Así, las limitaciones debidas al número máximo de caracteres impuesto a los autores para la elaboración del resumen genera que, con frecuencia, un gran número de ellos no lleguen a contener los elementos suficientes que permitan a un evaluador externo valorar la dimensión real del trabajo. Una buena prueba de las oportunidades que tenemos se desprende de la variación de los resultados en la aplicación de los criterios por los evaluadores del Comité Científico.

Por otra parte, las diferentes etapas del proceso de organización del congreso, desde la finalización del plazo de presentación de comunicaciones, con la necesaria información a los interesados sobre la aceptación o el rechazo de las comunicaciones y la gestión de los tiempos de impresión del Libro de Ponencias y Comunicaciones, suponen nuevos obstáculos añadidos para establecer planes de mejora en el proceso.

Otro aspecto en el que es necesario avanzar es en la definición del subproceso de premios. Las dificultades mencionadas para evaluar las comunicaciones son compartidas en el momento de preseleccionar las que pueden optar a alguno de los premios del Congreso. Las incertidumbres en la selección de las mejores experiencias se intenta controlarlas mediante el contacto directo con los autores y, cuando es posible, con la solicitud de ampliación de información. Esta medida, sin embargo, no es posible ponerla en marcha para los demás candidatos a otros premios, por los problemas de tiempos ya mencionados.

También se ha ido realizando un esfuerzo progresivo para organizar la presentación de las comunicaciones orales agrupadas de forma temática para facilitar a los congresistas la posibilidad de asistir al mayor número posible que sean de su interés. Para esta organización la principal dificultad está relacionada con la disponibilidad de salas y espacios temporales dentro del cada vez más apretado programa del Congreso. La defensa de los póster también es un asunto no bien resuelto, porque no hay un procedimiento explícito, consensuado y conocido para realizarla, lo que genera una importante variación que, unido a la dificultad organizativa de asignar horas específicas para la defensa del póster dentro del horario de la sesión prevista, contribuye a un bajo grado de satisfacción de los congresistas con esta actividad. La conveniencia de defender el póster es obvia, pero necesitamos mejorar la forma de llevarla adelante.

Otro tema importante, como se ha visto en esta y en anteriores ediciones del Congreso, es la oportunidad territorial de la organización del Congreso para impulsar los trabajos de calidad. El espectacular incremento de los trabajos presentados por la comunidad autónoma organizadora debe ser un elemento de incentivación para las comunidades que perciban la necesidad de potenciar las políticas de calidad.

Finalmente, los instrumentos con los que debemos evaluar las impresiones de nuestro cliente se han demostrado insuficientes y sujetos a un necesario e inaplazable estudio de mejora. Los elementos y las dimensiones a evaluar deben ser establecidos de forma que permitan identificar oportunidades de mejora y cuantificar sus grados de satisfacción con mucha mayor concreción y fiabilidad que los actualmente utilizados.

Que la participación en el Congreso de la Sociedad Española de Calidad Asistencial mantiene una tendencia ascendente se ve confirmada con los resultados expuestos. Ha pasado a la mayoría de edad por su complejidad organizativa, pero paralelamente debemos exigirnos el máximo nivel en su vertiente científica. Sobre todo porque es donde nuestro cliente se siente como verdadero protagonista.