Este estudio tiene como objetivo evaluar el poder y tamaño de 8 pruebas de normalidad en la presencia de errores autorregresivos de orden uno y diferentes tamaños de muestra. Para lograr este objetivo se emplean simulaciones de Monte Carlo evaluando las siguientes pruebas: Cramér-von Mises, Anderson-Darling, Lilliefors, Pearson, Shapiro-Wilk, Shapiro-Francia, Jarque-Bera y D’Agostino-Pearson. Los resultados muestran 4 aspectos importantes: primero, el efecto de la autocorrelación sobre el tamaño y el poder de las pruebas es asimétrico. Segundo, el tamaño de todas las pruebas se distorsionan en presencia de autocorrelación fuerte. Tercero, ninguna de las pruebas tiene un mejor poder que las demás. Cuarto, cuando la muestra es pequeña, las pruebas de normalidad estudiadas tienen un poder muy bajo.

The objective of this study is to assess the statistical power and size of 8 normality tests in presence of first-order autoregressive errors and different simple sizes. Using a Monte Carlo experiment, the following tests were compared: Cramér-von Mises, Anderson-Darling, Lilliefors, Pearson, Shapiro-Wilk, Shapiro-Francia, Jarque-Bera and D’Agostino-Pearson. Our results show 4 relevant findings: First, an asymmetrical effect of autocorrelation on the power and size of the tests. Second, the statistical size of all tests is affected by the autocorrelation. Third, none of the tests has greater power than the others. Fourth, the power of the normality test decreases as sample size decreases.

Este estudo tem como objectivo avaliar o poder e tamanho de oito provas de normalidade na presença de erros autorregressivos de ordem um e diferentes tamanhos de amostra. Para alcançar este objectivo empregam-se simulações de Monte Carlo avaliando as seguintes provas: Cramér-von Mises, Anderson-Darling, Lilliefors, Pearson, Shapiro-Wilk, Shapiro-Francia, Jarque-Bera e D’Agostino-Pearson. Os resultados mostram quatro aspectos importantes: primeiro, o efeito da autocorrelação sobre o tamanho e o poder das provas é assimétrico. Segundo, o tamanho de todas as provas distorce-se na presença de autocorrelação forte. Terceiro, nenhuma das provas tem um melhor poder que as demais. Quatro, quando a amostra é pequena, as provas de normalidade estudadas têm um poder muito baixo.

En trabajos econométricos empíricos es común que el investigador se vea en la necesidad de probar si los errores de una regresión provienen de una distribución normal. En este sentido, las pruebas de normalidad son necesarias para saber si es apropiado hacer inferencia sobre los coeficientes estimados de una regresión con muestras pequeñas, para el análisis de la regresión o para crear intervalos de confianza para la proyección de la variable dependiente. En la literatura se encuentran diferentes aproximaciones para probar la normalidad o no de una muestra o de los residuos de una regresión. Por ejemplo, Kilian y Demiroglu (2000) presentan una lista no exhaustiva de casos en los cuales un econometrista estaría interesado en probar la normalidad de los residuos de un modelo estimado. Ahora bien, en los trabajos empíricos se presentan comúnmente 3 procedimientos para determinar la normalidad de una muestra: los gráficos como los histogramas y los gráficos Q-Q, las estadísticas descriptivas como la curtosis y el coeficiente de asimetría y las pruebas formales de normalidad (Razali y Wah, 2011).

Centrando la atención en las pruebas formales de normalidad, se encuentra que estas presentan diferentes formas de acercarse al problema, tales como verificar la curtosis y simetría y compararlas con las de una distribución normal o ejecutar pruebas de bondad de ajuste para verificar el ajuste de la distribución. Estas diferentes aproximaciones al problema implican que las pruebas presentan comportamientos diferentes en su tamaño y poder con el cambio del tamaño de la muestra o cuando la matriz de varianzas y covarianzas de la muestra se aleja de un comportamiento esférico (varianza constante y no autocorrelación).

El desempeño de las pruebas de normalidad tiene una documentación relativamente amplia. No obstante, la mayor parte de los estudios del poder de las diferentes pruebas se realizan bajo el supuesto de que las observaciones son independientes entre sí y mantienen la misma varianza. Por ejemplo, Shapiro, Wilk y Chen (1968) mostraron que la prueba de Shapiro y Wilk (1964) tiene un mejor desempeño que las pruebas de Kolmogorov-Smirnov (Kolmogorov, 1933), por su parte, Cramér-von Mises (Cramér, 1928) y Anderson y Darling (1952) encuentran que la prueba tiene un mejor desempeño cuando la muestra cumple el supuesto de esfericidad. Asimismo, Thadewald y Büning (2007) demostraron que la prueba de Jarque y Bera (1987) tiene un alto poder frente a distribuciones simétricas o ligeramente sesgadas que tengan colas largas y que cumplan el supuesto de esfericidad. Sin embargo, estos autores muestran que cuando la distribución tiene colas cortas es recomendable emplear modificaciones a la pruebas de Cramér-von Mises o Shapiro–Wilk.

Por otra parte, Razali y Wah (2011), empleando simulaciones de Monte Carlo, compararon el comportamiento de 4 pruebas de normalidad: Shapiro y Wilk (1964), Kolmogorov-Smirnov (Kolmogorov, 1933), Lilliefors (1967) y Anderson y Darling (1952). Para lo anterior, los autores diseñaron un experimento en el que se generaban muestras con observaciones independientes y homocedásticas provenientes de 7 diferentes distribuciones y 16 diferentes tamaños de muestras. De esta forma, Razali y Wah (2011) encontraron que la prueba de Shapiro y Wilk (1964) es la que presenta el poder más grande para todas las distribuciones y tamaños de muestras evaluadas.

Referente al estudio de Mbah y Paothong (2014), también realizan un experimento de Monte Carlo para comparar el desempeño de la prueba de Shapiro-Francia con Kolmogorov-Smirnov (Kolmogorov, 1933), Anderson y Darling (1952), Cramér-von Mises (Cramér, 1928), Lilliefors (1967), Shapiro y Wilk (1964), Chi-cuadrado de Pearson (Pearson, 1900), Jarque y Bera (1987) y D’Agostino (D’Agostino y Pearson, 1973). El experimento de Monte Carlo de estos autores implicó generar muestras de 5 distribuciones diferentes y 12 tamaños, cuyas observaciones son independientes y homocedásticas. Dado lo anterior, Mbah y Paothong (2014) encontraron que la prueba de Shapiro-Francia se comporta mejor que las otras 8 empleadas.

A partir de lo anterior, hasta donde llega el conocimiento de los autores del presente artículo, solamente existe un estudio reciente que compara pruebas de normalidad en presencia de errores autorregresivos. Este se refiere al trabajo de Lobato y Velasco (2004) en el que comparan el comportamiento de una prueba sugerida por ellos y la prueba Epps (1987), con un test para curtosis y simetría, para muetras producidas por un proceso autorregresivo de orden 1 (AR(1)). Los autores estudian el tamaño de las 2 pruebas empleando simulaciones de Monte Carlo en las que las muestras provienen de un proceso AR(1) con errores normales y 8 diferentes valores de la autocorrelación entre las observaciones. Lobato y Velasco (2004) encuentran que su prueba presenta distorsiones grandes en el tamaño cuando la muestra es pequeña; no obstante, en ese estudio no se presenta un análisis comparativo con las diferentes pruebas de normalidad, incluyendo la prueba de Jarque y Bera (1980) que considera datos que podrían estar autocorrelacionados y ser heterocedásticos.

En este sentido, el presente estudio tiene la intención de continuar la línea de investigación de Lobato y Velasco (2004), al evaluar el comportamiento de diferentes pruebas de normalidad en la presencia de errores autocorrelacionados. En este se pretende extender los resultados de Lobato y Velasco (2004) en 2 sentidos: primero, se estudia tanto el tamaño de las pruebas como el poder; y segundo, se comparan más pruebas siguiendo a Mbah y Paothong (2014).

Como lo documentan Mbah y Paothong (2014) y Razali y Wah (2011), existen más de 40 pruebas de normalidad. Tal vez la primera de estas fue la propuesta por Pearson (1894) y desde entonces se encuentran en la literatura diferentes tests que intentan aproximarse al problema de identificar si una muestra proviene de una distribución normal o no mediante diferentes vías. De esta forma, las pruebas se pueden clasificar de diferentes maneras; por ejemplo, según Shapiro et al. (1968), se pueden clasificar en tests de distancia (distance tests) y de bondad de ajuste (goodness of fit).

Siguiendo a Mbah y Paothong (2014), en el presente estudio comparativo se emplearán 8 de las pruebas de normalidad más populares en la literatura, recurriendo a las siguientes pruebas de distancia: Cramér-von Mises (Cramér, 1928), Anderson y Darling (1952) y Lilliefors (1967). La prueba Anderson y Darlin emplea el estadístico Cramér-von Mises ponderado por su función de probabilidad acumulada y el test de Lilliefors corresponde a una modificación de la prueba Kolmogorov-Smirnov para el caso en el que los parámetros poblacionales son estimados. Por eso, en el estudio no se incluyó la prueba de Kolmogorov-Smirnov (Kolmogorov, 1933).

Adicionalmente, se consideran las siguientes pruebas de bondad de ajuste: Pearson (1900), Shapiro y Wilk (1964), Francia y Shapiro (1972), Jarque y Bera (1987) y D’Agostino (D’Agostino y Pearson, 1973; D’Agostino, Belanger y D’Agostino, 1990).

Así, el objetivo de este documento es determinar el poder y el tamaño de las 8 pruebas de normalidad antes relacionadas, cuando estas se aplican a residuos estimados a partir de una regresión múltiple por mínimos cuadrados ordinarios (MCO) en presencia de autocorrelación en los errores.

Este documento consta de 3 secciones más. La segunda sección describe el diseño del ejercicio de Monte Carlo para determinar el tamaño y poder de las diferentes pruebas. La tercera sección presenta los resultados del ejercicio. La última sección concluye con unos comentarios finales y las implicaciones prácticas de los resultados.

2Diseño del experimentoAntes de describir el experimento, vale la pena recapitular las 8 pruebas que se evaluarán (nombres abreviados entre paréntesis): i) Cramér-von Mises (CM), ii) Anderson y Darling (1952) (WCM), iii) Lilliefors (1967) (LKS), iv) Pearson (1900) (Chi), v) Shapiro y Wilk (1964) (SW), vi) Francia y Shapiro (1972) (SF), vii) Jarque y Bera (1987) (JB) y viii) D’Agostino (D’Agostino y Pearson, 1973) (K).

Para verificar el comportamiento de las 8 pruebas del estudio se diseñó un experimento de Monte Carlo que se ejecuta empleando el lenguaje estadístico R versión 3.0.1 (R Core Team, 2013). El procedimiento para las simulaciones implica los siguientes pasos. Primero, se genera un vector aleatorizado y de dimensiones T×1 a partir del siguiente proceso generador de datos:

Donde x corresponde al vector de observaciones de una variable fija (no varía entre iteraciones) que es generado a partir de una distribución uniforme entre 0 y 1 y v es el vector aleatorizado de error que es homocedástico y sigue un proceso AR(1), es decir, vt=ρvt−1+εt donde ¿t es un ruido blanco. El segundo paso es estimar la regresión de y en función de [1x] y encontrar el vector de residuos vˆT×1=yT×1−βˆ[1x]. El tercer paso es emplear las 8 pruebas de normalidad seleccionadas para determinar si se puede rechazar la hipótesis nula de que vˆT×1 proviene de una distribución normal. Para cada prueba se guarda la decisión de rechazar o no la hipótesis nula. Estos 3 pasos se repiten 10.000 veces.

El experimento de Monte Carlo se realiza para diferentes distribuciones de υ. Se considera la distribución estándar normal (N[0,1]), la distribución t de Student con 3, 4, 5 y 6 grados de libertad, la distribución Chi-cuadrado con grados de libertad 1, 5, 10, 15 y 20 y una distribución uniforme entre cero y uno (U[0,1]). En total se consideran 6 distribuciones simétricas y 5 asimétricas.

Por otro lado, para cada distribución se consideran diferentes grados de autocorrelación. Específicamente, ρ tomará valores entre −0,9 y 0,9 a una razón de cambio de 0,1; es decir, el vector de coeficientes de autocorrelación será ρ=(−0, 9;−0, 8;⋯;0;⋯0,8;0,9). De esta manera, se tendrá un conjunto de simulaciones con errores autocorrelacionados negativamente (ρ=0), otro conjunto donde no están autocorrelacionados (ρ<0) y un tercero con errores autocorrelacionados positivamente (ρ>0).

Finalmente, para cada combinación de distribución y de ρ se consideran 5 diferentes tamaños de muestra (T); en especial, se tendrá que T=25, 60, 100, 200, 500.

Para el caso en que las simulaciones se realizan sobre errores que siguen una distribución diferente a la normal, el poder de cada prueba se calcula como la proporción de veces que la prueba rechaza la hipótesis nula de normalidad (usando un nivel de significación del 5%)1. Para el caso en que las simulaciones se realicen con errores normales, realizando el mismo procedimiento, se obtiene el tamaño de la prueba (probabilidad de cometer el error tipo I).

3ResultadosEn esta sección se discutirán los resultados de las simulaciones de Monte Carlo, empleando una subsección para cada una de las 4 familias de distribuciones consideradas: distribución normal, distribución t de Student (y los diferentes grados de libertad), la distribución Chi-cuadrado (y los diferentes grados de libertad) y la distribución uniforme.

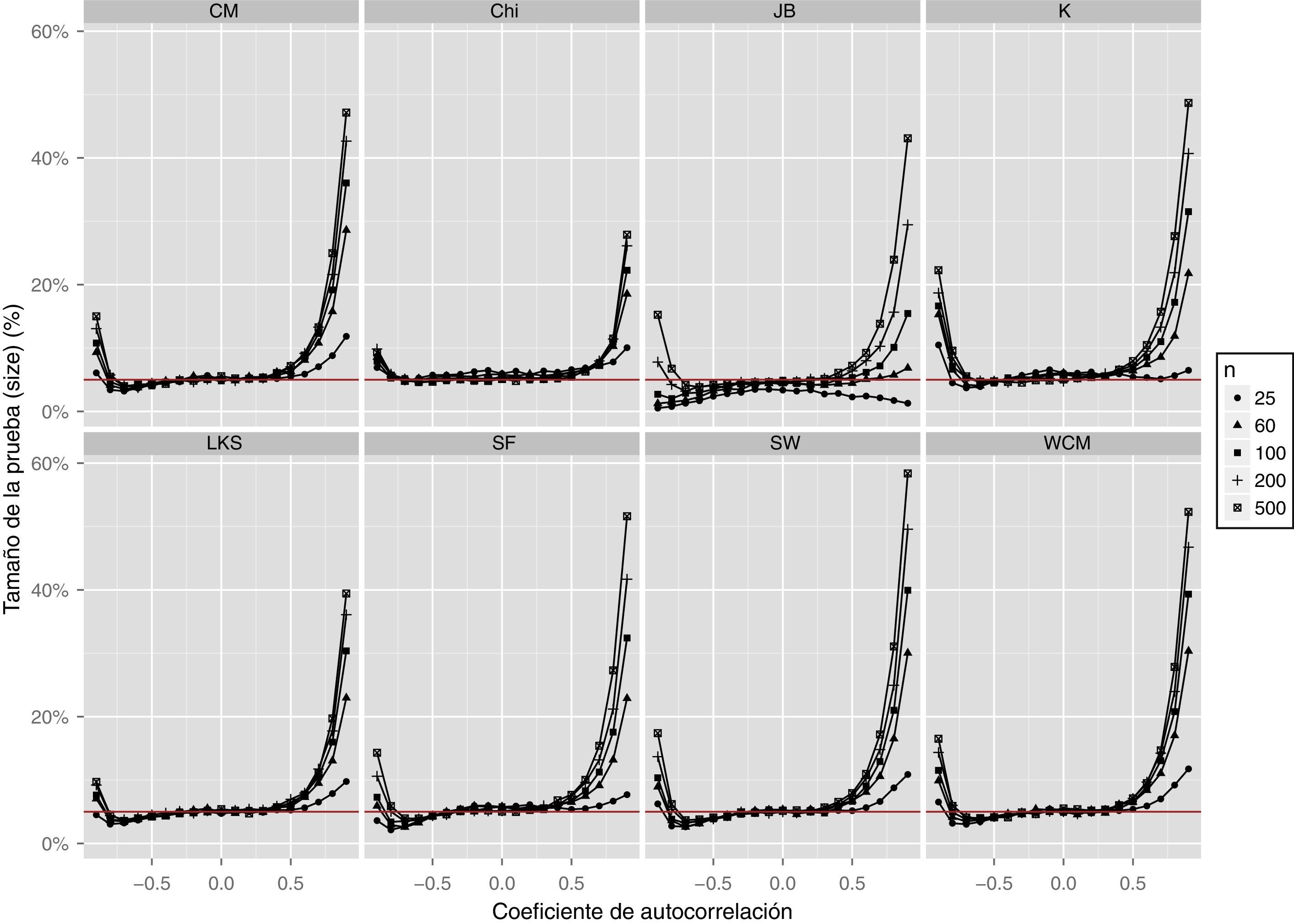

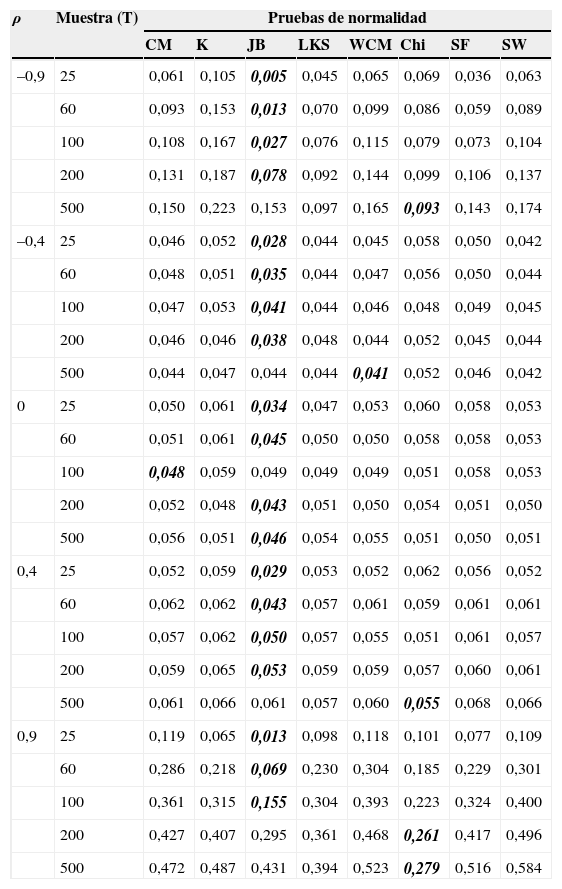

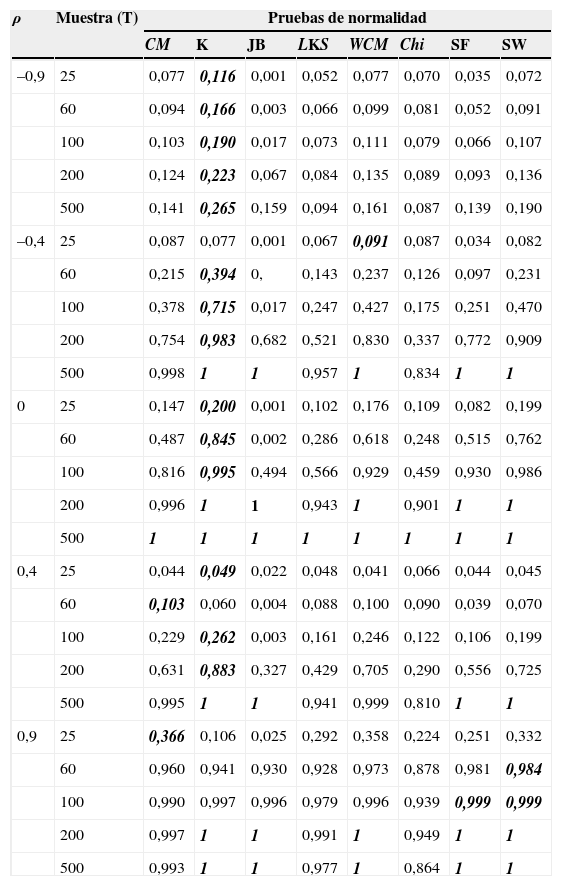

3.1Distribución normalEn el caso en el que los errores provienen de una distribución estándar normal, todas las pruebas presentan un tamaño cercano al nominal (α=0, 05) cuando no hay autocorrelación (ρ=0) y la muestra es relativamente grande (superior a 100) (tabla 1). No obstante, la prueba JB presenta un tamaño levemente más bajo que el nominal cuando la muestra es de tamaño 200. Para el caso de no autocorrelación y muestras pequeñas, se encuentra que con la prueba JB la probabilidad de cometer el error tipo I es menor a 0,05. En general, la prueba JB es la que presenta el menor tamaño para las otras muestras. La prueba K tiene la probabilidad de cometer el error tipo I más grande para muestras de 25 y 60 observaciones. Es decir, la probabilidad de rechazar erróneamente la hipótesis nula de normalidad es más grande que lo teóricamente esperado (α=0, 05). Referente a las demás pruebas, estas presentan un tamaño entre 0,05 y 0,058 que corresponde con el diseño del test (tabla 1).

Tamaño de las pruebas de normalidad

| ρ | Muestra (T) | Pruebas de normalidad | |||||||

|---|---|---|---|---|---|---|---|---|---|

| CM | K | JB | LKS | WCM | Chi | SF | SW | ||

| –0,9 | 25 | 0,061 | 0,105 | 0,005 | 0,045 | 0,065 | 0,069 | 0,036 | 0,063 |

| 60 | 0,093 | 0,153 | 0,013 | 0,070 | 0,099 | 0,086 | 0,059 | 0,089 | |

| 100 | 0,108 | 0,167 | 0,027 | 0,076 | 0,115 | 0,079 | 0,073 | 0,104 | |

| 200 | 0,131 | 0,187 | 0,078 | 0,092 | 0,144 | 0,099 | 0,106 | 0,137 | |

| 500 | 0,150 | 0,223 | 0,153 | 0,097 | 0,165 | 0,093 | 0,143 | 0,174 | |

| –0,4 | 25 | 0,046 | 0,052 | 0,028 | 0,044 | 0,045 | 0,058 | 0,050 | 0,042 |

| 60 | 0,048 | 0,051 | 0,035 | 0,044 | 0,047 | 0,056 | 0,050 | 0,044 | |

| 100 | 0,047 | 0,053 | 0,041 | 0,044 | 0,046 | 0,048 | 0,049 | 0,045 | |

| 200 | 0,046 | 0,046 | 0,038 | 0,048 | 0,044 | 0,052 | 0,045 | 0,044 | |

| 500 | 0,044 | 0,047 | 0,044 | 0,044 | 0,041 | 0,052 | 0,046 | 0,042 | |

| 0 | 25 | 0,050 | 0,061 | 0,034 | 0,047 | 0,053 | 0,060 | 0,058 | 0,053 |

| 60 | 0,051 | 0,061 | 0,045 | 0,050 | 0,050 | 0,058 | 0,058 | 0,053 | |

| 100 | 0,048 | 0,059 | 0,049 | 0,049 | 0,049 | 0,051 | 0,058 | 0,053 | |

| 200 | 0,052 | 0,048 | 0,043 | 0,051 | 0,050 | 0,054 | 0,051 | 0,050 | |

| 500 | 0,056 | 0,051 | 0,046 | 0,054 | 0,055 | 0,051 | 0,050 | 0,051 | |

| 0,4 | 25 | 0,052 | 0,059 | 0,029 | 0,053 | 0,052 | 0,062 | 0,056 | 0,052 |

| 60 | 0,062 | 0,062 | 0,043 | 0,057 | 0,061 | 0,059 | 0,061 | 0,061 | |

| 100 | 0,057 | 0,062 | 0,050 | 0,057 | 0,055 | 0,051 | 0,061 | 0,057 | |

| 200 | 0,059 | 0,065 | 0,053 | 0,059 | 0,059 | 0,057 | 0,060 | 0,061 | |

| 500 | 0,061 | 0,066 | 0,061 | 0,057 | 0,060 | 0,055 | 0,068 | 0,066 | |

| 0,9 | 25 | 0,119 | 0,065 | 0,013 | 0,098 | 0,118 | 0,101 | 0,077 | 0,109 |

| 60 | 0,286 | 0,218 | 0,069 | 0,230 | 0,304 | 0,185 | 0,229 | 0,301 | |

| 100 | 0,361 | 0,315 | 0,155 | 0,304 | 0,393 | 0,223 | 0,324 | 0,400 | |

| 200 | 0,427 | 0,407 | 0,295 | 0,361 | 0,468 | 0,261 | 0,417 | 0,496 | |

| 500 | 0,472 | 0,487 | 0,431 | 0,394 | 0,523 | 0,279 | 0,516 | 0,584 | |

En la tabla se reporta en negrita y cursiva el tamaño de la prueba más bajo para cada muestra. Por ejemplo, se resalta en la primera línea de la tabla el número 0,005 que corresponde al tamaño de la prueba JB, que es el más pequeño entre todas las pruebas cuando se emplean 25 observaciones y un ρ=−0,9.

Fuente: elaboración propia.

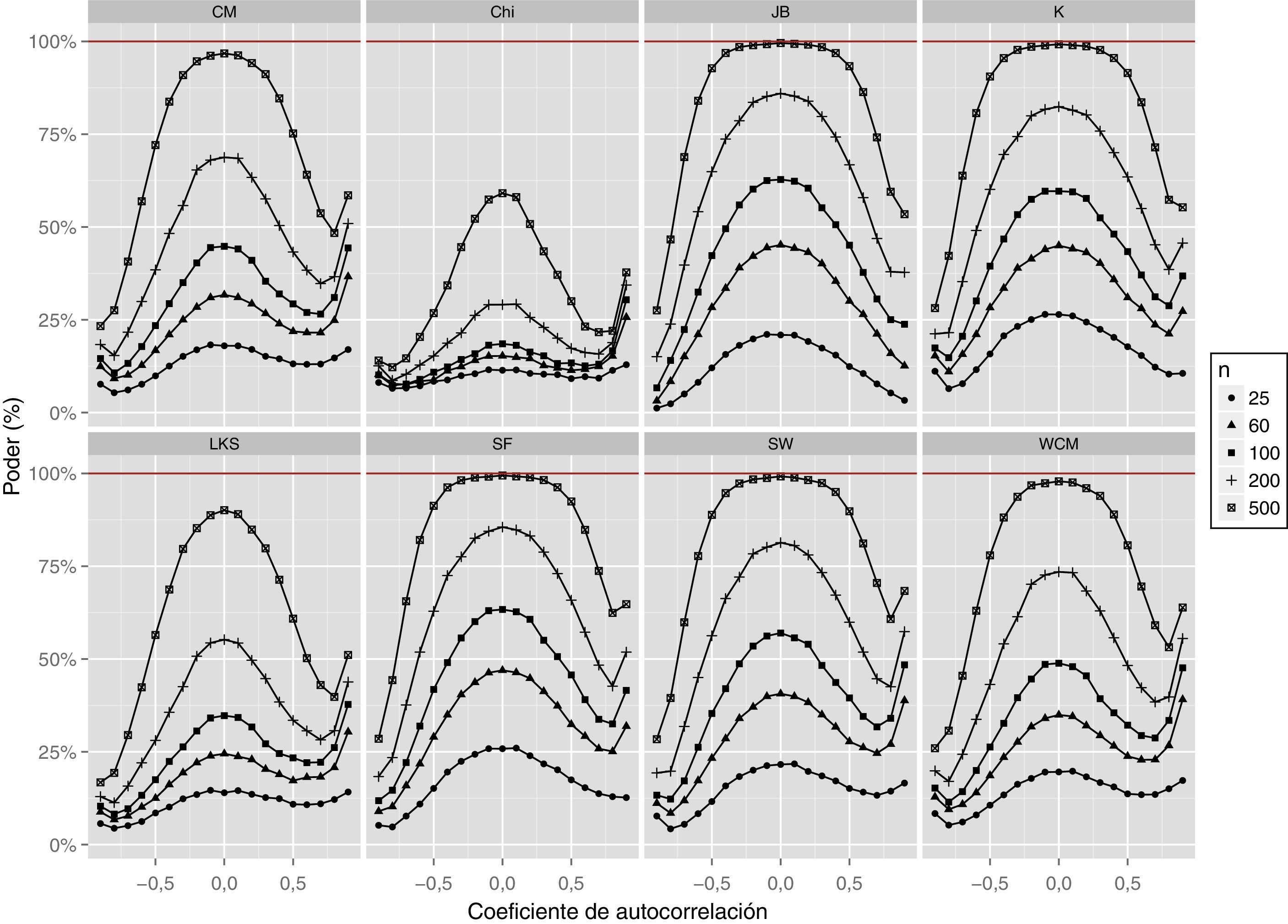

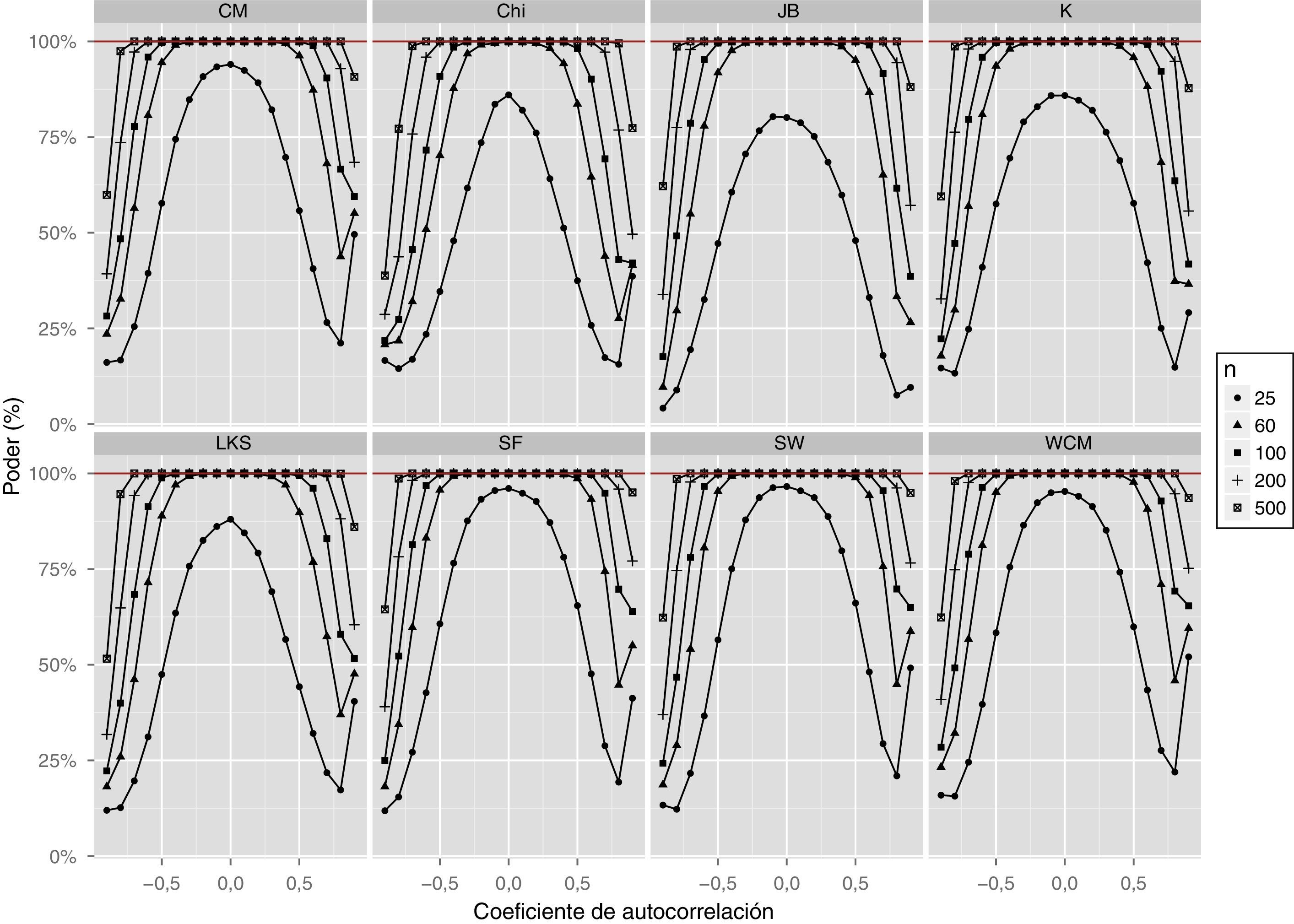

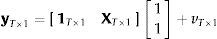

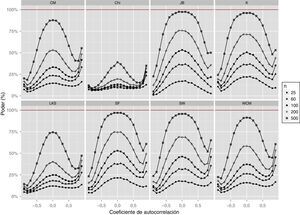

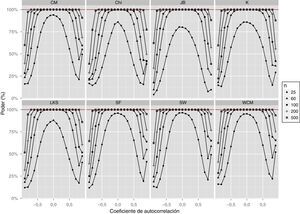

Cuando se presenta una autocorrelación positiva, la probabilidad de rechazar la hipótesis nula de normalidad, siendo esta verdadera, es más grande que el tamaño nominal y que el tamaño que se presenta con la autocorrelación de igual valor absoluto pero con signo negativo; es decir, se presenta una trayectoria asimétrica en el tamaño de la prueba entre el caso de autocorrelación positiva y autocorrelación negativa. Además, el tamaño de la prueba es más grande a medida que aumenta la muestra (tabla 1 y fig. 1).

Cuando la autocorrelación negativa es más fuerte, se observa un resultado similar al caso en el que la autocorrelación es positiva. Sin embargo, el tamaño de las pruebas en presencia de autocorrelación positiva es mayor que cuando existe autocorrelación negativa (tabla 1 y fig. 1). La prueba que presenta una menor distorsión en su tamaño es la prueba JB. No obstante, su tamaño puede llegar a ser de 0,431 en presencia de errores con una autocorrelación positiva muy fuerte (ρ=0, 9). En otras palabras, la probabilidad de cometer el error de rechazar la hipótesis nula cuando es verdadera alcanza el 43,1%, en presencia de autocorrelación positiva fuerte.

Cuando el coeficiente de autocorrelación ρ —en valor absoluto— crece, y la muestra se hace más grande, las pruebas experimentan una gran distorsión en su tamaño. Sin embargo, los resultados muestran que las pruebas mantienen un tamaño relativamente cercano al nominal para el intervalo ρ∈[−0, 5;0, 5].

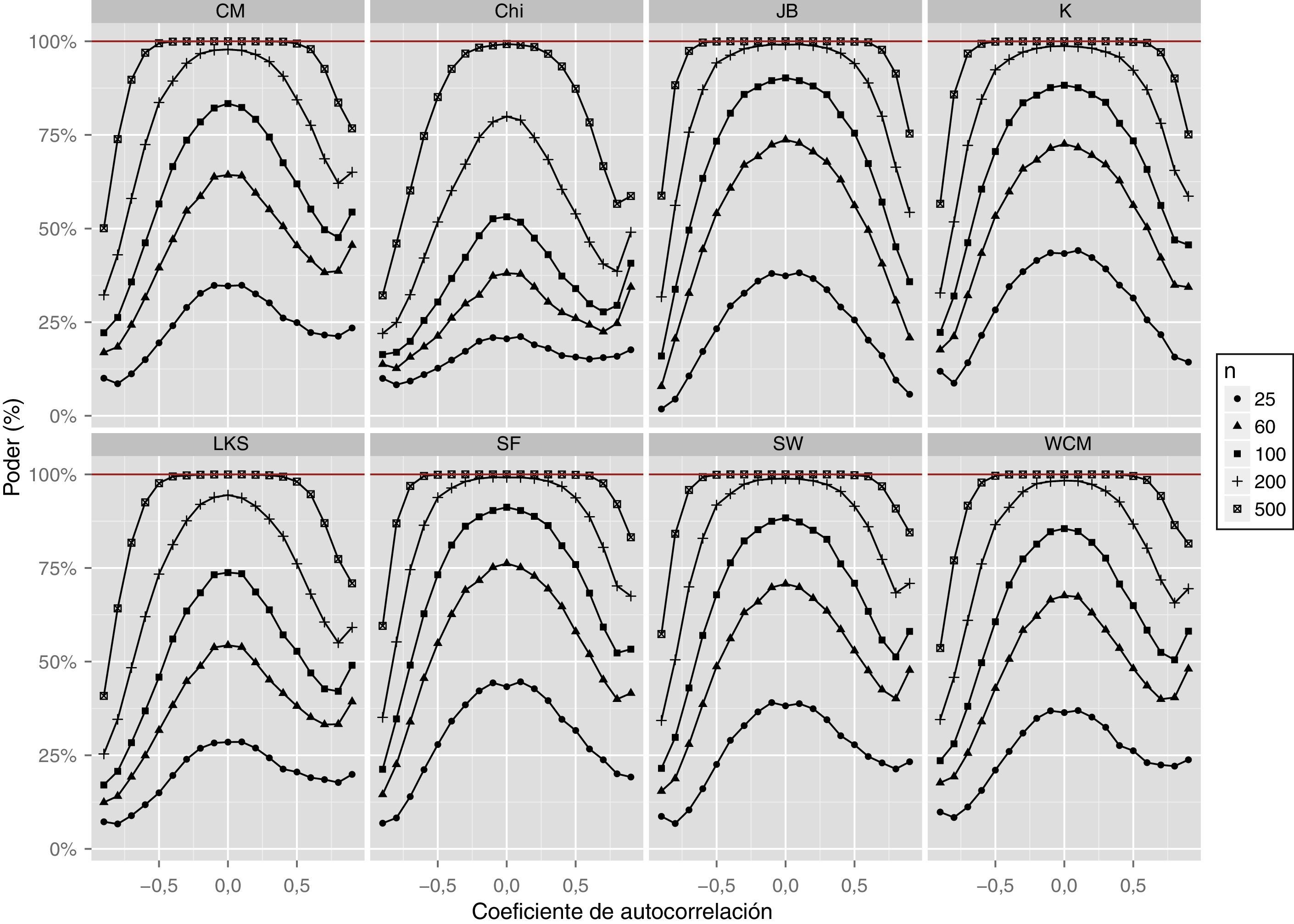

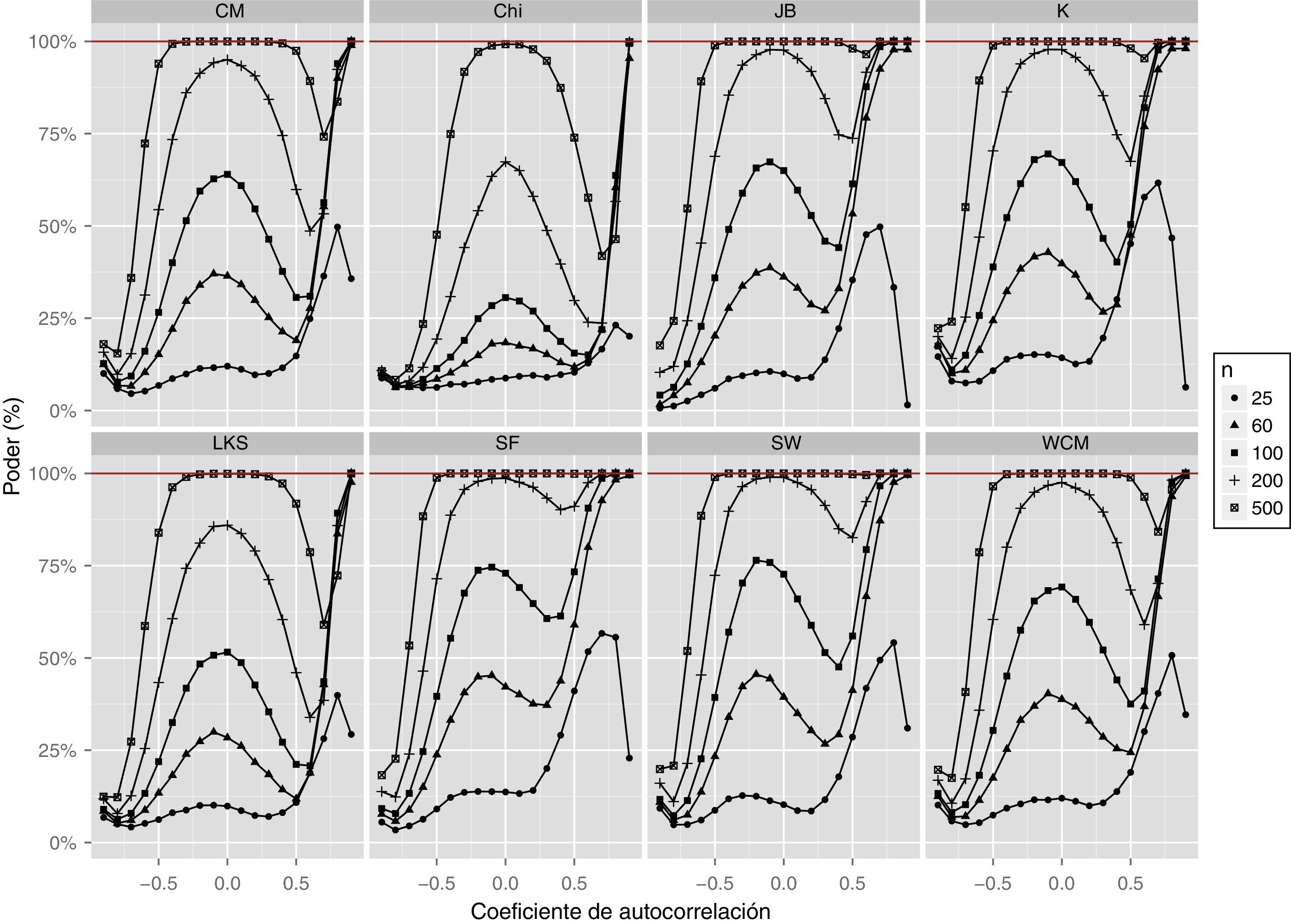

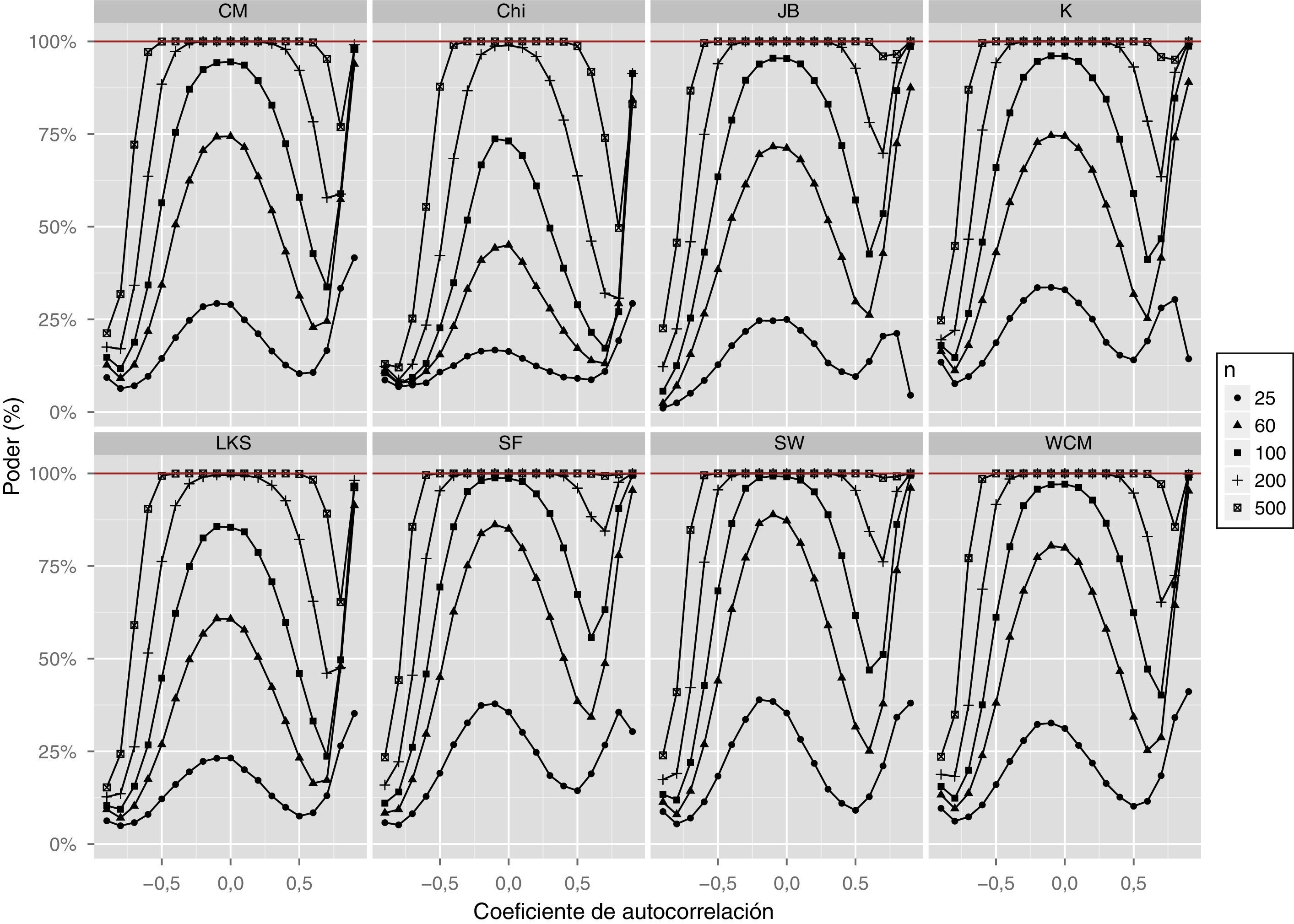

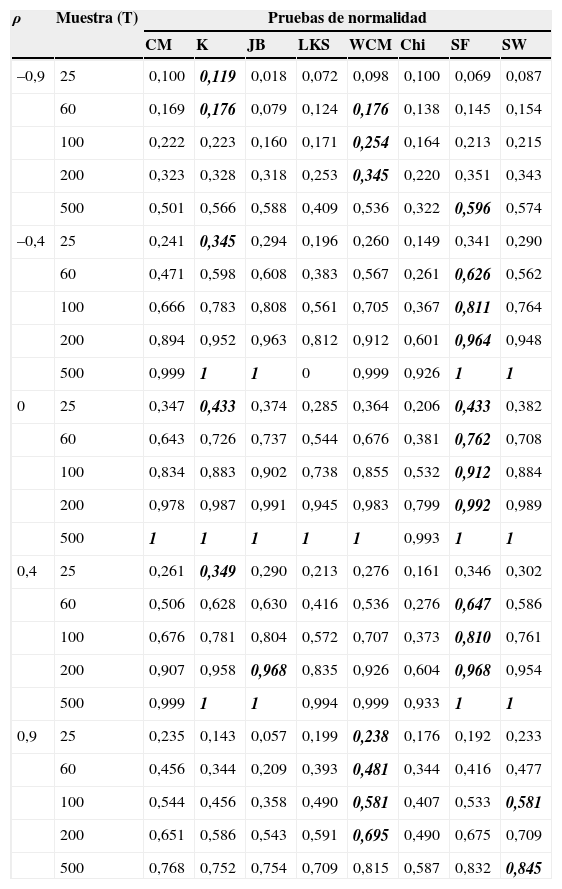

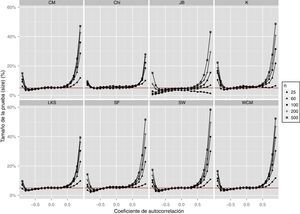

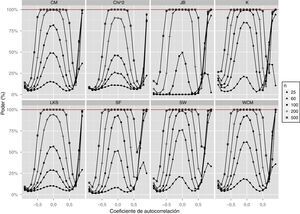

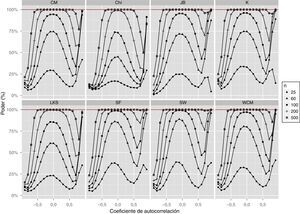

3.2Distribución t de StudentEn la tabla 2 y la figura 2 se reportan los resultados del ejercicio de simulación cuando los errores provienen de una distribución t de Student con 3 grados de libertad. De manera similar, en la tabla 3 y la figura 3 se reportan los resultados cuando los grados de libertad son 6. En general, los resultados muestran que el poder disminuye drásticamente a medida que la autocorrelación se hace más fuerte (ya sea positiva o negativa, es decir, ρ en valor absoluto crece). Asimismo, todas las pruebas muestran una caída en su poder cuando el tamaño de la muestra es relativamente pequeño (25 observaciones).

Poder de las pruebas de normalidad para errores con distribución t3

| ρ | Muestra (T) | Pruebas de normalidad | |||||||

|---|---|---|---|---|---|---|---|---|---|

| CM | K | JB | LKS | WCM | Chi | SF | SW | ||

| –0,9 | 25 | 0,100 | 0,119 | 0,018 | 0,072 | 0,098 | 0,100 | 0,069 | 0,087 |

| 60 | 0,169 | 0,176 | 0,079 | 0,124 | 0,176 | 0,138 | 0,145 | 0,154 | |

| 100 | 0,222 | 0,223 | 0,160 | 0,171 | 0,254 | 0,164 | 0,213 | 0,215 | |

| 200 | 0,323 | 0,328 | 0,318 | 0,253 | 0,345 | 0,220 | 0,351 | 0,343 | |

| 500 | 0,501 | 0,566 | 0,588 | 0,409 | 0,536 | 0,322 | 0,596 | 0,574 | |

| –0,4 | 25 | 0,241 | 0,345 | 0,294 | 0,196 | 0,260 | 0,149 | 0,341 | 0,290 |

| 60 | 0,471 | 0,598 | 0,608 | 0,383 | 0,567 | 0,261 | 0,626 | 0,562 | |

| 100 | 0,666 | 0,783 | 0,808 | 0,561 | 0,705 | 0,367 | 0,811 | 0,764 | |

| 200 | 0,894 | 0,952 | 0,963 | 0,812 | 0,912 | 0,601 | 0,964 | 0,948 | |

| 500 | 0,999 | 1 | 1 | 0 | 0,999 | 0,926 | 1 | 1 | |

| 0 | 25 | 0,347 | 0,433 | 0,374 | 0,285 | 0,364 | 0,206 | 0,433 | 0,382 |

| 60 | 0,643 | 0,726 | 0,737 | 0,544 | 0,676 | 0,381 | 0,762 | 0,708 | |

| 100 | 0,834 | 0,883 | 0,902 | 0,738 | 0,855 | 0,532 | 0,912 | 0,884 | |

| 200 | 0,978 | 0,987 | 0,991 | 0,945 | 0,983 | 0,799 | 0,992 | 0,989 | |

| 500 | 1 | 1 | 1 | 1 | 1 | 0,993 | 1 | 1 | |

| 0,4 | 25 | 0,261 | 0,349 | 0,290 | 0,213 | 0,276 | 0,161 | 0,346 | 0,302 |

| 60 | 0,506 | 0,628 | 0,630 | 0,416 | 0,536 | 0,276 | 0,647 | 0,586 | |

| 100 | 0,676 | 0,781 | 0,804 | 0,572 | 0,707 | 0,373 | 0,810 | 0,761 | |

| 200 | 0,907 | 0,958 | 0,968 | 0,835 | 0,926 | 0,604 | 0,968 | 0,954 | |

| 500 | 0,999 | 1 | 1 | 0,994 | 0,999 | 0,933 | 1 | 1 | |

| 0,9 | 25 | 0,235 | 0,143 | 0,057 | 0,199 | 0,238 | 0,176 | 0,192 | 0,233 |

| 60 | 0,456 | 0,344 | 0,209 | 0,393 | 0,481 | 0,344 | 0,416 | 0,477 | |

| 100 | 0,544 | 0,456 | 0,358 | 0,490 | 0,581 | 0,407 | 0,533 | 0,581 | |

| 200 | 0,651 | 0,586 | 0,543 | 0,591 | 0,695 | 0,490 | 0,675 | 0,709 | |

| 500 | 0,768 | 0,752 | 0,754 | 0,709 | 0,815 | 0,587 | 0,832 | 0,845 | |

En la tabla se reporta en negrita y cursiva el tamaño de la prueba más alto para cada tamaño de muestra. Por ejemplo, se resalta en la primera línea de la tabla el número 0,119 que corresponde al poder de la prueba K, que es el más grande entre todas las pruebas cuando se emplean 25 observaciones y un ρ=−0,9.

Fuente: elaboración propia.

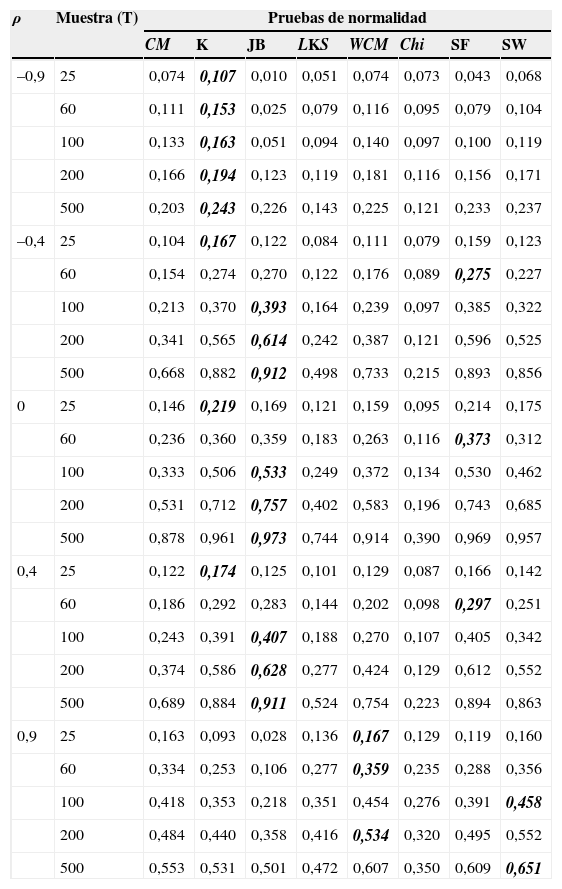

Poder de las pruebas de normalidad para errores con distribución t6

| ρ | Muestra (T) | Pruebas de normalidad | |||||||

|---|---|---|---|---|---|---|---|---|---|

| CM | K | JB | LKS | WCM | Chi | SF | SW | ||

| –0,9 | 25 | 0,074 | 0,107 | 0,010 | 0,051 | 0,074 | 0,073 | 0,043 | 0,068 |

| 60 | 0,111 | 0,153 | 0,025 | 0,079 | 0,116 | 0,095 | 0,079 | 0,104 | |

| 100 | 0,133 | 0,163 | 0,051 | 0,094 | 0,140 | 0,097 | 0,100 | 0,119 | |

| 200 | 0,166 | 0,194 | 0,123 | 0,119 | 0,181 | 0,116 | 0,156 | 0,171 | |

| 500 | 0,203 | 0,243 | 0,226 | 0,143 | 0,225 | 0,121 | 0,233 | 0,237 | |

| –0,4 | 25 | 0,104 | 0,167 | 0,122 | 0,084 | 0,111 | 0,079 | 0,159 | 0,123 |

| 60 | 0,154 | 0,274 | 0,270 | 0,122 | 0,176 | 0,089 | 0,275 | 0,227 | |

| 100 | 0,213 | 0,370 | 0,393 | 0,164 | 0,239 | 0,097 | 0,385 | 0,322 | |

| 200 | 0,341 | 0,565 | 0,614 | 0,242 | 0,387 | 0,121 | 0,596 | 0,525 | |

| 500 | 0,668 | 0,882 | 0,912 | 0,498 | 0,733 | 0,215 | 0,893 | 0,856 | |

| 0 | 25 | 0,146 | 0,219 | 0,169 | 0,121 | 0,159 | 0,095 | 0,214 | 0,175 |

| 60 | 0,236 | 0,360 | 0,359 | 0,183 | 0,263 | 0,116 | 0,373 | 0,312 | |

| 100 | 0,333 | 0,506 | 0,533 | 0,249 | 0,372 | 0,134 | 0,530 | 0,462 | |

| 200 | 0,531 | 0,712 | 0,757 | 0,402 | 0,583 | 0,196 | 0,743 | 0,685 | |

| 500 | 0,878 | 0,961 | 0,973 | 0,744 | 0,914 | 0,390 | 0,969 | 0,957 | |

| 0,4 | 25 | 0,122 | 0,174 | 0,125 | 0,101 | 0,129 | 0,087 | 0,166 | 0,142 |

| 60 | 0,186 | 0,292 | 0,283 | 0,144 | 0,202 | 0,098 | 0,297 | 0,251 | |

| 100 | 0,243 | 0,391 | 0,407 | 0,188 | 0,270 | 0,107 | 0,405 | 0,342 | |

| 200 | 0,374 | 0,586 | 0,628 | 0,277 | 0,424 | 0,129 | 0,612 | 0,552 | |

| 500 | 0,689 | 0,884 | 0,911 | 0,524 | 0,754 | 0,223 | 0,894 | 0,863 | |

| 0,9 | 25 | 0,163 | 0,093 | 0,028 | 0,136 | 0,167 | 0,129 | 0,119 | 0,160 |

| 60 | 0,334 | 0,253 | 0,106 | 0,277 | 0,359 | 0,235 | 0,288 | 0,356 | |

| 100 | 0,418 | 0,353 | 0,218 | 0,351 | 0,454 | 0,276 | 0,391 | 0,458 | |

| 200 | 0,484 | 0,440 | 0,358 | 0,416 | 0,534 | 0,320 | 0,495 | 0,552 | |

| 500 | 0,553 | 0,531 | 0,501 | 0,472 | 0,607 | 0,350 | 0,609 | 0,651 | |

En la tabla se pone en negrita y cursiva el tamaño de la prueba más alto para cada tamaño de muestra. Por ejemplo, se resalta en la primera línea de la tabla el número 0,107 que corresponde al poder de la prueba K, que es el más grande entre todas las pruebas cuando se emplean 25 observaciones y un ρ=−0,9.

Fuente: elaboración propia.

Por otro lado, para la distribución Chi-cuadrado con 3 grados de libertad, todas las pruebas tienen un poder similar; pero la prueba SF parece tener un poder ligeramente mayor que las demás cuando no hay autocorrelación (tabla 2).

En general, semejante a los resultados de la distribución normal, las pruebas funcionan relativamente bien cuando ρ toma valores entre ±0,5 (fig. 2) y las muestras poseen más de 60 observaciones. Sin embargo, SW parece ser afectada en menor medida por la dependencia lineal de los errores en comparación con las demás pruebas. Adicionalmente, al igual que en el caso del tamaño de las pruebas, cuando se presenta una autocorrelación positiva, la probabilidad de rechazar la hipótesis nula de normalidad cuando esta es falsa es más pequeña que cuando existe autocorrelación con el mismo valor pero con signo negativo. Es decir, se presenta un comportamiento asimétrico entre el poder de la prueba cuando la autocorrelación es positiva y cuando la autocorrelación es negativa. Siendo el poder más bajo cuando existe una autocorrelación negativa más fuerte.

Los resultados del poder de la prueba comienzan a cambiar su comportamiento cuando los grados de libertad aumentan. En la sección de anexos se presentan los resultados cuando se consideran 4 y 5 grados de libertad (anexo, figs. A1 y A2). Para el caso de 6 grados de libertad (tabla 3 y fig. 3), se puede observar que el poder de las pruebas es menor que en el caso de una distribución con 3 grados de libertad. Este resultado es apenas natural, pues a medida que crecen los grados de libertad, la distribución t se parece más a la distribución normal. De esta manera, se hace más difícil que la prueba rechace la hipótesis nula de una distribución normal. Es más, para el caso de no autocorrelación (ρ=0), todas las pruebas presentan un poder relativamente bajo para muestras pequeñas. El poder de las pruebas solo mejora cuando la muestra es grande (T=500).

Para los casos en los que existe autocorrelación, las pruebas JB, K y SF muestran el mejor poder relativo, dejando todo lo demás constante. Por el contrario, la prueba Chi es la que presenta el poder más bajo (fig. 3).

En este caso también se presenta el comportamiento asimétrico del poder de la prueba cuando se comparan los escenarios con autocorrelación positiva y negativa. Por otro lado, se observa un desempeño interesante para autocorrelaciones positivas grandes. El poder de las pruebas comienza a aumentar, después de haber caído, cuando ρ toma valores superiores a 0,7. Este comportamiento se presenta en los resultados de todas las pruebas empleadas.

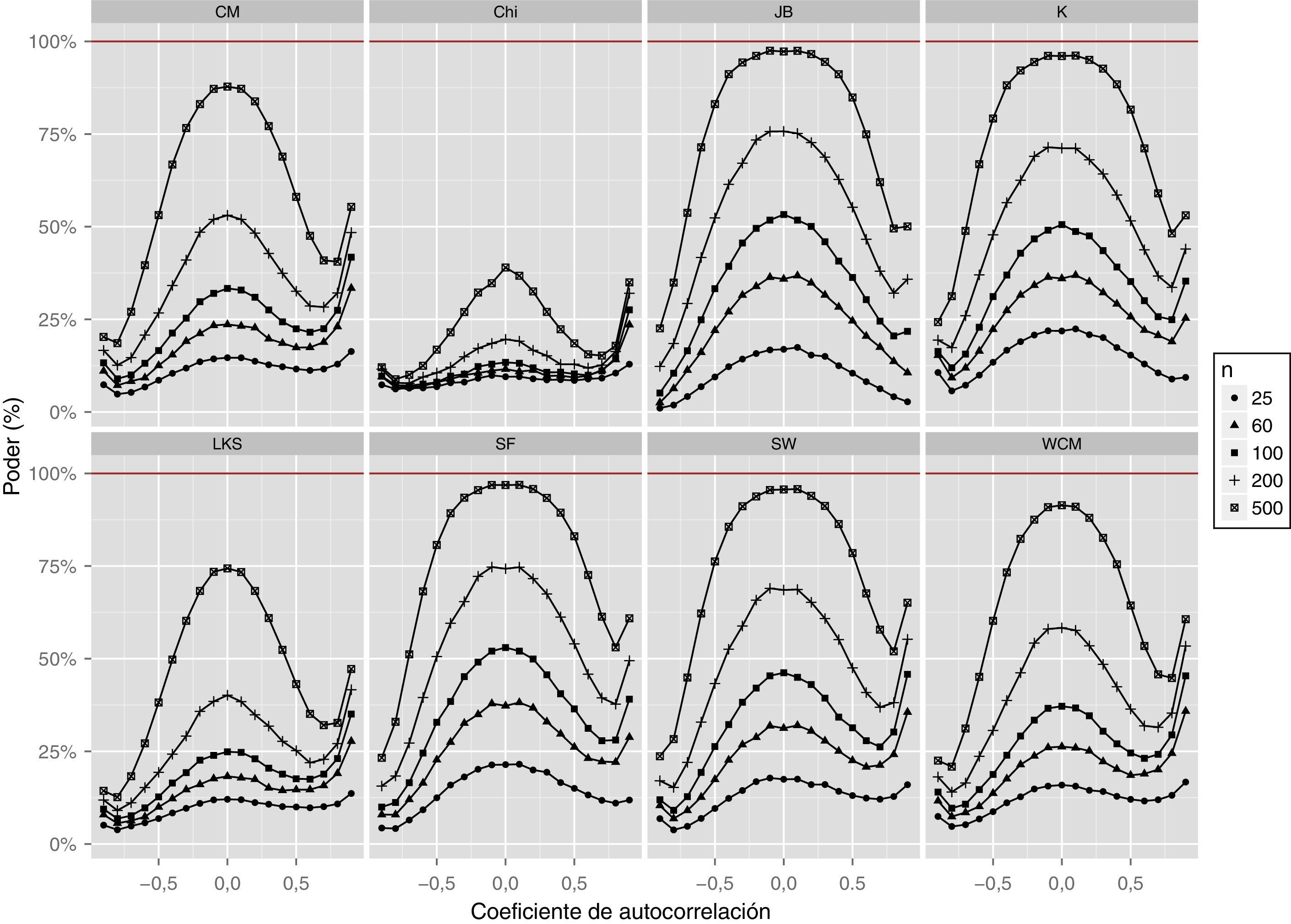

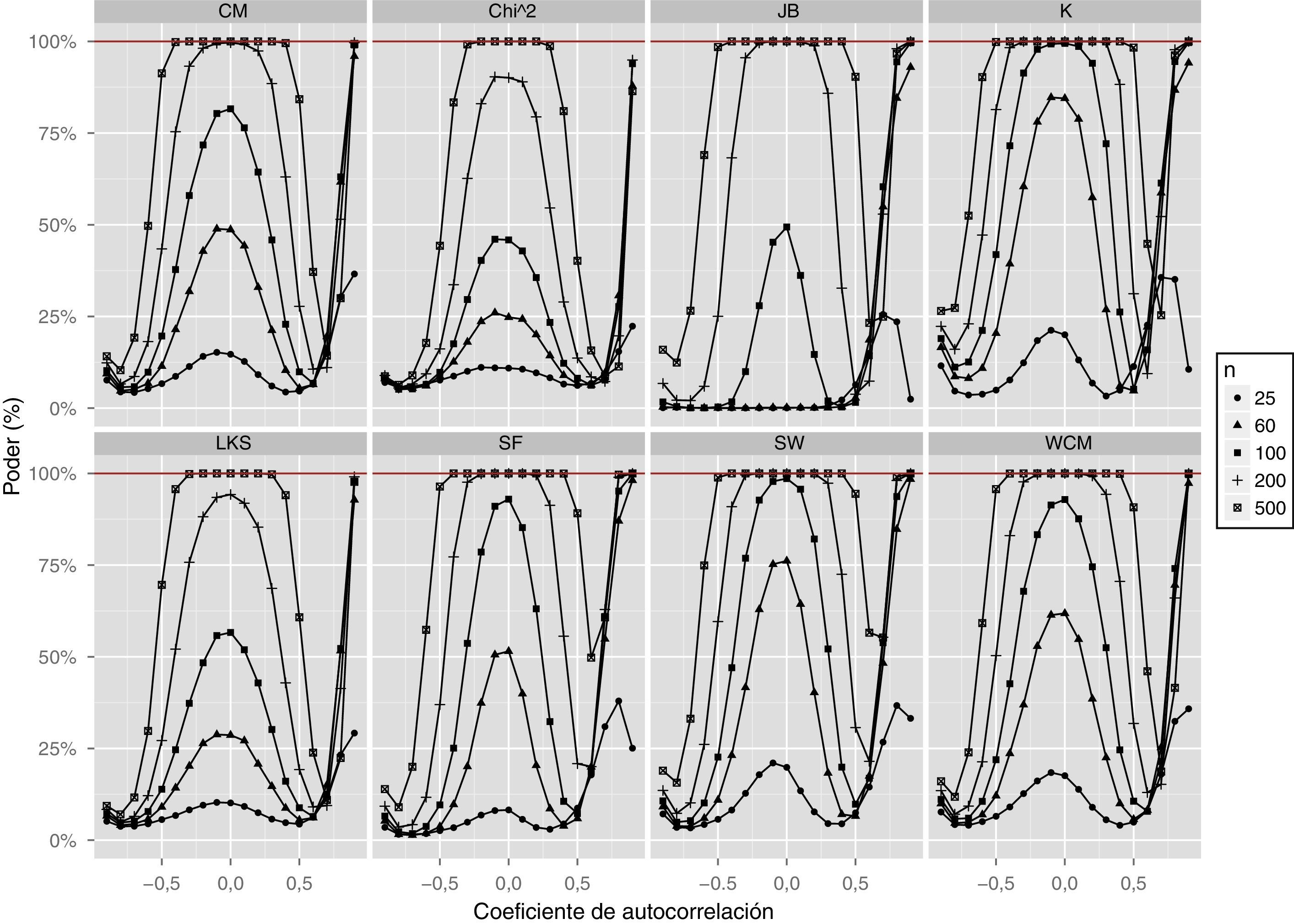

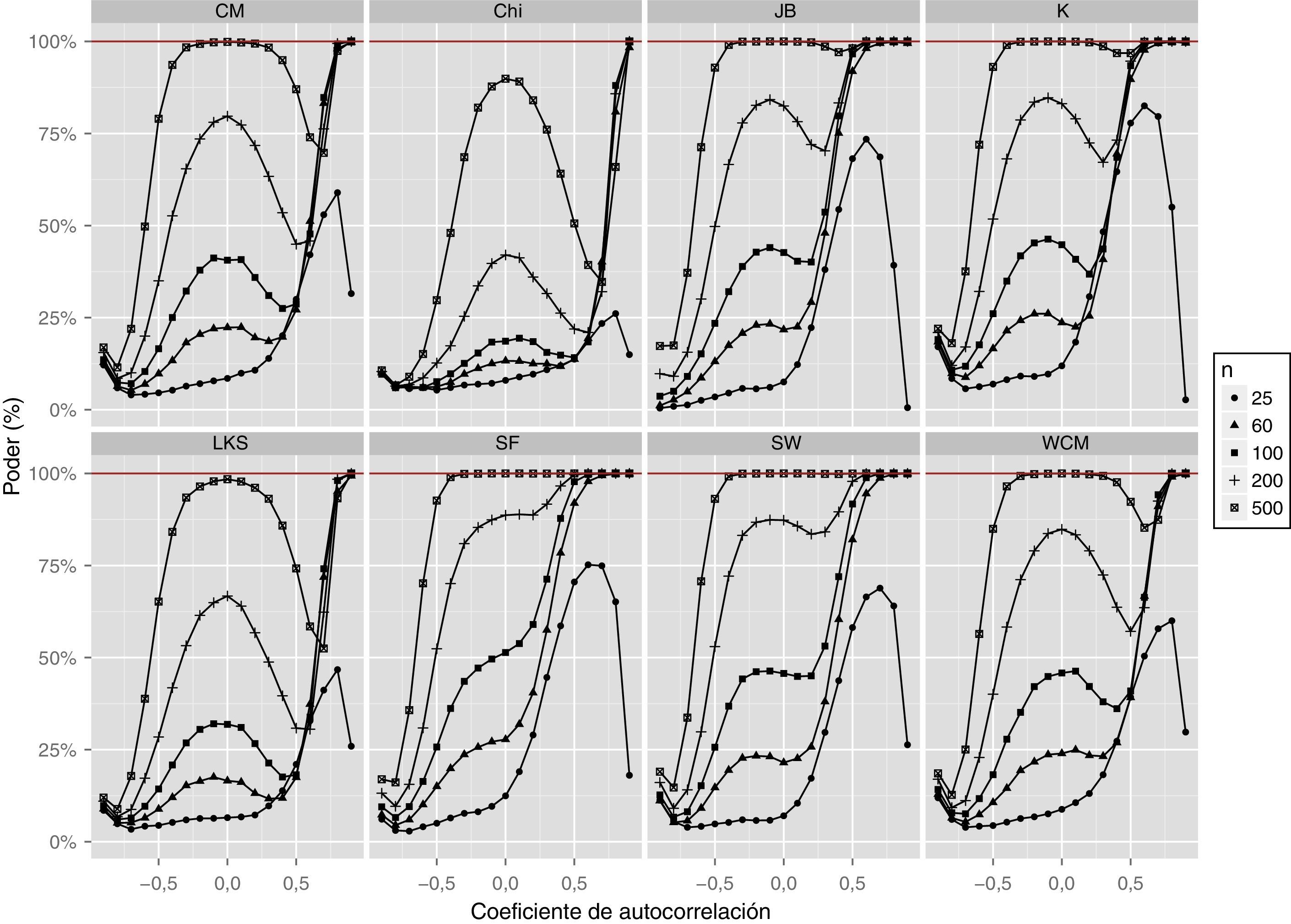

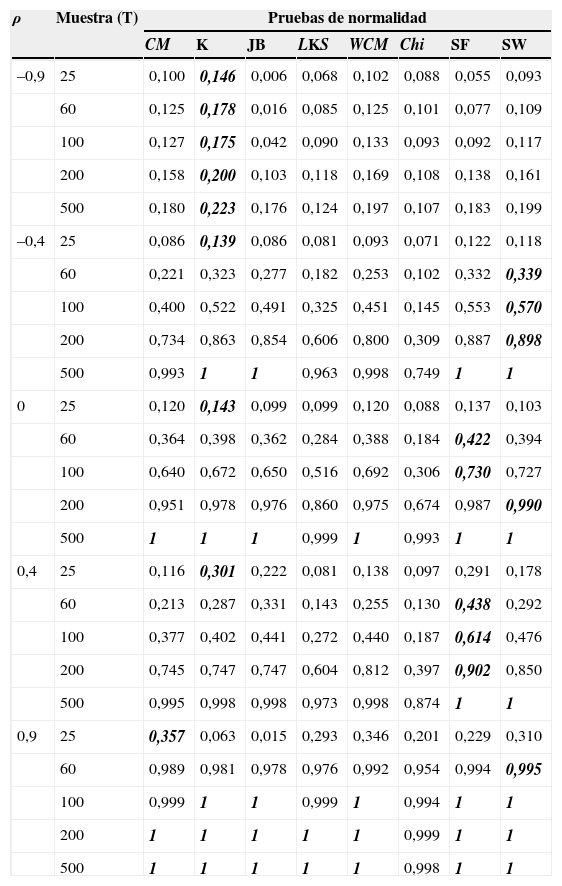

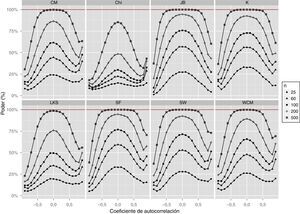

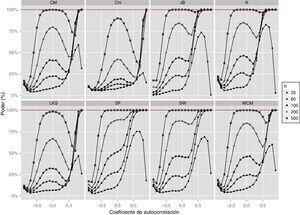

3.3Distribución Chi-cuadradoEl ejercicio de Monte Carlo incluye simulaciones para errores que provienen de una distribución Chi-cuadrado con grados de libertad 1, 5, 10, 15 y 20. En esta subsección se reportan los resultados para el caso de 10 grados de libertad (tabla 4 y fig. 4), los otros resultados para esta misma distribución con grados de libertad 1, 5, 15 y 20 se encuentran en los anexos (figs. A3–A6).

Poder de las pruebas de normalidad para errores con distribución χ102

| ρ | Muestra (T) | Pruebas de normalidad | |||||||

|---|---|---|---|---|---|---|---|---|---|

| CM | K | JB | LKS | WCM | Chi | SF | SW | ||

| –0,9 | 25 | 0,100 | 0,146 | 0,006 | 0,068 | 0,102 | 0,088 | 0,055 | 0,093 |

| 60 | 0,125 | 0,178 | 0,016 | 0,085 | 0,125 | 0,101 | 0,077 | 0,109 | |

| 100 | 0,127 | 0,175 | 0,042 | 0,090 | 0,133 | 0,093 | 0,092 | 0,117 | |

| 200 | 0,158 | 0,200 | 0,103 | 0,118 | 0,169 | 0,108 | 0,138 | 0,161 | |

| 500 | 0,180 | 0,223 | 0,176 | 0,124 | 0,197 | 0,107 | 0,183 | 0,199 | |

| –0,4 | 25 | 0,086 | 0,139 | 0,086 | 0,081 | 0,093 | 0,071 | 0,122 | 0,118 |

| 60 | 0,221 | 0,323 | 0,277 | 0,182 | 0,253 | 0,102 | 0,332 | 0,339 | |

| 100 | 0,400 | 0,522 | 0,491 | 0,325 | 0,451 | 0,145 | 0,553 | 0,570 | |

| 200 | 0,734 | 0,863 | 0,854 | 0,606 | 0,800 | 0,309 | 0,887 | 0,898 | |

| 500 | 0,993 | 1 | 1 | 0,963 | 0,998 | 0,749 | 1 | 1 | |

| 0 | 25 | 0,120 | 0,143 | 0,099 | 0,099 | 0,120 | 0,088 | 0,137 | 0,103 |

| 60 | 0,364 | 0,398 | 0,362 | 0,284 | 0,388 | 0,184 | 0,422 | 0,394 | |

| 100 | 0,640 | 0,672 | 0,650 | 0,516 | 0,692 | 0,306 | 0,730 | 0,727 | |

| 200 | 0,951 | 0,978 | 0,976 | 0,860 | 0,975 | 0,674 | 0,987 | 0,990 | |

| 500 | 1 | 1 | 1 | 0,999 | 1 | 0,993 | 1 | 1 | |

| 0,4 | 25 | 0,116 | 0,301 | 0,222 | 0,081 | 0,138 | 0,097 | 0,291 | 0,178 |

| 60 | 0,213 | 0,287 | 0,331 | 0,143 | 0,255 | 0,130 | 0,438 | 0,292 | |

| 100 | 0,377 | 0,402 | 0,441 | 0,272 | 0,440 | 0,187 | 0,614 | 0,476 | |

| 200 | 0,745 | 0,747 | 0,747 | 0,604 | 0,812 | 0,397 | 0,902 | 0,850 | |

| 500 | 0,995 | 0,998 | 0,998 | 0,973 | 0,998 | 0,874 | 1 | 1 | |

| 0,9 | 25 | 0,357 | 0,063 | 0,015 | 0,293 | 0,346 | 0,201 | 0,229 | 0,310 |

| 60 | 0,989 | 0,981 | 0,978 | 0,976 | 0,992 | 0,954 | 0,994 | 0,995 | |

| 100 | 0,999 | 1 | 1 | 0,999 | 1 | 0,994 | 1 | 1 | |

| 200 | 1 | 1 | 1 | 1 | 1 | 0,999 | 1 | 1 | |

| 500 | 1 | 1 | 1 | 1 | 1 | 0,998 | 1 | 1 | |

En la tabla se reporta en negrita y cursiva el tamaño de la prueba más alto para cada tamaño de muestra. Por ejemplo, se resalta en la primera línea de la tabla el número 0,146 que corresponde al poder de la prueba K, que es el más grande entre todas las pruebas cuando se emplean 25 observaciones y un ρ=−0,9.

Fuente: elaboración propia.

En el caso de la distribución Chi-cuadrado con grados de libertad 1 y 5, los resultados son similares a los obtenidos con la distribución t de Student (figs. A3 y A4). Sin embargo, cuando los grados de libertad son 10, el poder de la prueba es mayor en todos los casos, a diferencia de lo encontrado para la distribución t. Para esta distribución también se observa una caída en el poder a medida que la muestra disminuye y cada vez que la autocorrelación se hace más negativa. Para el caso de autocorrelación positiva fuerte (ρ=0, 9) el poder de todas las pruebas es igual o mayor que cuando no hay autocorrelación.

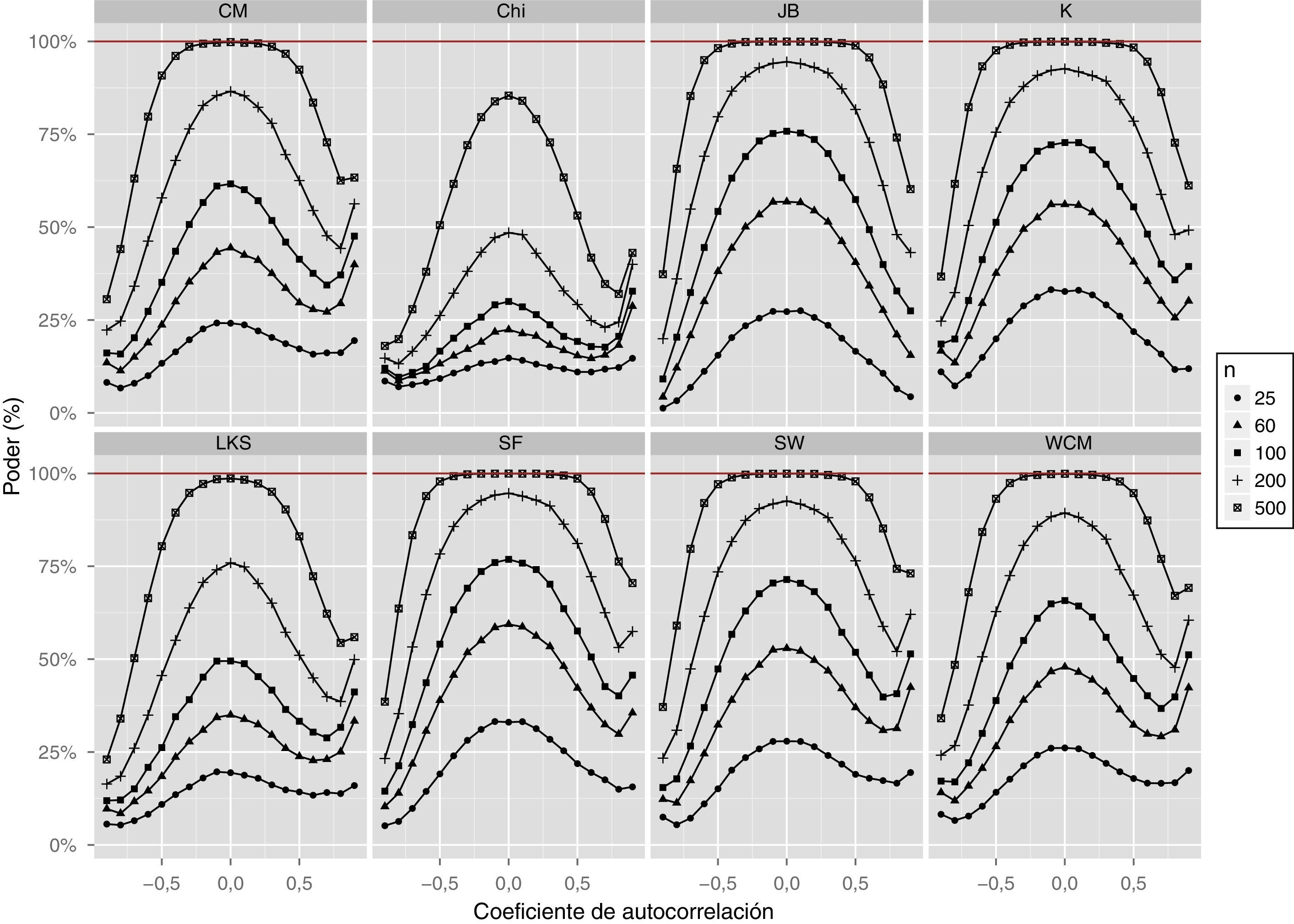

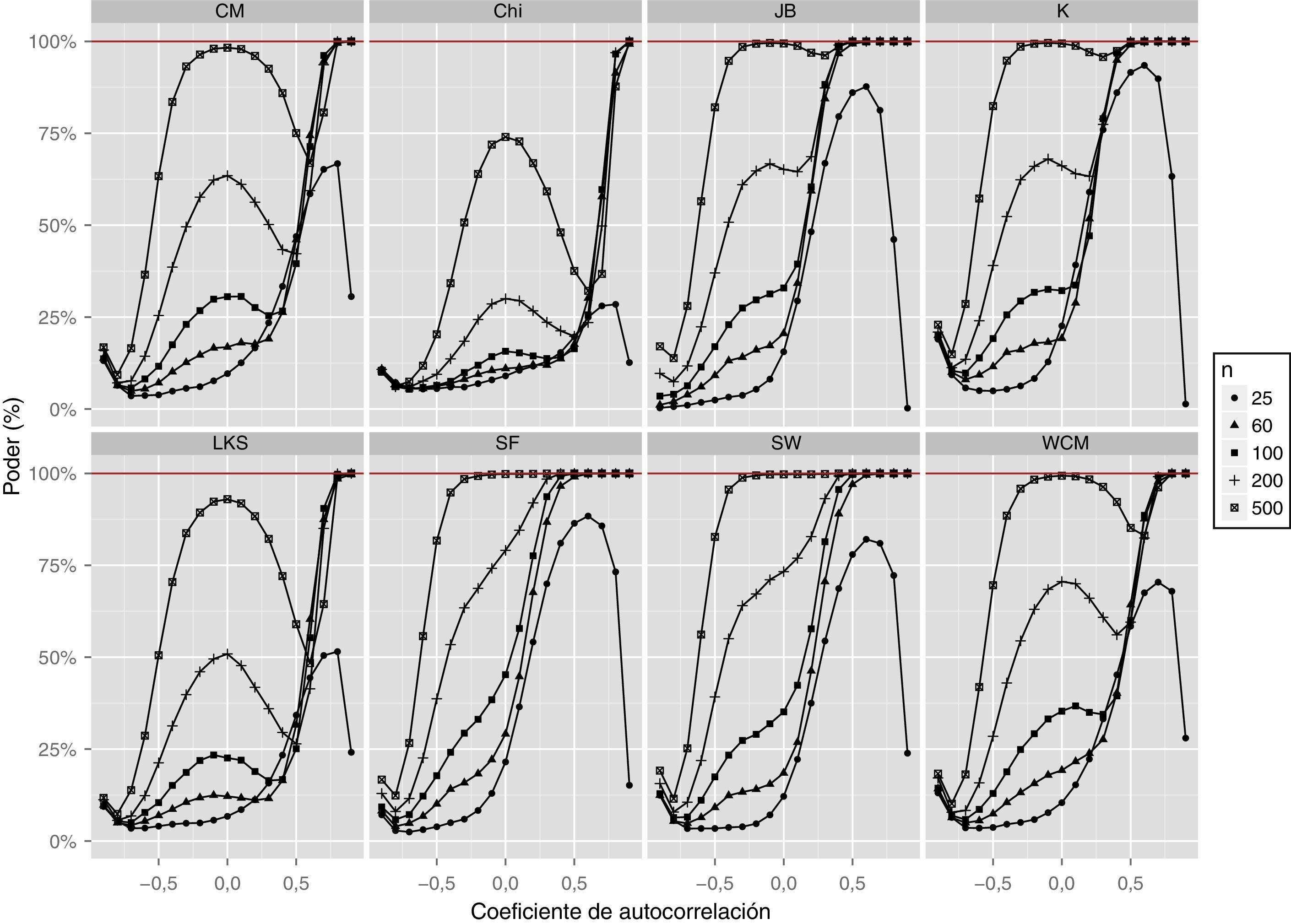

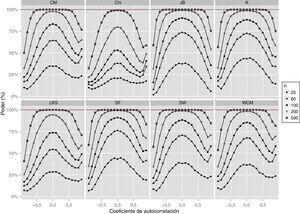

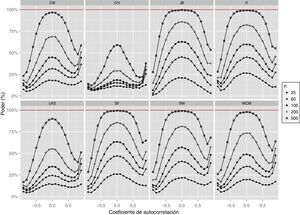

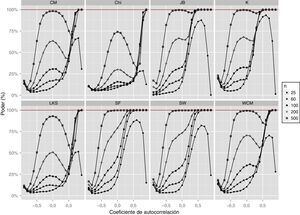

3.4Distribución uniformePara esta distribución, el comportamiento del poder de las pruebas de normalidad es relativamente parecido a lo que ocurre con las anteriores distribuciones (tabla 5 y fig. 5). De esta forma, el poder disminuye cuanto más fuerte es la autocorrelación negativa, mientras que el poder se deteriora en gran medida cuando la muestra es pequeña. Adicionalmente, a medida que la autocorrelación es más positiva el poder de la prueba mejora. La figura 5 muestra en detalle lo indicado anteriormente para todos los coeficientes de autocorrelación.

Poder de las pruebas de normalidad para errores con distribución uniforme

| ρ | Muestra (T) | Pruebas de normalidad | |||||||

|---|---|---|---|---|---|---|---|---|---|

| CM | K | JB | LKS | WCM | Chi | SF | SW | ||

| –0,9 | 25 | 0,077 | 0,116 | 0,001 | 0,052 | 0,077 | 0,070 | 0,035 | 0,072 |

| 60 | 0,094 | 0,166 | 0,003 | 0,066 | 0,099 | 0,081 | 0,052 | 0,091 | |

| 100 | 0,103 | 0,190 | 0,017 | 0,073 | 0,111 | 0,079 | 0,066 | 0,107 | |

| 200 | 0,124 | 0,223 | 0,067 | 0,084 | 0,135 | 0,089 | 0,093 | 0,136 | |

| 500 | 0,141 | 0,265 | 0,159 | 0,094 | 0,161 | 0,087 | 0,139 | 0,190 | |

| –0,4 | 25 | 0,087 | 0,077 | 0,001 | 0,067 | 0,091 | 0,087 | 0,034 | 0,082 |

| 60 | 0,215 | 0,394 | 0, | 0,143 | 0,237 | 0,126 | 0,097 | 0,231 | |

| 100 | 0,378 | 0,715 | 0,017 | 0,247 | 0,427 | 0,175 | 0,251 | 0,470 | |

| 200 | 0,754 | 0,983 | 0,682 | 0,521 | 0,830 | 0,337 | 0,772 | 0,909 | |

| 500 | 0,998 | 1 | 1 | 0,957 | 1 | 0,834 | 1 | 1 | |

| 0 | 25 | 0,147 | 0,200 | 0,001 | 0,102 | 0,176 | 0,109 | 0,082 | 0,199 |

| 60 | 0,487 | 0,845 | 0,002 | 0,286 | 0,618 | 0,248 | 0,515 | 0,762 | |

| 100 | 0,816 | 0,995 | 0,494 | 0,566 | 0,929 | 0,459 | 0,930 | 0,986 | |

| 200 | 0,996 | 1 | 1 | 0,943 | 1 | 0,901 | 1 | 1 | |

| 500 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | |

| 0,4 | 25 | 0,044 | 0,049 | 0,022 | 0,048 | 0,041 | 0,066 | 0,044 | 0,045 |

| 60 | 0,103 | 0,060 | 0,004 | 0,088 | 0,100 | 0,090 | 0,039 | 0,070 | |

| 100 | 0,229 | 0,262 | 0,003 | 0,161 | 0,246 | 0,122 | 0,106 | 0,199 | |

| 200 | 0,631 | 0,883 | 0,327 | 0,429 | 0,705 | 0,290 | 0,556 | 0,725 | |

| 500 | 0,995 | 1 | 1 | 0,941 | 0,999 | 0,810 | 1 | 1 | |

| 0,9 | 25 | 0,366 | 0,106 | 0,025 | 0,292 | 0,358 | 0,224 | 0,251 | 0,332 |

| 60 | 0,960 | 0,941 | 0,930 | 0,928 | 0,973 | 0,878 | 0,981 | 0,984 | |

| 100 | 0,990 | 0,997 | 0,996 | 0,979 | 0,996 | 0,939 | 0,999 | 0,999 | |

| 200 | 0,997 | 1 | 1 | 0,991 | 1 | 0,949 | 1 | 1 | |

| 500 | 0,993 | 1 | 1 | 0,977 | 1 | 0,864 | 1 | 1 | |

En la tabla se reporta en negrita y cursiva el tamaño de la prueba más alto para cada tamaño de muestra. Por ejemplo, se resalta en la primera línea de la tabla el número 0,116 que corresponde al poder de la prueba K, que es el más grande entre todas las pruebas cuando se emplean 25 observaciones y un ρ=−0,9.

Fuente: elaboración propia.

Los resultados de las simulaciones de Monte Carlo permiten encontrar 4 regularidades interesantes, con implicaciones para el trabajo empírico con series de tiempo. Primero, el efecto de la presencia de autocorrelación sobre el tamaño y el poder de las pruebas es asimétrico; es decir, el efecto que tiene una autocorrelación, de igual tamaño pero de signo contrario, sobre el tamaño o el poder, es diferente independientemente de la distribución y la prueba considerada. Por ejemplo, cuando se presenta una autocorrelación positiva, la probabilidad de rechazar erróneamente la hipótesis nula de normalidad (tamaño de la prueba) es más grande que el tamaño nominal y que el tamaño con la misma autocorrelación en valor absoluto pero con signo contrario. En el caso del poder, este es más grande cuando existe autocorrelación positiva en comparación con el escenario con autocorrelación negativa de la misma magnitud.

Segundo, la prueba que presenta una menor distorsión en su tamaño es la JB. No obstante, su tamaño puede llegar a ser de 0,431 en presencia de errores con una autocorrelación positiva muy fuerte (ρ=0, 9). En este sentido, todas las pruebas ven distorsionado su tamaño en presencia de autocorrelación fuerte (mayor a 0,5 en valor absoluto). Por otro lado, el tamaño no se ve fuertemente distorsionado por el tamaño de la muestra cuando la autocorrelación es moderada (menor a 0,4 en valor absoluto).

Tercero, si bien la prueba Chi tiene el poder más bajo en todos los escenarios estudiados, ninguna de las 8 pruebas estudiadas tiene consistentemente un mejor poder que las demás en todos los escenarios analizados.

Cuarto, cuando la muestra es pequeña (T=25) y existe autocorrelación, así sea moderada, las pruebas de normalidad estudiadas tienen un poder muy bajo. El poder no supera el 37%.

Finalmente, en presencia de errores que siguen un proceso AR(1), las 8 pruebas más comunes de normalidad no parecen ser una buena opción. Por un lado, si el investigador se enfrenta sin saberlo a errores que provienen de una distribución normal, las 8 pruebas presentan una probabilidad relativamente alta de rechazar la hipótesis nula erróneamente. Por otro lado, si el investigador se enfrenta sin saberlo a unos errores que no proceden de una distribución normal, las 8 pruebas presentan una relativa baja probabilidad de no rechazar la hipótesis nula de normalidad. En especial esta probabilidad es más baja para muestras pequeñas. En este orden de ideas, se debe ser muy cuidadoso al concluir sobre la distribución de los errores MCO si se emplean las 8 pruebas más comunes. Este resultado debe llamar la atención a los investigadores que emplean series de tiempo que estén autocorrelacionadas.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.