La ciencia apenas existe hasta que se publica1,2. Es sólo entonces cuando la información trasciende los límites del propio autor y puede ser compartida por la comunidad científica. En el área de ciencias de la salud, en concreto, uno de los ítems que se valoran es la capacidad investigadora del profesional y, dentro de ella y como consecuencia directa de ésta, su producto final: la publicación científica3.

La primera revista científica moderna inició su andadura allá por el año 1665, promovida en aquellos tiempos por la Royal Society de Londres4. El número de artículos que se publicaban en las revistas científicas era inicialmente muy bajo, y continuó siéndolo hasta mediados del siglo xx. Hasta no hace mucho tiempo, la mayoría de los proyectos científicos y las autorías eran responsabilidad de un único individuo4. Los científicos iniciales –los pioneros– no dependían de la publicación de un elevado número de artículos para obtener financiación, reconocimiento público o promoción4 (una situación muy diferente a la de hoy día, resumida por el famoso precepto: publish or perish, «publicar o perecer»)5,6. Por ejemplo, sir Isaac Newton era reacio a publicar sus descubrimientos e incluso a incluir su nombre en las publicaciones7. Newton fue el autor en solitario de los Principia, una grandiosa obra que hoy día sería impensable que pudiera ser firmada por un único autor. Otros grandes científicos –como Mendel o Einstein– tienen en su palmarés un escaso número de publicaciones, en la mayoría de las cuales firman como únicos autores4. En la literatura clásica (no médica) la situación es semejante y, que sepamos, hasta el momento ninguna obra se ha atribuido a Shakespeare et al8.

El modelo de investigación y de autoría está cambiando rápidamente y estamos asistiendo a una progresión desde el modelo individualista –el de los primeros científicos– al colaborativo –el de los actuales–, en el que se combinan diferentes disciplinas biomédicas y se potencian los sinergismos, lo que ha tenido como consecuencia un incremento notable en el número de autores por manuscrito. Así, a mediados de la década de los años noventa, se alcanzó una media de 2 autores por artículo2. Desde entonces, el número medio de firmantes en revistas prestigiosas como The Lancet se ha incrementado hasta más de 6, y este ascenso continúa siendo exponencial1,9–14. Desde el año 1980 hasta el año 2000 el número de autores por manuscrito en las grandes revistas médicas se ha incrementado en más de un 50%, y ha alcanzado una cifra de 6,9 por artículo9–11. En el área de los ensayos clínicos, por ejemplo, desde el año 1990 se ha descrito un aumento exponencial en el número de artículos con más de 100 autores12. ¡En ocasiones puede parecer que el número de autores supera al de pacientes incluidos en el estudio!

Según el Diccionario de la Lengua Española, «autor» se define como «persona que es causa de algo», «persona que inventa algo» o «persona que ha hecho alguna obra científica, literaria o artística». En sentido general, se considera que un «autor» de un trabajo publicado es una persona que ha contribuido intelectualmente de manera significativa a él13,14. El criterio de autoría debe guiarse por un principio ético fundamental: los autores deben estar dispuestos a responsabilizarse públicamente de lo que hayan escrito y a responder a las preguntas que se les planteen15. Según el International Committee of Medical Journal Editors, la acreditación de autoría debe basarse únicamente en contribuciones sustanciales en los aspectos siguientes16–19: a) contribuciones significativas a la concepción y el diseño del estudio, u obtención de los datos, o al análisis e interpretación de éstos; b) la redacción del manuscrito o su revisión crítica con aportaciones de naturaleza intelectual relevantes, y c) la aprobación final de la versión a publicar. Las personas designadas como autores deben cumplir los requisitos 1, 2 y 3, y no sólo alguno de ellos.

Por qué y para qué ser autor de un artículo biomédicoLa elaboración y la presentación de un manuscrito a una revista biomédica requiere un duro –a veces incluso penoso– esfuerzo. Las motivaciones que llevan a los autores a embarcarse en la realización de un estudio y en la posterior redacción del manuscrito en que plasmarán sus resultados son de muy diversa índole1,20,21. En primer lugar, existe una motivación de tipo personal, la propia satisfacción de ver culminado (publicado) un trabajo que tanto esfuerzo nos ha costado. La finalidad de la investigación es contribuir al avance del conocimiento, de forma que la publicación es una fase esencial de la investigación, porque permite difundir el nuevo conocimiento y contribuir así al progreso de la ciencia. Una motivación o argumento adicional para escribir nuestro propio artículo es aprender a valorar (tanto en lo bueno como en lo malo) lo que escriben los demás1,20,21. Así, conocer cómo escribir críticamente un artículo nos ayuda a leer también críticamente los artículos escritos por otros autores. Evidentemente, otros motivos personales muy diferentes, como la necesidad de alimentar nuestra autoestima o el deseo de reconocimiento por los demás profesionales, constituyen en ocasiones un estímulo importante a la hora de publicar1,20–22. Un último argumento para publicar, menos altruista pero no por ello menos capaz de generar estímulo, es la necesidad de obtener un currículo profesional.

Pertinencia de escribir un artículoLa primera pregunta que nos debemos plantear al considerar la posibilidad de elaborar un manuscrito es si merece realmente la pena escribir el artículo en cuestión1,20–22. La elaboración de un manuscrito es una tarea compleja a la que tendremos que dedicar un esfuerzo considerable; por eso, antes de embarcarnos en este largo viaje, debemos estar convencidos de que el artículo merece ser escrito para que pueda optar a su posterior publicación. Uno de los factores de los que dependerá la aceptación de un artículo por una revista es si su mensaje es nuevo en la literatura médica1,20–22. Una segunda pregunta que deberemos hacernos al plantearnos la pertinencia de escribir un determinado artículo es la de «¿qué pasará?», es decir, ¿qué efecto tendrá el mensaje de nuestro estudio?, fundamentalmente en el sentido de si cambiará los conceptos o la práctica clínica y cómo lo hará1,20–22. Una vez que hemos decidido que merece la pena escribir y publicar el artículo, deberemos plantearnos quiénes serán sus potenciales lectores (lo que se ha denominado la prueba de «¿a quién importa?»)1,20–22. No debemos caer en el error de sobrevalorar la audiencia probable de nuestro artículo, lo que nos llevaría a la preparación y envío del manuscrito a una revista de gran circulación que probablemente lo rechazará1,20–22.

La productividad científica y los indicadores bibliométricosHoy más que nunca las publicaciones de los científicos se emplean como medida de la competencia y el éxito profesional de éstos4. Así, la capacidad de obtener recursos económicos, promoción profesional y reconocimiento público depende actualmente de la cantidad y la calidad de publicaciones científicas16. Es lógico que en un mundo con recursos limitados la evaluación de los candidatos que optan a ellos sea esencial. La evaluación de un autor o científico es un proceso que permite asignarle una puntuación que lo sitúa con relación a otros17,18,23. Sin embargo, la valoración del mérito curricular es un tema complicado y controvertido.

Teóricamente, las agencias evaluadoras y las comisiones deben tener en cuenta 2 aspectos de la actividad investigadora: la cantidad y la calidad de la producción científica (no siempre los indicadores de estos 2 aspectos coinciden)16. Esto es fácil de decir, pero difícil de cuantificar. El establecimiento de un parámetro sencillo, y a la vez riguroso, para medir el rendimiento científico ha sido un objetivo largamente perseguido, pero con poco éxito18,19,24.

El juicio de los expertos o evaluación «por pares» ha demostrado ser el método más apropiado para valorar el grado de desarrollo de un determinado campo de investigación y la calidad de las aportaciones concretas al área de los distintos científicos25. No obstante, este sistema presenta algunas limitaciones, entre las que destaca su carácter subjetivo –es un método muy sensible a la influencia de factores personales–. Puesto que no es posible crear condiciones ciegas para la evaluación de la trayectoria profesional de un candidato, si no se dispone de instrumentos precisos no pueden ofrecerse garantías para que la evaluación se realice de una manera objetiva por evaluadores competentes y libres de conflictos de intereses23.

Revisados estos antecedentes, se explica el éxito de los indicadores bibliométricos aplicados a la evaluación científica, al tener éstos la ventaja de ser objetivos y complementar al juicio de los expertos25. Se han identificado numerosos indicadores para la cuantificación y la valoración de las publicaciones biomédicas. Los más utilizados se basan en el recuento de las publicaciones y de las citas recibidas por los trabajos publicados, así como en el impacto de las revistas en las que se publican25.

Como gráficamente señalan Imperial y Rodríguez-Navarro19, hace tiempo que la ciencia busca el número áureo, un método cuantitativo, un único indicador, sencillo, que sea válido para todas las ramas de la ciencia y para todas las disciplinas, capaz de representar el valor de un autor y sus aportaciones19,23,24. Sin embargo, al menos por el momento, ninguno de los indicadores bibliométricos puede considerarse en sí mismo determinante, ya que cada uno de ellos presenta sólo una faceta de la realidad –siempre en forma imperfecta–, de manera que sólo tienen verdadera utilidad cuando se consideran en conjunto. En resumen, en la actualidad no disponemos de un único indicador que pueda analizar fehacientemente una actividad tan compleja como la investigación3.

Tipos de indicadores bibliométricosLos principales indicadores bibliométricos se pueden agrupar en 2 grandes grupos: a) indicadores cuantitativos de actividad científica, donde se incluye el número de publicaciones, e b) indicadores de impacto, basados en el número de citas que obtienen los trabajos, y que caracterizan la importancia de esta producción en función del reconocimiento otorgado por otros investigadores3,25.

La ventaja fundamental del número total de publicaciones es que cuantifica la productividad global, mientras que su desventaja reside es que no mide la importancia ni el impacto de los trabajos16. El simple recuento de publicaciones de cada investigador es un indicador poco fiable para medir la aportación que ha hecho al progreso de la ciencia3,25,26. Se ha indicado que medir la ciencia con unidades de peso (cuantas más publicaciones, mejor, aunque no se citen) es más un mérito literario que científico27. Así, es evidente que si un autor ha publicado muchos trabajos, eso sólo significa que ha sido un escritor muy activo, pero no nos informa del efecto o la repercusión de sus aportaciones23. De hecho, existen no pocos casos de científicos sumamente prolíficos y escasamente citados28.

Puesto que, como acabamos de mencionar, el número de publicaciones es un indicador meramente cuantitativo que no valora la calidad o la importancia del contenido de los documentos, se han introducido otros indicadores cualitativos, como el número de citas que reciben los trabajos y el factor de impacto de la revista de publicación. El número de citas que recibe un documento es un indicador de la influencia o impacto que produce su contenido en la comunidad científica. Sin embargo, es preciso recordar que impacto y calidad de la investigación no son sinónimos25. Así, el término calidad se refiere al contenido científico de la publicación, a lo adecuado de la metodología, a la claridad de exposición y originalidad de planteamientos y conclusiones. Mientras que el impacto, por su parte, se refiere a la influencia de la publicación en la investigación afín en un momento determinado25.

Como acertadamente han señalado algunos autores25, aunque nos gustaría contar con algún indicador capaz de valorar la calidad de las publicaciones, de momento tenemos que conformarnos con indicadores indirectos de esa calidad, como es el impacto que estas publicaciones producen en los investigadores del área. Sin embargo, se ha observado que muchas publicaciones que reúnen criterios de calidad atendiendo a la opinión de expertos apenas reciben citas (es decir, que producen un impacto escaso)25. La razón es que el número de citas recibidas por una publicación depende obviamente de su calidad, pero también de otras variables no totalmente identificadas, entre las que se incluye el prestigio del autor o de su lugar de trabajo, la actualidad del tema, la lengua utilizada y la revista de publicación, que condicionarán la mayor o menor difusión del trabajo29. Por otra parte, si como indicador global de calidad de un autor se toma el número total de citas provenientes de todas la publicaciones, éste puede estar inflado por unos pocos «grandes impactos», que pueden no ser representativos de la persona si es coautor de tales trabajos con muchos otros16. Por lo tanto, se podría concluir que el número de citas que recibe un trabajo, o el número global de citaciones de un autor, siendo importantes, son sólo indicadores parciales de su calidad, y lo que –únicamente– muestran es la visibilidad, la difusión o el impacto del trabajo en la comunidad científica del área25.

El «factor de impacto»: mito y realidadDe entre los diversos indicadores de impacto, el más conocido es el denominado «factor de impacto» (de Thomson Scientific). El «factor de impacto» de una revista en un año es el cociente entre el número de citas que han recibido en ese año los documentos publicados en los 2 años anteriores y el número de documentos publicados por la revista en esos 2 años. Por tanto, el «factor de impacto» de una revista es el número medio de citas de los trabajos publicados en los 2 años naturales que siguen al de su publicación18. Por ejemplo, el «factor de impacto» de la revista X en el año 2008 se define como el número total de citas recibidas durante el año 2008 por los documentos publicados en los años 2006 y 2007 dividido por el número total de documentos publicados por la revista en cuestión durante esos 2 años.

Lamentablemente, en ocasiones vemos a algunos investigadores más preocupados por los «factores de impacto» de las revistas que por lo que pueden descubrir con su trabajo18. Como brillantemente ha expresado Camí30 en su artículo titulado «Impactolatría: diagnóstico y tratamiento», algunos colegas profesan una verdadera impactolatría, es decir, un culto o adoración incontinente al «factor de impacto», como si se tratara de la panacea de la evaluación en ciencia. La impactolatría conlleva una práctica simplista en la que se presupone que el «factor de impacto» de la revista de publicación es indicativo de la calidad o la importancia de una investigación científica concreta y, por extensión, de los autores de ésta. Otros términos acuñados para describir procesos patógenos o tratamientos relacionados con este índice son «impactitis» e «impactoterapia»31,32.

Muchas instituciones de evaluación en España han elegido el uso de los «factores de impacto» de las revistas en los que los investigadores publican para evaluar la calidad del trabajo. Sin embargo, y a pesar del extendido uso de este índice, se ha demostrado repetidamente que el «factor de impacto» de una revista no predice la calidad de cada uno de los trabajos publicados18,31,33–38. En bibliometría, el uso del «factor de impacto» como instrumento de calidad únicamente cobra validez cuando se manejan grandes cifras30. Dicho de otro modo, el «factor de impacto» es un indicador que mide la repercusión global de los artículos de una revista, pero no de cada uno de ellos de forma individual3. Así, dentro de un rango de variación bastante grande del «factor de impacto» de las revistas de una especialidad, no hay correlación entre el valor de este factor y el número de citas recibidas por cada uno de los artículos publicados por ella19,24,30,39. Por tanto, publicar en una revista de impacto no es necesariamente un indicador de la calidad del manuscrito, puesto que la mayoría de los artículos de las revistas de impacto no reciben ninguna cita o un número muy reducido de ellas16,39. Así, se ha descrito que aproximadamente el 15–20% de los artículos publicados en una revista concentran más del 50% de todas las citas, mientras que una gran parte de los artículos jamás serán citados18,40. Por último, es preciso tener en cuenta que los «factores de impacto» están influidos por algunos parámetros bibliométricos que nada tienen que ver con la calidad, como, por ejemplo, el número de citas bibliográficas en los trabajos, lo que es enormemente dependiente del tema que éstos traten18.

Por tanto, en la evaluación de un artículo determinado parecería más justo contabilizar las citas que haya recibido ese artículo en concreto, con independencia del «factor de impacto» de la revista3. Como acertadamente expone Camí30, el valor indicativo del «factor de impacto» de la revista parece indiscutible cuando se está ante un trabajo publicado en una de las mejores revistas de la especialidad, pero, aun así, siempre se tratará de una presunción que sólo se confirmará, en parte, según el número de citas que luego reciba la investigación.

En un excelente monográfico dedicado al índice h, Rodríguez-Navarro e Imperial-Ródenas18 señalaban que llama poderosamente la atención el hecho que muchas agencias de evaluación resuelvan un tema tan complejo, como es la evaluación científica, con un método tan falto de soporte empírico y teórico, como es el de los «factores de impacto» de las revistas. Por el contrario, y a partir de las limitaciones relevantes de este indicador, podemos concluir que «factor de impacto» debería desterrarse de las evaluaciones científicas, o al menos complementarlo con otros índices18,19,24,35.

El índice h: definición y cálculoComo queda patente por lo expuesto hasta aquí, para evaluar a un investigador de forma objetiva, y a la vez sencilla, sería preciso disponer de algún tipo de indicador que aglutinara y simplificara la amplia gama de medidas disponibles (como el número de trabajos publicados, las citas totales recibidas, el número de citas por trabajo, el «factor de impacto» de la revista, etc.). En este contexto de sobreabundancia y caos de índices bibliométricos, en el año 2005 Jorge Hirsch, un profesor de física de la Universidad de California en San Diego (Estados Unidos), publicó un trabajo41 en el que se proponía un indicador denominado índice h.

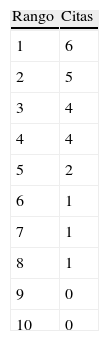

La idea que propone Hirsch consiste en tomar cada uno de los trabajos de un autor y ordenarlos en forma descendente en función de las citas recibidas. Cada trabajo tiene, por tanto, además de una cantidad de citas, un número de orden en el ranking, al que denominamos simplemente rango. De esta forma construimos 2 listas de números: una ascendente (los rangos) y otra descendente (el número de citas). Cuando los valores de ambas se cruzan, tenemos el índice h42,43. Por tanto, un investigador tiene un índice h de X cuando X de sus documentos han recibido al menos X citas cada uno. Por ejemplo, un h=20 significa que un autor tiene 20 publicaciones que se han citado cada una de ellas al menos 20 veces (pero no tiene 21 publicaciones que se hayan citado 21 veces cada una de ellas).

Un ejemplo tomado de Grupo Scimago aclarará este concepto42,43. En la tabla 1 vemos un autor que tiene 10 publicaciones (rango=10), la más citada de las cuales presenta 6 citas y las que menos, ninguna. En este caso h=4, ya que en ese valor se cruzan las distribuciones. Esto equivale a decir que el autor tiene 4 publicaciones con al menos 4 citas.

Es preciso puntualizar que, en este contexto, el término «publicación», «documento» o «trabajo» debe entenderse como cualquier forma de publicación científica ampliamente citada (por ejemplo, artículos, libros, capítulos, ponencias, etc.), aunque la forma más común sea la de artículos en revistas con revisión anónima de pares16. Por tanto, cualquier cita tiene el mismo valor para un autor.

Afortunadamente, la reciente introducción de los nuevos métodos de análisis del Thomson ISI Web of Knowledge permite que el cálculo del número h sea casi inmediato. A continuación se explica cómo calcularlo:

- 1.

Entrar en el portal de acceso a la Web of Knowledge (http://accesowok.fecyt.es), luego hacer clic en «acceso a la WoK».

- 2.

Activar la pestaña Web of Science. En la ventana Search for introducir el nombre del investigador, con el siguiente formato: apellido seguido de la inicial o iniciales del nombre. Confirmar que en la casilla de la derecha, donde se elige el campo en el que se desea buscar, esté seleccionado el término author.

- 3.

Hacer clic en el botón Search, tras lo cual obtendremos la lista de todas las publicaciones del autor. A partir de aquí, podremos ordenar las publicaciones mediante la opción Sorted by Times Cited, y posteriormente movernos hasta encontrar el último trabajo cuyo número de orden sea igual o menor al número de citas (ese es el índice h). Actualmente, el programa permite calcular directamente el índice h, sin necesidad de ordenar previamente los artículos: basta con hacer clic sobre el icono Create Citation Report, situado en el ángulo superior derecho, y obtendremos un resumen del número total de publicaciones, el número total de veces que éstas se han citado, la media de citas por artículo y, finalmente, el índice h.

El índice h tiene una serie de ventajas que lo hacen muy útil y atractivo. Entre ellas se encuentran las siguientes:

- a)

Su cálculo es muy sencillo18,44–46. Como se ha mencionado previamente, la introducción de los nuevos métodos de análisis del ISI Web of Knowledge permite que el cálculo del número h sea prácticamente instantáneo.

- b)

Combina, en un mismo índice bibliométrico, el efecto de la «cantidad» (número de publicaciones) y la «calidad» (tasa de citas) de un modo equilibrado, superando los recuentos brutos de documentos y citas18,44–46.

- c)

Es un indicador robusto, es decir, es insensible a un exceso accidental de trabajos no citados y también a uno o varios extraordinariamente citados18,44–47. Algunos estudios demuestran que el índice h se correlaciona con el número de documentos publicados por cada autor48,49. De igual modo, se ha constatado un paralelismo entre el índice h y el número de citas43,50. Además, lo que es más importante, se ha observado una buena correlación entre la puntuación del índice h y los resultados de la evaluación por revisores (revisión «por pares»)18,41,51. A modo de ejemplo, recientemente se ha calculado de forma retrospectiva el índice h correspondiente a la documentación de más de 400 solicitantes de una beca posdoctoral concedida en la primera mitad de la década pasada, y se ha demostrado que el grado de correlación entre este índice y la aceptación o rechazo del candidato era significativo52. Por otra parte, uno de los problemas que se suele achacar a los indicadores relativos basados en citas por trabajos es que se ven muy influidos por publicaciones excepcionales que cosechan una cantidad de citas muy alta en comparación con el resto42,43. En este caso, si tenemos una publicación extraordinariamente citada, sólo ocupará el primer puesto del rango, pero el h se mantendrá inalterado.

- d)

Valora un esfuerzo científico prolongado durante toda la vida profesional o académica, frente a verdaderos «pelotazos» –éxitos fulgurantes, pero aislados– que pueden tener un impacto muy alto, pero claramente acotado42,43. El factor h aspira a constituirse en el indicador que exprese mejor el nivel medio de visibilidad internacional de todos los trabajos de un autor, por lo que su creador lo ha llamado «indicador de carrera». En resumen, el valor del número h representa la biografía científica de un autor, pues no mide inmediatez, sino grandes períodos23.

- e)

Tiene capacidad predictiva. El índice h ha demostrado ser capaz de predecir con más precisión que otros indicadores bibliométricos (como el número total de artículos o de citas) la progresión de la carrera científica y los logros futuros de los autores53. Esto no es de extrañar, pues, como se ha mencionado previamente, el índice h permite valorar al autor con más perspectiva que otros indicadores. Esta capacidad es especialmente relevante, ya que, al asignar recursos a un determinado investigador, lo que a las agencias de evaluación realmente les interesa es conocer no sólo sus logros pasados, sino también, sobre todo, la probabilidad de que este éxito se confirme en el futuro.

- f)

Es difícil de falsear, porque es muy difícil manipular una carrera científica o académica entera54.

Como no podía ser de otro modo, no todo son ventajas y el índice h tiene también sus inconvenientes55. Aunque se han propuesto algunas variantes o modificaciones de este índice con la intención de solucionar estos problemas, algunas de sus limitaciones son inherentes a las características de cálculo del número h y, por tanto, difíciles o imposibles de solventar55. A continuación se resumen las limitaciones principales del índice h.

- a)

No tiene en cuenta la calidad de las revistas en las que se publican los artículos, lo que constituye una limitación importante, dado que hay notables diferencias entre publicaciones en cuanto a los filtros de calidad impuestos a los documentos51. De hecho, algún estudio plantea ciertas dudas sobre la verdadera exactitud de este índice para valorar la capacidad investigadora de los autores56 o sobre la auténtica superioridad respecto a los índices bibliométricos tradicionales (como el mero cálculo del número de publicaciones o de citaciones57,58). Por tanto, al ignorar el «factor de impacto» de las revistas en las que se publican los artículos, se ha indicado que el índice h podría, al menos teóricamente, ser artificialmente inflado con citas provenientes de revistas «mediocres y de nivel bajo»51.

- b)

Tiende a favorecer a los que cuentan con carreras científicas más dilatadas y tiene menos validez en los más jóvenes, debido a que el índice h depende del número total de citas y de documentos de los investigadores18,51,55,57. Para comparar autores en distintas fases de su carrera investigadora, Hirsch introdujo el valor m, que resulta de dividir h entre la «edad científica» del investigador (esto es, los años transcurridos desde su primera publicación); se han descrito cifras de m entre 1,4 y 3,9 para los científicos de nivel alto57. Otra alternativa para comparar investigadores en distintas etapas de su carrera es calcular el índice h para un determinado período (por ejemplo, los últimos 10 o 15 años) en lugar de para toda su vida profesional59. No obstante, la consideración de que uno de los inconvenientes del índice h es que no trata «adecuadamente» a los investigadores jóvenes no es tan evidente. Así, es preciso tener en cuenta que este índice informa del impacto que en su área científica ha tenido la producción total de un investigador. En este sentido, algunos han argumentado que el hecho de que no sea grande para un investigador joven no es ni un defecto ni una debilidad del índice h, ya que, salvo casos excepcionales, el impacto en su área científica no ha podido ser grande49; y que habrá que esperar para ver si trascurrido el tiempo el joven investigador llega o no a alcanzar un índice h elevado que demuestre que el impacto en su área científica ha sido realmente destacado49.

- c)

Tiene una notable dependencia del número total de documentos publicados, de forma que, como es lógico, el índice h nunca puede ser superior al número total de artículos59. De este modo, una persona con 10 documentos nunca podrá tener un índice h superior a 10, independientemente del número de citas que reciban sus artículos. Esto nos lleva a pensar que el índice h penaliza a los autores que presentan estrategias de publicación «selectivas»48,60, es decir, a aquéllos que tienden a primar calidad frente a cantidad: no publican un número de documentos muy elevado, pero sus contribuciones son muy relevantes y producen un impacto alto en la comunidad científica (medido por el número de citas recibidas); es decir, publican menos, pero publican mejor59.

- d)

No tiene en cuenta el número de autores ni el orden de éstos en el artículo en cuestión, de modo que puntúa de igual modo un artículo en el que el autor firma en solitario y otro en el que ocupa, por ejemplo, el vigésimo lugar61. Consecuentemente, tanto el índice h como los demás índices bibliométricos tienden a favorecer las disciplinas científicas en las que trabajan grandes grupos. Para corregir este problema, el propio Hirsch sugirió normalizar el índice h por un factor que reflejara el promedio de coautores41,55,62. Otros han propuesto un método probablemente más preciso, que consiste en puntuar a cada artículo de acuerdo con la inversa del número de autores61. Si bien es cierto que si no se realiza la corrección por el número de autores se perjudica a los grupos pequeños, si ésta se hace se puede, por una parte, perjudicar a los investigadores jóvenes a quienes se han impuesto autores cuya justificación es discutible y, por otra, puede diluir el trabajo de dirección del autor senior del estudio18. Este problema no tiene una solución formal y las comisiones de evaluación deberían de prestar una atención especial a la coherencia de las líneas de trabajo y a la posición del evaluado entre los autores de los trabajos que dan origen a su índice h18.

- e)

Podría permitir a un investigador «dormirse en los laureles», dejando que sus artículos «hagan el trabajo por él», ya que el número de citaciones recibidas puede seguir incrementándose, incluso si no se publican nuevos artículos41,44–46. De este modo, se ha indicado que el número h no sería un buen índice para diferenciar entre científicos en activo y retirados55.

- f)

Es inadecuado para comparar investigadores de diferentes áreas científicas, lo que se explica por los distintos hábitos de publicación y citación, según el campo a que se dedique el autor18,44–46,57,59,63,64. Por ejemplo, los investigadores más relevantes en biología doblan en sus valores de índice h a los de otras áreas, como la física, y éstos a su vez se sitúan muy por encima de las matemáticas59. Las diferencias están causadas, en parte, por la dependencia de h del tamaño de la población que potencialmente puede citar el trabajo: si son muchos los investigadores trabajando en una materia, las citas probablemente serán mayores que en una comunidad científica pequeña19,24. En el caso de la medicina, son claras las diferencias atendiendo al carácter básico o clínico de la actividad: las áreas clínicas con frecuencia presentan una productividad menor, ya que sus profesionales suelen primar la asistencia sanitaria frente a la investigación y la publicación de resultados25. El problema fundamental es que incluso dentro de una misma especialidad (por ejemplo médica) puede haber también diferencias que impidan la comparación correcta entre 2 autores, debido a que los temas de investigación más «populares» o más «de moda» tendrán, teóricamente, más posibilidad de citarse19,24,57. Desde la perspectiva opuesta, debe considerarse que los científicos que no trabajan en las áreas principales de las disciplinas reciben normalmente un número de citas menor, lo que puede reducir su índice h. Como respuesta a esta limitación, han surgido distintas modificaciones del índice h orientadas a facilitar las comparaciones entre áreas62,64,65, cuya descripción detallada escapa al objetivo del presente artículo.

- g)

Hay también limitaciones técnicas, ya que, aunque las principales bases de datos que incluyen citas (como la Web of Science) proporcionan diversas herramientas para facilitar la identificación de los documentos de un autor, e incluso permiten el cálculo automático del índice h, los problemas de homonimia, variantes de firma de los autores, errores tipográficos y falta de normalización pueden dificultar la obtención correcta y fiable de este indicador44–46,59. No obstante, se ha argumentado que es de esperar que los errores afecten de manera similar a todos los autores, aunque esto podría no ser necesariamente así66.

En opinión de Hirsch, el índice h indica que si 2 científicos tienen la misma h, estos científicos son comparables en términos de impacto científico global, con independencia de que su número de publicaciones o el número total de citas sean diferentes. Por otro lado, en el caso de 2 científicos con un número similar de trabajos y de citas, un índice h más elevado de uno de ellos indica que este científico tiene un reconocimiento mayor y un impacto mayor en su campo que el otro. Dicho esto, es pertinente recalcar de nuevo que el índice h es inadecuado para comparar investigadores de diferentes áreas científicas.

Los procedimientos de selección de las agencias evaluadoras u otros organismos científicos pueden ser vistos por algunos como opacos, endogámicos y caprichosos54; por ello, el método de Hirsch podría servir para justificar la toma de decisiones de financiación o de promoción académica de un modo transparente, justo y difícil de falsear, porque descansa sobre el conjunto de trabajo realizado durante muchos años54. De hecho, se ha recomendado que el índice h se calcule para períodos de más de 10 años, ya que a mayor período evaluado, mayor será la exactitud con la que se valora la trayectoria de un autor23.

Se podrían establecer diferentes intervalos de valores h para acceder a ciertos reconocimientos científicos o docentes (plaza de profesor, miembro de academia, etc.)54,67. La carrera científica o académica consistiría, en este caso, en ir obteniendo reconocimientos a medida que se van superando umbrales h42,43. La posibilidad de ir escalando valores h es cada vez más difícil, pues a medida que se avanza requiere de mayor esfuerzo, por lo que su proyección no es lineal42,43.

Hirsch sugiere, con cautelas, los valores de h que, de forma automática, deberían conducir a obtener una plaza permanente en la universidad y a progresar en la carrera científica, incluido el nombramiento de miembro de la National Academy of Sciences de Estados Unidos (que para los físicos sería de h=45). En el caso de las ciencias físicas, Hirsch concluye que un factor h=20 después de 20 años de actividad científica es característico de una carrera coronada por el éxito; factores h=35-45 después de 20 años sólo se dan entre los mejores científicos; y un factor h=60 caracterizaría a un individuo singular, excepcionalmente dotado para la ciencia41. Se ha indicado que, en física, un científico considerado productivo tiene un h por lo menos igual a la cantidad de años que lleva trabajando, mientras que en la ciencia biomédica estos valores son generalmente más elevados41.

A modo de ejemplo, cuando Hirsch publicó su artículo en agosto de 2005 tenía un h de 4968. En un artículo divulgativo sobre el índice h, García69 indicaba que el valor medio de los últimos 3 premios españoles de física era h=34, y que el índice h de los candidatos más destacados en un concurso de promoción interna del Centro Superior de Investigaciones Científicas fue de 7; un equivalente, la promoción a profesor asociado en una universidad de investigación de Estados Unidos requiere un h=1228. Iglesias y Pecharroman70, por su parte, han encontrado una gran diferencia en los valores del índice h de científicos españoles de diferentes disciplinas científicas, entre los que se incluyen Corma (química, h=60), Rodés (medicina clínica, h=84), Herrera (ecología, h=35), Sánchez Madrid (inmunología, h=35), Nualart (matemáticas, h=15), Sanz Serna (matemáticas, h=21), Vázquez (matemáticas, h=22), Barbacid (biología molecular, h=79), Palacios (neurociencia, h=72), Aguilar Benítez (física, h=38) y Duarte (ciencias de las plantas y animales, h=38).

Hirsch demostró que el índice h tiene importantes capacidades predictivas en relación con los honores que un científico haya recibido, como el Premio Nobel. Éste es un dato muy relevante, pues indica que un Nobel, antes de obtener el premio, ha tenido una carrera muy fructífera y exitosa. También desmonta el mito, defendido en ocasiones, de que un Premio Nobel representa un golpe de suerte y, por tanto, al alcance de una gran mayoría de científicos28. Así, la mayor parte de los premios Nobel de los últimos 20 años acumulan un h entre 35 y 39, aunque las cifras oscilan según la disciplina23.

Por último, un h=0 caracteriza, obviamente, a un autor científicamente inactivo que ha publicado, como mucho, algún artículo que no ha tenido ningún impacto (esto es, que ningún otro autor ha citado)46.

ConclusionesLa ciencia realmente no existe hasta que se publica2. Hoy más que nunca es preciso estar convencidos de que los manuscritos deben escribirse para dejar constancia de los descubrimientos científicos, y no sólo para justificar el currículum vitae del autor71. Autoría significa autenticidad y autoridad72, e implica un grado de responsabilidad alto2.

La evaluación de un autor tiene pleno sentido en un sistema competitivo en el que la puntuación más elevada tiene efectos en la carrera del investigador o en el acceso a financiación. Por tanto, la instauración de sistemas de evaluación de la actividad científica es hoy día una necesidad ineludible, ya que es la única forma de mejorar los recursos, siempre limitados, que se destinan a la investigación25. El dogma central de la evaluación es que ningún parámetro sencillo puede igualar a la revisión «por pares», pero ésta es una evaluación compleja que conlleva notables dificultades18. Los indicadores bibliométricos constituyen una herramienta valiosa para el estudio de la actividad científica, siempre y cuando se utilicen de forma adecuada, para lo cual es necesario conocer sus condiciones óptimas de aplicación y sus limitaciones25. La ciencia es una actividad multidimensional, en la que participan simultáneamente elementos científicos, económicos y sociales. Esta realidad multidimensional complica enormemente los procesos de evaluación de la actividad científica, para los cuales se requiere el uso combinado de diversos indicadores25,29,73. Ello permite aprovechar las fortalezas de cada uno de ellos y reducir sus posibles efectos adversos en la actividad de los investigadores y en el funcionamiento del sistema científico, que en último término repercutirán en la salud de nuestra ciencia.

El principal papel de los indicadores bibliométricos no es reemplazar a los expertos, sino facilitar sus decisiones y aportar objetividad y transparencia a los procesos de evaluación. No cabe duda de que, a pesar de las objeciones que se pueden y se deben hacer a los indicadores bibliométricos, éstos constituyen en la actualidad una herramienta útil y objetiva que facilita una mejor comprensión y evaluación de la actividad investigadora25. No obstante, hemos visto que el simple recuento de publicaciones de cada investigador es un indicador poco fiable para medir la aportación que ha hecho al progreso de la ciencia. Se ha revisado que la capacidad de ser citado por otros autores traduce un determinado reconocimiento o crédito que la comunidad científica otorga a un trabajo –impacto, ergo sum30–. Sin embargo, la utilización del número de citas que reciben los trabajos como indicador bibliométrico tiene también algunas limitaciones, lo que hace posible que los éxitos fulgurantes pero aislados, las colaboraciones afortunadas pero casuales, y hasta los pelotazos científicos inusitados, puedan primar sobre el valor de una carrera seria y sostenida en el tiempo74. Hemos concluido, además, que es imposible predecir la calidad o la relevancia científica de un trabajo tomando como indicador el «factor de impacto» de la revista en la que se ha publicado, y hemos llegado a la conclusión, por tanto, de que este índice debería desterrarse de las evaluaciones científicas (o al menos complementarlo con otros indicadores). Como jocosamente se señala en un artículo de difusión reciente, resulta curioso que Hirsch, un físico antiarmamentista y ferviente activista en contra de las armas nucleares, haya lanzado una verdadera «bomba h» al núcleo duro de los miembros «impactoadictos» de la comunidad científica42,43.

El índice h, propuesto por Hirsch hace tan sólo 3 años, ha revolucionado el mundo de la evaluación de la investigación científica, al representar un equilibrio entre el número de publicaciones y las citas a éstas; dicho de otro modo, la principal ventaja del índice h es que combina en un solo indicador una medida de cantidad y otra del impacto de la producción. Este índice se diseñó para medir de forma eficaz la calidad del investigador, a diferencia de otros sistemas de medición más imperfectos que cuentan meramente citas o publicaciones; por ello, el índice h permite diferenciar a los investigadores con gran influencia en el mundo científico de los que simplemente publican muchos trabajos. Algunas agencias nacionales con responsabilidad para la evaluación de la actividad científica (por ejemplo, en Brasil) ya lo han adoptado como uno de sus criterios para la asignación de recursos financieros16.

El índice h refleja de manera bastante aproximada el éxito de un investigador y la evolución de su trabajo, lo que indica que el método de Hirsch será un hito que marque un antes y un después en materia de evaluación científica19,24. El índice h mide el recorrido de un autor, su biografía como científico. Lo importante no es el valor de h, sin más, sino las diferencias en h entre los autores. Así, el índice h parece ser un indicador equitativo y justo para realizar rankings de científicos (siempre dentro de la misma disciplina)54.

La creciente popularidad del índice h conlleva el riesgo de pretender reducir la evaluación a un solo indicador, a pesar de que, como se ha mencionado, la investigación es un proceso multidimensional que difícilmente se puede reducir a una dimensión única48,51,55,57,59,68. Evidentemente, no se puede resumir el trabajo de toda una vida en un simple número –el número h–. Como ya señaló el mismo Hirsch, un número único sólo puede dar una aproximación al perfil multifacético de un investigador y debe considerarse en combinación con otros factores al evaluar a dicho científico. El índice h no va a resolver todos los problemas de cuantificación de la productividad científica, pero es evidente que considerar únicamente el número de publicaciones o el «índice de impacto» de ellas tampoco basta. En cualquier caso, el valor numérico del índice h tampoco es suficiente para llevar a cabo una evaluación rigurosa y, para ello, sería necesario disponer de las referencias completas de todos los trabajos que conforman dicho índice y la suma total de citas de estos trabajos18.

La implantación de cualquier sistema de evaluación acaba por modificar el proceso evaluado. Los investigadores reaccionan a la evaluación y adaptan su comportamiento a ésta. Los cambios inducidos por los sistemas de evaluación no siempre son positivos, sino que pueden producir efectos no deseados, como priorizar cantidad frente a calidad de las publicaciones, disuadir a los investigadores de involucrarse en proyectos de alto riesgo o favorecer la investigación encaminada a obtener resultados a corto plazo, entre otros. Por todo ello, antes de introducir y aceptar como bueno cualquier indicador, es importante prever sus posibles «efectos adversos» en la actividad de los investigadores.

En resumen, el índice h es un indicador prometedor, sin duda, pero presenta también importantes limitaciones, por lo que su empleo requiere cautela. Todavía desconocemos cuál será el alcance, la validez y la futura aplicación del índice h, pero, si resiste el escrutinio de la comunidad científica, este índice debería ser un elemento a considerar en el proceso de selección y evaluación de los científicos28.

Agradecemos sinceramente a María Bordons (Centro de Información y Documentación Científica [Cindoc], Consejo Superior de Investigaciones Científicas [CSIC]) la lectura crítica del manuscrito que ha hecho y sus valiosos comentarios.