The knowledge of student's representations constitutes a fundamental element in teaching planning. When a great number of data must be considered, knowledge of the diversity of representations in the classroom may be difficult. The teacher's usual point of view, required for certification of knowledge, seems not to be an adequate scheme in these cases. In this article we show an alternative diagnostic assessment technique based on a phenomenographic frame which gives a way to the identification of alternative ideas together with a comparative analysis with traditional evaluation methods. The shown phenomenographic based technique not only provides an option to the quality control point of view held in the traditional assessment scheme but also a useful tool in the detection of representations.

En la evaluación del proceso de enseñanza y aprendizaje desde una perspectiva pedagógica que implica una construcción de conocimiento (Sverdlick, 2008), se recorren siempre ciertas etapas: a) recolección de información, b) análisis de esta información y juicio sobre el resultado de este análisis, y c) toma de decisiones de acuerdo con el juicio emitido (Sanmartí y Alimenti, 2004).

Estas últimas autoras identifican funciones de la evaluación que orientan la toma de decisiones. El tipo de decisiones tomadas diferencia las funciones de la evaluación que pueden ser de carácter social o de carácter pedagógico. La calificación, por ejemplo, es de carácter social y pretende constatar el progreso de los alumnos sobre un determinado conocimiento en un sistema de certificación. La evaluación formativa, de carácter pedagógico, propone por otra parte identificar los cambios que se han de introducir (en la práctica docente y/o en el proceso de aprendizaje de los alumnos) para acompañar la construcción del conocimiento (Black y Wiliam, 1998; Scaife, 2010). Este proceso en la práctica docente podría llevar a lamejora de la calidad de la educación a través de la formación permanente de educadores que analizan su propia práctica (Freire, 1994 en Sverdlick, 2008).

Sanmartí y Alimenti (2004) señalan también tres instancias de aplicación de la evaluación durante el proceso de aprendizaje: 1) la inicial, que permite un diagnóstico sobre concepciones previas, procedimientos intuitivos y actitudes presentes en los estudiantes; 2) la realizada durante el proceso de enseñanza, que posibilita identificar representaciones y estrategias que los alumnos utilizan (Allal, 1979) en la construcción del conocimiento, y 3) la final, que pretende detallar los conocimientos incorporados y la calidad del proceso de enseñanza utilizado.

Con la tercera instancia señalada, la más habitual, se pretende valorar a cada individuo de acuerdo al grado de incorporación de contenidos, con la suposición de que ese individuo recorrió un proceso casi lineal de acumulación de conocimiento cuyo nivel quedaría indicado mediante la escala de valoración. El uso de esta información se remite al cumplimiento del rol institucional de certificar ese nivel en el alumno sin ninguna pretensión de modificar lo ocurrido durante el curso. Si se acude a encuestas apuntadas a detectar ideas alternativas, tal como cuestionarios de opción múltiple de dos niveles (Treagust, 1995; Treagust,1988; Tan y otros, 2002), su uso será planteado al inicio del curso o tema y, en caso de pretender una comparación para identificar cambios en las representaciones, también podrá usarse al final. En este caso, dicha comparación se podría relacionar con lo trabajado durante el curso y, por su implementación temporal, la encuesta podría contemplarse como una evaluación final. A diferencia de lo que sucede con un examen tradicional, apuntado sólo a la valoración individual de nivel de acumulación de conocimientos, en esta comparación y en su interpretación quedaría implícito un análisis colectivo del proceso de enseñanza y aprendizaje desarrollado (Treagust, 2006).

A la hora de valorar la producción de los estudiantes en la evaluación existen distintas maneras de considerar el nivel alcanzado por cada estudiante (Johnstone, 2003). Por una parte puede tomarse un estándar arbitrario de mínima, que se aplica a la distribución de notas obtenidas. Tal criterio, llamado Norma de referencia, a veces intuitiva o bien a través de una política institucional, sólo permite una comparación de lo alcanzado por cada estudiante en una determinada evaluación; no es posible la comparación con otras instancias de evaluación. Otra manera es la aplicación de un Criterio de referencia, donde el evaluador es el experto que tiene un claro estándar en mente y decide cuándo el estudiante cubre los requerimientos mínimos aceptables sobre el tema.

¿Qué sucede si se analizaran los resultados de una encuesta que pretende identificar ideas alternativas en los estudiantes, desde un marco de referencia de examen tradicional para acreditar?

En lo que sigue se muestran comparativamente las consecuencias de analizar las respuestas a un instrumento concebido desde una perspectiva de identificación de representaciones desde un marco de examen tradicional y desde una mirada “más amplia” de las mismas respuestas.

El instrumento utilizado y la población encuestadaAl finalizar un curso de Química General se aplicó una encuesta a 69 estudiantes de primer año de la Licenciatura en Alimentos de la Universidad Nacional del Noroeste de la Provincia de Buenos Aires (unnoba), Argentina. La misma se estructuró en torno a cinco ítems, con siete opciones de respuesta no excluyentes para cada uno. Las cuestiones abordadas cubrían aspectos como conservación de la materia (ítem 1) elaborado a partir de Landau y Lastres (1996), el uso de una representación submicroscópica en un sistema (ítem 5), y niveles de descripción macroscópicos y submicroscópicos para los estados de agregación y modelos discreto y continuo (ítems 2, 3 y 4, ver tabla 1) (Mortimer, 1998). En este trabajo se analizan las respuestas a los ítems incluidos en la tabla 1.

ÍtemS 2, 3 y 4 de la encuesta utilizada, referidos a estructura de la materia.

| 2) Considera una jeringa con aire, que tiene tapada la salida. Si empujas el émbolo podrás desplazarlo hasta cierto punto haciendo que el espacio ocupado por el aire disminuya. ¿Qué te parece que sucede? Responde eligiendo una o más de las siguientes posibles respuestas: |

| a) disminuye el volumen de aire; |

| b) disminuye el volumen de las partículas que lo forman; |

| c) disminuye el espacio entre las partículas que lo forman; |

| d) no cambia el volumen de aire; |

| e) no cambia el volumen de las partículas que lo forman; |

| f) no cambia el espacio entre las partículas que lo forman; |

| g) ninguna de las anteriores. |

| 3) Considera una jeringa con agua, que tiene tapada la salida. Si empujas el émbolo podrás desplazarlo, con algún esfuerzo, hasta cierto punto haciendo que el espacio ocupado por el agua disminuya. ¿Qué te parece que sucede? Responde eligiendo una o más de las siguientes posibles respuestas: |

| a) disminuye el volumen de agua; |

| b) disminuye el volumen de las partículas que la forman; |

| c) disminuye el espacio entre las partículas que la forman; |

| d) no cambia el volumen de agua; |

| e) no cambia el volumen de las partículas que la forman; |

| f) no cambia el espacio entre las partículas que la forman; |

| g) ninguna de las anteriores. |

| 4) Considera un recipiente cilíndrico rígido lleno de plastilina y provisto de un pistón en la parte superior. Mediante un dispositivo de alta presión se empuja el pistón hacia abajo haciendo que el espacio ocupado por la plastilina disminuya. ¿Qué te parece que sucede? Responde eligiendo una o más de las siguientes posibles respuestas: |

| a) disminuye el volumen de plastilina; |

| b) disminuye el volumen de las partículas que la forman; |

| c) disminuye el espacio entre las partículas que la forman; |

| d) no cambia el volumen de plastilina; |

| e) no cambia el volumen de las partículas que la forman; |

| f) no cambia el espacio entre las partículas que la forman; |

| g) ninguna de las anteriores. |

Los encuestados fueron provistos de una planilla para anotar sus respuestas a cada ítem junto con sus datos de identificación. Aunque los estudiantes podían ser identificados, la idea central no fue certificar sus conocimientos en particular sino obtener categorías de la diversidad de representaciones existente en el grupo y situarse respecto de las mismas, al contemplar el conjunto de respuestas.

Los resultados obtenidos y su análisis desde una visión tradicionalAl considerar las respuestas desde un punto de vista tradicional, por ejemplo al utilizar un Criterio de referencia, el docente se plantearía la evaluación desde tres premisas: (i) la existencia de respuestas asumidas como correctas; (ii) un modelo de estudiante examinado y (iii) la idea asignada a cualquier instancia de evaluación, desde esta perspectiva y un marco de control, de que el docente debe certificar el estado de conocimientos de cada estudiante.

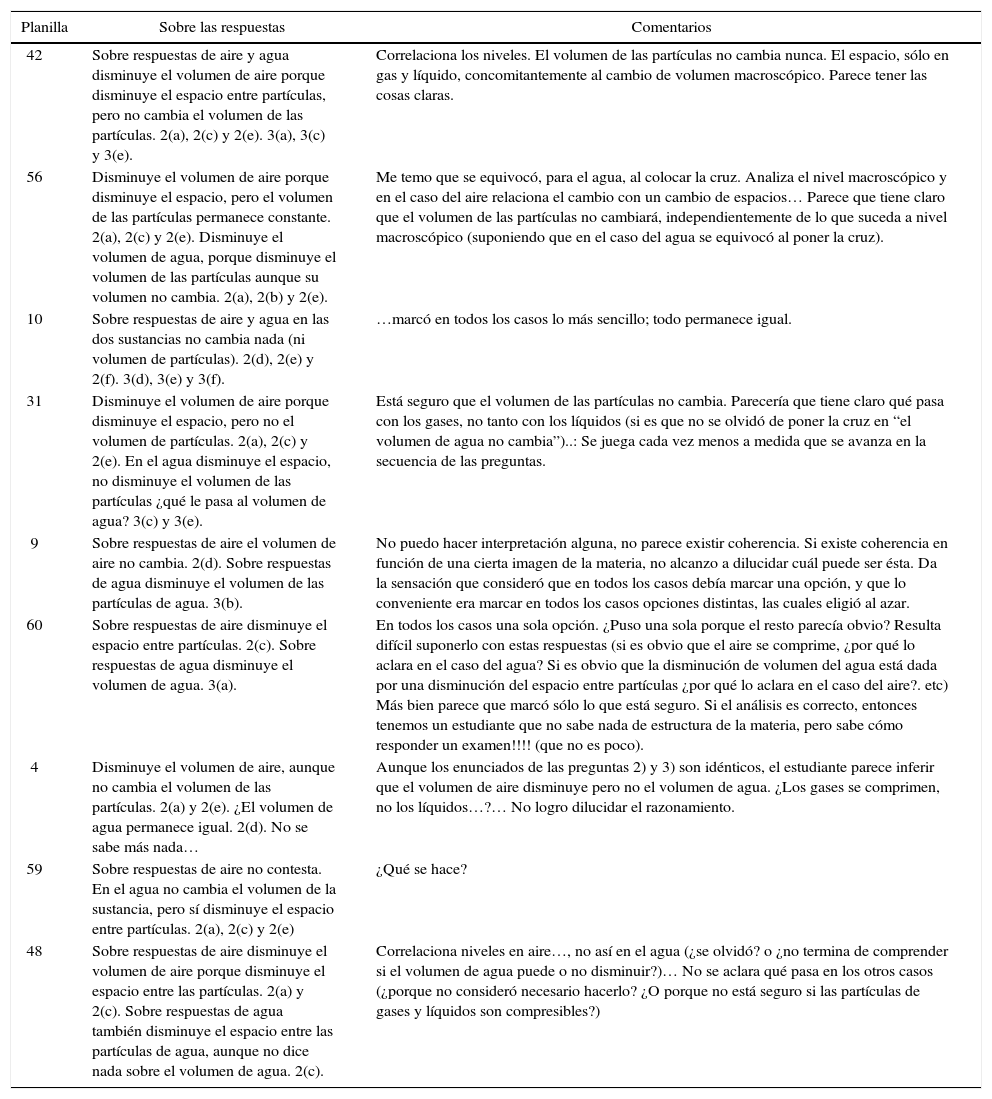

La búsqueda se centraría, según la premisa (i), en lo que debería ser respondido en el contexto de lo enseñado: a cada pregunta le corresponderá una única respuesta válida. Como ejemplo, se incluye un análisis de este tipo efectuado y co mentado por un docente del curso encuestado (ver tabla 2).

Análisis de la encuesta con un enfoque hacia la certificación. Los números en la columna de la izquierda identifican a cada estudiante.

| Planilla | Sobre las respuestas | Comentarios |

|---|---|---|

| 42 | Sobre respuestas de aire y agua disminuye el volumen de aire porque disminuye el espacio entre partículas, pero no cambia el volumen de las partículas. 2(a), 2(c) y 2(e). 3(a), 3(c) y 3(e). | Correlaciona los niveles. El volumen de las partículas no cambia nunca. El espacio, sólo en gas y líquido, concomitantemente al cambio de volumen macroscópico. Parece tener las cosas claras. |

| 56 | Disminuye el volumen de aire porque disminuye el espacio, pero el volumen de las partículas permanece constante. 2(a), 2(c) y 2(e). Disminuye el volumen de agua, porque disminuye el volumen de las partículas aunque su volumen no cambia. 2(a), 2(b) y 2(e). | Me temo que se equivocó, para el agua, al colocar la cruz. Analiza el nivel macroscópico y en el caso del aire relaciona el cambio con un cambio de espacios… Parece que tiene claro que el volumen de las partículas no cambiará, independientemente de lo que suceda a nivel macroscópico (suponiendo que en el caso del agua se equivocó al poner la cruz). |

| 10 | Sobre respuestas de aire y agua en las dos sustancias no cambia nada (ni volumen de partículas). 2(d), 2(e) y 2(f). 3(d), 3(e) y 3(f). | …marcó en todos los casos lo más sencillo; todo permanece igual. |

| 31 | Disminuye el volumen de aire porque disminuye el espacio, pero no el volumen de partículas. 2(a), 2(c) y 2(e). En el agua disminuye el espacio, no disminuye el volumen de las partículas ¿qué le pasa al volumen de agua? 3(c) y 3(e). | Está seguro que el volumen de las partículas no cambia. Parecería que tiene claro qué pasa con los gases, no tanto con los líquidos (si es que no se olvidó de poner la cruz en “el volumen de agua no cambia”)..: Se juega cada vez menos a medida que se avanza en la secuencia de las preguntas. |

| 9 | Sobre respuestas de aire el volumen de aire no cambia. 2(d). Sobre respuestas de agua disminuye el volumen de las partículas de agua. 3(b). | No puedo hacer interpretación alguna, no parece existir coherencia. Si existe coherencia en función de una cierta imagen de la materia, no alcanzo a dilucidar cuál puede ser ésta. Da la sensación que consideró que en todos los casos debía marcar una opción, y que lo conveniente era marcar en todos los casos opciones distintas, las cuales eligió al azar. |

| 60 | Sobre respuestas de aire disminuye el espacio entre partículas. 2(c). Sobre respuestas de agua disminuye el volumen de agua. 3(a). | En todos los casos una sola opción. ¿Puso una sola porque el resto parecía obvio? Resulta difícil suponerlo con estas respuestas (si es obvio que el aire se comprime, ¿por qué lo aclara en el caso del agua? Si es obvio que la disminución de volumen del agua está dada por una disminución del espacio entre partículas ¿por qué lo aclara en el caso del aire?. etc) Más bien parece que marcó sólo lo que está seguro. Si el análisis es correcto, entonces tenemos un estudiante que no sabe nada de estructura de la materia, pero sabe cómo responder un examen!!!! (que no es poco). |

| 4 | Disminuye el volumen de aire, aunque no cambia el volumen de las partículas. 2(a) y 2(e). ¿El volumen de agua permanece igual. 2(d). No se sabe más nada… | Aunque los enunciados de las preguntas 2) y 3) son idénticos, el estudiante parece inferir que el volumen de aire disminuye pero no el volumen de agua. ¿Los gases se comprimen, no los líquidos…?… No logro dilucidar el razonamiento. |

| 59 | Sobre respuestas de aire no contesta. En el agua no cambia el volumen de la sustancia, pero sí disminuye el espacio entre partículas. 2(a), 2(c) y 2(e) | ¿Qué se hace? |

| 48 | Sobre respuestas de aire disminuye el volumen de aire porque disminuye el espacio entre las partículas. 2(a) y 2(c). Sobre respuestas de agua también disminuye el espacio entre las partículas de agua, aunque no dice nada sobre el volumen de agua. 2(c). | Correlaciona niveles en aire…, no así en el agua (¿se olvidó? o ¿no termina de comprender si el volumen de agua puede o no disminuir?)… No se aclara qué pasa en los otros casos (¿porque no consideró necesario hacerlo? ¿O porque no está seguro si las partículas de gases y líquidos son compresibles?) |

Con respecto a la premisa (ii), el docente realizaría su análisis con una idea preconcebida acerca de las conductas del estudiante en situación de examen. El estudiante genérico, en esta concepción, responderá (si no tiene ideas claras) tratando de esquivar la prueba o superarla acudiendo al azar o a cualquier medio. En los comentarios del docente identificados como planillas 10, 31, 9 y 60 incluidos en la tabla 2 se pueden ver ejemplos sobre este aspecto.

En la tabla 3 se incluyen expresiones y conclusiones del mismo docente que reflejarían el intento de controlar el desarrollo del proceso de aprendizaje como si se tratara de una línea de producción en serie. En la segunda y tercera columna se han incluido expresiones y conclusiones del docente.

Categorías de análisis identificadas junto con expresiones y conclusiones del docente.

| Ámbito de análisis donde aparecen dificultades | Expresiones del docente ante las dificultades encontradas | Conclusiones referidas a las dificultades | |

|---|---|---|---|

| 0 | Hay algunas dificultades generales. | ||

| I | Búsqueda de coherencia interna. | Me resulta extremadamente difícil no tener en cuenta la coherencia interna de las respuestas. | No sé si es bueno o malo. |

| II | Búsqueda de relación en los datos hallados. | Tengo pilas de hojas intentando extraer conclusiones de a una variable (o de lo que consideré como variables) o cruzando de a dos o de a tres. | Ninguna de estas cosas me llevó a algún lado. |

| III | Búsqueda de conclusiones relacionadas con cada estudiantes encuestado. | Creo que la gran conclusión, que orbita a lo largo y ancho de las encuestas es que los estudiantes no leen el enunciado, si lo leen no lo interpretan, y si lo interpretan no hacen caso. | Conclusión rutinaria de cualquier examen, pero en un examen ya aprendí (bien o mal) a manejarlo. Aquí no sé realmente qué hacer. |

| IV | Búsqueda de conclusiones sobre el conjunto de encuestas. | Evidentemente hay encuestas que no deberían tenerse en cuenta. Supongo que siempre hay encuestas que no deberían tenerse en cuenta, salvo que el objetivo sea evaluar el ruido de fondo. | El problema es que sé cómo detectar los datos locos en una curva de calibración, pero no sé si las encuestas que creo que operan como ruido que entorpece el análisis, son realmente ruido o son significativas. |

En la primera de las conclusiones mostradas en la tabla 3 se reiteran las tres premisas enunciadas, mientras que en la segunda se refleja el desconcierto de no poder generalizar los datos obtenidos. Con la tercera conclusión se vuelve sobre el modelo de estudiante para intentar atenuar el desconcierto. En la última afirmación se refleja el marco teórico implícito desde el que se pretende analizar la información obtenida: se ha partido de la idea de investigación habitual en ciencias naturales, donde el significado de “medición” no se discute, el objeto de estudio es invariante durante el registro y se presume un resultado correcto obtenible desde métodos estadísticos. Los interrogantes acerca de lo significativo, el “ruido de fondo” o la posibilidad de comparar este proceso con las curvas de calibración habituales en tareas de laboratorio conducen a discutir la metodología para abordar la información obtenida, el instrumento utilizado y el marco desde el cual se generó.

Con estos criterios, explícitos o no, un docente que certifica conocimientos tendrá como objeto de estudio a cada estudiante y su mirada integral será la de un conjunto de individuos aislados. Los matices en las respuestas personales podrían constituir obstáculos para hallar conclusiones generales. Si la búsqueda está signada por la dualidad correcto-incorrecto el resultado se reducirá a establecer cuántos estudiantes responden “bien” y cuántos “mal”, según el “conocimiento oficial” del docente.

Tal mirada resulta distante de la denominada evaluación formativa, aspecto central del proceso de enseñanza y aprendizaje (Sanmartí y Alimenti, 2004). Si se considera a dicho proceso como objeto de estudio, en cambio, la interpretación de los resultados puede permitir distinguir grupos de alumnos con ideas similares y sugerir actividades diferenciadas para cada grupo (Scaife, 2010).

La finalidad, en el presente trabajo, fue la de identificar y evaluar todas las representaciones sobre estructura de la materia presentes en el universo encuestado. Es decir, reconocer la diversidad de representaciones y considerar sus características para su posible empleo en el aula. Para el análisis de dicha información, si bien se podría haber utilizado un tratamiento estadístico, se acudió a un marco cualitativo como el fenomenográfico (Marton, 1981; Ebenezer y Fraser, 2001).

Otro análisis de las respuestasEn el punto de vista fenomenográfico no se establecen categorías a priori sino que ellas deben surgir del análisis de lo expresado por los encuestados, al caracterizar el denominado espacio de representaciones respecto de un tema o contenido específico. Mediante una búsqueda sistemática de similitudes en el conjunto de respuestas se llega a la generación de categorías. La disposición particular de los datos a analizar permite tanto realizar una aproximación estadística como hallar sus generalidades al agruparlos según sus similitudes.

La tabla 4 muestra una porción de planilla Excel con los datos obtenidos con la encuesta de la tabla 1. Un número de orden en la primera columna, permite identificar las respuestas de cada estudiante y también evaluar las respuestas en general. En la fila superior se indican todas las opciones posibles y la opción elegida en cada respuesta se indica mediante un “1” en la casilla correspondiente. Al ordenar los datos según frecuencias de respuestas, independientemente en cada ítem, se obtiene por ejemplo la disposición expuesta en la tabla 5 (en función del ítem 2 que corresponde a gases). Así es posible obtener el conjunto de respuestas más frecuente, la distribución de frecuencias en las respuestas, falta de respuestas a un ítem (aquí indicadas en gris) u otras cuestiones de interés para gases. De modo similar se puede operar sobre el ítem 3 correspondiente a la estructura de líquidos o con el ítem 4 para el estado sólido (el cual no será incluido en este análisis).

Extracto de la planilla general de datos. Sólo se muestran los resultados de los ítems 2, 3 y 4. Cuestiones no respondidas se indican rellenas en gris.

| 2a | 2b | 2c | 2d | 2e | 2f | 2g | 3a | 3b | 3c | 3d | 3e | 3f | 3g | 4a | 4b | 4c | 4d | 4e | 4f | 4g | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 1 | 1 | 1 | ||||||||||||||||||

| 2 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | ||||||||||||

| 3 | 1 | 1 | 1 | 1 | 1 | ||||||||||||||||

| 4 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | |||||||||||||

| 5 | 1 | 1 | 1 | 1 | 1 | 1 | |||||||||||||||

| 6 | 1 | 1 | 1 | 1 | |||||||||||||||||

| 7 | 1 | 1 | 1 | 1 | |||||||||||||||||

| 8 | 1 | 1 | 1 | ||||||||||||||||||

| 9 | 1 | 1 | 1 | 1 | |||||||||||||||||

| 10 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 |

Extracto de planilla con respuestas ordenadas del problema de gas.

| 2a | 2b2 | 2c | 2d | 2e | 2f | 2g | S1 | 3a | 3b | 3c | 3d | 3e | 3f | 3g | S2 | 4a | 4b | 4c | 4d | 4e | 4f | 4g | S3 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 59 | 0 | 1 | 1 | 2 | 1 | 1 | 2 | |||||||||||||||||

| 11 | 1 | 1 2a | 1 | 1 | 1 | 1 | ||||||||||||||||||

| 45 | 1 | 1 | 1 | 1 | 1 | 1 | ||||||||||||||||||

| 64 | 1 | 1 3 | 1 | 1 | 1 | 1 | ||||||||||||||||||

| 18 | 1 | 1 2b | 1 | 1 | 1 | 1 | 1 | 3 | ||||||||||||||||

| 47 | 1 | 1 2 | 1 | 1 | 1 | 1 | ||||||||||||||||||

| 1 | 1 | 1 2c | 1 | 1 | 1 | 1 | ||||||||||||||||||

| 8 | 1 | 1 | 1 | 1 | 1 | 1 | ||||||||||||||||||

| 19 | 1 | 1 3 | 1 | 1 | 2 | 1 | 1 |

Una nueva columna a la derecha en cada ítem (S1, S2, S3, etc.) indica la sumatoria de opciones elegidas en cada caso. A la derecha de la columna sumatoria S1 en la tabla 5, se señala el tipo de respuesta y la cantidad de estudiantes que la eligieron: por ejemplo 2a, 3 significa que 3 alumnos han elegido la respuesta 2a (ver alumnos 11, 45 y 64 en la tabla 5).

Resulta importante identificar diferencias en las representaciones sobre gas, líquido y sólido ya que, en caso de existir, constituirán obstáculos en el abordaje de, por ejemplo, interacciones entre sustancias con distintos estados de agregación (análisis en realización a ser publicado próximamente). Para relacionar las respuestas para gas y líquido en la misma planilla, se toman como base las respuestas para gas de la tabla 5 y se reordena en función de lo respondido para líquido. Al comparar lo obtenido sobre ambas fases se evidencian grupos con respuestas semejantes para ambos estados (ver tabla 6).

Extracto de la planilla para integración de modelos de gas y líquido.

| 2a | 2b | 2c | 2d | 2e | 2f | 2g | 3a | 3b | 3c | 3d | 3e | 3f | 3g | 4a | |||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 58 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 7 | 0 | 1 | contradictories | ||||||||

| 15 | 1 | 1 | 1 | 1 | 4 | 1 | 1 | 1 | 3 | contradictories | |||||||||

| 55 | 1 | 1 | 1 | 1 | 4 | 1 | 1 | contradictories | |||||||||||

| 41 | 1 | 1 | 1 | 3 | 1 | 1 | 1 | 3 | Situación congruente entre ambos problemas. | ||||||||||

| 50 | 1 | 3 | 1 | 3 | 3 | ||||||||||||||

| 62 | 1 | 1 | 1 | 3 | 1 | 1 | 1 | 3 | |||||||||||

| 39 | 1 | 1 | 1 | 3 | 1 | 1 | 1 | 1 | 1 | Existencia de modelo micro para estado gas. No guarda coherencia con modelo líquido. | |||||||||

| 29 | 1 | 1 | 1 | 3 | 1 | 1 | 1 | 3 | Existencia de modelo micro para estado gas. No guarda coherencia con modelo líquido. | ||||||||||

| 56 | 1 | 1 | 1 | 3 | 1 | 1 | 1 | 3 | 2 | ||||||||||

| 44 | 1 | 1 | 1 | 3 | 1 | 1 | 2 | Existencia de modelo micro para estado gas. No guarda coherencia con modelo líquido. |

En columnas auxiliares a los ítems 2 y 3 (ver tabla 6) aparece la suma horizontal de respuestas para ordenar los datos y, más a la derecha, una primera categorización al hacer explícitas las características de respuestas y su relación con las representaciones posibles. Por ejemplo, las tres primeras encuestas (alumnos 58, 15 y 55 en tabla 6), con respuestas 2a y 2d para gas (afirman que el gas se comprime y lo niegan al mismo tiempo), implican un grupo con contradicciones en este estado de agregación; las respuestas distintas para el líquido sugieren una disociación en la representación de ambos estados. Los siguientes tres estudiantes (41, 50 y 62), en cambio, responden con una representación discreta y coherente con lo macroscópico para el gas (2a, 2c y 2e) y de igual modo para el líquido (3a, 3c y 3e).

Al reunir las respuestas en grupos, se pueden identificar categorías de posibles modelos de la materia utilizados para explicar la situación planteada. Por ejemplo, si las respuestas fueron “a-c-e”, implicaría un modelo que vincula lo observable (indicado por la elección de “a”) con una representación discreta (evidenciada en la selección “c-e”). Ese modelo de materia es diferente de aquel que al considerar, por ejemplo, sólo “a” revelaría una mirada estrictamente macroscópica y continua de la situación.

Las categorías finales para gas surgidas del análisis expuesto y volcadas a la tabla 7 constituyen el espacio de representaciones para ese estado de agregación dónde se ha incluido, además, una columna que agrupa las respuestas identificadas con los modelos de materia sugeridos. Es importante indicar que, aunque no coincidan las respuestas, pueden coincidir los modelos de materia que las agrupan. Por ejemplo, un estudiante puede haber respondido “a-e-f” y “b-c-d” y sugerir el mismo modelo de materia. Esto permite simplificar categorías que reúnen a distintos grupos de estudiantes.

Agupación de respuestas en categorías de modelos sugeridos.

| Respuestas | Posible interpretación | Modelo de materia sugerido |

|---|---|---|

| a-e-f | Partículas con características indefinidas. Incongruencia entre observación en el nivel macroscópico y modelo de partículas. | (I) Discreto que no explica observación macroscópica. Disociación entre nivel microscópico y macroscópico. |

| e-f | Partículas con características no expresadas. Incongruencia implícita con nivel macroscópico. | |

| b-c-d | Partículas con características macroscópicas. Incongruencia entre observación en el nivel macroscópico y modelo de partículas. | |

| a-c-e | Partículas con características microscópicas. Coherencia con observación en el nivel macroscópico. | (II) Discreto, coherente con nivel macroscópico. |

| a-e | Partículas con características microscópicas. Coherencia con observación en el nivel macroscópico. | |

| a-c | Partículas con características microscópicas implícitas. Coherencia con observación en el nivel macroscópico. | |

| c-e | Partículas con características microscópicas. Coherencia con observación en el nivel macroscópico. | |

| c | Partículas con características microscópicas no expresadas. Coherencia implícita con observación en el nivel macroscópico. | |

| a-b-c | Partículas de características macroscópicas. Coherencia con nivel macroscópico. | (III) Discreto con características macroscópicas; coherencia con nivel macroscópico. |

| a-b-f | Partículas de características macroscópicas. Coherencia con nivel macroscópico. | |

| b-c | Partículas de características macroscópicas. Coherencia implícita con observación en el nivel macroscópico. | |

| b | Partículas de características macroscópicas. Coherencia implícita con observación en el nivel macroscópico. | |

| b-d | Partículas con características macroscópicas. Coherencia implícita entre observación en el nivel macroscópico y modelo. | (IV) Discreto, con propiedades extrañas de “partículas” o espacio entre ellas. |

| c-d | Partículas con características no expresadas. Coherencia implícita con observación en el nivel macroscópico. | |

| c-d-e | Partículas con características microscópicas. Incongruencia entre observación en el nivel macroscópico y modelo. | (V). Discreto, coherente en sí mismo pero que no acepta lo fenomenológico. |

| d-e-f | Partículas de características no expresadas. Incoherencia con observación en el nivel macroscópico. | |

| e | Partículas con características no expresadas. Coherencia implícita con observación en el nivel macroscópico. | |

| d | No acepta lo fenomenológico. | (VI). Sólo macroscópico; no acepta lo fenomenológico. |

| a | Sólo macroscópico. | (VII). Sólo macroscópico. |

| g | Otras respuestas que no permiten identificar una representación. | (VIII). Otros. |

NS/NCNo sabe o no contesta.

Las categorías aquí identificadas con modelos continuos y discretos de la materia coexistentes coinciden con lo indicado en otros trabajos donde suele aparecer, además del modelo deseable desde el saber escolar, uno que incluye “partículas” con características del continuo (Mortimer, 1995 y 1998; Benarroch, 2000 y 2001; Johnson, 1998). Un proceso similar se puede realizar con las respuestas sobre líquido y sólido, al detallar los modelos subyacentes sin establecer de antemano la coincidencia con lo evidenciado para gas. Las frecuencias de respuesta obtenidas se han volcado a la Tabla 8.

De dicha Tabla surge que el modelo II (deseable desde el docente) no es el único y si bien resulta preponderante para gases disminuye notablemente para líquidos y aún más para sólidos. En estas fases es reemplazado por los modelos V (discreto pero que no acepta lo fenomenológico), sobre todo en sólidos, y VI (sólo macroscópico y que no acepta lo fenomenológico). También aparece el modelo I (discreto pero que no explica lo macroscópico) con una alta frecuencia de respuestas distribuidas de modo similar en las tres fases. Un registro análogo de frecuencias se ha encontrado en estudiantes universitarios perteneciente a carreras de Ciencias Exactas de la Universidad Nacional de La Plata, cuyo análisis se encuentra en desarrollo.

ConclusionesSe ha evidenciado cómo, para el mismo conjunto de respuestas, concepciones acerca de la evaluación y maneras de proceder de los docentes pueden obstaculizar la identificación de las diversas representaciones en el aula de ciencias. Por ejemplo en el caso de plantearse, desde la certificación, una evaluación que lleva a resultados estrictamente individuales.

Desde el enfoque de certificación de conocimientos el modelo de estudiante queda prefijado (no sabe leer, no sabe exponer sus ideas claramente, no distingue lo correcto de lo incorrecto, necesita ser enseñado), resulta muy difícil encontrar coherencia en las respuestas a la encuesta y relacionar los datos obtenidos. Las frases escritas por el docente (“Creo que la gran conclusión, que orbita a lo largo y ancho de las encuestas, es que los estudiantes no leen el enunciado; si lo leen no lo interpretan y si lo interpretan no hacen caso.… Conclusión rutinaria de cualquier examen, pero en un examen ya aprendí (bien o mal) a manejarlo. Aquí no sé realmente qué hacer… El problema es que sé cómo detectar los datos locos en una curva de calibración, pero no sé si las encuestas que creo que operan como ruido que entorpece el análisis, son realmente ruido o son significativas”) reflejan la dificultad de incorporar lo que muestran las respuestas de sus alumnos a su trabajo de aula.

A diferencia de la aplicación de un criterio de referencia, la alternativa propuesta para el ordenamiento y análisis de datos numerosos, sin descartar ninguno, permite identificar categorías en las ideas existentes en un conjunto de estudiantes además de evidenciar un modelo de estudiante muy distante del esperado desde el esquema de certificación.

En este sentido queda claro que no se puede asumir la existencia única del modelo II, esperada habitualmente desde la perspectiva docente tradicional, sino que es imprescindible considerar otros modelos cuya relevancia estará evidenciada en el porcentaje de estudiantes que los manifiesten.

Tener la posibilidad de identificar las diferentes representaciones que muestran grupos de estudiantes en un aula puede permite al docente programar caminos de acción mediante los cuales abordar la situación. Los resultados de la evaluación realizada pueden considerarse entonces, en un sentido vigotskiano, el punto de partida de un proceso de trabajo docente que atienda a las diferentes necesidades de cada grupo de estudiantes. A partir del espacio de representaciones identificado, el tratamiento de datos de carácter cualitativo presentado se constituye en una herramienta de planificación de las actividades de aula.