Introducción y antecedentes

En la práctica profesional diaria del dietista-nutricionista, es frecuente enfrentarse a un sinfín de preguntas acerca del uso de las recomendaciones dietético-nutricionales, a las cuales debe hallarse respuesta. Pese a que aún es habitual entre los profesionales sanitarios recurrir a la experiencia personal, o bien acudir a los libros de texto para solucionar dichas incógnitas1,2, cabe destacar que ésta podría no ser la forma más adecuada.

Esta forma de proceder no ha sido única en la historia. Tal y como explica Doherty3, en 1937, el joven médico Sir Richard Doll observó que en Londres los nuevos tratamientos surgían de la propia experiencia de los especialistas, sin tener en cuenta los factores de confusión ni los posibles sesgos4.

De esta forma, durante años la medicina fue incorporando la necesidad de crear la así llamada «medicina basada en la evidencia» para poder ofrecer la mejor práctica posible, hasta que en 1993 se publicaron, en el Journal of the American Medical Association, dos de los primeros documentos en que se usa el concepto de medicina basada en la evidencia5-7. Sin embargo, no es hasta 1995 cuando se define de forma explícita este concepto: «la forma sistemática de analizar los estudios científicos publicados para ser la base de los árboles de decisión clínica»8. Posteriormente, en 1996, Sacket et al9 redefinieron el nuevo término como «el uso concienzudo y juicioso de la mejor evidencia científica actual derivada de la investigación en el manejo de pacientes individuales en atención clínica». En 1997 el National Center for Biotechnology Information (NCBI), basado en un artículo publicado en el British Medical Journal10, la introduce como «MeSH Term» —MeSH son las siglas de Medical Subject Headings (encabezados de materia médica) designados por National Library of Medicine de Estados Unidos— y la define como: «El proceso de encontrar, evaluar y usar, de manera sistemática, los hallazgos contemporáneos relativos a la investigación como la base en la toma de decisiones clínicas». Asimismo, se indica que la medicina basada en la evidencia sigue cuatro pasos: formulación de una cuestión clínica clara a partir de un problema médico, indagar en la literatura para hallar artículos clínicos relevantes, evaluar (valoración clínica) la evidencia desde el punto de vista de su validez y utilidad e implementar los hallazgos útiles en la práctica clínica10.

Como se puede apreciar, pese a que la medicina basada en la evidencia es un concepto bastante nuevo, el concepto sobre el cual se ha construido (los niveles de evidencia) es más antiguo. Ya en 1979, la Canadian Task Force on the Periodic Health Examination11 elaboró una jerarquía para clasificar la evidencia. Dicha jerarquía consistía en la clasificación de los estudios científicos en 5 niveles de evidencia según el tipo de estudio realizado:

I. Ensayo clínico controlado, aleatorizado.

II.1. Ensayos clínicos controlados (sin aleatorización).

II.2. Estudios de cohortes o estudios analíticos de caso-control.

II.3. Estudios de series de tiempo múltiples con o sin intervención.

III. Opiniones de expertos, experiencias clínicas, estudios descriptivos u opiniones de comités de expertos.

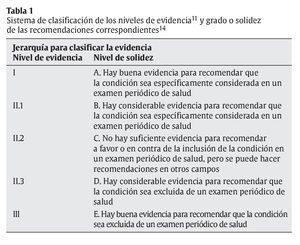

Posteriormente se han publicado otras jerarquías12,13, todas ellas basadas en una clasificación de los diferentes tipos de estudios según el nivel de evidencia, y se establecieron los grados de recomendación correspondientes. En 1996, la US Preventive Task Force, como se aprecia en la tabla 114, añadió a los niveles de evidencia de la Canadian Task Force on the Periodic Health Examination11 un sistema de clasificación de la solidez de las recomendaciones que dichas evidencias proporcionan.

En una revisión de 1.602 artículos realizada por la Agency for Healthcare Research and Quality de la US Department of Health and Human Services en 2002, se detectó el uso de hasta 120 sistemas diferentes de clasificación de la evidencia científica y de calidad de los estudios15.

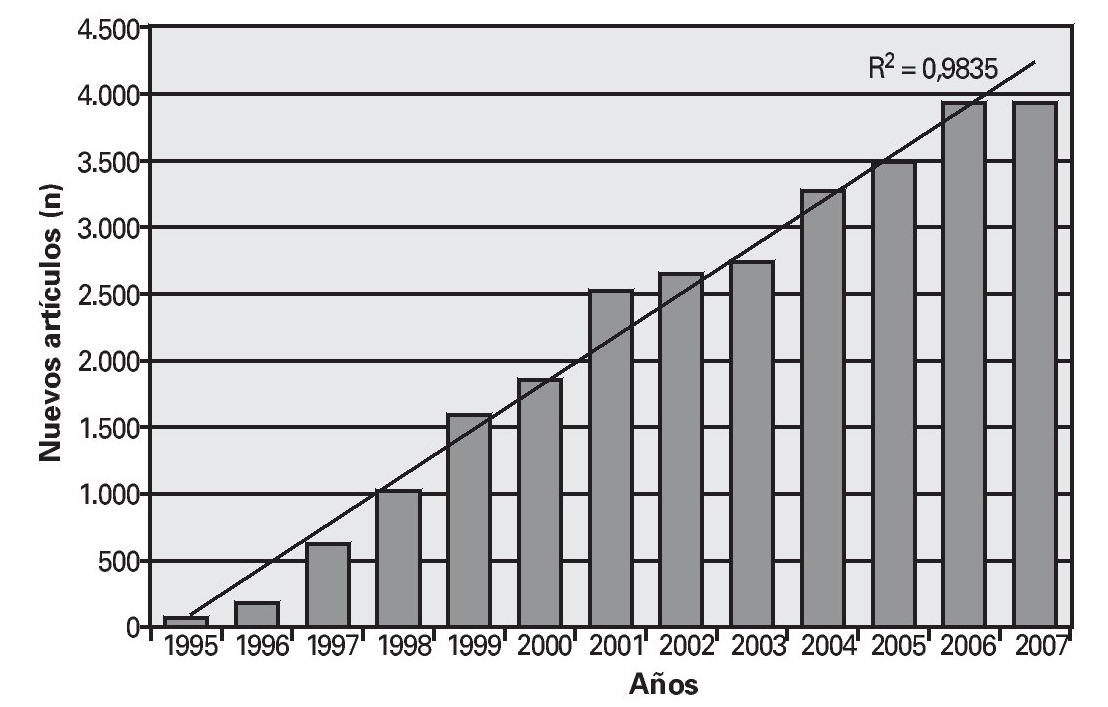

De esta forma, paralelamente al desarrollo de los niveles de evidencia, ha ido creciendo la medicina basada en la evidencia. En la figura 1 se observa el crecimiento lineal (R2 = 0,9835) de los nuevos estudios publicados cada año en PubMed en torno a la medicina basada en la evidencia.

Fig. 1. Resultado de la introducción de «evidence based medicine» en PubMed por años. Nuevos artículos acerca de la medicina basada en la evidencia por año (elaboración propia).

De la misma forma que la medicina basada en la evidencia ha evolucionado y actualmente determina la práctica clínica, la dietética y la nutrición aplicada basadas en la evidencia (DNABE) debe hacerlo también, y dictar cuál es la mejor práctica dietético-nutricional.

Existen iniciativas cuyo objetivo es ayudar a los dietistas-nutricionistas a desarrollar e implementar guías basadas en la evidencia. Es el caso de la iniciativa del departamento de dietética de la División de Rehabilitación y Nutrición del Centro Médico Universitario Utrecht NL16, en 1998, o la iniciativa de la American Dietetic Association (ADA)17 de poner a disposición de sus socios, en 2006, una librería de análisis de la evidencia desde donde se puede acceder a las guías más importantes de la práctica dietética basada en la evidencia. En cualquier caso, no se ha hallado ningún estudio que describa, de forma detallada, un método práctico de sistematizar la clasificación de los niveles de evidencia y la solidez de sus recomendaciones en el campo de la dietética y la nutrición humana aplicada.

Es, por tanto, la finalidad del presente documento iniciar el proceso de creación de la DNABE en España, y ofrecer una metodología práctica para que los dietistas-nutricionistas, así como cualquier otro profesional sanitario cualificado, puedan ofrecer recomendaciones actuales, útiles, válidas y sólidas en el campo de la dietética y la nutrición humana aplicada.

Sistema para establecer la solidez de un conjunto de artículos que conformen la evidencia científica

Uno de los mayores problemas actuales es que hay muchos estudios, y de muchos tipos, que nos pueden ofrecer diferentes respuestas o incluso contradictorias. Esto puede hacer difícil al profesional discernir cuál es «la verdad» o en qué medida una recomendación se «acerca a la verdad».

En este sentido, cuando hay un conjunto de artículos de los que se quiere conocer a cuál o cuáles de ellos se debe tener en mayor consideración para realizar una recomendación, hay que tener en cuenta 3 aspectos principales: el tipo de diseño de estudio, la calidad individual de los estudios18 y la cantidad relativa de muestra de población19, así como la duración del estudio. Estos aspectos se detallan a continuación.

Importancia del diseño del estudio

Para clasificar los estudios dentro de una jerarquía de niveles de evidencia y grados de recomendación, es necesario determinar el diseño del estudio. Según su diseño podríamos diferenciar cuatro grandes grupos de estudios: experimentales, observacionales, de revisión y de consenso o posicionamiento.

Los estudios experimentales se caracterizan por tener un grupo llamado «intervención», que se somete a un tratamiento, mientras que los estudios observacionales se caracterizan por observar y examinar la relación entre los factores específicos de un grupo de población y los factores o marcadores de salud o enfermedad20. Por otro lado, los estudios de revisión, consenso y posicionamiento pueden ser muy heterogéneos, ya que pueden abarcar desde revisiones de la literatura de cualquier tipo (libros, artículos de revistas científicas, páginas de internet, etc.) hasta revisiones de artículos científicos de un diseño específico (por ejemplo, de ensayos clínicos controlados, aleatorizados).

Entre los estudios experimentales, se puede distinguir21:

1. Ensayos clínicos controlados, aleatorizados (ECCA, o sus siglas inglesas RCT: randomized controlled trial): trabajos consistentes en un ensayo clínico que involucre, como mínimo, un grupo de intervención y un grupo control, asignación simultánea, y seguimiento de ambos grupos. Asimismo, los tratamientos a administrar se seleccionan por un proceso aleatorio.

2. Ensayos clínicos controlados (no aleatorizados): trabajos consistentes en ensayos clínicos que involucren, como mínimo, un grupo de intervención y un grupo control, y que especifiquen las medidas de los parámetros para la intervención estudiada, mediante un método libre de sesgos para asignar a los pacientes al tratamiento. Los tratamientos podrían ser fármacos, aparatos o procedimientos estudiados para valorar la efectividad del diagnóstico, la terapia o la profilaxis. Las medidas de control incluyen placebos, sustancia activa, no tratar, dosis utilizada y regímenes, comparaciones históricas, etc.

3. Ensayos clínicos (no controlados): trabajos consistentes en estudios clínicos prediseñados acerca de la seguridad, la eficacia o la planificación de la dosis óptima de uno o más fármacos, instrumentos o técnicas para realizar diagnósticos, terapias o profilaxis en humanos seleccionados en función de criterios predeterminados de elegibilidad y observados por evidencias previamente determinadas de efectos favorables o no favorables.

Entre los estudios observacionales21:

1. Estudios de cohortes: estudios en los que se identifican subgrupos de población. Estos grupos pueden ser o no expuestos a factores que hipotéticamente podrían influir en la probabilidad de que ocurra una enfermedad en concreto u otro acontecimiento. Las cohortes son poblaciones definidas que, como grupo, se siguen con el objetivo de determinar características distintivas en subgrupos.

2. Estudios de casos-control: estudios que se inician con la identificación de personas con una enfermedad de interés y con un grupo control (comparación o de referencia) sin la enfermedad. Se examina la relación de un atributo con la enfermedad comparando a las personas enfermas y las no enfermas en relación con la frecuencia o los niveles del atributo en cada grupo.

3. Estudios transversales: estudios en que se valora la presencia o ausencia de una enfermedad, o de otras variables determinadas, en cada miembro de la población de estudio o en una muestra representativa de dicha población, en un momento dado.

Entre los estudios de revisión21:

1. Metaanálisis: trabajos que consisten en la valoración de estudios con un método cuantitativo mediante la combinación de resultados de estudios independientes (normalmente extraídos de lo publicado en la literatura científica) y sumarios sintetizados y conclusiones que podrían utilizarse para evaluar el efectividad terapéutica, planificar nuevos estudios, etc.

2. Revisión sistemática22: una revisión de una cuestión claramente formulada, que utiliza métodos sistemáticos y explícitos para identificar, seleccionar y criticar estudios relevantes, y para recoger y analizar información incluida en la revisión. Se puede o no usar métodos estadísticos (metaanálisis) para analizar o sintetizar los resultados de los estudios que se hayan incluido.

3. Revisión: un artículo o libro publicado tras el examen de material publicado acerca de un tema. Puede ser exhaustiva, a varios niveles, y el intervalo de tiempo seleccionado para captar estudios puede ser amplio o estrecho, pero las revisiones más solicitadas son las que evalúan la literatura actual.

No todos los estudios tienen la misma finalidad. Por ejemplo, se considera que los ECCA son los estudios que estiman «la verdad» de forma más precisa23, mientras que los estudios de casos clínicos, se considera que son más útiles para generar hipótesis24. Entre estos dos tipos de diseño están los estudios de cohortes y los estudios de casos-control. Los primeros ayudan a crear una relación entre un factor de riesgo y una consecuencia potencial, mientras que los segundos a menudo son utilizados para identificar los factores que pueden pronosticar una posible consecuencia23,24. Los estudios de casos-control son más susceptibles a tener algún tipo de sesgo que los estudios de cohortes25.

Por un lado, la US Agency for Health Care Policy and Research (AHCPR) estableció en 1996 que, en los casos en que no es posible realizar ECCA, o bien éstos no son capaces de proporcionar la respuesta adecuada, se puede igualar el valor científico de estudios observacionales y de ECCA. La jerarquía propuesta por esta agencia está basada en 7 niveles de evidencia que se corresponden a 3 grados de recomendaciones diferentes19.

Por otro lado, investigadores del Instituto Alemán de Medicina Social, Epidemiología y Economía de la Salud y el Departamento de Epidemiología del Instituto Alemán de Nutrición Humana han puesto de manifiesto que cuando se realizan recomendaciones preventivas a la población con consejos para mejorar conductas, sin especificar cantidades (por ejemplo, recomendar el aumento del consumo de frutas y verduras sin establecer una cantidad bien definida), o eliminar conductas perniciosas (hábito de fumar o consumo de alcohol), no es necesario que se diseñe un ECCA para comprobarlo, sino que con estudios observacionales es suficiente para llegar a la conclusión26.

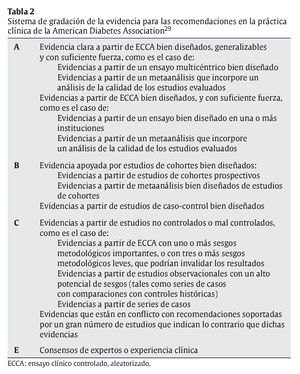

Muchos autores han desarrollado sus propias jerarquías de niveles de evidencia. En este sentido, se ha utilizado la base de datos del National Guideline Clearinghouse (base de datos pública que ofrece acceso a guías de práctica clínica basada en la evidencia, creada por la Agency for Healthcare Research and Quality [AHRQ], US Department of Health and Human Services, y en su origen, por la American Medical Association y la American Association of Health Plans) para encontrar estudios que usen un sistema de jerarquía de la evidencia en el marco de la nutrición basada en la evidencia (evidence based nutrition; EBN). Debido a las limitaciones del buscador de esta base de datos, se ha utilizado Google como motor de búsqueda dentro de la misma base de datos (para más información al respecto, consultar Baladia et al27, 2006). Únicamente se han hallado 2 documentos que cumplan con los requisitos establecidos: la «Guía práctica basada en la evidencia de los desórdenes en el metabolismo de los lípidos»28 y los «Estándares en el cuidado médico en la diabetes»29, de los cuales únicamente el segundo establece de forma clara una jerarquía de niveles de evidencia en sus recomendaciones (tabla 2).

Se han hallado, además, otras guías que, pese a no especificar que son de nutrición basada en la evidencia, tratan sobre el manejo dietético-nutricional en distintas enfermedades crónicas: obesidad30, enfermedad cardiovascular31, osteoporosis32 y salud dental33.

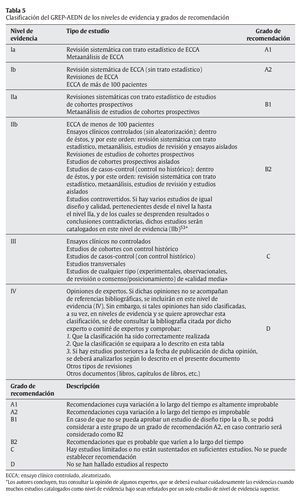

De esta forma, tomando como base únicamente el tipo de diseño de estudio, y según lo descrito en este apartado, se puede resumir y establecer un esquema general de jerarquía de los niveles de evidencia:

- Revisión sistemática con trato estadístico de ECCA.

- Metaanálisis de ECCA.

- Revisión sistemática de ECCA (sin trato estadístico).

- Revisiones de ECCA.

- ECCA independientes.

- Revisiones sistemáticas con trato estadístico de estudios de cohortes prospectivos.

- Metaanálisis de estudios de cohortes prospectivos.

- Ensayos clínicos controlados (sin aleatorización): dentro de éstos, y por este orden: revisión sistemática con trato estadístico, metaanálisis, revisión e independientes.

- Revisiones de estudios de cohortes prospectivos.

- Estudios de cohortes prospectivos independientes.

- Estudios de casos-control (control no histórico): dentro de éstos, y por este orden: revisión sistemática con trato estadístico, metaanálisis, revisión e independientes.

- Ensayos clínicos no controlados.

- Estudios de cohortes con control histórico.

- Estudios de casos-control (con control histórico).

- Estudios transversales.

- Estudios controvertidos: estudios de diseño parecido o bien muchos estudios de diseño inferior refutados por poca cantidad de estudios de diseño de calidad superior.

- Opiniones de expertos: en caso de que éstos aporten estudios, se clasificará según su diseño.

- Otros tipos de revisiones.

- Otros documentos.

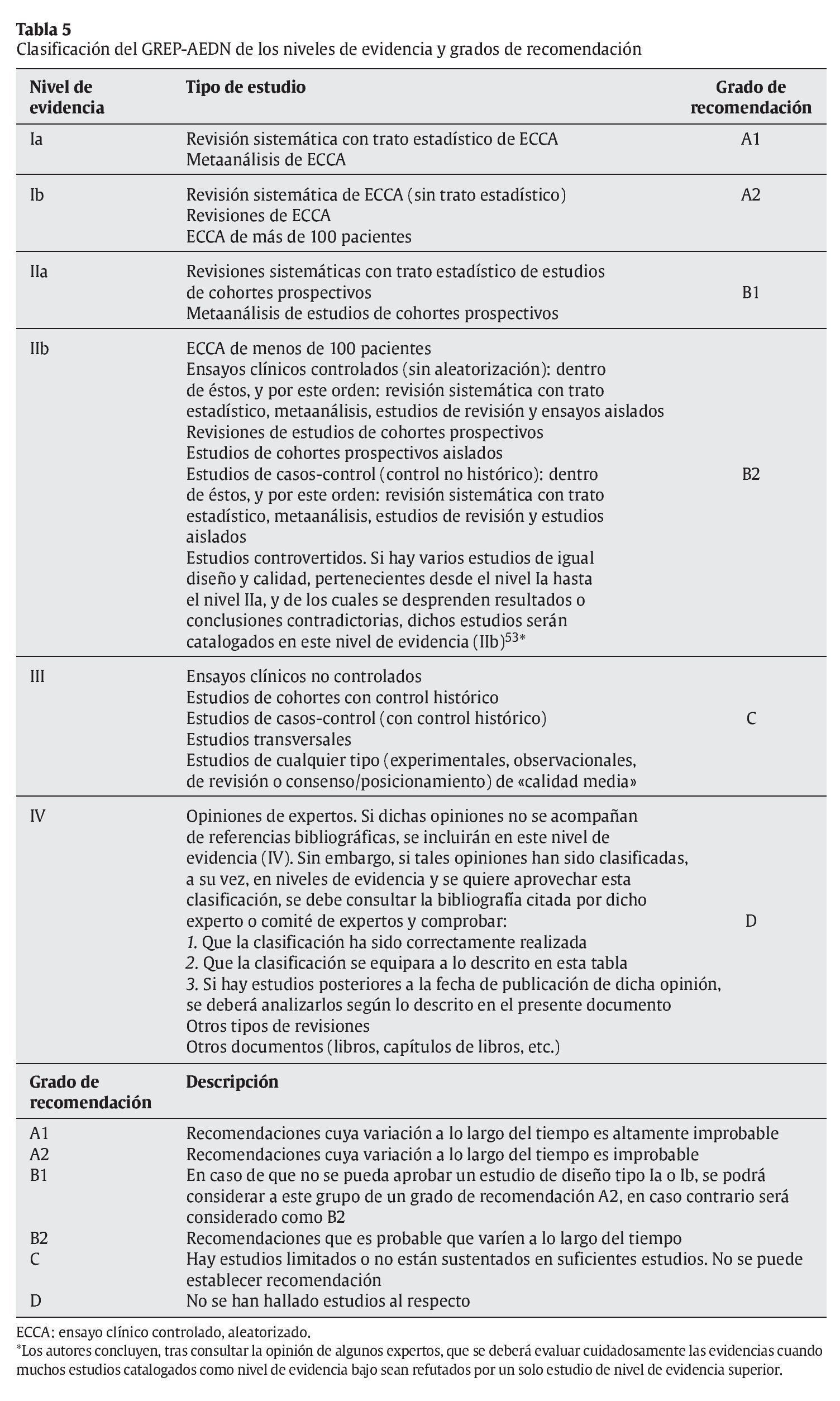

A estos niveles de evidencia, les debe corresponder unos grados de recomendación o solidez de la recomendación:

- Recomendaciones cuya variación a lo largo del tiempo es altamente improbable.

- Recomendaciones cuya variación a lo largo del tiempo es improbable.

- Recomendaciones que es probable que varíen a lo largo del tiempo.

- Hay estudios limitados o no están sustentados en suficientes estudios. No se puede establecer recomendación.

- No se han hallado estudios al respecto.

Pese a que el diseño de un estudio es muy importante para definir la evidencia científica que nos aporta la afirmación que se baraja en su hipótesis, hay que tener en cuenta los otros dos aspectos para establecer una buena jerarquía de niveles de evidencia y grados de solidez de las recomendaciones15, descritos a continuación.

Sistema para estimar la calidad individual de los artículos

Aparte de establecer una jerarquía entre los distintos tipos de diseño de estudios, también es posible establecer un sistema jerárquico dentro de un mismo tipo de estudio para permitir que los estudios de mayor calidad estén por encima de los de peor calidad; de esta forma se obtiene una mayor fiabilidad de las recomendaciones que se desprendan de dichos estudios, y se pueden evitar posibles sesgos o errores de interpretación. Según el Center of Reviews and Dissemination (CRD) de la Universidad de York (Reino Unido)25, es posible que los estudios de baja calidad tiendan a sobrestimar el efecto del tratamiento34, o incluso pueden llegar a conclusiones contrarias a las halladas por estudios de alta calidad35.

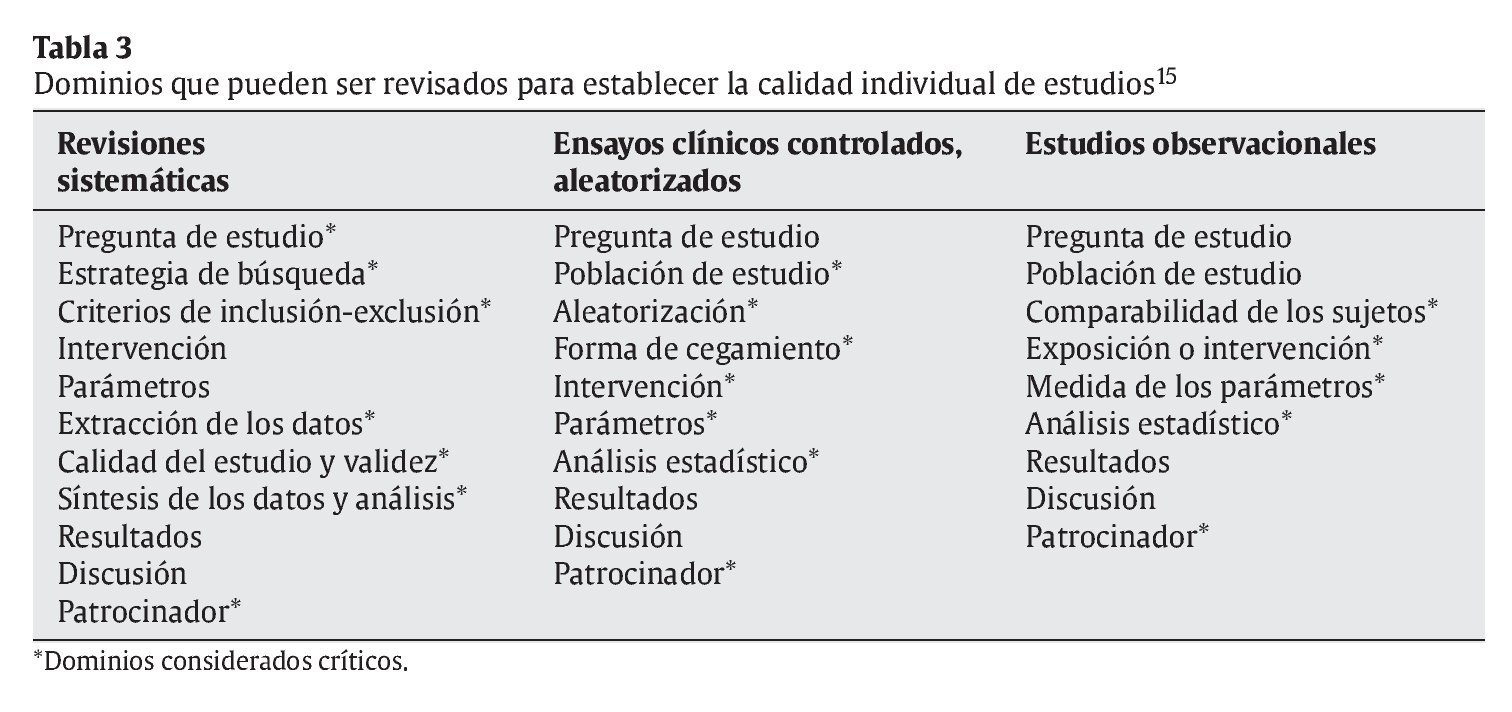

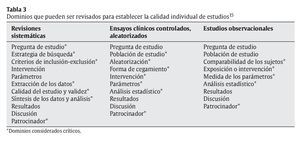

Hay muchos puntos que se podría considerar para definir la calidad de un artículo. Tal y como muestra la tabla 3, un documento, aceptado por la Agency for Healthcare Research and Quality de la US Department of Health and Human Services en 2002, considera entre 9 y 11 dominios (por cada tipo de diseño de estudio) que pueden ser revisados cuando se intenta definir la calidad de un artículo15. Se puede apreciar que se han destacado los 19 dominios que se consideraron «críticos» para establecer dicha calidad.

Según señalan los autores de ese documento, para definir la calidad de un artículo se pueden usar los 9-11 dominios o solamente los indicados como críticos. Asimismo, advierten que debe tenerse siempre en consideración que, según el sistema elegido para establecer la calidad, puede aumentar tanto la dificultad de uso que disminuya su practicidad y su precisión15.

Estudios experimentales

En el apartado «Importancia del diseño del estudio», se ha podido comprobar que los ECCA ocupan los primeros lugares en la jerarquía del tipo de diseño. Sin embargo, no todos los ECCA son de igual calidad o igual de fiables. Como se puede observar en la tabla 3, hay 7 dominios críticos que pueden ser revisados para determinar la calidad de los ECCA. Sin embargo, para mantener la practicidad, algunos autores han descrito que para definir la calidad de los ECCA es aceptable usar, como mínimo, los siguientes indicadores: la aleatorización, el análisis estadístico y la forma de cegamiento19,36-38, es decir 3 de los 7 descritos como críticos en la tabla 3. Una revisión realizada en 1995 por Moher et al38 identificó 25 escalas de puntuación diferentes para definir la calidad de ECCA. Los autores identificaron, de cada una de las escalas, una serie de características para poder evaluar su calidad. Entre otras, se describió:

1. Si podía medir ECCA de cualquier materia, o bien, estaba especializada, por ejemplo, en alguna patología.

2. Si se refería a la calidad metodológica o a la calidad total del artículo.

3. Si había como mínimo un ítem para identificar la asignación de los pacientes.

4. Si había como mínimo un ítem acerca del enmascaramiento.

5. Si había como mínimo un ítem acerca del seguimiento del paciente.

6. Si se hacía un análisis estadístico.

7. El número de ítems a responder.

8. El tiempo necesario para completar dicha escala.

Pese a que los autores concluyeron que únicamente la escala de Jadad-Bechara39 superó todo el examen propuesto, cabe destacar que la Cochrane Collaboration indica que no existe el estándar en el uso de dichas escalas para establecer la calidad de los estudios40, y que no están soportadas por evidencia empírica41,42. La misma organización recomienda que, en caso de usarlas, se haga con cautela. Los autores del presente artículo quieren recalcar, por tanto, que pueden existir otros sistemas que ofrezcan mayor fiabilidad en la evaluación de la calidad de los estudios, pero también advierten que establecer otro tipo de metodología para evaluar la calidad de los estudios podría requerir una mayor inversión de tiempo y mejores conocimientos en bioestadística. Es por ello que se aconseja usar, conociendo las limitaciones del sistema, alguna de las citadas escalas de calidad detalladas por Moher et al38, antes que no usar ningún sistema para evaluar la calidad individual de los estudios. Como el actual documento pretende ser una herramienta práctica que sirva para evaluar de forma rápida la calidad de ECCA de cualquier materia, se ha valorado cualitativamente cada uno de los 8 puntos que caracterizan las diferentes escalas38 para determinar cuál de ellas puede ser la más adecuada.

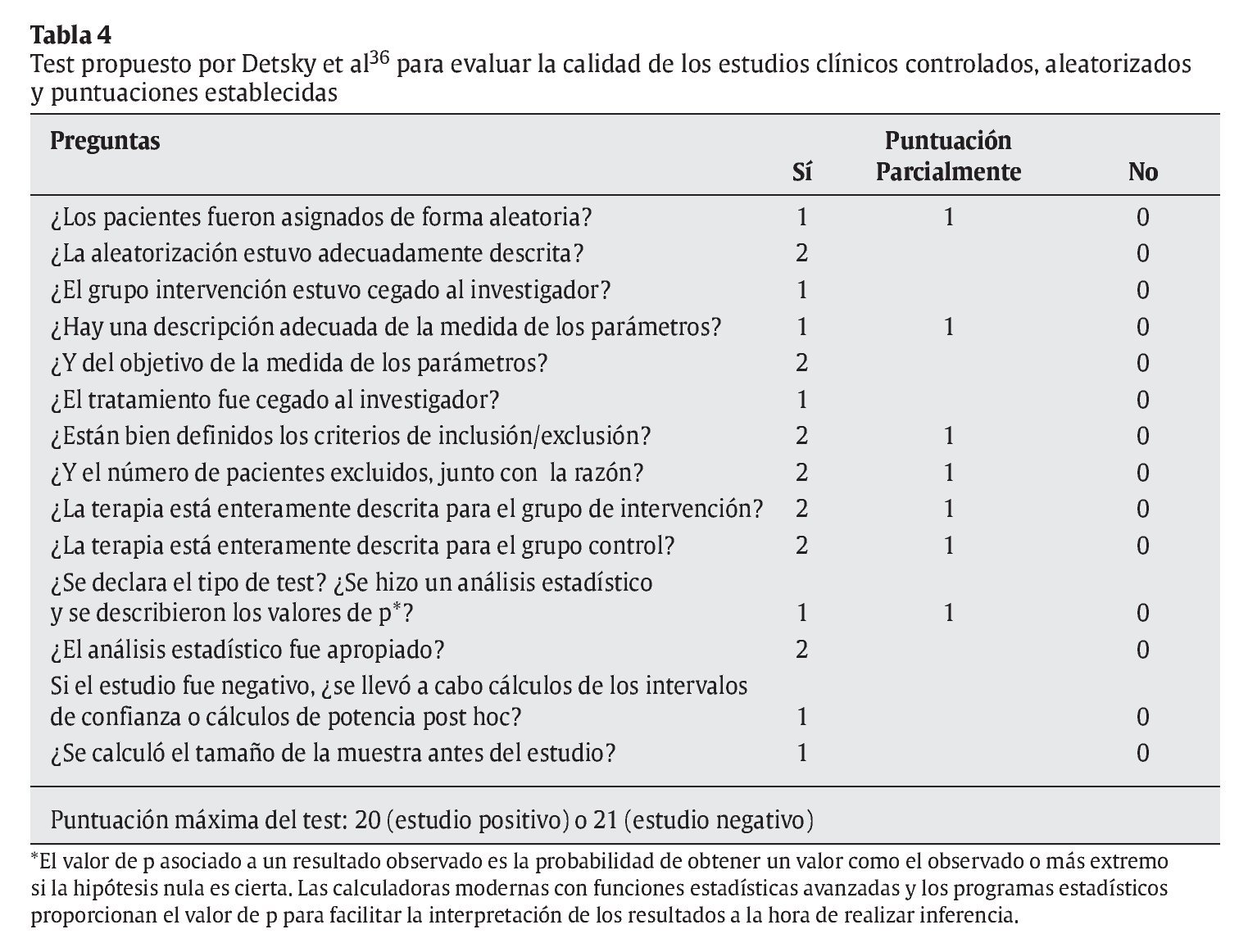

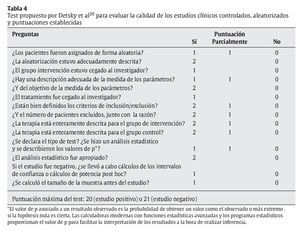

Pese a que hay muchas escalas, con múltiples ítems y complejos sistemas de puntuación que pueden hacer que el evaluador invierta mucho tiempo en contestarlos, no se ha comprobado que dichas escalas ofrezcan mayor validez que otras más sencillas43. Por tanto, tras revisar las 25 escalas de puntuación del estudio de Moher et al38, la escala de Detsky et al36 parece ser la que mejor se adapta a las necesidades de los lectores del presente artículo. Dicha escala sirve para evaluar ECCA de cualquier materia y se refiere tanto a la calidad metodológica como a la calidad general del artículo. Hay, como mínimo, un ítem para identificar la asignación de los pacientes y otro acerca del enmascaramiento. Asimismo, hay, como mínimo, un ítem para evaluar el análisis estadístico, y es uno de los que más rápidamente se puede contestar (aproximadamente en 10 min) (tabla 4). Además, tal y como detallan Petrisor et al18, el sistema desarrollado por Detsky et al36 es un método validado. Otros estudios posteriores han usado dicha escala para evaluar, con éxito, ECCA de distintas materias44-46.

Esta puede ser, por tanto, una forma práctica de clasificar los ECCA según el porcentaje de cumplimiento respecto al total de puntos obtenidos en el test de Detsky et al36.

Otra forma de determinar la calidad individual de un estudio es mediante las listas de control sin puntuaciones o cheklists. El Center of Reviews and Dissemination (CRD) usa como ejemplo los 9 ítems del Consenso de Delphi (Verhagen et al47):

1. ¿Realmente la asignación del tratamiento a los grupos fue aleatoria?

- Enfoques apropiados para la generación de secuencias: a) números aleatorios generados por computadora, y b) tablas de números aleatorios.

- Enfoques inapropiados para la generación de secuencias: uso de alternancias, números de historia clínica, fechas de nacimientos, días de la semana, etc.

2. ¿Se ocultó la asignación al tratamiento?

- Enfoques apropiados del enmascaramiento de la aleatorización:

a) aleatorización centralizada o controlada; b) contenedores numerados con secuencias idénticas; c) sistema computarizado con una secuencia aleatoria no legible hasta la asignación, y d) otros enfoques con métodos sólidos para prevenir el reconocimiento de la secuencia de asignación por parte de los investigadores o los pacientes.

- Enfoques inapropiados del enmascaramiento de la aleatorización: a) uso de alternancias, números de historia clínica, fechas de nacimientos, días de la semana, etc.; b) listas legibles de números aleatorios, y c) envases numerados con secuencias (incluso los envases opacos sellados pueden estar sujetos a manipulaciones).

3. ¿Los grupos eran similares al inicio del estudio en términos de factores pronóstico?

4. ¿Se especificaron los criterios de inclusión?

5. ¿Hubo ciego simple (paciente), doble ciego (investigador) o triple ciego (quien analiza los datos)?

6. La estimación puntual y la medida de la variabilidad ¿fueron presentadas para la variable de valoración predefinida (es decir, la de mayor importancia y la que en un estudio habitualmente determina el tamaño muestral)?

7. ¿Incluyeron los análisis una evaluación por intención de tratamiento?

También, en este caso, se podría clasificar los ECCA según el porcentaje de respuestas favorables o negativas a dicho checklist.

Estudios observacionales

Para los estudios observacionales, la Agency for Healthcare Research and Quality de la US Department of Health and Human Services concluye que para poder inferir un resultado válido a partir de estudios observacionales, los investigadores deben asegurar, como mínimo, la comparabilidad entre los grupos de estudio (exceptuando los factores que están bajo estudio), y garantizar que se haya hecho un adecuado análisis estadístico de los resultados15.

Asimismo, el Center of Reviews and Dissemination señala que los estudios de cohorte que usan datos históricos para comparar con el grupo de estudio actual, son vistos, generalmente, como de menor calidad que aquellos que comparan dos grupos actuales, y añade, además, que los estudios prospectivos acostumbran a tener menor riesgo de sesgos que los estudios retrospectivos25.

Pese a que existen distintos cheklists para la evaluación de la calidad individual de estudios epidemiológicos, como, por ejemplo, el propuesto por Levine et al48, el Center of Reviews and Dissemination propone una fusión de distintos cheklists25:

1. Estudios de cohortes:

- ¿Hay suficiente descripción de los grupos y de la distribución de los factores de pronóstico?

- ¿Los grupos se agruparon en función de la similitud en la progresión de su enfermedad?

- ¿Se estableció formalmente la intervención o el tratamiento?

- ¿Los grupos son comparables en relación con todos los factores de confusión?

- ¿Se ajustaron adecuadamente los efectos de dichos factores de confusión?

- ¿Hay una relación dosis-respuesta entre la intervención y los resultados?

- ¿La persona que analiza fue cegada en referencia a la intervención?

- ¿El seguimiento fue lo suficientemente largo como para que tuviesen lugar los resultados?

- ¿Qué proporción de la cohorte fue seguida?

- ¿La tasa de abandono y sus causas fueron similares entre los grupos intervención y control?

2. Estudios de casos y controles:

- ¿Es explícita la definición del grupo «caso»?

- ¿Se ha valorado y validado correctamente el estado de la enfermedad de los «casos»?

- ¿Se aleatorizó a los grupos control a partir de la fuente de población de los «casos»?

- ¿Son comparables los casos y los controles con respecto a los potenciales factores de confusión?

- ¿Se valoró de la misma manera las intervenciones y otras exposiciones tanto en los casos como en los controles?

- ¿Cómo se definió la tasa de respuesta?

- ¿Las tasas de falta de respuesta y sus razones fueron iguales en ambos grupos?

- ¿Es posible que haya habido un sobreemparejamiento en cuanto a la asignación de los casos y los controles a los factores relacionados con la exposición?

- ¿Se realizó un análisis estadístico apropiado? (emparejado o no emparejado).

3. Series de casos:

- ¿El estudio se basa en una muestra representativa seleccionada de una población relevante?

- ¿Los criterios de inclusión son explícitos?

- ¿Todos los individuos empezaron la investigación en un punto similar de la progresión de su enfermedad?

- ¿El seguimiento fue lo suficientemente largo como para que ocurriesen eventos importantes?

- ¿Los parámetros se valoraron siguiendo criterios objetivos o se utilizó un método de cegamiento?

- Si se han hecho comparaciones de subgrupos, ¿hubo suficiente descripción de las series y de la distribución de los factores pronóstico?

Otros criterios aplicables a todos los tipos de estudios

Además de los dominios descritos en los apartados correspondientes a cada tipo de diseño de estudio, también se puede verificar, como propone la Agency for Healthcare Research and Quality de la US Department of Health and Human Services14: los patrocinadores y los conflictos de intereses.

Por tanto, entre estudios de igual diseño, la calidad individual puede hacer que los de más calidad estén, científicamente hablando, por encima de los estudios de menor calidad. De la misma forma, estudios de mala calidad que teóricamente ofrecerían, según su diseño, mayor nivel de evidencia, puede que estén por debajo de otros que serían de calidad científica inferior. A este respecto no se ha hallado ningún estudio que establezca de forma clara a partir de qué puntuación se puede decir que un estudio es de menor calidad individual que otro. Vista la falta de información, los autores del presente documento proponen clasificar la calidad de los estudios, de forma transitoria hasta tener más datos, de la siguiente manera:

- Calidad alta: estudios cuya puntuación o porcentaje de cumplimiento de las escalas establecidas en este punto supere el 75%.

- Calidad media: cuya puntuación o porcentaje de cumplimiento de las escalas establecidas en este punto estén entre el 50 y el 75%.

- Calidad baja: cuya puntuación o porcentaje de cumplimiento de las escalas establecidas en este punto estén por debajo del 50%.

Así, ¿cómo puede afectar la calidad de un estudio individual a la jerarquía de niveles de evidencia? Se propone que las recomendaciones procedentes de estudios de calidad media tengan un formato igual o similar al siguiente: «hay pocos estudios o las conclusiones no están sustentadas en suficientes estudios. No se puede establecer una recomendación», mientras que los estudios de calidad baja automáticamente serán desechados.

Cantidad relativa de muestra de población y duración de la intervención

La cantidad de muestra de población de los estudios también es uno de los factores que debe tenerse en cuenta para establecer el peso que se le tiene que dar a dicho estudio. Hay sistemas para establecer el tamaño de muestra que debe usarse según las características del estudio. Pese a que la explicación de dichos sistemas excede los objetivos fijados para esta revisión, cabe resaltar que la US Agency for Health Care Policy and Research clasifica los ECCA de menos de 100 pacientes como estudios de menor evidencia científica19. Es decir, que entre estudios de igual diseño, y cuya calidad individual sea parecida, serán de mayor calidad científica aquellos que tengan una muestra mayor de población.

En este sentido, cuando se comparan estudios de diseño distinto, cabe destacar que los estudios observacionales y los metaanálisis, por sus características, pueden tener una mayor cantidad relativa de muestra de población respecto a los ECCA. Esto no implica que dichos estudios sean directamente de mayor calidad que los ECCA. Únicamente los metaanálisis de ECCA, con su correspondiente análisis estadístico bien realizado, serán de mayor evidencia científica que los ECCA de más de 100 pacientes de forma individual. Sin embargo, las revisiones sistemáticas con trato estadístico o metaanálisis de estudios de cohortes prospectivos podrán ser de igual evidencia científica que los ECCA con menos de 100 pacientes18,19.

De igual forma, al comparar estudios de igual diseño, calidad individual parecida y tamaño de muestra parecido, serán de mayor calidad científica aquellos cuya duración de la intervención sea mayor.

Conclusiones. Creando una metodología

Actualmente existe la necesidad de que el dietista-nutricionista, o cualquier otro profesional que se dedique a la dietética y nutrición aplicada (tanto clínica como comunitaria), utilice la DNABE en sus métodos para obtener guías de práctica clínica que incorporen recomendaciones basadas en la evidencia científica49-51.

Considerando los tres dominios principales (el tipo de diseño de estudio, la calidad individual de los estudios18 y la cantidad relativa de muestra de población19 y la duración del estudio), se recomienda la siguiente metodología de trabajo para crear dichas recomendaciones:

1. Definir la pregunta o cuestión a tratar: cuanto más abierta, más difícil será recuperar (mediante una estrategia de búsqueda) estudios relevantes. Pero si la pregunta es demasiado concisa, se podría estar dejando de lado consideraciones potencialmente importantes en la decisión final40.

2. Ejecutar una correcta estrategia de búsqueda a través de una base de datos especializada. Para más información se propone consultar el artículo: «Introducción a la búsqueda de información en internet de interés para dietistas-nutricionistas (2): bases de datos electrónicas especializadas, el primer paso hacia la evidencia científica»52.

3. Agrupar los estudios según su diseño:

- Experimental: ECCA, estudio clínico controlado (no aleatorizado) o estudio clínico (no controlado).

- Observacional: estudio de cohortes (identificar si es prospectivo o retrospectivo), estudio caso-control o estudio transversal.

- De revisión: revisión sistemática (con o sin trato estadístico), metaanálisis o revisión.

- Otros: documentos de consenso, posicionamiento u otros tipos. Tanto en los artículos de revisión como en otros hay que establecer si dichos estudios han seleccionado ECCA, o bien, en su caso, identificar el tipo de estudio observacional.

4. Establecer la calidad individual de los estudios según lo descrito en el apartado «Sistema para estimar la calidad individual de los artículos» en: alta, media o baja.

- ECCA (usar ambos sistemas): sistema de Detsky et al36 y sistema de consenso Delphi47.

- Observacionales: sistema del CRD25 (véase el apartado «Sistema para estimar la calidad individual de los artículos», concretamente el subapartado «Estudios observacionales»).

- Todos15: patrocinadores y conflictos de intereses.

Desechar los estudios de calidad baja.

5. Clasificar la evidencia según la jerarquía descrita en la tabla 5.

6. Dentro de cada uno de los tipos de diseño de un estudio, ordenar por cantidad de muestra y tiempo que dura la intervención u observación.

7. Crear la recomendación, añadiendo una frase que identifique el espíritu del grado de recomendación.

Reflexiones finales

Tal y como indica Doherty3, pese a que la medicina basada en la evidencia se ha ido consolidando, con el objetivo de disminuir fuentes de error en la elección del tratamiento o para prevenir la prescripción de tratamientos peligrosos, hay algunos estudios contemporáneos que indican que más del 25% de los pacientes aún reciben tratamientos que les podrían perjudicar54, y que más de un 40% no recibe tratamientos de comprobada efectividad55.

Según Doherty3, hay algunas razones para que las buenas evidencias no sean realmente adoptadas en la práctica clínica56. Éstas se pueden resumir en:

- Características de la propia evidencia (por ejemplo, la dificultad de realizarla).

- Barreras o resistencias en la capacidad de adopción de la evidencia, que se pueden dar en el paciente, el profesional, el grupo de trabajo, la institución y otros.

- Transferencia inadecuada de la evidencia al paciente o también llamada «traducción errónea del conocimiento».

Con el presente documento se ha propuesto un sistema para poner en marcha la dietética y la nutrición aplicada basadas en la evidencia en España. Ha sido la intención de los autores crear una herramienta práctica para que los dietistas-nutricionistas puedan involucrarse en dicha tarea y así mejorar el nivel de sus recomendaciones, sin caer en la primera de las barreras que pueden existir a la hora de aplicar las buenas evidencias: un sistema excesivamente complicado.

Investigaciones futuras deberán establecer si se ha podido implementar el sistema propuesto de niveles de evidencia y, en todo caso, establecer cuáles han sido los puntos fuertes o frágiles del sistema planteado.

Correspondencia: E. Baladia.

Consell de Cent, 314, pral. B.

08007 Barcelona. España.

Correo electrónico:info@grep-aedn.es

Historia del artículo:

Recibido 11-4-2008.

Aceptado 11-4-2008.